高可用replication controller

一直监控pod节点,坏了就重新创建一个pod

首先是apiversion 然后就是种类ReplicationController,接着是元数据name,spec->replicas高可用个数,选择器,就是选择app 开头也就是以myweb开头的pod,接下来时模板,->metadata->labels: 与选择器一样-》spec container- 容器镜像地址 port

docker load -i nginx.tar.gz 相当于在本地加载了一个nginx

docker images 查看docker的镜像的信息,然后根据信息打个tag,并推送到私有仓库

docker tag docker.io/nginx:latest 10.0.0.11:5000/nginx:1.13 新建tag

docker push 10.0.0.11:5000/nginx:1.13 推送到私有仓库中去

apiVersion: v1

kind: ReplicationController

metadata:

name: myweb #用于生成name的前缀

spec: #详情

replicas: 2 #副本数

selector:

app: myweb

template:# 模板

metadata:

labels:

app: myweb

spec:

containers:

- name: myweb

image: 10.0.0.11:5000/nginx:1.13

ports:

- containerPort: 80

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

rc2.yaml

apiVersion: v1

kind: ReplicationController

metadata:

name: myweb2

spec:

replicas: 2

selector:

app: myweb2

template:

metadata:

labels:

app: myweb2

spec:

containers:

- name: myweb2

image: 10.0.0.11:5000/nginx:1.15

ports:

- containerPort: 80

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

升级

kubectl rolling-update myweb -f rc2.yaml --update-period=30s

回滚

kubectl rolling-update myweb2 -f rc.yaml --update-period=30s

回滚到上一个版本

kubectl rolling-update myweb myweb2 --rollback

myweb-58tsk 0/1 ContainerCreating 0 12s

myweb-chl3h 1/1 Running 0 12s

每个pod运行是selector选择器,选择pod

修在资源

kubectl edit pod nginx

通过标签区分管理

kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE

myweb2-r18tt 1/1 Running 0 1m 172.16.70.4 k8s-master

myweb2-tz7hx 1/1 Running 0 1m 172.16.25.3 k8s-node2

若标签为myweb的pod个数变多了,则会删除最年轻的pod。

kubectl rolling-update myweb -f nginx2.yaml --update-period=30s 升级的周期是30s

回复到指定标签选择器的版本,从web2回滚到myweb

kubectl rolling-update myweb myweb2 --rollback

这部分将深入探讨Azure机器学习平台中数据集的应用,从基本概念到实际操作,为正在备战AI-900考试的考生提供一份完整的指南。

一、数据集基础概念解析

1.1 什么是数据集?

在人工智能和机器学习中,数据集是由具有相似数据结构和逻辑关联的数据单元构成的集合。它是训练、验证和测试模型的核心资源。数据集的质量、规模和多样性都直接影响机器学习模型的训练效果和性能。

数据集的关键特征包括:

- 数据结构一致性:数据集内的数据应具有相同的格式和结构,便于进行统一处理。

- 逻辑关联性:数据集中的各个数据项之间存在内在的联系,例如在分类任务中,标签与特征值之间有明确的关系。

- 标准化格式:数据集通常遵循某些标准格式(如CSV、JSON等),确保兼容不同的工具和平台。

- 可重复使用性:高质量的数据集应能够在不同的机器学习任务中多次使用,而不会出现过度拟合或偏差问题。

1.2 数据集在机器学习中的作用

数据集在机器学习项目中承担着至关重要的角色,主要用于以下几个方面:

- 模型训练:机器学习模型通过学习训练数据集中的特征与标签之间的关系,进行预测或分类。

- 模型验证:验证数据集用于评估模型在未知数据上的表现,确保模型的泛化能力。

- 模型测试:测试数据集用于在模型训练完成后,检测模型的最终准确性和鲁棒性。

二、经典数据集详解

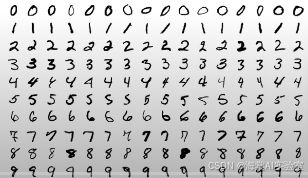

2.1 MNIST数据集

MNIST(Modified National Institute of Standards and Technology)数据库是机器学习和计算机视觉领域最经典的数据集之一,广泛用于图像识别和分类任务。

MNIST的基本信息:

- 内容:包含70000个手写数字(0-9)的灰度图像,分为训练集(60000个样本)和测试集(10000个样本)。

- 用途:主要用于手写数字识别、计算机视觉模型训练、算法性能测试等。

MNIST的应用场景:

- 深度学习入门训练:MNIST是深度学习初学者常用的经典数据集,帮助学习者了解图像分类的基本流程。

- 手写体识别系统开发:MNIST用于开发和测试手写体识别系统,帮助推动该领域的进步。

- 图像分类模型评估:许多新型的机器学习算法通过MNIST进行初步测试,以评估模型的基本分类能力。

- 算法性能测试:通过在MNIST数据集上进行训练和测试,可以评估不同算法(如卷积神经网络、支持向量机等)的性能。

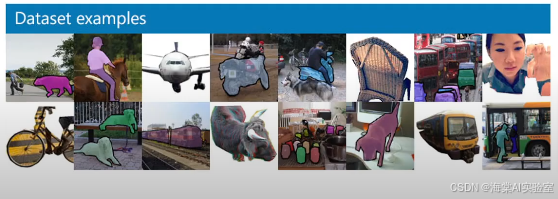

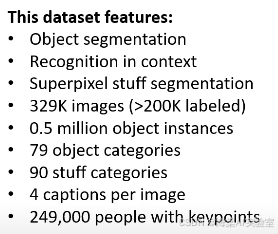

2.2 COCO数据集

COCO(Common Objects in Context)数据集是一个具有丰富标注的图像数据集,广泛应用于计算机视觉中的多个任务,如目标检测、分割和上下文理解。

COCO的核心功能:

- 对象分割:COCO数据集支持对象级别的分割标注,可以帮助研究者更好地识别图像中的独立物体。

- 场景识别:COCO数据集标注了多种常见的物体和场景,支持场景理解和推理。

- 上下文理解:COCO数据集提供了丰富的上下文信息,帮助机器理解不同物体之间的关系。

- 超像素分割:COCO还为图像提供了精细的超像素分割信息,促进图像分析任务的进步。

COCO的技术特征:

- JSON文件格式:COCO数据集采用JSON格式进行标注,便于机器读取和处理。

- 丰富的图像标注:每个图像不仅有物体标签,还包含了物体的位置、轮廓等详细标注信息。

- 多样化的对象类别:COCO数据集包含80个常见物体类别,适用于多种计算机视觉任务。

- 精确的分割信息:COCO提供了精确的目标分割信息,有助于研究更高精度的分割算法。

COCO的应用场景:

- 目标检测:COCO广泛应用于目标检测任务,帮助研究者开发更高效的检测算法。

- 实例分割:COCO数据集为实例分割任务提供了标准化的数据支持。

- 语义分割:COCO支持对图像中的每个像素进行分类,为语义分割技术的发展提供了数据基础。

三、Azure机器学习与数据集整合

Azure机器学习平台为数据科学家和开发者提供了一系列工具,帮助他们轻松地使用和管理数据集。通过Azure,您不仅可以方便地上传和共享数据集,还可以借助平台的强大功能进行数据标注、预处理和模型训练。

3.1 数据标注服务

Azure机器学习工作室提供了强大的数据标注工具,帮助您标注图像、文本和音频数据。这些工具能够自动化标注过程,减少手动干预,并提高标注的准确性。

Azure数据标注服务的特点:

- COCO格式导出支持:Azure机器学习工作室支持将标注数据导出为COCO格式,方便与其他工具进行整合。

- 自动化标注工具:通过机器学习和人工智能技术,Azure可以自动识别和标注数据,显著提高数据处理效率。

- 批量处理能力:Azure支持对大规模数据进行批量处理,帮助处理海量数据集。

- 质量控制机制:平台提供了质量控制工具,确保数据标注的一致性和准确性。

3.2 开放数据集应用

Azure不仅支持自定义上传数据集,还提供了多种开放数据集供用户使用。这些开放数据集已经经过标准化处理,可以直接用于机器学习任务。

Azure平台上的开放数据集类型:

- 即时可用的训练数据:如MNIST、COCO等常见数据集,用户可以直接使用。

- 标准化的测试集:为评估模型性能提供标准化数据集,便于与其他模型进行比较。

- 验证数据集:用于验证模型的泛化能力,帮助开发者评估模型在真实世界中的表现。

- 示例数据集:用于展示Azure机器学习工具的使用方法,帮助用户快速上手。

四、实践应用指南

4.1 数据集选择策略

在选择数据集时,考虑项目的需求是至关重要的。一个合适的数据集能够极大提升机器学习项目的成功率。

选择数据集时的策略:

- 项目需求匹配度:确保数据集中的数据类型和标签符合项目需求,例如,图像分类项目需要图像数据集。

- 数据质量评估:高质量的数据集应包含详细的标签和清晰的标注,避免噪声数据对模型训练产生负面影响。

- 使用许可确认:确认所选数据集的使用许可,确保不会违反数据版权或隐私政策。

- 更新频率考虑:如果项目需要长期使用数据集,考虑数据集的更新频率,确保数据的时效性。

4.2 最佳实践建议

为了确保数据集能够顺利应用于机器学习任务,以下是一些最佳实践:

- 数据预处理:对数据进行清洗、去噪和标准化,确保数据质量。

- 格式标准化:确保数据符合所需格式,避免在训练过程中出现不兼容问题。

- 质量验证:对数据进行质量检查,确保标签准确且无误。

- 性能优化:利用Azure的计算资源,优化数据集处理和模型训练的速度和效率。

五、总结

数据集在机器学习中扮演着至关重要的角色,Azure机器学习平台为开发者提供了便捷的工具和强大的资源,帮助他们高效地利用各种数据集进行模型训练和测试。无论是经典的MNIST和COCO数据集,还是Azure平台提供的开放数据集,都为机器学习提供了丰富的素材。在AI-900考试中,理解数据集的选择、处理和应用方法,将帮助您更好地掌握Azure机器学习平台的基本概念,进而顺利通过考试。

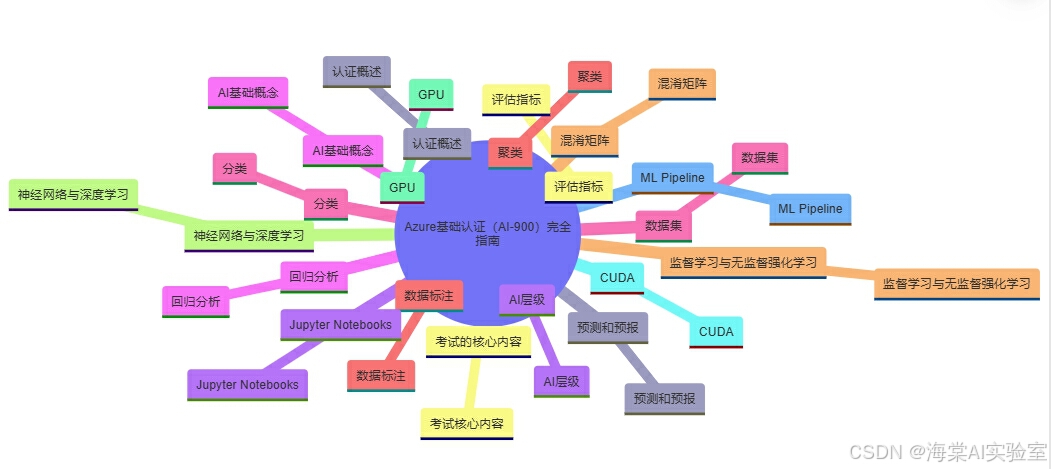

Azure基础认证(AI-900)完全指南

-

认证概述:认证概述

-

考试的核心内容:考试核心内容

-

AI层级:AI层级

-

AI基础概念:AI基础概念

-

数据集:数据集

-

数据标注:数据标注

-

监督学习与无监督强化学习:监督学习与无监督强化学习

-

神经网络与深度学习:神经网络与深度学习

-

GPU:GPU

-

CUDA:CUDA

-

ML Pipeline:ML Pipeline

-

预测和预报:预测和预报

-

评估指标:评估指标

-

Jupyter Notebooks:Jupyter Notebooks

-

回归分析:回归分析

-

分类:分类

-

聚类:聚类

-

混淆矩阵:混淆矩阵

本文为原创内容,未经许可不得转载。

评论记录:

回复评论: