两年前,ChatGPT刚出来时候,在国内是不能注册账号的,看同事们纷纷试用ChatGPT,我也在他们推荐下于淘宝花14块钱买一个ChatGPT账号。当时试用感受已经记不太清,大概是只有惊叹无好奇且不依赖的,因为过去的两年中,我只在那些偶尔想起来的时刻用它一下。

我今年看的好几个工作机会,都和AI很有些关系,当面试官问我“你平时都有使用哪些AI工具”时,我内心是会生出些不坦然情绪的。对的,我用的AI工具并不多甚至可以说很少,我用到的AI,只是文本对话而已,即便我已经在手机上安装了《讯飞星火》《文小言》《豆包》《腾讯元宝》《Kimi智能助手》。

今年的8月9月,我意识到自己该做出些改变:作为一个程序员,对于这种坊间传说即将取代我的工具毫不上心毫不了解,似乎是不太明智的。

我接触新知识的方式,在最近几年的阅读习惯中已经有了些改变。以前单纯通过看别人写的高赞博客,读别人写的高阅文章来获取对新事物的认知,现在会慢一些,就某个知识点,我愿意去看书。由此,对AI做出改变的第一步,是读书,我找到的第一本书,叫做《这就是ChatGPT》。

这本书,是作者斯蒂芬·沃尔弗拉姆于ChatGPT问世后不久写的两篇长文的合集。“第一篇介绍了ChatGPT,并且解释了它为何拥有像人类一样的生成语言的能力。第二篇则展望了ChatGPT的未来,预期它能使用计算工具来做到人类所不能做到的事,特别是能够利用Wolfram|Alpha系统对知识进行计算(computational knowledge,在后文中简称为计算知识)的‘超能力’。”

ChatGPT是如何拥有像人类一样生成语言的呢?读完全书后我留在脑子中的印象是这样的:一切都基于概率,基于它所接受的训练(互联网上的几十亿文本,与500多万本电子书),以“合理”的方式续写文本。

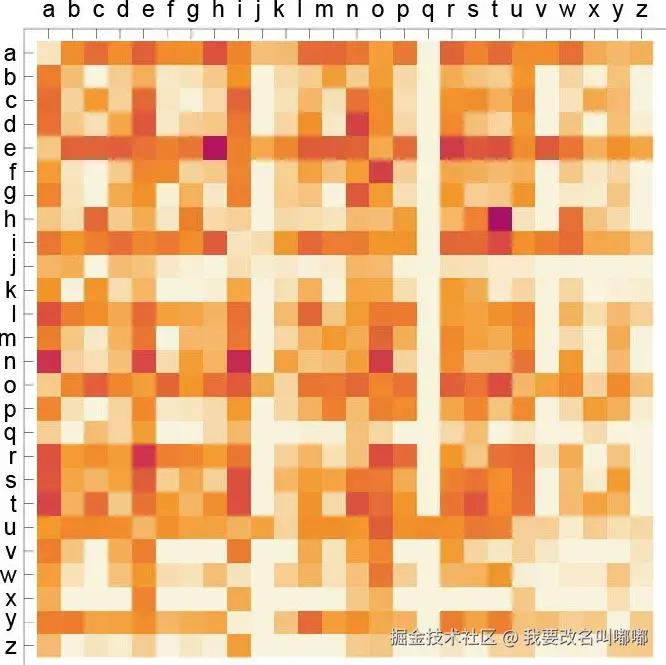

字母对

比如单词的形成,如上图(来源于本书),是英文文本中字母对的概率(可能出现的第一个字母横向表示,第二个字母纵向表示,颜色越深表示出现概率越高),可以看到“si”“ti”“tn”的颜色是比较深的。

(关于这张图,此处有一个分支想法想要记录。看此图时,我看到“ht”的颜色最深,于是便在脑子中去搜寻包含“ht”的单词,感觉上好像不比“si”“ti”更多。我去问Gemini——谷歌刚刚发布的“ChatGPT”二代,看到了time、action、simple、since、light、height,它的“感觉”与我相似:“ti”最常见,“si”次之,“ht”相对来说频率最低,如果要更精确统计,需要大型语料库和计算机程序进行词频分析。)

使用这概率表生成“单词”,最终是可能蒙对很多个真实存在单词的。

再将这概念扩大些,如果我们知道单词接单词的概率,单词接单词再接单词的概率,则可能生成有意义的句子。比如“this”后面常跟“is”,“is”后面常跟限定词、名词甚至形容词,“these”后面常跟“are”,当看见“these”时,ChatGPT发现“are”出现的概率较高,再基于“are”后面可能出现词的概率,最终可能生成句子:“these are cars”。

基于这些概率生成的句子,如何才能保证它是真正有意义的呢?接下来出现的概念是“神经网络”,我已经先读完一本关于“神经网络”的书,但到整理此篇时,脑子中的概念依然是模糊的。

于是此处,只整理几个在“神经网络”之后出现的我还不能理解清楚不能精细复述的模糊概念。

训练,基于一批样例(很多的句子),然后基于最小化网络(emmm?)在这些样例上的误差来调整网络中的权重(神经网络中一层又一层)。(训练很重要很复杂也很贵,此处只是做一个标记,待未来再理解。)

Embeddings。在许多句子当中,将一个词换成另外一个词是不会影响句子意义的,比如alligator(短吻鳄)和crocodile(鳄鱼)。为对此种相似性进行计算,可以给某个句子、单词生成一个高维向量,测量这些向量之间的距离,就可以找到词之间的“相似度”。

意义空间,指的是句子当中,某些意义相近的词,也会放在句子中某个相近位置。比如,This is a car和This is an apple中的car和apple,是放在相同位置的。如果要为car和apple添加一些形容词,那位置也将相似,比如This is a beautiful car,This is a delicious apple。

基于这些复杂概念,再配合海量数据,最终有了ChatGPT的问世。作者在书中的总结语是:

ChatGPT的基本概念在某种程度上相当简单:首先从互联网、书籍等获取人类创造的海量文本样本,然后训练一个神经网络来生成“与之类似”的文本。特别是,它能够从“提示”开始,继续生成“与其训练数据相似的文本”。

很简单么?对于现在的我来说,并不是的。

本书的第二篇文章,介绍的是Wolfram|Alpha。ChatGPT在一些计算上,给出的答案只在语言层面合理,但它自信给出的事实与计算结果可能并不准确,作者所列举示例是东京到芝加哥的距离为多少,ChatGPT的答案是错误的。(我在阅读当时做了测试,真的会不准确。今天再试了下,Gemini也不准确。)

为解决这个问题,作者介绍了ChatGPT与Wolfram|Alpha“合作”之后的未来:Wolfram|Alpha将给予ChatGPT计算超能力,二者结合,所向无敌。对的,本书第二部分,更像是作者对自己一项新发明的推广介绍。

在本书“序”中有这样的一段话:“直接学习所有详细的知识已经变得不必要了:我们可以在更高的层次上学习和工作,抽象掉许多具体的细节。‘整合’,而不是专业化。尽可能广泛、深入地思考,尽可能多地调用知识和范式。”

虽然分层设计是这个世界的常态,但我并不能全部认可“序”作者的此条观点。

最近一个多月来,我天天都借助ChatGPT帮我解答工作中的疑问,甚至开始使用Cursor帮我写代码(推荐小伙伴们试试看啦,我还处于入门阶段,已经感受到它对效率的提升大大的)。诚然,ChatGPT生成的答案基本上全对,但将它的答案用在准确的地方,是需要些积攒的。

这些积攒,只关注“整合”而不关注细节,并不能做到(当然,此结论只是基于我当前的认知得出,也可能只是我对工具的使用方式还不够完善)。ChatGPT是工具,是我们大脑的延升,我们使用它、依赖它都没关系,但我们不能基于此失去一颗持续学习的心。

《这就是ChatGPT》中的内容我并不能全部理解,但它帮助我拓宽了认知边界:原来ChatGPT,是基于概率的啊。

评论记录:

回复评论: