前引:我们为何需要一个“AI算力管家”?你是否出现了以下问题

在人工智能迅速发展的今天,算力资源可谓是比肩“石油”。无论是训练大型语言模型,还是实时处理计算机视觉数据,企业和开发者都面临三大痛点:

(1)成本的失控。临时扩容需求导致云服务费用暴增,预算像“漏斗”一样很难被把控

(2)资源很分散。买了GPU服务器却用不上满负荷,闲置之后也算是浪费

(3)协作低效。团队的成员各自为战,环境配置很混乱,数据问题频频发生

蓝耘元生代智算云正是为了解决这些问题还诞生,它更像一台“智能调节大型处理器”,不仅可以整合碎片化算力资源,又能让AI开发变的简单,下面我们来介绍如何用它快速构建专属的AI平台。记得三连支持小编哦!制作不易,感谢支持!

目录

何为:蓝耘元生代智算云

我们在这里假想一下,蓝耘平台就像一栋“AI大厦”

在我们的一楼,就是资源调度中心。这里有各种算力资源,比如GPU服务器、CPU集群等,而管理员就像调度员,根据用户的需求动态分配资源。例如:现在某个团队需要训练某个大型模型,它会第一时间从“空闲资源池”中调度性能GPU,此时可以不用等待区采购新的硬件

在我们的二楼,就是商店(就是市场模块)。它可以给我们提供生成好的“AI工具包”:Stable Diffusion绘画界面、YOLO目标检测模型、3D建模工具等等,用户只需要说出需求就可以进行部署,省去安装调试的麻烦,大大提高效力

在我们的三楼,就是AI协作开发模块。简单理解就是办公区,开发者们在这里写代码、测试各种模型,财务与行政人员在后台管理账单、查工作,我们每个人都有自己的工作,互不打扰,高效办公

(1)服务模式

面向中小型企业商业客户和各类C端开发者,用户根据需求选择计费方式,不需要自建硬件,针对数据的安全性,和高性能的大型商业客户,可以在蓝耘平台内部私设部署化,保护自己的数据隐私空间

(2)技术优势

全景式覆盖:依托行业领域的灵活基础设施和大规模的GPU算力资源,实现从数据准备到代码开发,再到模型训练推理部署全景式覆盖

异构算力资源调度革命:打破GPU中心化传统架构,首创蜂巢式资源网路,实现了CPU、GPU、TPU协处理器,通过实时拓扑感知与强化学习算法,自动识别任务特征并匹配最优算力组合

全生命周期效能优化:基于NCCL 2.11优化与自定义AIIReduce算法,分布式训练吞吐量较传统提高了38%,开发第三代自适应剪枝框架,首创TensorRT-LLVM联合优化路径,INT8量化模型推理延迟突破2ms级

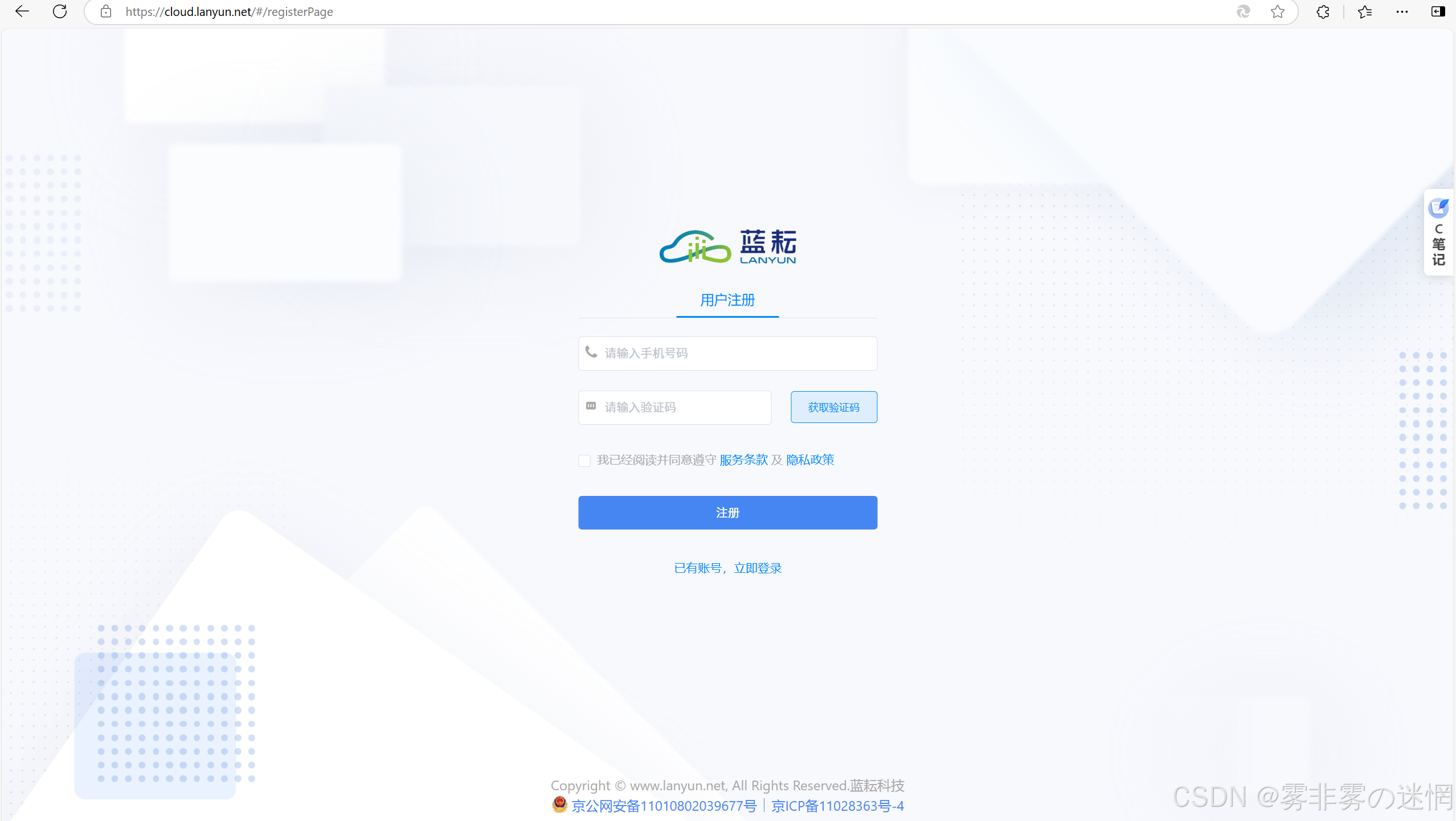

如何注册你的“AI算力品牌”

(1)进入官网

首先我们需要打开浏览器,输入蓝耘元生代智算云官网www.lanyuncloud.net

再点击注册按钮,进入企业级认证流程,如下:

先上传企业Logo,生成专属标识图案,随后填写你的企业信息,比如营业执照,等等各方面的证明,最后提交负责人信息,比如姓名、手机号、邮箱。

注意:如果是开发者个人使用,可以点击右上角的免费使用,但是功能有限,企业用户建议直接走企业认证,这样可以享受绝大多数功能,品牌定制,优先技术等权益。

(2)租用算力资源

当我们登录后台之后,我们点击创造实例按钮,可以看到以下选项:

·镜像选择:从应用市场挑选工具,比如“SDWebUL”可以用来生成图片、“YOLOv8”可以用来目标检测

·资源配置:选择GPU型号,比如NVIDIAV100、CPU的核心数、内存大小

·计费方式:我们可以选择是按小时计费,还是按月计费,根据我们的使用时间来选择,对于企业运用,建议选择按月计费

比如:如果我现在要用Stable Diffusion训练一张高清图片,我们可以选择“SDWebUl”镜像+1块V100GPU+16GB内存,选择按小时收费。部署完成之后,系统会给你分配一个公网IP和SSH端口,你可以通过终端工具连接服务器

(3)打造你自己的“AI工作室”

第一步:连接服务器

- bush

- ssh username@your-instance-ip-p port_number

先输入密码,之后你会进入Linux命令行界面

第二步:启动应用

- bush

- cd /app/sdwebui && screen -dms"SDWebUI" python main.py

这会启动Stable Diffusion的图形画界面,你可以上传图片、各种提示词,进行创作

第三步:团队协作

当工程师在训练模型,需要另一个人实时查看GPU使用率,发现资源很紧张时,立即进行扩容。后台管理员发现当前的产品使用率不足30%时,立刻标识为“闲置资源”。整个管理高效有序,任务分工明确

蓝耘的“硬核装备”究竟有多强

(1)裸金属服务器

蓝耘的裸金属服务器直接对接物理硬件,没有虚拟化层的消耗,例如一台配备8块NVDIA AI00 GPU的服务器,算力利用率可以达到95%以上,而普通服务器只能达到70%左右。

·训练场景:训练千亿参数的LLM模型,比如GPT-4,实时渲染3D视频或者自动驾驶仿真

·自定义权限:支持NUMA亲和性调度,让CPU核心与GPU绑定,减少数据传输延迟,耳机换机组网,可以将多个服务器的GPU连接成高速网络,满足极端性能要求

(2)容器化集群:弹性伸缩的“变形金刚”

如果你的项目需要快速迭代(比如每天上线新的功能),容器化部署是最佳的选择。蓝耘基于Kubernetes打造容器集群,具备以下优势:

·秒级扩容:白天流量高峰时自动增加10个推理节点,夜间需求下降时缩减至2个推理节点

·资源隔离:每个容器单独分配内存和磁盘空间,避免“抢资源”导致硬件崩溃

·镜像仓库:预集成PyTorch、TensorFlow等框架,以及行业定制镜像,例如某电商公司需要用蓝耘容器集群部署商品分类服务,双十一期间流量暴增平常的30倍,平台会自动扩容200个容器实例,全程没有故障

(3)算力共享经济

蓝耘的最大创新在于“资源纳管”功能,如下:

·企业合作:如果你有闲置的GPU服务器,可以授权给蓝耘平台托管,其它用户通过付费租用你的资源

·收益合成:按小时收费,你每月将额外增收数万元

·安全保障:数据存储在本地服务器,蓝耘仅仅负责任务调度,彻底解决隐私担忧

·数据对比:某个高校实验室有8台闲置的PTX4090服务器,接入蓝耘平台后,每年产生约15万元收益,相当于把“闲置的垃圾”变成了“自动印钞机”

解锁蓝耘的“隐藏技能”

(1)智能调优:让AI训练速度加倍

蓝耘后台内置“AI训练加速引擎”,将常用的数据集缓存于内存中,减少硬盘IO的时间

·混合精度训练:自动将FP32浮点运算转为FP16,提高计算效率30%

·网络调优:针对GPU间通信延迟高的问题,动态调整RDMA协议参数

例如:某个团队用蓝耘平台训练ResNet-50模型,相比传统方式,训练时间从2小时缩减至1.2小时

(2)全链路监控:让算力“透明化”

·运维看板:实时显示CPU\GPU温度、负载率、网络带宽占用

·任务追踪:点击任何训练任务,可查看损失函数曲线、梯度爆炸报警记录

·成本分析:生成月度账单明细,区分“训练消耗”、“推理消耗”、“资源配置”占比

真实的用户故事:某个初创公司通过监控发现,他们70%的算力浪费在重复的数据预处理上,于是他们优化了数据加载代码,月成本降低了40%

(3)私有化部署

如果不想依赖公有云,蓝耘还支持私有化部署,例如:

·购买物理服务器或者使用已有的数据中心

·安装蓝耘调度系统,纳管本地资源

·配置企业网认证,限制访问IP范围

适用于这些场景:金融、军工等对数据安全要求极高的行业

蓝耘的使用对象

(1)AI实验室:清华大学某个研究院

需求:训练千亿参数的蛋白质结构预测模型

解决方案:租用了16台NVIDIA V100裸金属服务器,启动分布式缓存和NUMA优化

成果:模型训练时间从4周缩短至2周,论文登上了《Nature》子刊

(2)云计算服务商,某个区域IDC运营商

需求:利用闲置服务器赚外快

·解决方案:将300台GPU服务器接入蓝耘平台,开放给中小企业租用

·成果:月营收入增加200万元,硬件利用率从15%提高到了85%

(3)AI初创公司:某个自动驾驶初创团队

需求:快速验证算法,控制试错成本

·解决方案:按需租用容器实例,白天训练模型,晚上释放资源

·成果:半年内试错10多个版本,仅仅花费10万元云成本

蓝耘可否发展为市场的“滴滴”

当前,全球AI市场正呈现“碎片化”特征:谷歌、AMS等巨头占据高端市场,但中小企业和开发者更加灵活、更具性价比的选择。蓝耘的模式或许正在改写游戏规则:

·资源民主化:让个人开发者也能低成本调用顶级算力

·协作生态化:构建从工具链到服务的完整AI开发闭环

·绿色可持续化发展:通过资源共享减少硬件浪费,助力碳中和目标

挑战与机遇:

·竞争压力:面临AWS SageMaker、华为MindSpore等老牌平台的竞争

·技术瓶颈:如何进一步优化异构算力调度

·市场教育:让非技术用户理解“算力调度”的价值

蓝耘元生底层技术实现

一.基础设施层

(1)异构算力资源池

(2)高效存储结构

二.智能调度引擎

(1)动态的资源调度算法

(2)优先队列优化机制,采用顶级算法,实时监控NVIDIA NVMI API获取设备状态

三.计算加速层

(1)深度学习优化库

(2)推理加速技术

四.安全与可靠性

(1)加速传输机制

(2)容灾恢复系统

(3)性能优化细节,包含CPU性能调优,网络优化

五.监控与调试

可视化的监控模版,自动化调试工具

评论记录:

回复评论: