一、引言

在机器学习的广阔领域中,贝叶斯算法以其独特的概率推理方式占据了重要的地位。它不仅为分类问题提供了有效的解决方案,还在自然语言处理、信息检索、垃圾邮件过滤等诸多领域发挥着不可替代的作用。

贝叶斯算法的基本思想源于贝叶斯定理,它描述了在已知某些条件下,某事件发生的概率如何根据这些条件进行更新。在机器学习中,贝叶斯算法利用先验知识和观察到的数据来更新事件的概率分布,从而做出更加准确的预测和决策。

贝叶斯算法的应用领域十分广泛。在文本分类中,贝叶斯分类器能够基于词汇的频率和上下文信息,有效地将文档划分为不同的类别;在自然语言处理中,贝叶斯网络能够捕捉变量之间的依赖关系,进而用于情感分析、观点挖掘等任务;在垃圾邮件过滤中,贝叶斯算法能够根据邮件的内容和特征,准确地识别并过滤掉垃圾邮件。

随着大数据时代的到来,贝叶斯算法的重要性愈发凸显。它不仅能够处理大规模的数据集,还能够有效地应对复杂的数据结构和不确定的环境。因此,深入剖析贝叶斯算法的原理和应用,对于提升机器学习的效果和性能具有重要意义。

在接下来的内容中,我们将详细介绍贝叶斯算法的原理、分类器、网络结构及其在机器学习中的应用案例。通过对这些内容的探讨,我们希望能够帮助读者更好地理解贝叶斯算法,并激发其在机器学习领域的更多应用和创新。

二、贝叶斯算法原理详解

1. 贝叶斯定理的数学基础及解释

贝叶斯定理是概率论中的一个基本定理,它描述了条件概率之间的关系。该定理的数学表达式如下:

P ( A ∣ B ) = P ( B ∣ A ) ⋅ P ( A ) P ( B ) P(A|B) = \frac{P(B|A) \cdot P(A)}{P(B)} P(A∣B)=P(B)P(B∣A)⋅P(A)

其中:

P

(

A

∣

B

)

P(A|B)

P(A∣B)表示在事件B发生的条件下,事件A发生的概率,即后验概率。

P

(

B

∣

A

)

P(B|A)

P(B∣A) 表示在事件A发生的条件下,事件B发生的概率。

P

(

A

)

P(A)

P(A)表示事件A发生的概率,即先验概率。

P

(

B

)

P(B)

P(B)表示事件B发生的概率。

贝叶斯定理的核心思想在于利用已知的先验概率和条件概率来更新我们对某个事件发生的概率的估计。在机器学习中,这通常意味着我们可以利用已有的数据和知识来推断新的、未知的数据或事件。

2. 条件概率与先验概率、后验概率的关系

条件概率是指在某个特定条件已经发生的情况下,另一个事件发生的概率。在贝叶斯定理中,条件概率起着关键作用,因为它允许我们根据已知信息来调整对其他事件的概率估计。

先验概率是在没有任何其他条件或信息的情况下,某个事件发生的概率。在贝叶斯推断中,先验概率通常是我们对某个事件或类别的初始认知或假设。

后验概率是在获得新的证据或信息后,对某个事件发生的概率的更新。后验概率是贝叶斯推断的输出,它反映了我们在考虑新信息后对某个事件或类别的信念或认知的变化。

3. 贝叶斯推断过程及示例分析

贝叶斯推断是一种基于贝叶斯定理的概率推理方法。它通常包括以下步骤:

-

(1)确定先验概率:根据历史数据、经验或其他信息,确定事件或类别的初始概率分布。

-

(2)收集新的证据或信息:这些证据或信息可以是新的观测数据、实验结果或其他相关信息。

-

(3)计算条件概率:根据新的证据或信息,计算条件概率,即在给定新信息的情况下,事件或类别发生的概率。

-

(4)应用贝叶斯定理:使用贝叶斯定理将先验概率和条件概率结合起来,计算后验概率。

-

(5)根据后验概率做出决策或预测:根据计算得到的后验概率,对事件或类别进行分类、预测或做出其他决策。

三、朴素贝叶斯分类器的原理

1. 朴素贝叶斯分类器的原理

朴素贝叶斯分类器是基于贝叶斯定理与特征条件独立假设的分类方法。它假设给定类别下,特征之间是相互独立的,即一个特征的出现概率不会受到其他特征的影响。这一假设虽然在实际应用中可能并不完全成立,但在很多情况下都能够取得不错的效果,并且使得模型的计算变得简单高效。

朴素贝叶斯分类器的原理是,对于给定的待分类样本,计算其属于各个类别的概率,然后将样本划分到概率最大的类别中。具体地,假设有(n)个特征,(m)个类别,对于待分类样本(x),其属于类别(c_i)的概率(P(c_i|x))可以通过以下公式计算:

P ( c i ∣ x ) = P ( x ∣ c i ) P ( c i ) P ( x ) = P ( c ) P ( x ) ∏ i = 1 d P ( x i ∣ c ) P(c_i|x) = \frac{P(x|c_i)P(c_i)}{P(x)}= \frac{P(c)}{P(x)} \prod_{i=1}^{d}P(x_i|c) P(ci∣x)=P(x)P(x∣ci)P(ci)=P(x)P(c)i=1∏dP(xi∣c)

其中, P ( c i ) P(c_i) P(ci)是类别 c i c_i ci的先验概率, P ( x ∣ c i ) P(x|c_i) P(x∣ci)是在类别 c i c_i ci下特征 x x x出现的条件概率, P ( x ) P(x) P(x)是特征 x x x出现的概率。由于 P ( x ) P(x) P(x)对于所有类别是相同的,因此在比较不同类别的概率时,可以省略 P ( x ) P(x) P(x)的计算。其实 P ( x ∣ c ) = ∏ i = 1 d P ( x i ∣ c ) P(x|c)=\prod_{i=1}^{d}P(x_i|c) P(x∣c)=∏i=1dP(xi∣c),这里的d为属性数目, x i x_i xi为 x x x在第 i i i个属性的取值;( x i x_i xi实际上是一个“属性-值”,如“色泽 = 青绿”)

2.朴素贝叶斯分类器的表达式:

由于对所有类别来说P(x)相同;(数据集固定则确定)

基于

h

∗

(

x

)

=

a

r

g

m

a

x

c

∈

y

P

(

c

∣

x

)

h^{*}(x)={argmax}_{c \in y}P(c|x)

h∗(x)=argmaxc∈yP(c∣x)

贝叶斯判定准则有为:

h

n

b

(

x

)

=

a

r

g

m

a

x

c

∈

y

P

(

c

)

∏

i

=

1

d

P

(

x

i

∣

c

)

h_{nb}(x) = argmax_{c \in y}P(c)\prod_{i=1}^{d}P(x_i|c)

hnb(x)=argmaxc∈yP(c)i=1∏dP(xi∣c)

这就是朴素贝叶斯的表达式

3.朴素贝叶斯分类器的训练:

朴素贝叶斯的训练就是基于数据集 D D D

计算估计“类先验概率 P ( x ) P(x) P(x)

并为每个属性估计条件概率 P ( x i ∣ c ) P(x_i|c) P(xi∣c)

令 D c D_c Dc表示训练集 D D D中第 c c c类样本组成的集合l若有充足的独立同分布样本,则很容易估计出“类先验概率”

P ( c ) = ∣ D c ∣ ∣ D ∣ P(c) = \frac {|D_c|}{|D|} P(c)=∣D∣∣Dc∣

4.对离散属性而言

令

D

c

,

x

i

D_{c,x_i}

Dc,xi表示

D

c

D_c

Dc中在第

i

i

i个属性上取值为

x

i

x_i

xi的样本组成的集则条件概率

P

(

x

i

∣

c

)

P(x_i|c)

P(xi∣c) 可估计为

P

(

x

i

∣

c

)

=

∣

D

c

,

x

i

∣

∣

D

c

∣

P(x_i|c)=\frac {|D_{c,x_i}|}{|D_c|}

P(xi∣c)=∣Dc∣∣Dc,xi∣

5.对连续属性

可考虑概率密度函数

假定

p

(

x

i

∣

c

)

∼

N

(

μ

c

,

i

,

σ

c

,

i

2

)

p(x_i|c) \sim \Nu(\mu_{c,i},\sigma_{c,i}^{2})

p(xi∣c)∼N(μc,i,σc,i2)

其中

μ

c

,

i

\mu_{c,i}

μc,i和

σ

c

,

i

2

\sigma_{c,i}^{2}

σc,i2分别是第

c

c

c类样本在第

i

i

i个属性上取值的“均值”和“方差”

则有

p

(

x

i

∣

c

)

=

1

2

π

σ

c

,

i

e

x

p

(

−

(

x

i

−

μ

c

,

i

)

2

2

σ

c

,

i

2

)

p(x_i|c) = \frac{1}{\sqrt{2\pi}\sigma_{c,i}}exp(-\frac{(x_i-\mu_{c,i})^2}{2\sigma_{c,i}^{2}})

p(xi∣c)=2πσc,i1exp(−2σc,i2(xi−μc,i)2)

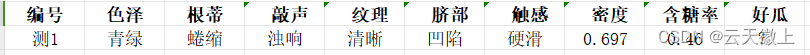

6.手算朴素贝叶斯实例: 来源于周志华老师的西瓜书

数据集使用”西瓜数据集 3.0,具体如下所示;

通过上面的数据集,测试下面的测试案列是否是好瓜?

1、计算“类先验概率”

一共有17个样本,其中8个好瓜,9个坏瓜

P

(

好瓜

=

是)

=

8

17

≈

0.471

P(好瓜=是)= \frac {8}{17} \approx 0.471

P(好瓜=是)=178≈0.471

P

(

好瓜

=

否)

=

9

17

≈

0.529

P(好瓜=否)= \frac {9}{17} \approx 0.529

P(好瓜=否)=179≈0.529

2、为每个属性估计条件概率

P

(

x

i

∣

c

)

P(x_i|c)

P(xi∣c)

(1)色泽 = 青绿

好瓜里“色泽=青绿”的有3个,好瓜共8个;坏瓜里“色泽=青绿”的有3个,坏瓜共9个;

P

青绿

∣

是

=

P

(

色泽

=

青绿

∣

好瓜

=

是)

=

3

8

=

0.375

P_{青绿|是}=P(色泽=青绿|好瓜=是)=\frac{3}{8}=0.375

P青绿∣是=P(色泽=青绿∣好瓜=是)=83=0.375

P

青绿

∣

否

=

P

(

色泽

=

青绿

∣

好瓜

=

否)

=

3

9

≈

0.333

P_{青绿|否}=P(色泽=青绿|好瓜=否)=\frac{3}{9}\approx0.333

P青绿∣否=P(色泽=青绿∣好瓜=否)=93≈0.333

(2)纹理 = 蜷缩

好瓜里“纹理 = 蜷缩”的 有 5 个 ,好瓜共 8 个;坏瓜里“纹理 = 蜷缩”的 有 3 个,坏瓜共 9 个;

P

蜷缩

∣

是

=

P

(

纹理

=

蜷缩

∣

好瓜

=

是)

=

5

8

=

0.625

P_{蜷缩|是}=P(纹理 = 蜷缩|好瓜=是)=\frac{5}{8}=0.625

P蜷缩∣是=P(纹理=蜷缩∣好瓜=是)=85=0.625

P

蜷缩

∣

否

=

P

(

纹理

=

蜷缩

∣

好瓜

=

否)

=

3

9

≈

0.333

P_{蜷缩|否}=P(纹理 = 蜷缩|好瓜=否)=\frac{3}{9}\approx0.333

P蜷缩∣否=P(纹理=蜷缩∣好瓜=否)=93≈0.333

同理可以计算出

P

浊响

∣

是

=

0.750

P_{浊响|是}=0.750

P浊响∣是=0.750 、

P

浊响

∣

否

≈

0.444

P_{浊响|否}\approx0.444

P浊响∣否≈0.444;

P

清晰

∣

是

=

0.875

P_{清晰|是}=0.875

P清晰∣是=0.875 、

P

清晰

∣

否

≈

0.222

P_{清晰|否}\approx0.222

P清晰∣否≈0.222;

P

凹陷

∣

是

=

0.750

P_{凹陷|是}=0.750

P凹陷∣是=0.750 、

P

凹陷

∣

否

≈

0.222

P_{凹陷|否}\approx0.222

P凹陷∣否≈0.222;

P

硬滑

∣

是

=

0.750

P_{硬滑|是}=0.750

P硬滑∣是=0.750 、

P

硬滑

∣

否

≈

0.667

P_{硬滑|否}\approx0.667

P硬滑∣否≈0.667;

(3)密度=0.697

μ

\mu

μ 和

σ

2

\sigma^2

σ2分别是“正样本”在密度属性上取值的“均值”和“方差”;

μ

=

0.574

,

σ

2

=

0.12

9

2

\mu = 0.574,\sigma^2=0.129^2

μ=0.574,σ2=0.1292

P

密度:

0.697

∣

是

=

P

(

密度

=

0.697

∣

好瓜

=

是)

=

1

2

π

∗

0.129

e

x

p

(

−

(

0.697

−

0.574

)

2

2

∗

0.12

9

2

)

≈

1.959

P_{密度:0.697|是}=P(密度=0.697|好瓜=是)=\frac{1}{\sqrt{2\pi}*0.129}exp(-\frac{(0.697-0.574)^2}{2*0.129^2})\approx1.959

P密度:0.697∣是=P(密度=0.697∣好瓜=是)=2π∗0.1291exp(−2∗0.1292(0.697−0.574)2)≈1.959

P

密度:

0.697

∣

否

=

P

(

密度

=

0.697

∣

好瓜

=

否)

≈

1.203

P_{密度:0.697|否}=P(密度=0.697|好瓜=否)\approx1.203

P密度:0.697∣否=P(密度=0.697∣好瓜=否)≈1.203

同理可以算出: P 含糖率 : 0.460 ∣ 是 ≈ 0.788 P_{含糖率:0.460|是}\approx0.788 P含糖率:0.460∣是≈0.788、 P 含糖率 : 0.460 ∣ 是 ≈ 0.066 P_{含糖率:0.460|是}\approx0.066 P含糖率:0.460∣是≈0.066

3、连乘,得出最终结果

测试数据为好瓜的概率:

P

(

好瓜

=

是)

=

P

青绿

∣

是

×

P

蜷缩

∣

是

×

P

浊响

∣

是

×

P

清晰

∣

是

×

P

凹陷

∣

是

×

P

硬滑

∣

是

×

P

密度:

0.697

∣

是

×

P

含糖率

:

0.460

∣

是

≈

0.038

P(好瓜=是)=P_{青绿|是}\times P_{蜷缩|是}\times P_{浊响|是}\times P_{清晰|是}\times P_{凹陷|是}\times P_{硬滑|是}\times P_{密度:0.697|是}\times P_{含糖率:0.460|是}\approx0.038

P(好瓜=是)=P青绿∣是×P蜷缩∣是×P浊响∣是×P清晰∣是×P凹陷∣是×P硬滑∣是×P密度:0.697∣是×P含糖率:0.460∣是≈0.038

测试数据为坏瓜的概率:

P

(

好瓜

=

否)

=

P

青绿

∣

否

×

P

蜷缩

∣

否

×

P

浊响

∣

否

×

P

清晰

∣

否

×

P

凹陷

∣

否

×

P

硬滑

∣

否

×

P

密度:

0.697

∣

否

×

P

含糖率

:

0.460

∣

否

≈

6.80

∗

1

0

−

5

P(好瓜=否)=P_{青绿|否}\times P_{蜷缩|否}\times P_{浊响|否}\times P_{清晰|否}\times P_{凹陷|否}\times P_{硬滑|否}\times P_{密度:0.697|否}\times P_{含糖率:0.460|否}\approx 6.80*10^{-5}

P(好瓜=否)=P青绿∣否×P蜷缩∣否×P浊响∣否×P清晰∣否×P凹陷∣否×P硬滑∣否×P密度:0.697∣否×P含糖率:0.460∣否≈6.80∗10−5

结果: 0.038 > 6.80 ∗ 1 0 − 5 0.038 > 6.80*10^{-5} 0.038>6.80∗10−5 可以看出“好瓜”概率更高,因此最终判别结果为“好瓜”

7.不同类型的朴素贝叶斯分类器:

根据特征的不同类型,朴素贝叶斯分类器可以分为高斯朴素贝叶斯、多项式朴素贝叶斯和伯努利朴素贝叶斯等。

高斯朴素贝叶斯:适用于特征为连续变量的情况。它假设连续特征值服从高斯分布(正态分布),通过计算每个类别的均值和方差来估计条件概率。

多项式朴素贝叶斯:适用于特征为离散变量且取值较多(如文本分类中的词频)的情况。它假设特征值服从多项式分布,通过计算每个特征值在类别中出现的频率来估计条件概率。

伯努利朴素贝叶斯:适用于特征为二元变量(0或1)的情况。它假设特征值服从伯努利分布,即每个特征值只有两种可能的结果(例如,在文本分类中,一个词是否出现在文档中)。

8. 朴素贝叶斯分类器的优缺点分析

优点:

- 模型简单:基于简单的概率计算,易于实现和理解。

- 分类速度快:在训练阶段,只需要计算类别的先验概率和特征的条件概率;在分类阶段,只需要进行简单的概率乘法运算。

- 对噪声数据有较好的鲁棒性:在特征之间相关性较小的情况下,分类性能稳定。

缺点:

- 特征独立性假设:实际应用中,特征之间往往存在一定的相关性,这使得朴素贝叶斯分类器的性能可能受到影响。

- 对输入数据的表达形式敏感:对于不同的特征表示方式,可能需要选择不同类型的朴素贝叶斯分类器。

- 对于不平衡数据集可能表现不佳:当数据集中各类别的样本数量差异很大时,朴素贝叶斯分类器的性能可能会受到影响。

四、贝叶斯算法在机器学习中的应用

贝叶斯算法在机器学习中具有广泛的应用,尤其是在文本分类、情感分析等领域。下面我们将详细探讨贝叶斯算法在这些场景中的应用,并给出一个简单的贝叶斯垃圾邮件分类的代码示例。

1. 文本分类与垃圾邮件检测

文本分类是机器学习中的一个重要任务,其中贝叶斯分类器常被用于垃圾邮件检测。垃圾邮件检测的目标是将电子邮件划分为垃圾邮件和非垃圾邮件两类。

在垃圾邮件检测中,我们通常将邮件中的单词或词组作为特征,邮件的类别(垃圾邮件或非垃圾邮件)作为标签。然后,我们可以使用朴素贝叶斯分类器来训练模型。对于给定的新邮件,分类器会根据训练得到的条件概率来预测其类别。

假设我们有以下数据集:

特征:邮件中的单词 (x_1, x_2, …, x_n)

类别:垃圾邮件(spam)或非垃圾邮件(ham)

我们可以使用朴素贝叶斯公式来计算邮件属于某个类别的概率:

P ( C ∣ x 1 , x 2 , . . . , x n ) = P ( x 1 , x 2 , . . . , x n ∣ C ) P ( C ) P ( x 1 , x 2 , . . . , x n ) P(C|x_1, x_2, ..., x_n) = \frac{P(x_1, x_2, ..., x_n|C)P(C)}{P(x_1, x_2, ..., x_n)} P(C∣x1,x2,...,xn)=P(x1,x2,...,xn)P(x1,x2,...,xn∣C)P(C)

由于朴素贝叶斯假设特征之间独立,因此:

P ( x 1 , x 2 , . . . , x n ∣ C ) = ∏ i = 1 n P ( x i ∣ C ) P(x_1, x_2, ..., x_n|C) = \prod_{i=1}^{n} P(x_i|C) P(x1,x2,...,xn∣C)=i=1∏nP(xi∣C)

这样,我们就可以通过计算每个单词在给定类别下的条件概率来估计邮件的类别。

下面是一个简单的Python代码示例,使用scikit-learn库中的朴素贝叶斯分类器进行垃圾邮件检测:

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.naive_bayes import MultinomialNB

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 假设我们有一些标记过的邮件数据

emails = ["这是垃圾邮件", "这不是垃圾邮件", "请不要购买这个产品", "我喜欢这个产品"]

labels = [1, 0, 1, 0] # 1表示垃圾邮件,0表示非垃圾邮件

# 将文本数据转换为特征向量

vectorizer = CountVectorizer()

X = vectorizer.fit_transform(emails)

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, labels, test_size=0.2, random_state=42)

# 使用朴素贝叶斯分类器进行训练

clf = MultinomialNB()

clf.fit(X_train, y_train)

# 在测试集上进行预测并计算准确率

y_pred = clf.predict(X_test)

accuracy = accuracy_score(y_test, y_pred)

print(f"Accuracy: {accuracy:.2f}")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

2. 情感分析与观点挖掘

情感分析是自然语言处理中的一个重要任务,旨在分析文本中的情感倾向,如积极、消极或中 性。贝叶斯分类器也可以用于情感分析,将文本划分为不同的情感类别。

在情感分析中,我们通常将文本中的词汇、短语或n-gram作为特征,情感标签(如积极、消极)作为类别。然后,我们可以使用类似于垃圾邮件检测的方法,训练一个朴素贝叶斯分类器来进行情感分析。

3. 机器学习中的其他应用案例

除了文本分类和情感分析外,贝叶斯算法在机器学习中还有许多其他应用。例如,在推荐系统中,贝叶斯网络可以用于建模用户的行为和偏好,以进行个性化推荐。在自然语言处理中,贝叶斯方法可以用于词性标注、句法分析等任务。此外,贝叶斯优化等方法也被广泛应用于超参数调优等机器学习实践中。

总的来说,贝叶斯算法在机器学习中具有广泛的应用前景,其基于概率的推理方式使得它能够处理各种不确定性和复杂性。通过深入理解贝叶斯算法的原理和应用,我们可以更好地利用它来解决实际机器学习问题。

六、贝叶斯算法的局限性及改进方法

尽管贝叶斯算法在机器学习中有着广泛的应用,但它也存在一些局限性。这些局限性主要源于其理论假设和实际应用中的挑战。下面我们将分析贝叶斯算法的局限性,并探讨一些针对这些局限性的改进策略与方法。

1. 贝叶斯算法的局限性分析

(1)特征独立性假设

朴素贝叶斯分类器的一个核心假设是特征之间的独立性。然而,在现实世界的数据集中,特征之间往往存在一定的依赖关系。这种假设的简化虽然降低了计算的复杂性,但也可能导致分类性能的下降。

(2)对输入数据的敏感性

贝叶斯算法对输入数据的表示形式和质量非常敏感。例如,在文本分类中,如果特征选择不当或文本预处理不充分,可能会影响分类器的性能。此外,如果数据集存在类别不平衡问题,贝叶斯分类器也可能受到影响。

(3)计算复杂度

对于大规模数据集或高维特征空间,贝叶斯分类器的计算复杂度可能较高。特别是当特征数量很多时,计算条件概率表会变得非常耗时。

2. 针对局限性的改进策略与方法

(1)半朴素贝叶斯分类器

为了缓解特征独立性假设的限制,研究者提出了半朴素贝叶斯分类器。这类分类器放松了特征之间完全独立的假设,允许在一定程度上考虑特征之间的依赖关系。例如,可以通过引入超参数或构建特征之间的依赖图来改进模型。

(2)特征选择与文本预处理

针对输入数据的敏感性,可以通过特征选择和文本预处理来改进贝叶斯分类器的性能。特征选择可以帮助我们筛选出对分类任务最有用的特征,减少噪声和冗余信息的影响。文本预处理则包括分词、去除停用词、词干提取等步骤,有助于提升文本数据的表示质量。

(3)集成学习方法

集成学习是一种有效的提高分类器性能的方法。通过将多个贝叶斯分类器的预测结果进行组合(如投票或加权平均),可以提高整体的分类精度和稳定性。这种方法尤其适用于处理不平衡数据集或提高模型的鲁棒性。

(4)贝叶斯网络的扩展与应用

对于复杂的依赖关系和数据结构,可以考虑使用贝叶斯网络来替代朴素贝叶斯分类器。贝叶斯网络能够更灵活地表示变量之间的依赖关系,并通过学习网络结构和参数来优化分类性能。此外,贝叶斯网络还可以与其他机器学习算法结合使用,形成更强大的混合模型。

下面是一个改进后的贝叶斯垃圾邮件分类的代码示例,使用了TF-IDF特征提取和朴素贝叶斯分类器:

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.naive_bayes import MultinomialNB

from sklearn.pipeline import make_pipeline

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score, classification_report

# 假设我们有一些标记过的邮件数据和对应的标签

emails = ["这是垃圾邮件", "这不是垃圾邮件", "请不要购买这个产品", "我喜欢这个产品"]

labels = [1, 0, 1, 0] # 1表示垃圾邮件,0表示非垃圾邮件

# 使用TF-IDF进行特征提取

tfidf_vectorizer = TfidfVectorizer(stop_words='english') # 假设我们处理的是英文邮件,这里使用英文停用词

# 创建朴素贝叶斯分类器的管道,包含特征提取和分类两个步骤

clf = make_pipeline(tfidf_vectorizer, MultinomialNB())

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(emails, labels, test_size=0.2, random_state=42)

# 训练模型

clf.fit(X_train, y_train)

# 在测试集上进行预测

y_pred = clf.predict(X_test)

# 计算准确率和其他分类指标

accuracy = accuracy_score(y_test, y_pred)

report = classification_report(y_test, y_pred)

print(f"Accuracy: {accuracy:.2f}")

print(report)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

这个示例中,我们使用了TF-IDF(词频-逆文档频率)来提取文本特征,它考虑了词在文档中的频率以及词在整个语料库中的稀有程度。这种特征提取方法通常比简单的词频计数更能捕捉到文本中的关键信息。此外,我们还使用了scikit-learn提供的管道功能,将特征提取和分类器训练整合在一起,简化了代码流程。最后,我们计算了分类器的准确率和其他分类指标来评估模型的性能。

七、总结与展望

1. 总结贝叶斯算法在机器学习中的核心价值和意义

贝叶斯算法在机器学习中扮演着至关重要的角色,其核心价值和意义主要体现在以下几个方面:

首先,贝叶斯算法提供了一种基于概率的推理框架,能够处理各种不确定性和复杂性。在现实世界的数据集中,特征之间的依赖关系、类别的模糊性等问题往往难以避免。贝叶斯算法通过计算条件概率来估计类别的后验概率,从而能够在这些不确定性中找到最可能的分类结果。

其次,贝叶斯算法具有坚实的数学理论基础,其推导过程清晰且易于理解。这使得贝叶斯算法在实际应用中具有较高的可靠性和稳定性。同时,贝叶斯算法的计算过程相对简单,使得它能够在处理大规模数据集时保持较高的效率。

最后,贝叶斯算法在文本分类、情感分析、推荐系统等多个领域都有广泛的应用。通过结合具体场景和数据特点,贝叶斯算法能够发挥出强大的分类和预测能力,为机器学习应用提供有力的支持。

2. 展望贝叶斯算法未来的发展趋势及应用前景

随着大数据和人工智能技术的不断发展,贝叶斯算法在未来的应用前景将更加广阔。以下是一些可能的发展趋势:

首先,随着深度学习等复杂模型的兴起,贝叶斯算法可以与其他机器学习算法进行融合,形成更强大的混合模型。例如,可以将贝叶斯网络与深度神经网络相结合,以更好地处理复杂的特征依赖关系和分类任务。

其次,贝叶斯算法在处理不确定性和解释性方面具有独特优势。在未来的研究中,可以进一步探索贝叶斯算法在不确定性建模、可解释性机器学习等领域的应用,以提高机器学习模型的鲁棒性和可信度。

此外,随着计算能力的提升和算法优化技术的发展,贝叶斯算法在处理大规模数据集和高维特征空间时的性能将得到进一步提升。这将使得贝叶斯算法在更多实际场景中得到应用,为机器学习领域的发展注入新的活力。

八、参考资料

周志华 著.机器学习,北京:清华大学出版社,2016. (ISBN 978-7-302-42328-7);

微信名片

微信名片

评论记录:

回复评论: