在人工智能蓬勃发展的时代,国产化技术的崛起为行业带来了新的机遇。飞腾 CPU 作为国产芯片的杰出代表,逐渐在 AI 和高性能计算领域崭露头角。飞腾 CPU 与 DeepSeek 大模型的结合,为高效、安全的 AI 应用提供了强大动力。

本文将详细介绍飞腾公司及其 CPU,深入解析 DeepSeek 大模型的特征与优势,并结合飞腾 CPU 和 DeepSeek 的特点,阐述其结合的先进性。同时,本文将分享如何在飞腾 CPU 平台上部署 DeepSeek 大模型,涵盖环境搭建、模型部署、性能优化等关键步骤,并结合 NVIDIA GPU 的加速能力,实现高效的推理和应用。

前言:飞腾 CPU 与 DeepSeek 大模型介绍

飞腾系列 CPU

飞腾系列CPU是中国自主研发的高性能处理器,广泛应用于服务器、桌面终端及嵌入式设备,基于ARM指令集设计,兼具高性能与低功耗特性,其代表型号如腾云S5000C和腾锐D3000在AI推理、多路并行计算等领域已接近国际主流水平。截至2024年,飞腾CPU累计销量突破1000万片,国内市场占有率超70%,深度融入政务、金融、能源等关键领域,并依托“PK体系”(飞腾+麒麟操作系统)与7100余家生态伙伴合作,完成超400万项软硬件适配,构建了从芯片到操作系统的国产化生态链。在政策驱动下,飞腾通过天津信创产业集群实现全链条布局,2024年产业链规模达1100亿元,同时加速向AI领域延伸,支持DeepSeek大模型本地化部署,推动国产算力从“可用”向“好用”升级,成为突破国际技术垄断、重塑全球科技竞争格局的核心力量。

腾云 S5000C 芯片

飞腾腾云S5000C是飞腾公司自主研发的高性能服务器级处理器,基于ARMv8指令集设计,支持多路互联和硬件虚拟化,提供64核、32核、16核三种型号,主频达2.1-2.3GHz,配备DDR5内存和PCIe 5.0接口,性能卓越。该芯片专为数据中心、云计算和AI计算设计,支持多机多卡分布式计算,适配LLaMA、智谱华章等主流大模型,推理性能达到国际主流方案的80%-93%,性价比突出。S5000C广泛应用于政务云、金融、能源等领域,与麒麟操作系统构建“PK体系”,适配超7100家生态伙伴的软硬件产品,完成超400万项兼容认证。凭借高性能、低功耗和高安全性,S5000C成为国产服务器芯片标杆,推动信创产业链发展,助力国产算力从“可用”向“好用”升级,为全球科技竞争注入新动能。

DeepSeek 大模型

DeepSeek的成立背景与全球AI大模型的热潮密不可分。2022年OpenAI发布GPT-3后,AI大模型成为科技领域的焦点。DeepSeek在成立之初,便致力于开发自有的大语言模型,以应对市场需求。2023年底,DeepSeek发布了其首个模型DeepSeek-V1,支持文本生成、对话、摘要和代码生成等功能。尽管此时DeepSeek尚未引起广泛关注,但其技术路线已初具雏形。2024年是DeepSeek技术突破的关键一年。5月,DeepSeek发布了V2版本,在V1的基础上提升了模型性能,减少了错误率,并增强了上下文理解能力,同时支持多模态功能。这一版本的成功为DeepSeek赢得了更多企业合作机会。 12月26日,DeepSeek推出了开源模型DeepSeek-V3。该模型在多项基准测试中表现优异,超越了Meta的Llama3.1-405B等开源模型,并与OpenAI的GPT-4o闭源模型不相上下。更重要的是,DeepSeek-V3的训练成本仅为557.6万美元,远低于GPT-4o的7800万美元,展现了其在算法优化和成本控制方面的卓越能力。 2025年1月,DeepSeek迎来了全面爆发。1月20日,DeepSeek发布了推理模型DeepSeek-R1,该模型以极低的成本实现了与OpenAI o1相当的性能,成为大模型行业的“黑马”。DeepSeek的APP端日活跃用户(DAU)在1月末达到2215万,成为全球增速最快的AI应用之一,仅次于ChatGPT。其在157个国家和地区的苹果应用商店下载量排名第一,进一步巩固了其市场地位。 此外,DeepSeek的开源策略和低成本优势吸引了众多企业接入,包括中国电信、中国移动、中国联通等三大运营商,以及华为、中兴、金蝶等科技巨头。这些企业将DeepSeek模型集成到其云服务和产品中,推动了AI技术的广泛应用。

DeepSeek 大模型在多个方面展现出先进性:

DeepSeek的成功离不开其技术创新:****算法优化****:通过MLA算法、流水线策略和MoE调度等方式,DeepSeek大幅降低了训练成本,同时提升了模型性能。****强化学习路径****:DeepSeek-R1摒弃了传统的监督微调路径,转而通过强化学习优化推理能力,验证了纯强化学习在模型推理中的可行性。****开源策略****:DeepSeek的开源模型降低了AI技术的使用门槛,促进了AI应用生态的繁荣发展。DeepSeek的低成本策略对行业产生了深远影响。其训练成本仅为竞争对手的十分之一,使得更多中小企业和开发者能够参与AI技术的研发与应用,推动了AI技术的普及截至2025年2月,DeepSeek的最新技术进展包括:****API服务优化****:DeepSeek-V3和R1的API服务已全面上线,尽管价格有所上调,但仍具有较高的性价比,吸引了大量企业用户。****国产AI芯片适配****:华为昇腾等国产AI芯片已全面支持DeepSeek模型,进一步推动了国产算力的发展。未来,DeepSeek将继续探索AI技术的边界,特别是在多模态、量子计算和脑机接口等前沿领域。其低成本、高性能的开源模型有望在全球AI市场中占据更重要的地位,为AI技术的普及和应用开辟新的可能性。

腾云 S5000C 芯片在部署 DeepSeek 大模型时具有显著优势:

- 自主高性能核心:集成多个飞腾自主研发的高性能处理器核,兼容 64 位 ARMv8 指令集,主频高达 2.5GHz,单核性能相比上一代产品有显著提升,提供强大的并行计算能力,能够高效处理复杂计算任务。

- 优化存储结构:采用多级缓存设计,支持多种内存接口,优化存储访问延时,提供较高的计算性能和访存带宽,满足对内存和存储的高需求。

- 硬件虚拟化支持:支持硬件虚拟化技术,适用于高性能服务器领域,为大模型部署提供稳定可靠的运行环境,提高资源利用率和系统灵活性。

- 高扩展性与安全性:集成丰富拓展接口,支持飞腾自主定义的 PSPA 2.0 安全架构规范,从底层保障性能和数据安全,实现关后门、堵漏洞。

- 应用场景广泛:适用于计算服务器、存储服务器、AI 服务器、高端网安、行业级业务主机服务器系统、大型互联网数据中心等多种场景,满足用户对高效能处理器的需求。

一、硬件与软件环境准备

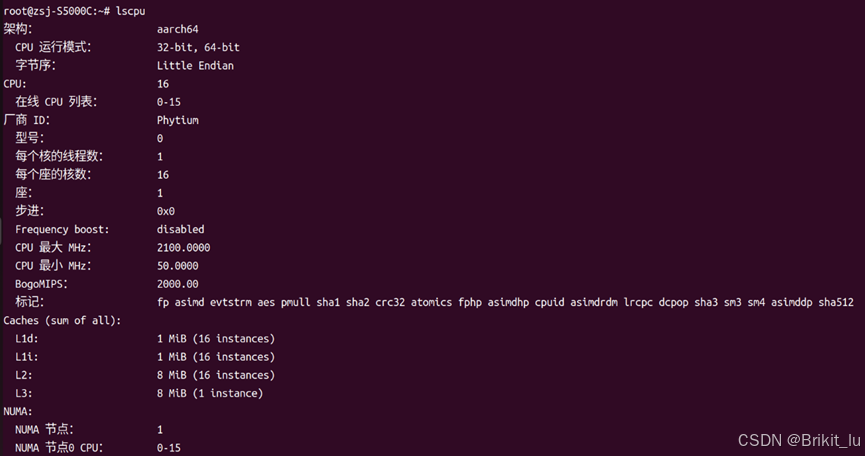

硬件环境

- CPU:S5000C/16

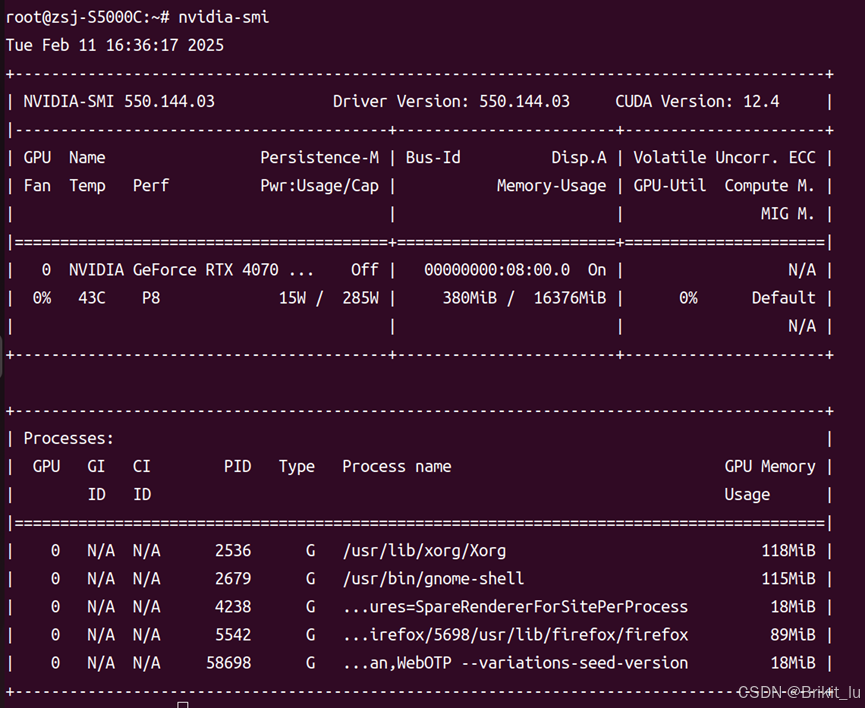

- GPU:NVIDIA GeForce RTX 4070 Ti Super

软件环境

- 操作系统:Ubuntu 22.04

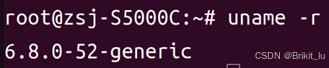

- Linux 内核:6.8.0.52

-

NVIDIA GPU 驱动:535.144.03

-

CUDA 版本:12.4

二、部署步骤

部署步骤

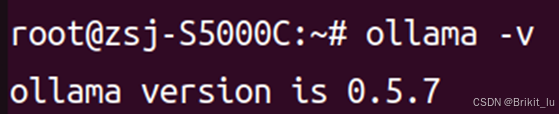

第一步:下载并安装 Ollama

- 使用

wget下载 Ollama 的 Linux ARM64 版本:

wget https://ollama.com/download/ollama-linux-arm64.tgz

- 1

注意:如果下载失败,请检查网络连接或更换网络环境后重试。

- 解压并安装 Ollama:

sudo tar -C /usr -xzf ollama-linux-arm64.tgz

- 1

- 验证安装:

ollama -v

- 1

如果安装成功,会显示 Ollama 的版本信息。

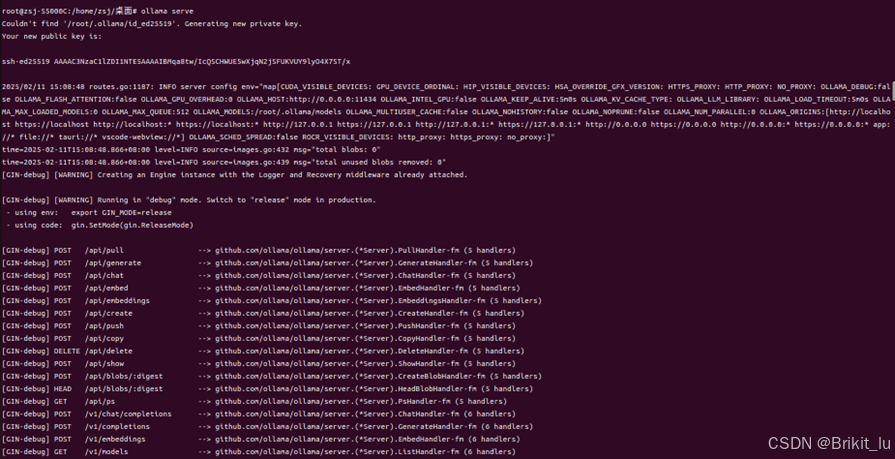

第二步:启动 Ollama 服务

运行以下命令启动 Ollama 服务:

ollama serve

- 1

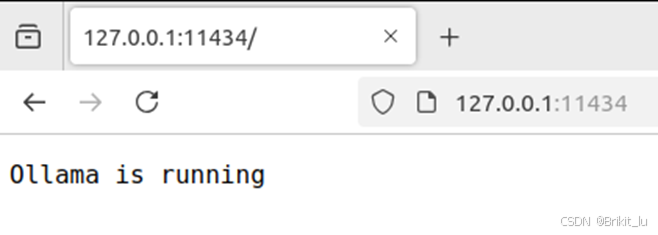

在浏览器输入 127.0.0.1:11434 查看ollama 的服务有没有运行起来

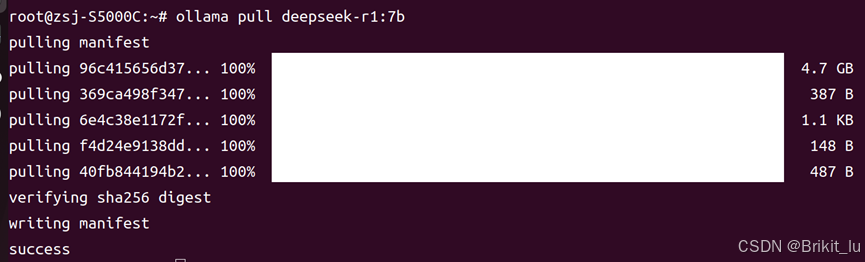

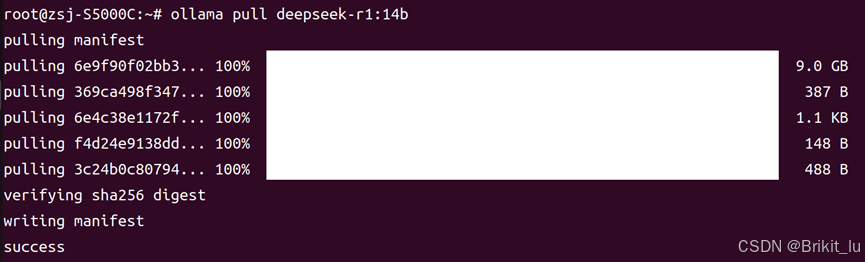

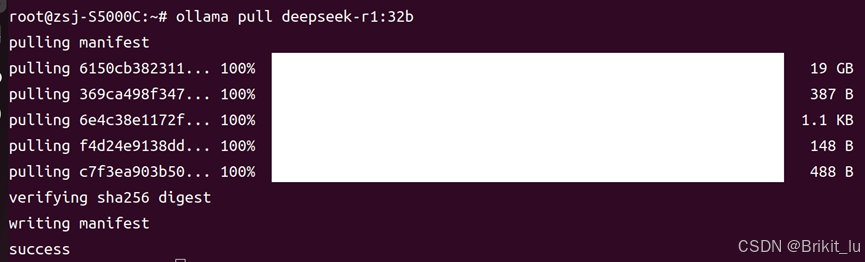

第三步:拉取 DeepSeek 模型

使用 Ollama 命令拉取所需的 DeepSeek 模型:

ollama pull deepseek-r1:7b

- 1

ollama pull deepseek-r1:14b

- 1

ollama pull deepseek-r1:32b

- 1

根据实际需求选择合适的模型版本。

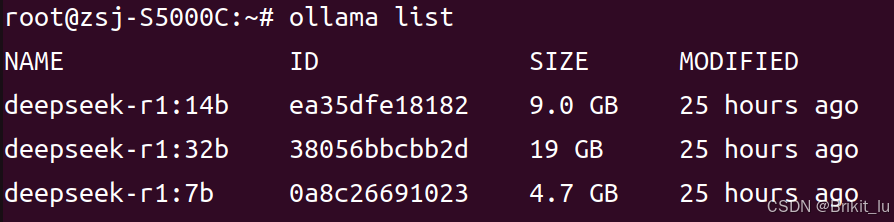

第四步:查看已下载模型

运行以下命令查看已下载的模型列表:

ollama list

- 1

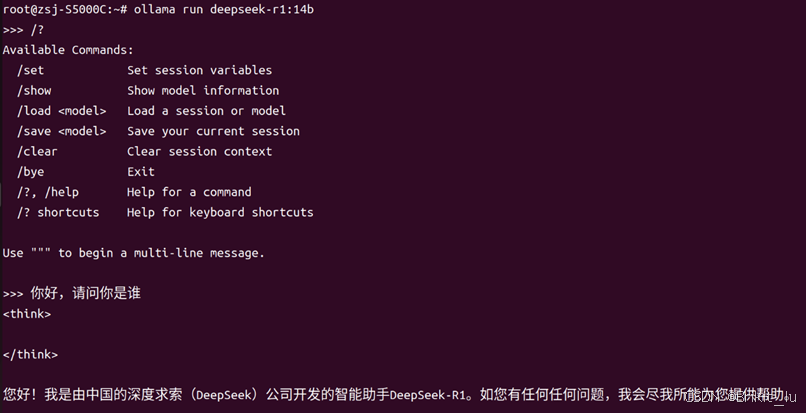

第五步:运行模型并与 DeepSeek 进行对话

启动 DeepSeek 模型进行推理:

ollama run deepseek-r1:14b

- 1

能看到显存已经占用了一大部分,运行ollama官网进行了Q4量化的14b模型大概需要12G以上的显存,如果是要运行32b的Q4量化模型,大概需要22G以上的显存,我们的显存只有16G,运行32b模型会爆显存,模型会有一部分加载在内存上面,之后会用CPU进行推理生成token会很慢,所以这里只运行14b的模型。

此时,你可以通过终端与 DeepSeek 模型进行交互,输入问题并获取回答。

第六步:部署 AnythingLLM 容器

从 Docker Hub 拉取 AnythingLLM 容器:

docker pull mintplexlabs/anythingllm

- 1

第七步:运行 AnythingLLM 容器

配置anythingllm的数据存储位置:

export STORAGE_LOCATION="/var/lib/anythingllm" && \

mkdir -p $STORAGE_LOCATION && \

touch "$STORAGE_LOCATION/.env"

- 1

- 2

- 3

运行以下命令启动 AnythingLLM 容器:

docker run -d \

--name anythingllm \

--add-host=host.docker.internal:host-gateway \

--env STORAGE_DIR=/app/server/storage \

--health-cmd "/bin/bash /usr/local/bin/docker-healthcheck.sh || exit 1" \

--health-interval 60s \

--health-start-period 60s \

--health-timeout 10s \

--cap-add SYS_ADMIN \

-p 3001:3001/tcp \

--restart=always \

--user anythingllm \

-v ${STORAGE_LOCATION}:/app/server/storage \

-v ${STORAGE_LOCATION}/.env:/app/server/storage/.env \

-w /app \

mintplexlabs/anythingllm

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

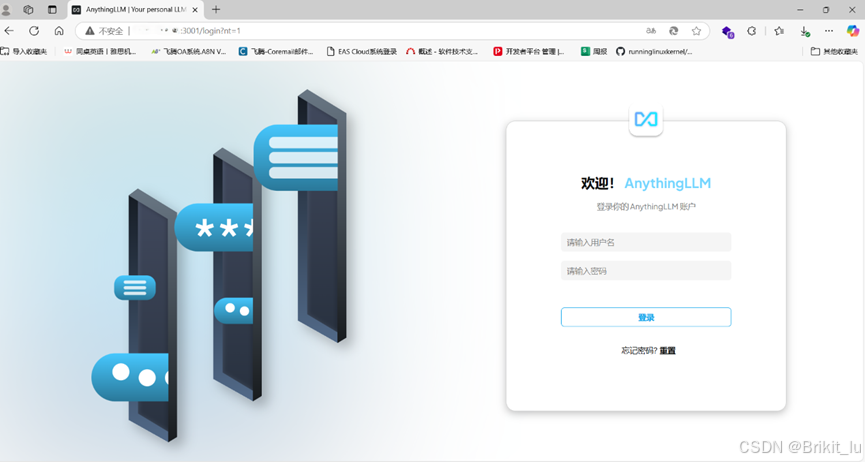

第八步:访问 AnythingLLM 服务

在浏览器中输入以下地址访问 AnythingLLM 服务:

http://<IP>:3001

- 1

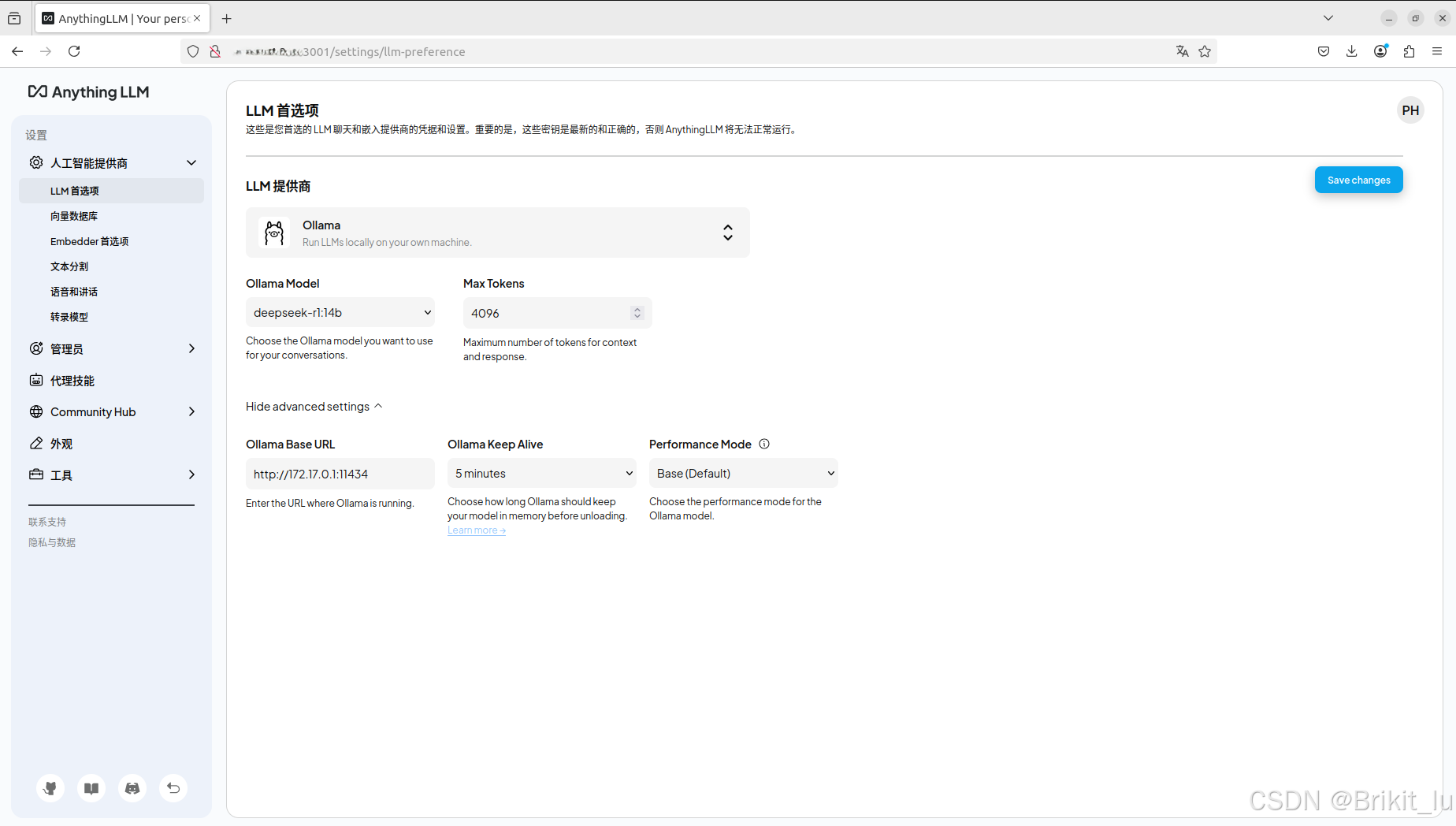

第九步:配置 AnythingLLM 并调用 Ollama API

ollama URL 那里比较坑,有时候会识别不到,可以尝试

127.0.0.1:11434,172.17.0.1:11434,,:11434 host.docker.internal:11434等多种方式来访问,在运行ollama serve之前可以export OLLAMA_HOST=0.0.0.0让ollama的API能够被容器识别到,希望这些经验能对你有所帮助

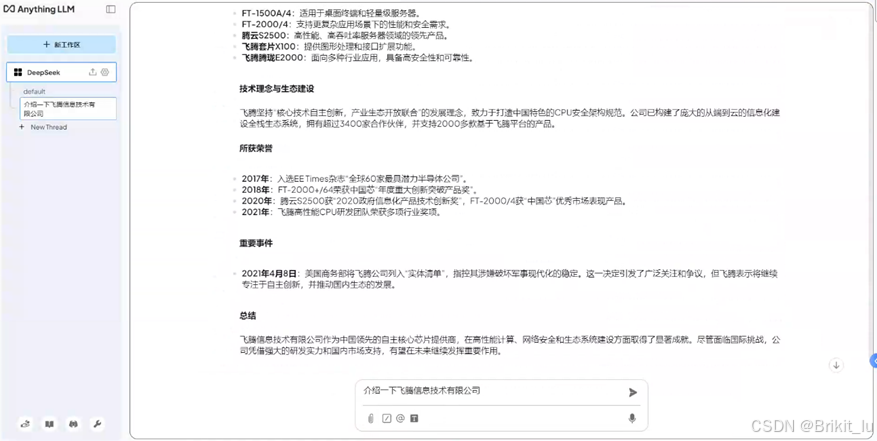

第十步:使用 AI 进行对话

完成配置后,即可通过 AnythingLLM 与 DeepSeek 模型进行对话,体验强大的 AI 交互功能。

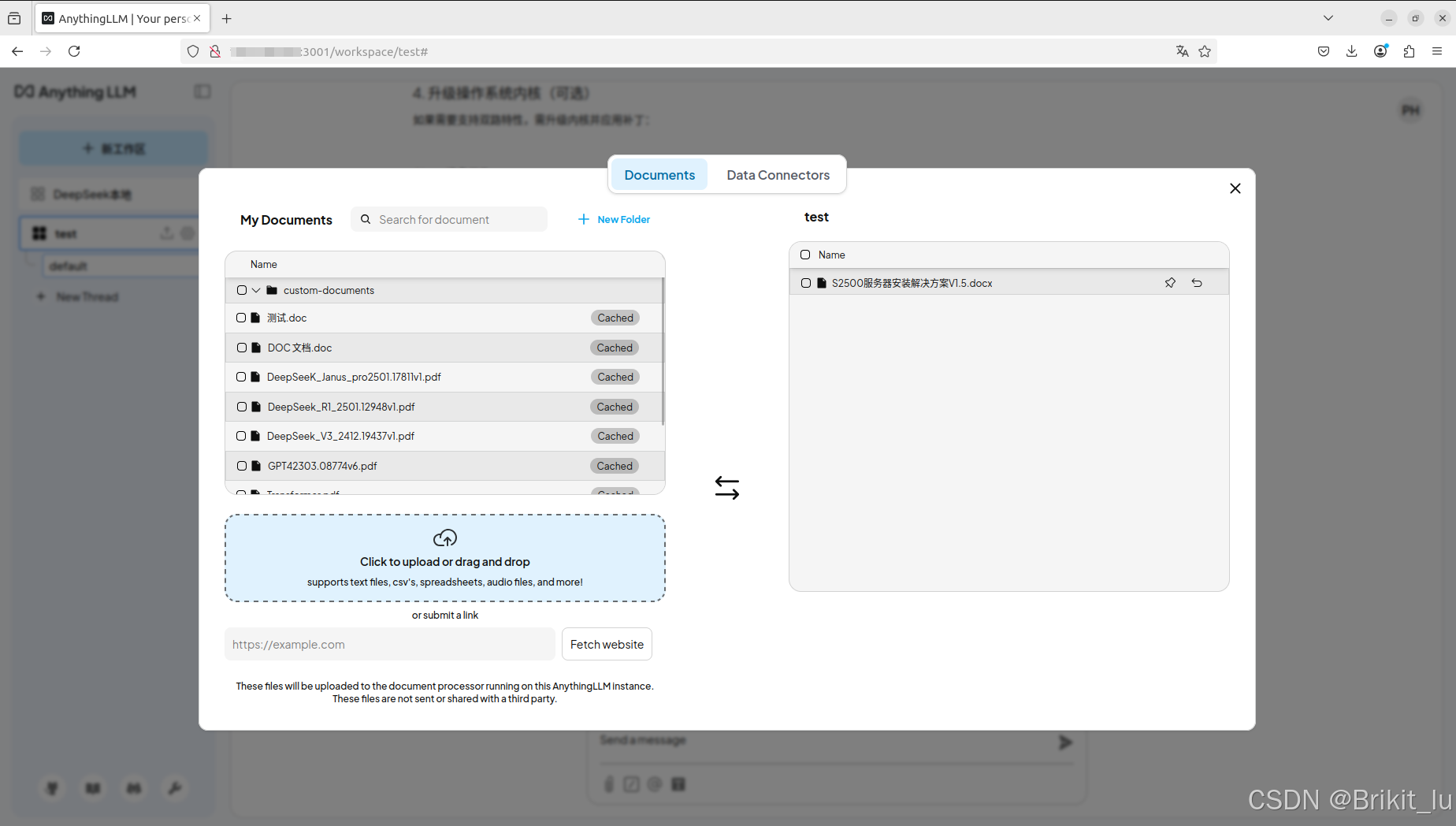

第十一步:使用知识库问答

上传文档到本地知识库

使用AI调用本地知识库进行对话

可以看到回答调用了知识库里面文档的内容,生成的token速度也很快

基于飞腾CPU平台+DeepSeek的本地知识库搭建完毕

三、总结:飞腾CPU平台与DeepSeek模型结合方案优势

通过以上步骤,我们成功在飞腾 CPU 平台上部署了 DeepSeek 大模型,包括环境搭建、模型下载与运行、以及与AnythingLLM的集成使用,并结合 NVIDIA GPU 的加速能力实现了高效的推理和应用。飞腾 CPU 的高性能与 DeepSeek 大模型的强大能力相结合,为本地知识库的搭建提供了坚实的基础。飞腾 CPU 和 DeepSeek 大模型的结合,不仅体现了国产化技术的先进性,还为行业提供了安全、高效、灵活的 AI 解决方案。通过结合飞腾CPU的强大性能和DeepSeek-R1的高效推理能力,用户可以在国产化平台上实现安全、高效的AI应用部署

评论记录:

回复评论: