欢迎关注[【AIGC论文精读】](https://blog.csdn.net/youcans/category_12321605.html)原创作品

【DeepSeek论文精读】1. 从 DeepSeek LLM 到 DeepSeek R1

【DeepSeek论文精读】2. DeepSeek LLM:以长期主义扩展开源语言模型

【DeepSeek论文精读】3. DeepSeekMoE:迈向混合专家语言模型的终极专业化

【DeepSeek论文精读】4. DeepSeek-V2:强大、经济且高效的混合专家语言模型

【DeepSeek论文精读】5. DeepSeek-V3 技术报告

【DeepSeek论文精读】6. DeepSeek R1:通过强化学习激发大语言模型的推理能力

DeepSeek 推理大模型 R1的发布在AI社区引发了冲击波,颠覆了人们对实现尖端AI性能所需条件的假设。DeepSeek 完全跳过监督微调(SFT),选择依赖强化学习(RL)来训练模型。

与OpenAI的o1相比,其成本仅为3%-5%。这种开源模式不仅吸引了开发人员,还挑战了企业重新思考其AI战略。

在一组第三方基准测试中,涵盖从复杂问题解决,到数学和编码的准确性方面,DeepSeek模型的表现优于Meta Llama 3.1、OpenAI的GPT-4o 和 Anthropic的Claude Sonnet 3.5。

微软CEO萨蒂亚·纳德拉(Satya Nadella)周三在瑞士达沃斯举行的世界经济论坛上表示:“看到DeepSeek的新模型,无论是他们如何真正有效地完成了一个开源模型来进行推理时间计算,还是计算效率方面,都令人印象深刻。我们应该非常认真地对待这一发展。”

本文简要介绍从 DeepSeek LLM、DeepSeek MoE、DeepSeek V2、DeepSeek V3 到 DeepSeek R1 的发展历程。本系列将逐篇解读 DeepSeek 论文和模型。

1. DeepSeek LLM

1.1 简介

- 论文标题:DeepSeek LLM: Scaling Open-Source Language Models with Longtermism

DeepSeek LLM - 发布时间:2024 年 1 月

- 论文地址:https://arxiv.org/pdf/2401.02954

- 主要内容:

- 基于 Transformer 架构,采用分组查询注意力(GQA)优化推理成本。

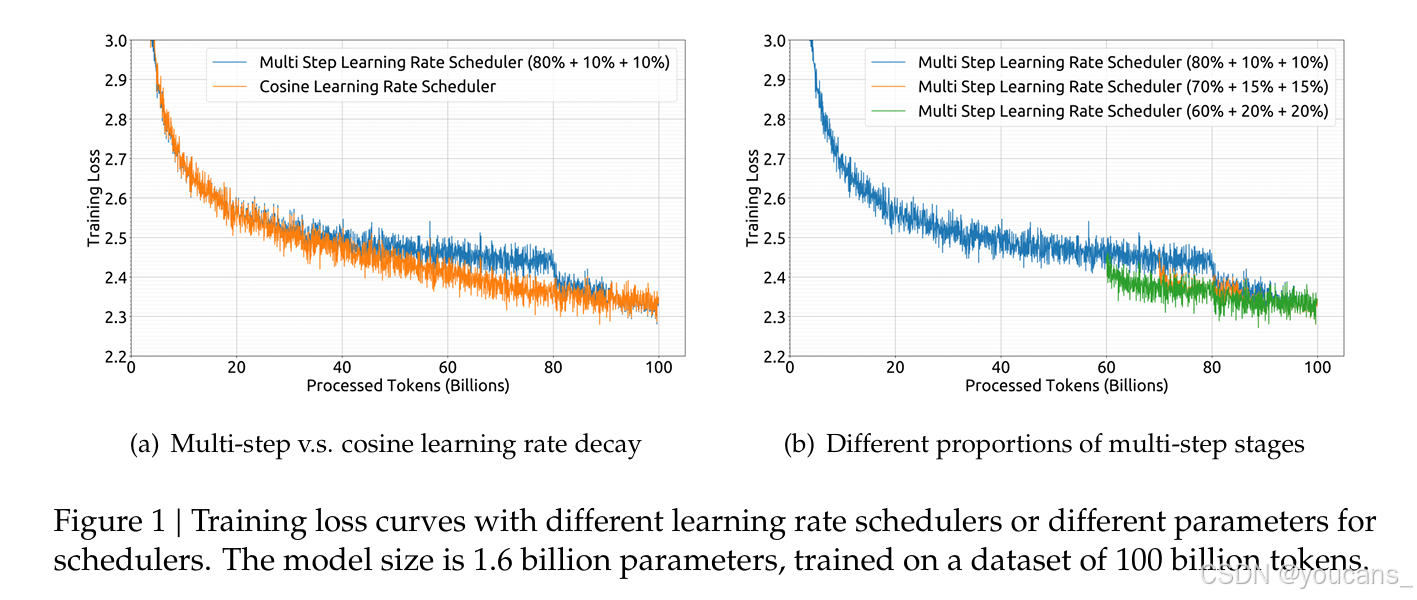

- 支持多步学习率调度器,提升训练效率。

- 在预训练和对齐(监督微调与 DPO)方面进行了创新。

- 数据集规模:DeepSeek LLM 使用了一个包含 2 万亿字符的双语数据集进行预训练,这比 LLaMA 的数据集更大。

- 模型性能:DeepSeek LLM 在多个基准测试中表现优于 LLaMA,特别是在代码、数学和推理方面。

1.2 摘要

论文主要讨论了开源大型语言模型(LLMs)的快速发展以及如何通过 DeepSeek LLM 项目来推进这种发展。

首先,开源大型语言模型的发展非常迅速,但之前的文献中描述的规模定律得出了不同的结论,这给规模化的LLM蒙上了一层阴影。

然后,作者深入研究了规模定律,并提出了自己独特的发现,这些发现有助于在两种流行的开源配置(7B和67B)中扩展大型模型。在规模定律的指导下,作者引入了DeepSeek LLM项目,该项目致力于从长远的角度推进开源语言模型的发展。

为了支持预训练阶段,作者开发了一个目前包含2万亿个tokens(2 trillion tokens)的数据集,并且还在不断扩大。作者还对DeepSeek LLM基础模型进行了SFT和直接偏好优化(DPO),从而创建了DeepSeek Chat模型。

最后,评估结果表明,DeepSeek LLM 67B在各种基准测试中超过了LLaMA-2 70B,特别是在代码、数学和推理领域。此外,开放式评估显示,与GPT-3.5相比,DeepSeek LLM 67B Chat表现出更优越的性能。

1.3 结论

论文介绍了DeepSeek LLMs,这是一系列在2万亿标记的英语和中文大型数据集上从头开始训练的开源模型。在本文中,深入解释了超参数选择、扩展定律以及做过的各种微调尝试。校准了先前工作中的扩展定律,并提出了新的最优模型/数据扩展-缩放分配策略。此外,还提出了一种方法,使用给定的计算预算来预测近似的batch-size和learning-rate。进一步得出结论,扩展定律与数据质量有关,这可能是不同工作中不同扩展行为的原因。在扩展定律的指导下,使用最佳超参数进行预训练,并进行全面评估。

DeepSeek Chat与其他LLMs一样存在公认的局限性,包括预训练后缺乏持续的知识更新、可能生成非事实信息以及产生幻觉的倾向。此外,中文数据初始版本并不详尽,这可能导致在某些特定中文主题上的性能不佳。由于数据主要由中文和英文来源组成,因此模型在其他语言的熟练程度不佳。

- 不久后,DeepSeek 将分别发布关于代码方面以及Mixture-of-Experts(MoE)的技术报告。它们将展示如何为预训练创建高质量的代码数据,并设计稀疏模型以实现密集模型的性能。

- 目前,正在为即将到来的DeepSeek LLM版本构建更大、更完善的数据集。希望下一版在推理、中文知识、数学和代码能力方面有显著提升。

- DeepSeek 对齐团队致力于研究如何向公众提供有帮助、诚实和安全的模型。初步实验证明,强化学习可以提升模型的复杂推理能力。

2. DeepSeek MoE

2.1 简介

- 论文标题:DeepSeekMoE: Towards Ultimate Expert Specialization in Mixture-of-Experts Language Models

- 发布时间:2024 年 1 月

- 论文地址:https://arxiv.org/pdf/2401.06066

- Github地址:https://github.com/deepseek-ai/DeepSeek-MoE

- 主要内容:

- 提出细粒度专家分割(Fine-Grained Expert Segmentation)和共享专家隔离(Shared Expert Isolation)策略。

- 通过更灵活的专家组合提升模型性能,同时保持计算成本不变。。

- 数据集规模:16B。

论文提出了DeepSeekMoE,这是一种创新的MoE架构,专门设计用于实现终极专家专业化(expert specialization)。通过细粒度的专家分割和共享专家隔离,DeepSeekMoE相比主流的MoE架构实现了显著更高的专家专业化和性能。从较小的2B参数规模开始,论文验证了DeepSeekMoE的优势,展示了其接近MoE模型上限性能的能力。此外,论文证明DeepSeekMoE具有比GShard更高水平的专家特化。

2.2 摘要

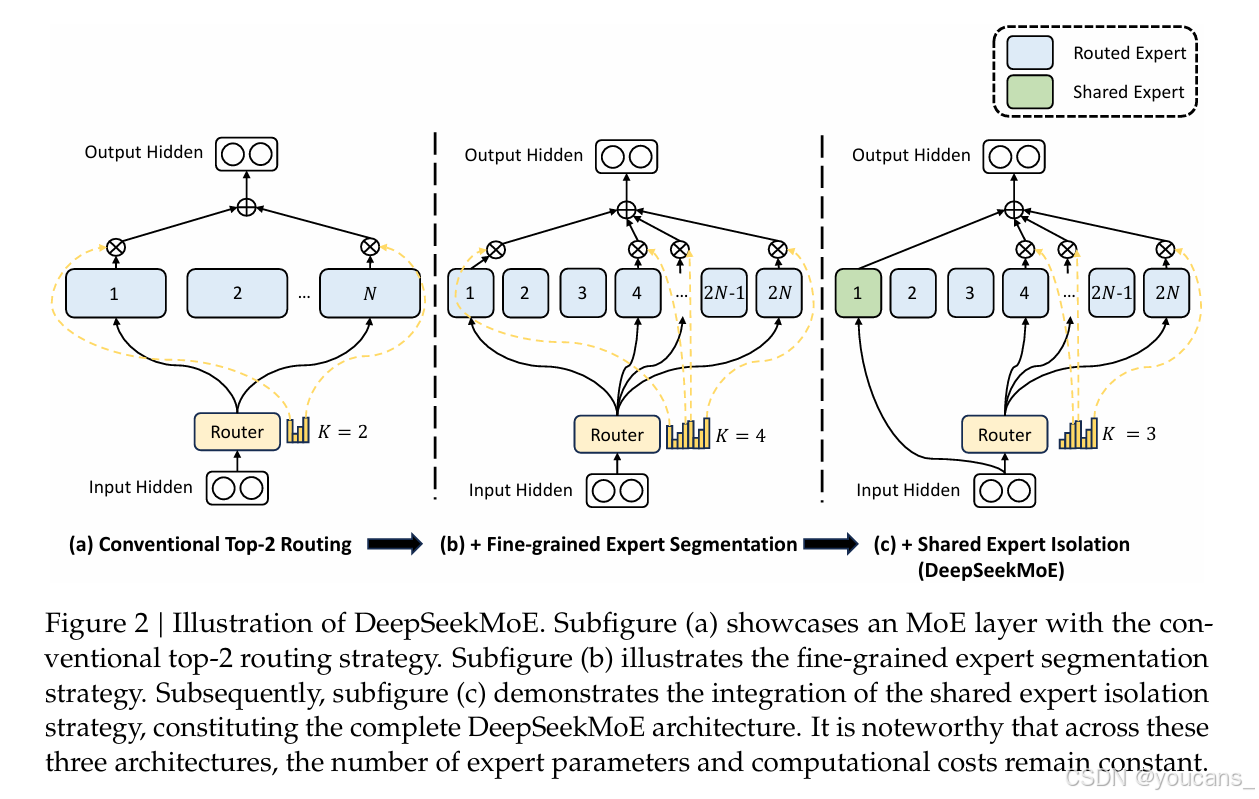

在大型语言模型时代,混合专家(Mixture-of-Experts, MoE)架构是一种有前途的架构,用于在扩展模型参数时管理计算成本。然而,传统的MoE架构如GShard,激活前?个专家中的?个,面临着确保专家专业化的问题,即每个专家获得非重叠且专注的知识。

为此,我们提出了DeepSeekMoE架构,旨在实现最终的专家专业化。DeepSeekMoE 涉及两个主要策略:

(1)将专家精细划分为??个,并从中激活??个,从而实现更灵活的激活专家组合;

(2)隔离??个专家作为共享专家,旨在捕捉共同知识并减少路由专家的冗余。

本文的贡献总结如下:

- 架构创新。我们引入了DeepSeekMoE,这是一种旨在实现最终专家专业化的创新MoE架构,采用了细粒度专家分割和共享专家隔离两个主要策略。

- 实证验证。我们进行了广泛的实验,以实证验证DeepSeekMoE架构的有效性。实验结果验证了DeepSeekMoE 2B中高水平专家专业化的有效性,并表明DeepSeekMoE 2B几乎接近MoE模型的性能上限。

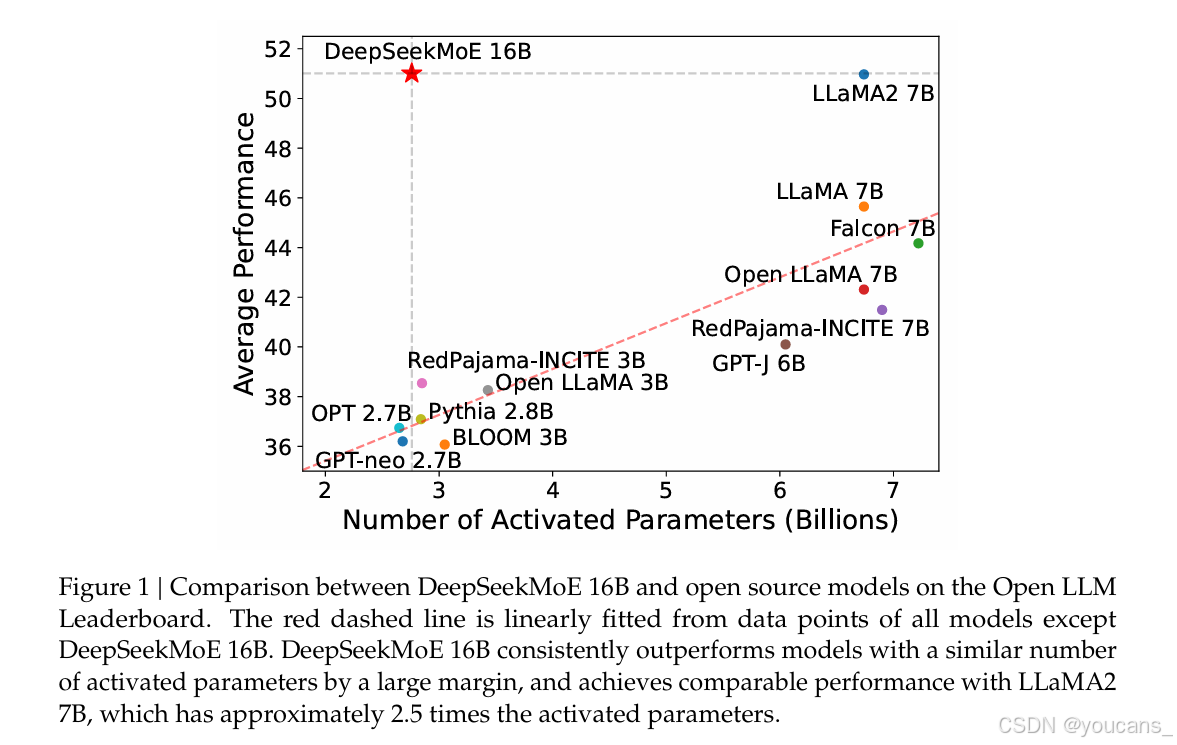

- 可扩展性。我们将DeepSeekMoE扩展到训练16B模型,并显示仅使用约40%的计算量,DeepSeekMoE 16B的性能与DeepSeek 7B和LLaMA2 7B相当。我们还进行了将DeepSeekMoE扩展到145B的初步努力,突显了其相对于GShard架构的持续优势,并显示其性能与DeepSeek 67B相当。

- 对齐MoE。我们成功地对DeepSeekMoE 16B进行了有监督微调,创建了一个对齐的聊天模型,展示了DeepSeekMoE 16B的适应性和多功能性。

- 公开发布。本着开放研究的精神,我们将DeepSeekMoE 16B的模型检查点公开发布。值得注意的是,该模型可以在单个40GB内存的GPU上部署,无需量化。

Figure 1 :DeepSeekMoE 16B与开源模型在Open LLM Leaderboard上的比较。红色虚线是从除DeepSeekMoE 16B之外的所有模型的数据点线性拟合得到的。DeepSeekMoE 16B始终以很大的优势胜过具有类似激活参数数量的模型,并在性能上与LLaMA2 7B相媲美,后者的激活参数数量大约是其2.5倍

2.3 结论

我们介绍了用于MoE语言模型的DeepSeekMoE架构,旨在实现最终的专家专业化。

通过细粒度专家分割和共享专家隔离,DeepSeekMoE在专家专业化和性能方面显著优于现有的MoE架构。

从2B参数的适度规模开始,我们验证了DeepSeekMoE的优势,展示了其接近MoE模型性能上限的能力。

此外,我们提供了实证证据,表明DeepSeekMoE在专家专业化水平上高于GShard。扩展到16B总参数的更大规模,我们在2T token上训练DeepSeekMoE 16B,并展示了其与DeepSeek 7B和LLaMA2 7B相当的卓越性能,仅使用了约40%的计算量。

此外,我们进行了有监督微调以实现对齐,构建了基于DeepSeekMoE 16B的MoE聊天模型,进一步展示了其适应性和多功能性。

进一步,我们进行了将DeepSeekMoE扩展到145B参数的初步探索。我们发现DeepSeekMoE 145B仍然保持相对于GShard架构的显著优势,并展示了与DeepSeek 67B相当的性能,仅使用了28.5%(甚至可能18.2%)的计算量。

为了研究目的,我们将DeepSeekMoE 16B的模型检查点公开发布,该模型可以在单个40GB内存的GPU上部署。我们希望这项工作能为学术界和工业界提供有价值的见解,并促进大规模语言模型的加速发展。

3. DeepSeek V2

3.1 简介

- 论文标题:DeepSeek-V2: A Strong, Economical, and Efficient Mixture-of-Experts Language Model

- 发布时间:2024 年 5 月

- 论文地址:https://arxiv.org/pdf/2405.04434

- Github地址:https://github.com/deepseek-ai/DeepSeek-MoE

- 主要内容:

- 引入了 MLA,一种配备低秩key-value联合压缩的注意力机制,显著减少了推理过程中的 KV 缓存,从而提高了推理效率。

- 遵循 DeepSeekMoE 架构,该架构采用细粒度专家分割和共享专家隔离,以实现更高效的专业化潜力。

论文地址:https://arxiv.org/abs/2405.044343

3.2 摘要

DeepSeek-V2 是一个混合专家 (MoE, Mixture-of-Experts) 语言模型,具有训练经济、推理高效的特点。它包含 236B 总参数,其中每个 token 激活 21B,支持 128K tokens 的上下文长度。

DeepSeek-V2 采用包括多头潜注意(MLA) 和 DeepSeek MoE 在内的创新架构。MLA 通过将KV缓存显著压缩为潜向量来保证高效推理,而 DeepSeek MoE 通过稀疏计算以经济的成本训练强大的模型。

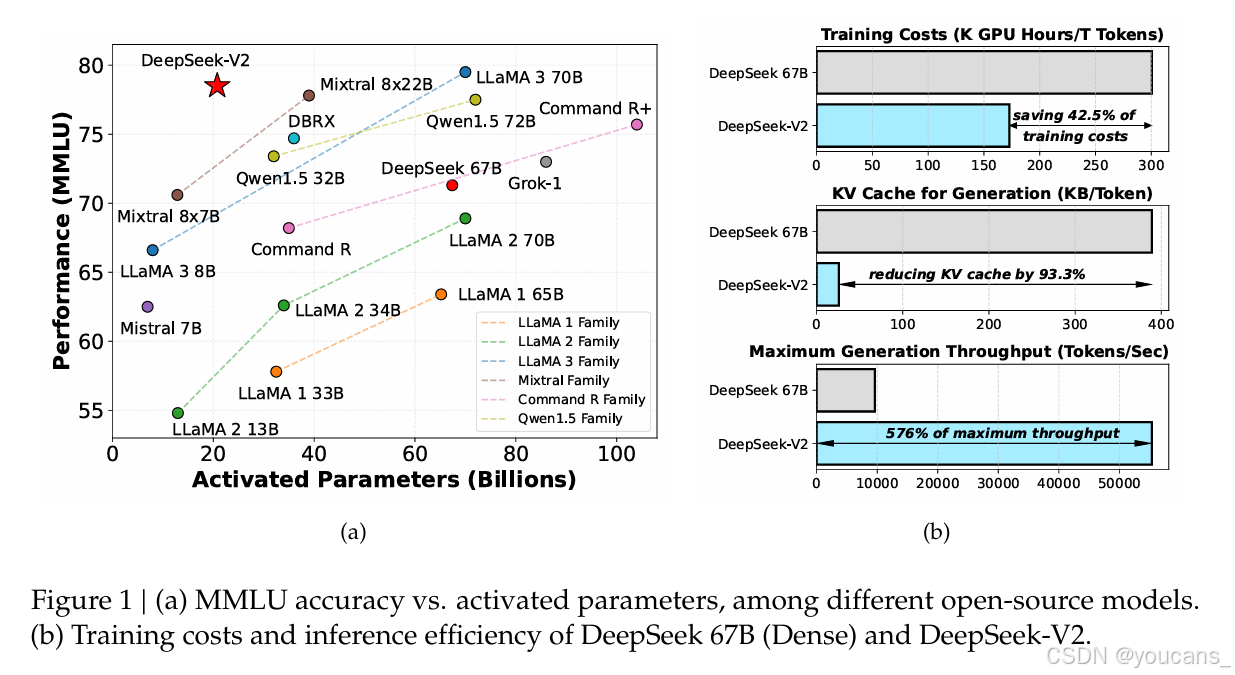

与 DeepSeek 67B 相比,DeepSeek-V2 实现了显著增强的性能,同时节省了 42.5% 的训练成本、减少了 93.3% 的 KV 缓存、并将最大生成吞吐量提升至 5.76 倍。在由 8.1T 标记组成的高质量多源语料库上对 DeepSeek-V2 进行预训练,并进一步执行有监督微调 (SFT) 和强化学习 (RL) 以充分发挥其潜力。

评估结果表明,即使只有 21B 激活参数,DeepSeek-V2 及其聊天版本仍然在开源模型中实现了顶级性能。

模型检查点位于 https://github.com/deepseek-ai/DeepSeek-V2。

3.3 结论

我们介绍了 DeepSeek-V2,一个支持 128K 上下文长度的大型 MoE 语言模型。 除了强大的性能之外,它还具有经济训练和高效推理的特点,这得益于其包括 MLA 和 DeepSeekMoE 在内的创新架构。 实际应用中,与 DeepSeek 67B 相比,DeepSeek-V2 的性能明显增强,同时节省了 42.5% 的训练成本,减少了 93.3% 的 KV 缓存,最大生成吞吐量提升至 5.76 倍。 评估结果进一步表明,仅用21B个激活参数,DeepSeek-V2就达到了开源模型中顶级的性能,成为最强的开源MoE模型。

DeepSeek-V2及其聊天版本具有其他大语言模型中常见的公认局限性,包括预训练后缺乏持续的知识更新、可能生成非事实信息(例如未经验证的建议)以及产生幻觉的机会。 此外,由于我们的数据主要由中文和英文内容组成,因此我们的模型对其他语言的熟练程度可能有限。 中英文以外的场景请谨慎使用。

DeepSeek将以长远的眼光持续投资开源大型模型,旨在逐步接近通用人工智能的目标。

-

在我们不断的探索中,我们致力于设计能够进一步扩展 MoE 模型的方法,同时保持经济的训练和推理成本。 我们下一步的目标是在即将发布的版本中实现与 GPT-4 相当的性能。

-

我们的对齐团队不断努力增强我们的模型,旨在开发一个对全球用户不仅有帮助而且诚实和安全的模型。 我们的最终目标是使模型的价值观与人类价值观保持一致,同时最大限度地减少人类监督的需要。 通过优先考虑道德考虑和负责任的发展,我们致力于为社会创造积极和有益的影响。

-

目前,DeepSeek-V2 专门支持文本模式。 在我们的前瞻性议程中,我们打算使我们的模型能够支持多种模式,增强其在更广泛场景中的多功能性和实用性。

4. DeepSeek-V3

4.1 简介

- 论文标题:DeepSeek-V3 Technical Report

- 发布时间:2024 年 12 月

- 论文地址:https://github.com/LRriver/DeepSeek-V3/blob/main/DeepSeek_V3.pdf

- Github地址:https://github.com/deepseek-ai/DeepSeek-V3

- 主要内容:

- DeepSeek-V3 是一款性能卓越的混合专家(MoE) 语言模型,整体参数规模达到 671B,其中每个 token 激活的参数量为 37B。

- DeepSeek-V3 在性能上超越了其他开源模型,并能够与主流闭源模型相媲美。

4.2 摘要

DeepSeek V3(DeepSeek-V3)是一款强大的混合专家(Mixture-of-Experts, MoE)语言模型,总参数量为6710亿,每个token激活370亿参数。

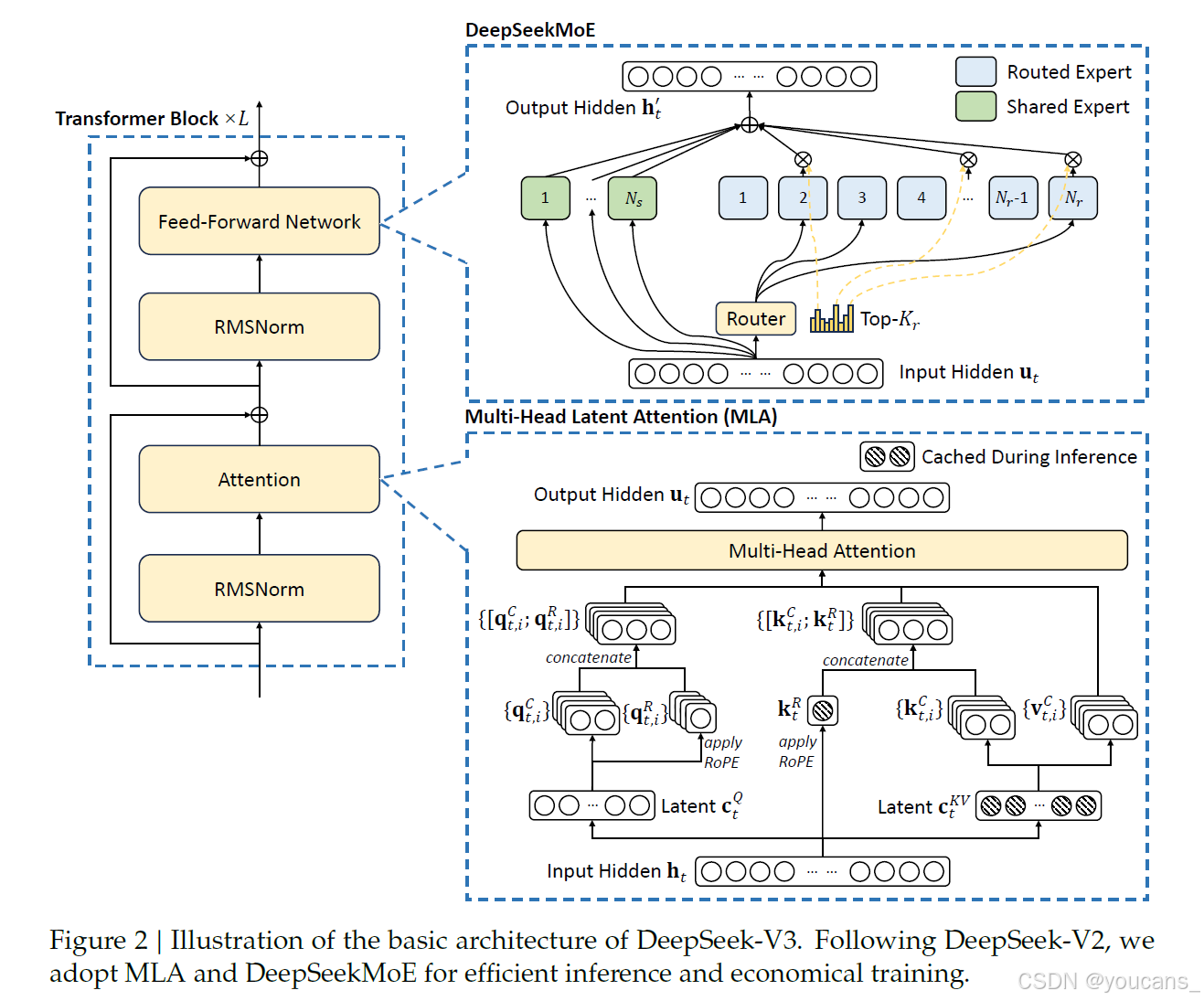

为了实现高效的推理和成本效益高的训练,DeepSeek-V3采用了多头潜在注意力(Multi-head Latent Attention, MLA)和深度探索MoE架构,这些架构已经在深度探索V2中得到了充分验证。

此外,DeepSeek-V3开创了无辅助损失的负载均衡策略,并设定了多token预测训练目标以增强性能。

DeepSeek-V3在14.8万亿高质量且多样化的token上进行了预训练,随后经过监督微调和强化学习阶段,充分发挥了其能力。

全面的评估显示,DeepSeek-V3在性能上超越了其他开源模型,并达到了与领先闭源模型相当的水平。尽管性能卓越,DeepSeek-V3的完整训练仅需278.8万H800 GPU小时。此外,其训练过程非常稳定,整个训练过程中没有出现任何不可恢复的损失峰值,也未进行过回滚。模型检查点可在https://github.com/deepseek-ai/DeepSeek-V3获取。

-

创新点

- 架构设计:通过 MLA 和 DeepSeekMoE 架构实现高效的推理和低成本训练。

- 辅助无损策略:采用了辅助无损策略来实现负载均衡。

- 多 token 预测:通过多 token 预测训练目标提高数据效率和模型表现。

- FP8 混合精度训练:在极大规模模型上验证了 FP8 训练的有效性,通过支持 FP8 计算和存储,实现加速训练和减少 GPU 内存使用。

-

工作成果

- 模型性能优秀:DeepSeek-V3 在多个基准测试中超越了其他开源模型,与领先的闭源模型相当。

- 训练成本较低:完整训练仅需要 2.788M H800 GPU 小时,训练成本相对较低。

- 良好的稳定性:在整个训练过程中,没有经历任何无法挽回的 loss spikes 或需要执行任何回滚操作。

4.3 结论

本研究介绍了 DeepSeek-V3 大规模混合专家语言模型,该模型总参数量达到 671B,每次处理激活 37B 参数,训练数据规模达 14.8T token。

模型在延续 MLA 和 DeepSeekMoE 架构优势的基础上,创新性地提出了无辅助损失负载均衡策略,并引入多 token 预测训练目标以提升性能。

通过采用 FP8 训练技术和精细的工程优化,模型实现了高效的训练过程。在后训练阶段,成功将 DeepSeek-R1 系列模型的推理能力迁移至新模型。

综合评估显示,DeepSeek-V3 不仅成为当前性能最强的开源模型,还达到了与 GPT-4o 和 Claude-3.5-Sonnet 等顶级闭源模型相当的水平。同时,模型维持了极具竞争力的训练成本,完整训练过程(包括预训练、上下文长度扩展和后训练)仅需 2.788M H800 GPU 小时。

尽管模型在性能和训练效率上表现出色,但仍存在一些局限性,特别是在部署方面:首先,为保证推理效率,模型的最小部署单元规模较大,可能超出小型团队的资源能力;其次,虽然当前部署方案使模型的端到端生成速度比上一代提升了两倍以上,但仍有优化空间。这些局限性有望随着硬件技术的进步得到自然解决。

秉持长期发展理念,DeepSeek 将继续坚持开源路线,稳步推进通用人工智能的研究。未来研究将重点关注以下方向:

- 持续优化模型架构,提升训练和推理效率,探索支持无限上下文长度的高效方案。同时突破 Transformer 架构的固有局限,拓展模型的建模能力边界。

- 深化训练数据的质量提升和规模扩展,探索新的训练信号来源,实现数据在多个维度的全面扩展。

- 加强模型的深层推理能力,通过扩展推理的广度和深度,提升模型的智能水平和问题解决能力。

- 建立更全面的多维度评估体系,避免过度优化特定基准测试集而产生的能力误判,确保模型评估的科学性和全面性。

5. DeepSeek R1

5.1 简介

- 论文标题:DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning

- 发布时间:2025 年 1 月

- 论文地址:https://arxiv.org/pdf/2501.12948v1

- Github 地址:https://github.com/deepseek-ai/DeepSeek-R1

- 主要贡献:

- 基于 DeepSeek-V3-Base,通过强化学习(RL)提升推理能力,而不使用任何SFT数据。

- 引入冷启动数据和多阶段训练流程,优化模型的可读性和性能。

5.2 摘要

本文介绍了我们的第一代推理模型DeepSeek-R1-Zero和DeepSeek-R1。

DeepSeek-R1-Zero是一个通过大规模强化学习(RL)训练的模型,在初步步骤中没有使用监督微调(SFT),它展示了出色的推理能力。

通过强化学习,DeepSeek-R1-Zero自然地展现出许多强大且有趣的推理行为。然而,它也遇到了一些挑战,如可读性差和语言混用问题。

为了解决这些问题并进一步提升推理性能,我们引入了DeepSeek-R1,该模型在强化学习之前结合了多阶段训练和冷启动数据。

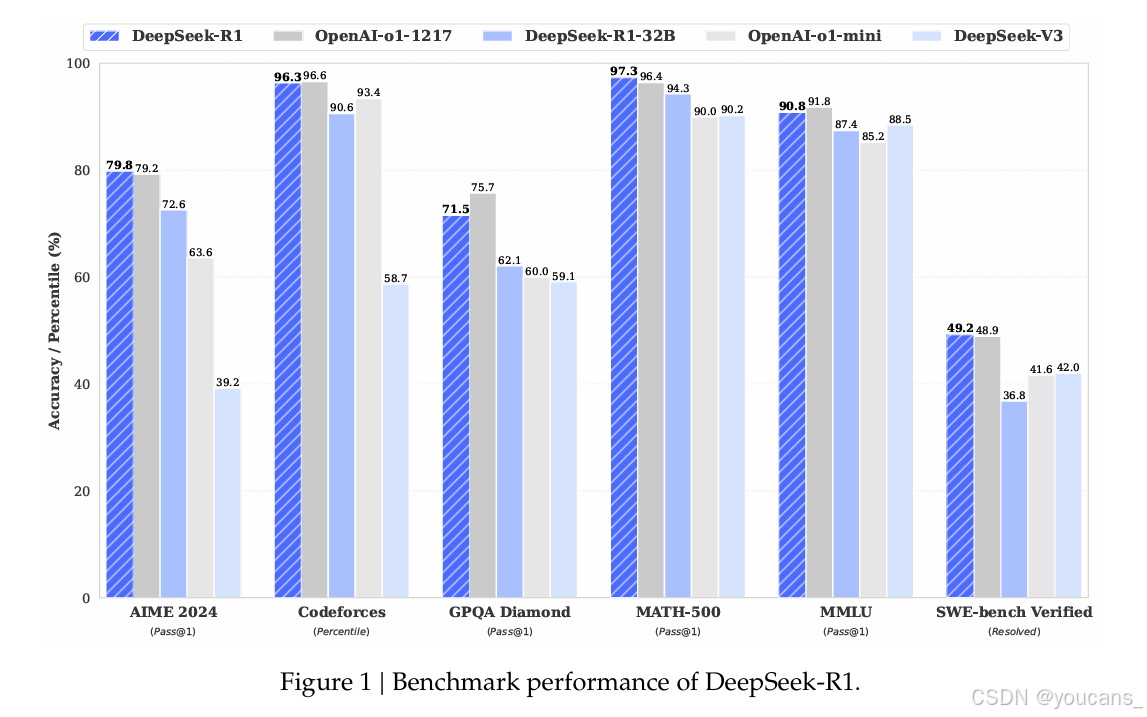

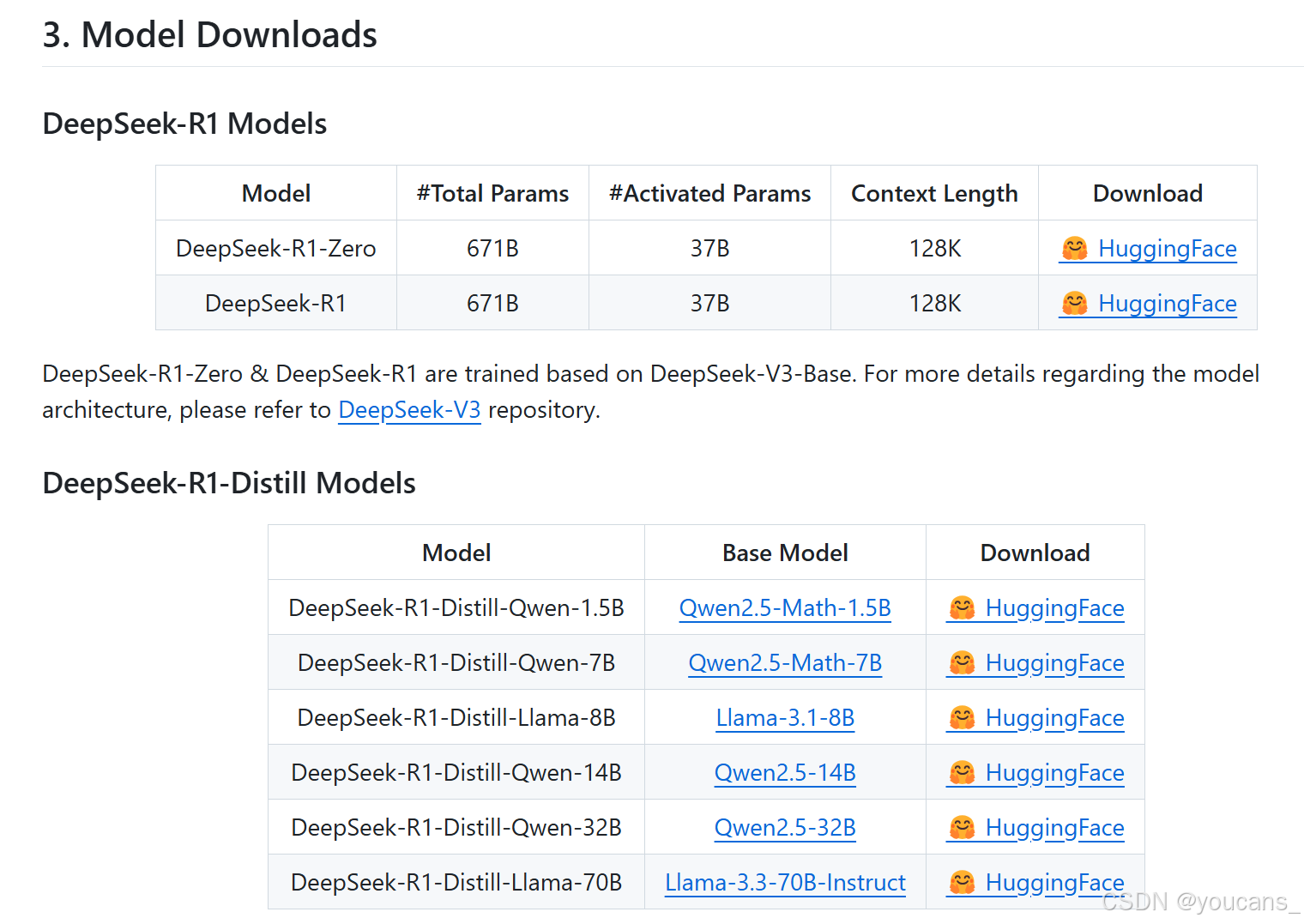

DeepSeek-R1在推理任务上的表现与OpenAI-o1-1217相当。为了支持研究社区,我们开源了DeepSeek-R1-Zero、DeepSeek-R1以及从DeepSeek-R1基于Qwen和Llama蒸馏出的六个密集模型(分别为15亿、70亿、80亿、140亿、320亿和700亿参数)。

-

DeepSeek-R1-Zero 的构建过程展示了如何通过纯强化学习激励大型语言模型自我进化,从而提升推理能力。尽管它面临可读性和语言混合等挑战,但其在多个推理任务上的表现证明了RL在提升模型推理能力方面的巨大潜力。DeepSeek-R1-Zero 的成功为未来的研究提供了新的方向,尤其是在无需监督数据的情况下,如何通过RL进一步优化模型的推理能力。

-

DeepSeek-R1 通过引入冷启动数据和多阶段训练管道,显著提升了模型的推理能力和可读性。它在多个推理任务上的表现与 OpenAI 的 o1-1217 相当,甚至在某些任务上超越了它。通过蒸馏技术,DeepSeek-R1 的推理能力还被成功迁移到更小的模型上,展示了其在推理任务中的强大潜力。DeepSeek-R1 的成功为未来的研究提供了新的方向,尤其是在如何通过冷启动和多阶段训练进一步提升模型性能方面。

-

通过蒸馏技术,作者成功地将 DeepSeek-R1 的强大推理能力迁移到了多个小型密集模型上。蒸馏后的模型在多个基准测试中表现优异,展示了知识迁移的有效性。蒸馏技术不仅降低了计算成本,还为在资源受限环境中部署高性能推理模型提供了新的可能性。

5.3 结论

在本文中,我们分享了通过强化学习(Reinforcement Learning, RL)提升模型推理能力的旅程。DeepSeek-R1-Zero代表了一种纯粹的RL方法,不依赖冷启动数据,其在各种任务上表现出色。DeepSeek-R1更为强大,它结合了冷启动数据和迭代的RL微调。最终,DeepSeek-R1在多个任务上的表现与OpenAI-o1-1217相当。

我们进一步探索将推理能力蒸馏到小型密集模型中。我们使用DeepSeek-R1作为教师模型生成800K数据,并微调多个小型密集模型。结果令人鼓舞:DeepSeek-R1-Distill-Qwen-1.5B在数学基准测试上超过了GPT-4o和Claude-3.5-Sonnet,分别在AIME上达到28.9%,在MATH上达到83.9%。其他密集模型也取得了令人瞩目的成绩,显著超过基于相同底层检查点的其他指令微调模型。

在未来,我们计划在以下方向上投入研究以进一步提升DeepSeek-R1:

- 通用能力:目前,DeepSeek-R1在函数调用、多轮对话、复杂角色扮演和json输出等任务上的能力不如DeepSeekV3。未来,我们计划探索如何利用长链式思维(Chain-of-Thought, CoT)来提升这些领域的任务能力。

- 语言混合:DeepSeek-R1目前针对中文和英文进行了优化,这可能导致处理其他语言查询时出现语言混合问题。例如,DeepSeek-R1可能在推理和响应中使用英文,即使查询不是英文或中文。我们计划在未来更新中解决这一限制。

- 提示工程:在评估DeepSeek-R1时,我们观察到它对提示非常敏感。少量提示一致地降低了其性能。因此,我们建议用户直接描述问题并使用零示例设置指定输出格式,以获得最佳结果。

- 软件工程任务:由于评估时间较长,影响RL过程的效率,大规模RL尚未广泛应用于软件工程任务。因此,DeepSeek-R1在软件工程基准测试上并没有显著超过DeepSeek-V3。未来版本将通过拒绝采样软件工程数据或在RL过程中引入异步评估来改善效率,从而解决这一问题。

通过这些探索和计划,我们希望在未来的版本中进一步提升DeepSeek-R1的能力,使其在更广泛的任务中表现出色。

5.4 DeepSeek R1 的下载与使用

-

使用浏览器聊天:

您可以在DeepSeek的官方网站上与DeepSeek-V3聊天:chat.deepseek.com。 -

在DeepSeek平台上提供 OpenAI 兼容的API:platform.deepseek.com。

-

DeepSeek-R1 模型下载:

DeepSeek-R1-Zero:https://huggingface.co/deepseek-ai/DeepSeek-R1-Zero

DeepSeek-R1:https://huggingface.co/deepseek-ai/DeepSeek-R1

DeepSeek-R1-Zero 和 DeepSeek-R1 基于DeepSeek-V3-Base 进行训练。 -

DeepSeek-R1-Distill 模型下载:

DeepSeek-R1-Distill-Qwen-1.5B:https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B

DeepSeek-R1-Distill-Qwen-7B:https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-7B

DeepSeek-R1-Distill-Qwen-14B:https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-14B

DeepSeek-R1-Distill-Qwen-32B:https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-32B

DeepSeek-R1-Distill-Llama-70B:https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Llama-70B

DeepSeek-R1-Distill模型是基于开源模型,使用DeepSeek-R1生成的样本进行微调的。我们稍微改变了他们的配置和标记器。

版权声明:

youcans@xidian 作品,转载必须标注原文链接:

【DeepSeek论文精读】1. 从 V0 到 R1 https://youcans.blog.csdn.net/article/details/145391398

Copyright 2025 youcans, XIDIAN

Crated:2025-01

评论记录:

回复评论: