要在电脑上本地部署DeepSeek AI大模型,你需要遵循一系列步骤来确保你拥有正确的硬件、软件环境,并正确地安装和配置必要的工具。以下是一个详细的指南,帮助你在本地计算机上部署DeepSeek R1大模型。

视频教程

电脑上如何本地部署一个Deepseek R1推理模型?

硬件准备

首先,你需要确认你的计算机硬件是否满足运行DeepSeek模型的需求。不同参数规模的DeepSeek模型对硬件有不同的要求。例如:

要在本地电脑上部署DeepSeek-R1大模型的不同版本,包括1.5B、7B、8B、14B、32B、70B和671B,需要根据每个版本的具体硬件需求来选择合适的配置。以下是对各版本的详细分析及推荐配置。

1.5B 模型

对于入门级的DeepSeek-R1-1.5B模型,其硬件需求相对较低。推荐配置如下:

- CPU:Intel i5 / Ryzen 5 或更高

- 内存(RAM):至少8GB,建议16GB以确保流畅运行

- 显卡(GPU):虽然不是必需,但如果有NVIDIA GTX 1650或更好的显卡可以提供加速

- 存储空间:至少50GB的可用空间

7B 和 8B 模型

这两个版本相较于1.5B模型有了显著的提升,因此对硬件的要求也相应增加:

- CPU:至少6核处理器,如Intel i7 / Ryzen 7

- 内存(RAM):32GB是最低要求,为了保证性能建议使用更多

- 显卡(GPU):NVIDIA RTX 3060或更高级别的显卡,至少拥有8GB显存

- 存储空间:至少100GB的空闲硬盘空间

14B 模型

随着参数量的增加,14B模型需要更高的计算能力和更多的内存:

- CPU:至少8核处理器,例如Intel i9 / Ryzen 9

- 内存(RAM):最低64GB,理想情况下应配备更多以支持复杂的推理任务

- 显卡(GPU):RTX 3080或更高,显存至少为12GB

- 存储空间:至少200GB的磁盘空间

32B 模型

对于这个级别的模型,通常需要企业级的硬件配置:

- CPU:至少8核以上的高性能处理器

- 内存(RAM):至少128GB

- 显卡(GPU):NVIDIA RTX 3090、A100或V100等高端显卡,可能需要多个显卡协同工作

- 存储空间:至少500GB的高速SSD

70B 模型

这种规模的模型几乎不可能在普通个人电脑上运行,通常需要专门的服务器环境:

- CPU:多核处理器,比如12核以上的顶级Intel或AMD CPU

- 内存(RAM):至少128GB,实际应用中可能需要更多

- 显卡(GPU):NVIDIA A100、V100显卡,通常需要多个GPU组成的集群

- 存储空间:至少1TB的高速存储

671B 模型

这是系列中最大的一个模型,仅适用于研究机构或大型企业,并且通常需要云计算资源或者专用数据中心:

- CPU:多台服务器配置,每台配备高性能、多核CPU

- 内存(RAM):至少512GB,甚至更多

- 显卡(GPU):多个NVIDIA A100或V100显卡,甚至整个GPU集群

- 存储空间:至少2TB的高效能存储解决方案

显卡推荐

对于DeepSeek-R1模型,显卡的选择至关重要,特别是对于较大的模型版本。以下是基于不同模型大小的显卡推荐:

- 对于1.5B至7B模型,可以考虑NVIDIA GTX 1650到RTX 3060之间的显卡。

- 8B到14B模型,则需要至少RTX 3080或类似级别的显卡。

- 32B及以上的大模型,推荐使用NVIDIA A100、V100等专业级显卡,这些显卡具有大量的显存和强大的计算能力。

选择适合的硬件配置取决于你计划部署的DeepSeek-R1模型的具体版本以及你的预算限制。从上述信息可以看出,即使是较小的模型也需要一定的计算资源,而较大的模型则需要高端的专业设备。此外,考虑到成本效益和实际应用场景,合理评估自己的需求是非常重要的。如果你的目标是进行大规模的数据处理或是需要极高的精度,那么投资于更强大的硬件将是必要的。反之,如果只是为了学习或小型项目,选择较小的模型版本将更加经济实用。

请注意,以上提供的配置仅供参考,具体需求可能会根据实际使用的软件环境和优化技术有所不同。例如,通过量化技术可以在一定程度上减少显存的需求,从而允许在更低规格的硬件上运行更大的模型。同时,利用诸如Ollama这样的工具可以帮助简化部署过程并优化性能表现。

如果你的电脑硬件不达标,尝试使用更小的模型版本,或者考虑升级硬件。

软件环境搭建

安装Ollama

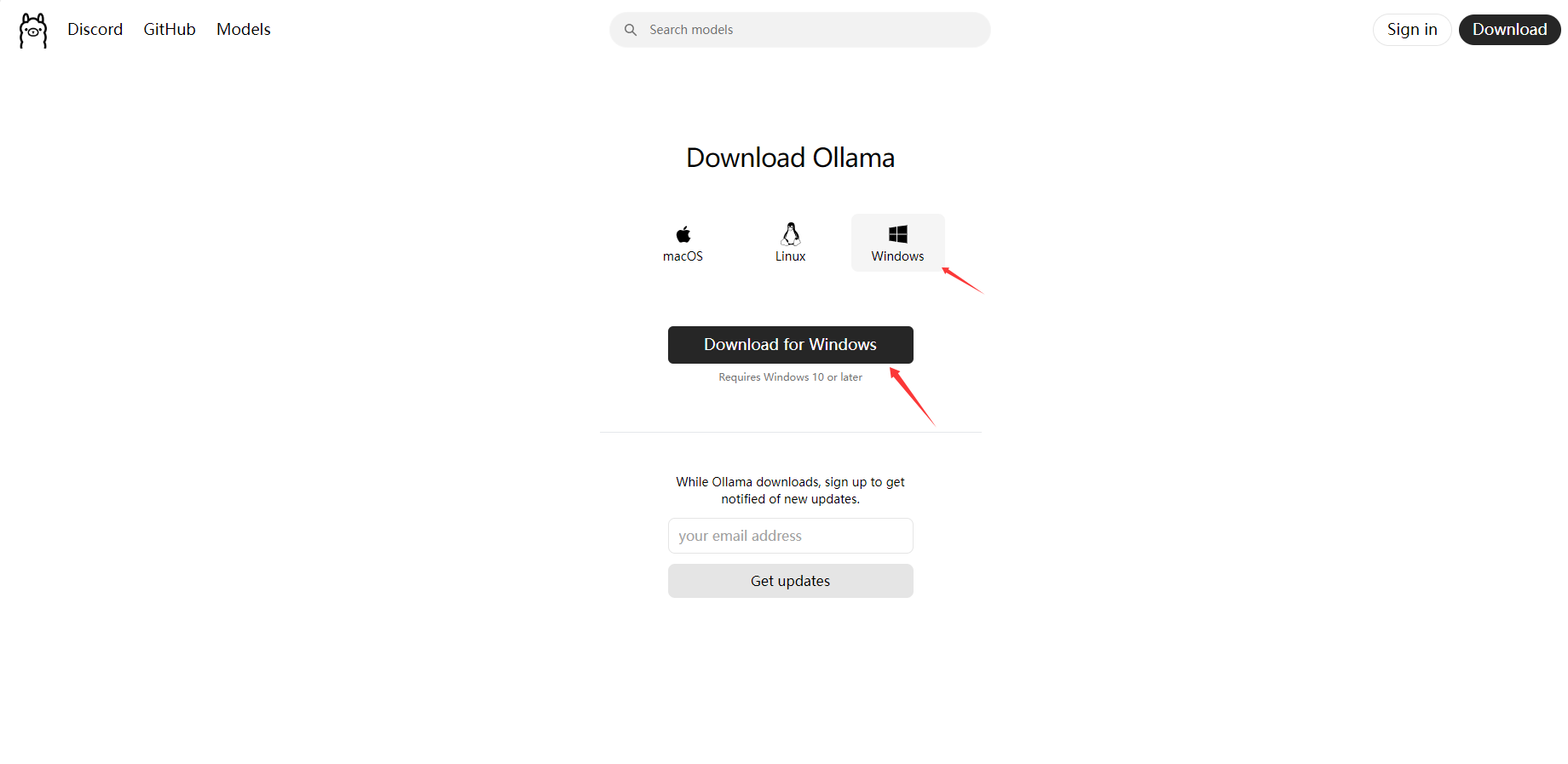

Ollama软件下载

Ollama是一个开源的本地化大模型部署工具,旨在简化大型语言模型(LLM)的安装、运行和管理。它支持多种模型架构,并提供与OpenAI兼容的API。你可以从Ollama官网下载适用于你操作系统的安装包。

安装过程相对直接,通常只需双击安装文件并按照提示完成安装。安装完成后,打开命令行工具(如PowerShell或Terminal),输入ollama -v以验证安装成功与否。

下载DeepSeek模型

一旦Ollama安装完毕,你可以通过Ollama的命令行界面来搜索并下载DeepSeek模型。访问Ollama官网的模型库,找到DeepSeek-R1系列中适合你硬件条件的模型版本,并复制相应的安装命令。

例如,如果你想下载8B版本的DeepSeek-R1模型,可以在命令行中执行如下命令:

ollama run deepseek-r1:8b这将开始下载并安装选定的模型到你的本地机器上。

配置客户端进行交互

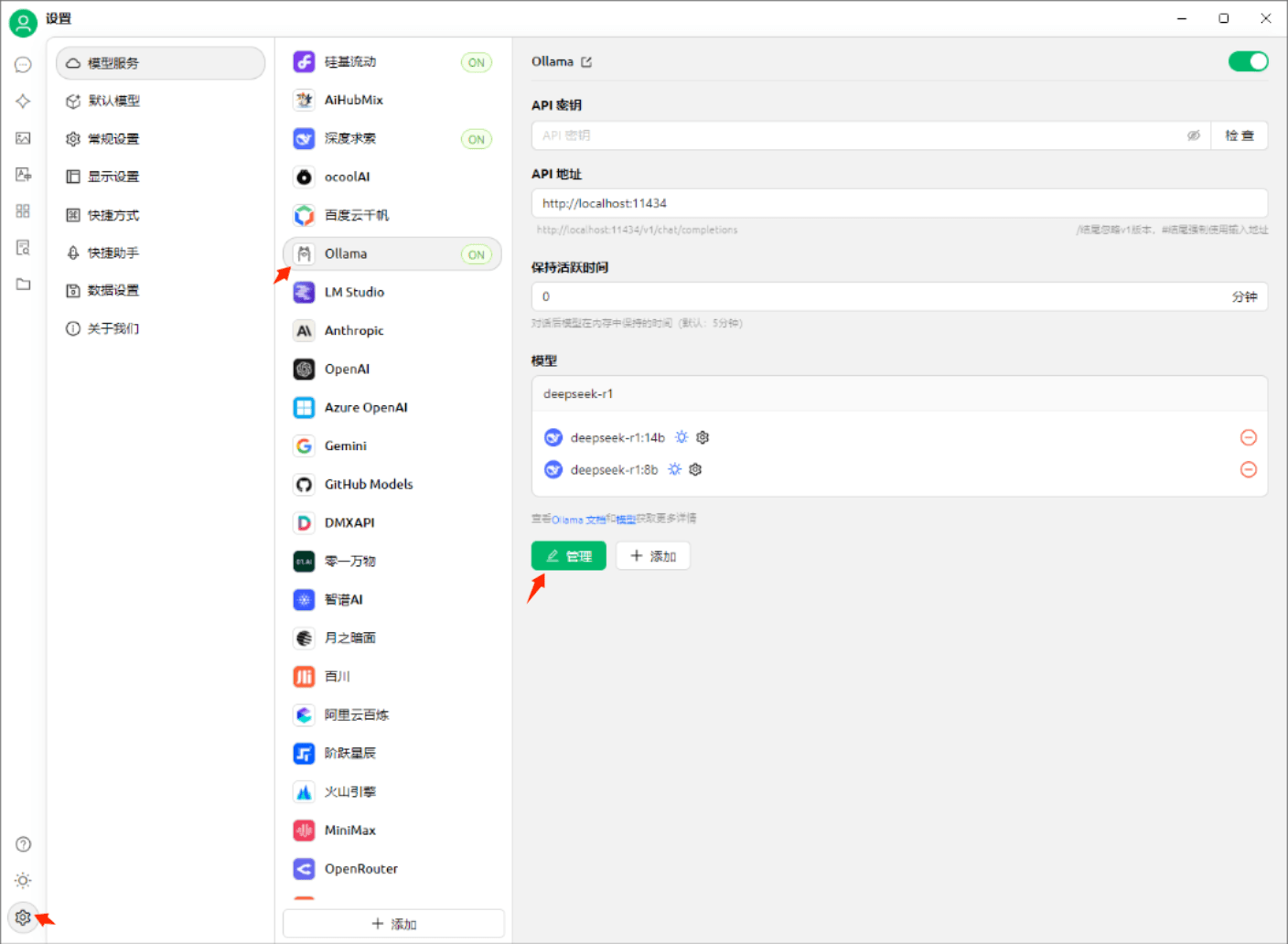

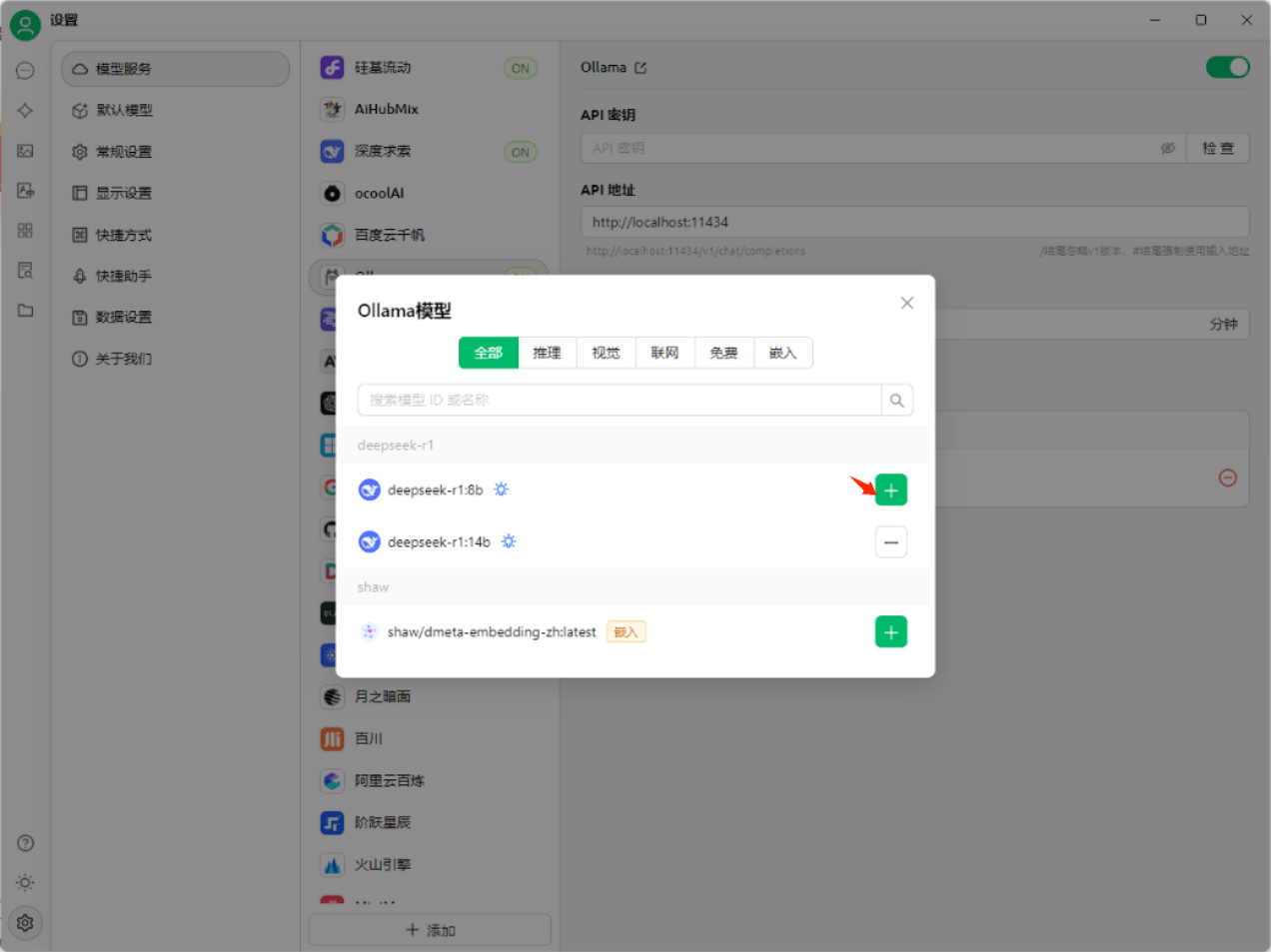

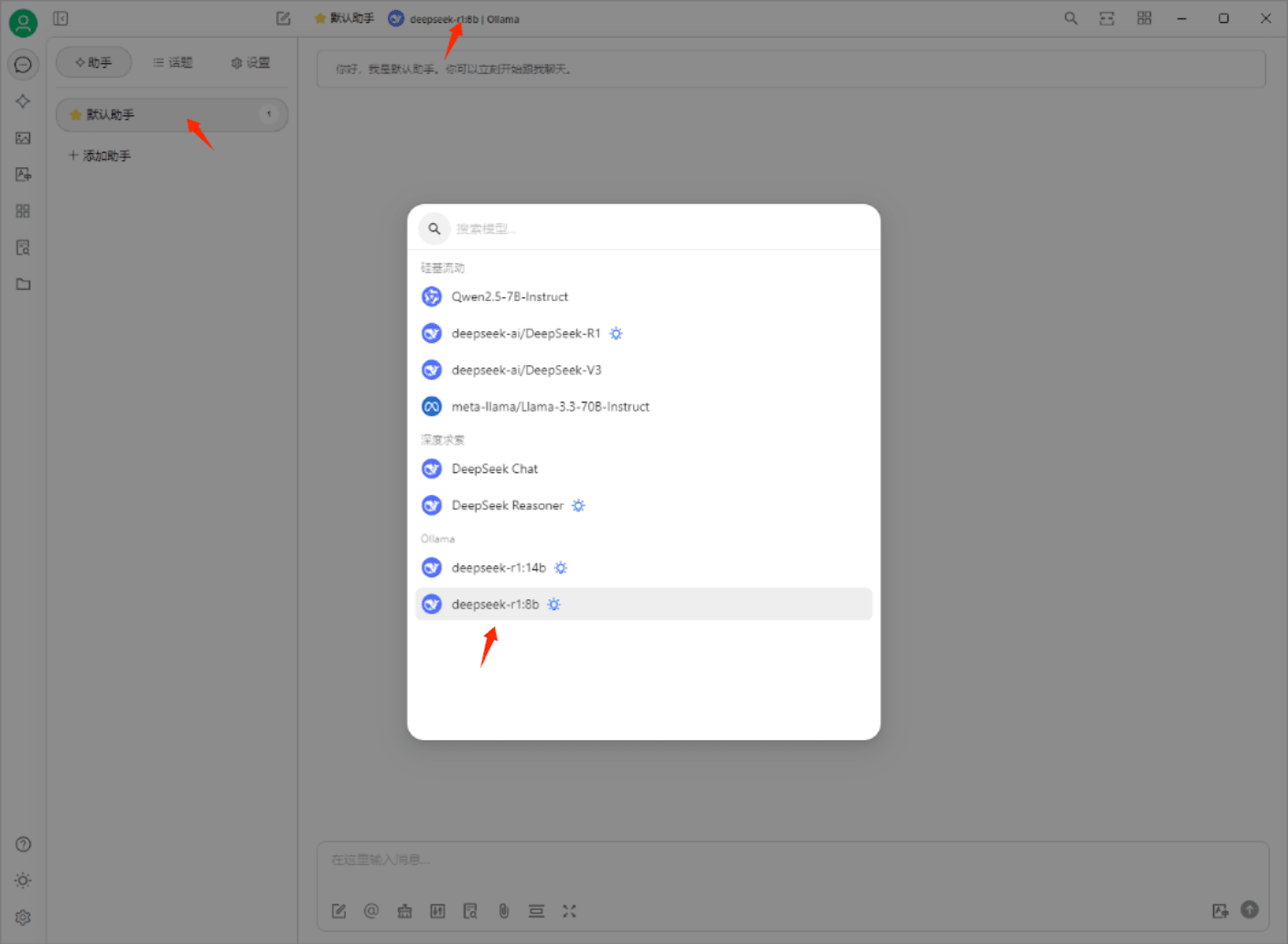

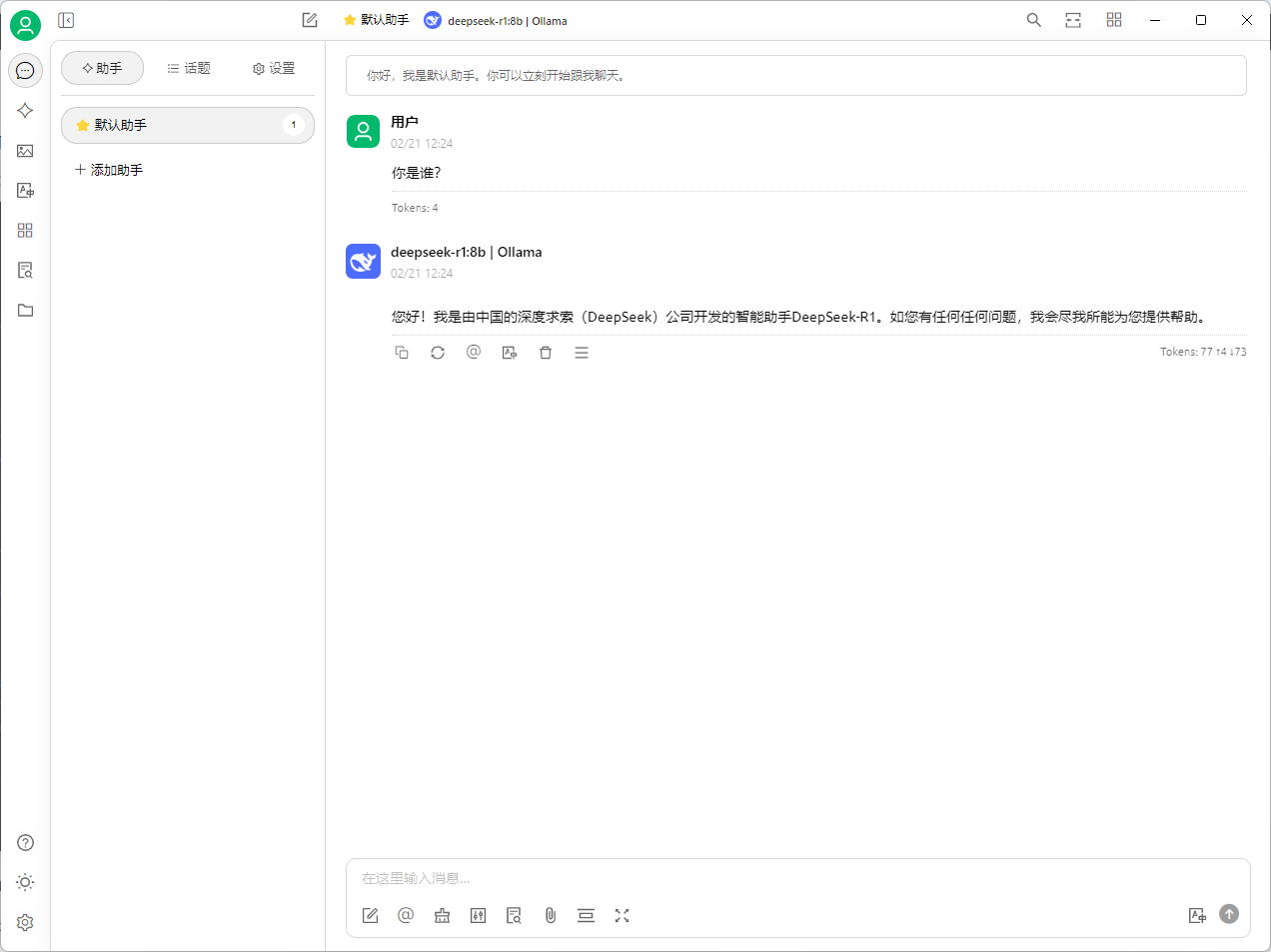

为了方便与模型交互,除了通过命令行外,你还可以设置一个图形用户界面(GUI)。一种方法是使用Cherry Studio,这是一个开源的多模型桌面客户端,可以直接调用Ollama上的本地模型。另一种选择是使用LM Studio,同样是一个通用的模型调用工具,提供了简化的界面来加载和使用模型。

这里推荐使用:Cherry Studio

Cherry Studio软件下载

对于想要通过Web界面进行交互的用户,可以考虑安装Open WebUI,这是一个自托管的人工智能平台,可以通过Docker轻松部署,并提供了一个基于浏览器的界面来与模型互动。

运行Cherry Studio软件安装完之后,配置下刚下载的Deepseek R1大模型.

测试与优化

完成上述步骤后,你应该能够在本地启动DeepSeek模型并与之互动了。不过,在实际使用过程中,你可能还需要根据自己的需求调整模型参数,或是探索如何利用量化技术减少模型占用的资源,从而提高性能或适应较低端的硬件。

总结

本地部署DeepSeek大模型涉及几个关键步骤:首先是确保有足够的硬件资源;其次是安装Ollama作为运行模型的基础框架;接着是选择合适的DeepSeek模型版本并下载;最后是配置一个友好的用户界面以便于日常使用。整个过程虽然可能对初学者来说有些复杂,但随着实践次数的增加,会逐渐变得容易掌握。希望这个指南能够帮助你顺利地在个人电脑上部署DeepSeek AI大模型。

原文链接:如何在电脑上本地部署一个Deepseek大模型ai呢? - Java程序员_编程开发学习笔记_网站安全运维教程_渗透技术教程

评论记录:

回复评论: