简介:3D重建是IT领域关键技术,尤其在计算机视觉、机器人导航和虚拟现实中占有重要地位。本压缩包包含关于单目相机3D重建的研究论文,重点涉及特征检测、特征匹配、几何恢复和后处理等关键步骤。论文探讨了单目相机3D重建中的挑战和解决方案,如深度学习方法的应用,旨在为读者提供该领域的最新研究进展和理论支持。

1. 3D重建基本概念和应用场景

1.1 3D重建技术概述

三维重建(3D Reconstruction)是指通过计算机视觉技术,从二维图像或点云数据中恢复出物体或场景的三维模型的过程。这项技术涉及从二维平面图像中提取三维空间信息,是计算机图形学和视觉领域的核心研究方向之一。

1.2 应用场景

三维重建技术广泛应用于多个领域,例如: - 电影与游戏制作 :三维模型为特效和动画提供精确的几何基础。 - 虚拟现实(VR)与增强现实(AR) :创建沉浸式的虚拟环境和交互体验。 - 文化遗产保护 :对文物和历史遗址进行数字化,用于研究和展示。 - 工业设计与制造 :辅助产品设计和质量检测。 - 自动驾驶 :通过重建周围环境来辅助导航和避免障碍物。

1.3 技术与实现途径

实现三维重建的途径多种多样,包括基于图像的方法和基于激光扫描的方法。前者利用拍摄的图像序列,通过特征匹配、深度学习等技术手段进行三维建模;后者使用激光扫描仪直接获取三维空间中的点数据,进而生成三维模型。

随着技术的发展,三维重建正变得更加高效和精确,为各个领域带来了革命性的变化。

2. 特征检测方法及其原理

2.1 特征检测的基本概念

2.1.1 特征检测的定义与重要性

特征检测是计算机视觉中的一个基本过程,它涉及识别并提取图像中的显著信息点,这些点在图像中具有唯一性,可以用来描述物体或场景的几何特征。特征点的定义依赖于它周围的图像区域,并且必须对光照变化、视点变化以及遮挡等有一定的鲁棒性。这些特征点通常被称作关键点,而围绕关键点计算得到的描述符则用来表达特征点周围的局部图像信息。

特征检测的重要性在于它能够帮助计算机理解图像内容,从而实现图像识别、物体检测、场景重建等多种任务。在3D重建中,特征检测使得从不同视角拍摄的图像之间的对应关系能够被确定下来,为后续的几何恢复和深度估计提供基础数据。

2.1.2 特征检测的发展历程

特征检测技术的发展经历了从传统的手动设计到自动学习的过程。早期的特征检测方法,如SIFT、SURF和ORB等,都是基于手工设计的算子和规则来实现特征点的提取和描述。近年来,随着深度学习技术的崛起,基于卷积神经网络(CNN)的方法开始主导特征检测领域,这类方法通常被称为深度特征检测器。

深度学习方法通过训练数据自动学习到如何提取有效的特征,这使得这些特征不仅对变化更加鲁棒,而且在特征描述上更具有判别力。然而,这并不意味着传统方法失去了它们的价值,因为它们在计算效率和实用性方面仍然具有优势。

2.2 常用特征检测算法介绍

2.2.1 SIFT算法的原理与应用

尺度不变特征变换(Scale-Invariant Feature Transform, SIFT)是一种著名的特征检测算法。它通过在不同尺度空间检测图像中的极值点,并在局部区域生成特征描述符,实现了尺度和旋转不变性。

SIFT描述符的生成基于图像梯度的方向信息,能够提供稳定的特征匹配。然而,由于SIFT包含专利问题,所以在商业应用中需要特别注意。

- import cv2

- # 读取图片

- img = cv2.imread('example.jpg', 0)

- # 初始化SIFT检测器

- sift = cv2.SIFT_create()

- # 检测关键点与描述符

- keypoints, descriptors = sift.detectAndCompute(img, None)

上述代码使用了OpenCV库来调用SIFT算法。首先读取一张灰度图片,然后初始化SIFT检测器,最后检测图片的关键点和描述符。 detectAndCompute 方法中的参数 None 代表使用默认的参数。

2.2.2 SURF算法的特点与限制

加速鲁棒特征(Speeded-Up Robust Features, SURF)算法,如其名,是在SIFT算法基础上对速度进行优化的算法。它通过使用箱型滤波器(box filter)和积分图像,加快了特征点的检测速度和特征描述符的计算速度。

SURF算法的主要优点是其高效性和对旋转与尺度变化的不变性。然而,由于其依赖于专利技术,这一点限制了其在商业应用中的使用。此外,SURF对遮挡和噪声也较为敏感。

2.2.3 ORB算法的优势和使用场景

Oriented FAST and Rotated BRIEF(ORB)算法结合了FAST关键点检测器和BRIEF描述符的优点,不仅提供了一种快速的特征检测方法,而且不需要专利许可。ORB通过改进FAST关键点的检测机制,增加了关键点的方向性,并通过旋转BRIEF描述符来提高匹配的稳健性。

ORB因其免费和效率,特别适合需要快速匹配的场景,比如实时增强现实应用。不过,由于其描述符不如SIFT和SURF具有那么多信息,所以在某些需要高度精确匹配的应用中,ORB可能不是最佳选择。

2.3 特征检测算法的比较与优化

2.3.1 各算法性能对比分析

在性能对比分析中,通常会考察算法的运行速度、特征点数量、描述符长度、匹配精度和鲁棒性等关键指标。例如,SIFT在匹配精度方面通常表现很好,但运行速度较慢;相比之下,ORB速度很快,但匹配精度稍逊一筹。

- flowchart LR

- A[SIFT] -->|运行速度慢| B[高精度匹配]

- C[ORB] -->|运行速度快| D[匹配精度适中]

- E[SURF] -->|运行速度中等| F[鲁棒性强]

根据实际应用场景的需要,可以选择最适合的特征检测算法。对于实时性要求较高的应用,ORB可能是更好的选择;而对于精度要求极高的应用,可能需要考虑使用SIFT。

2.3.2 算法选择的依据与优化策略

算法的选择应当基于特定任务的需求和约束条件。例如,如果应用主要是在移动设备上进行,可能更倾向于选择计算效率高的算法,如ORB或BRISK。如果任务需要极高的准确性和稳定性,可能会选择SIFT或SURF。

优化策略可能包括算法的改进、使用多尺度检测、采用并行计算、预处理步骤(如图像去噪)以及针对特定应用场景的定制算法。另外,深度学习方法的引入也被证明能够有效提升特征检测的性能,尽管它们在计算资源上的要求更高。

- import torch

- # 加载预训练的深度特征检测器模型

- model = torch.hub.load('harveenchadha95/Deep-Feature-Detector', 'DeepFeatureDetector')

- # 对输入图像进行特征检测

- features = model(img)

上述代码展示了如何使用深度学习库中的预训练模型进行特征检测。这里使用了Deep Feature Detector模型进行特征提取,该模型已经在大量图像上训练,具有很好的泛化能力。

3. 特征匹配技术的原理与实现

在3D重建的过程中,特征匹配是一个核心步骤,它涉及将不同图像中的特征点对应起来,为后续的几何恢复提供基础。本章将深入探讨特征匹配的理论基础、方法和挑战。

3.1 特征匹配的理论基础

3.1.1 特征匹配的定义和目的

特征匹配是指在多个二维图像中识别出对应的特征点,并建立它们之间的一一映射关系。这些特征点代表了图像中的显著结构或纹理信息,如角点、边缘、斑点等。匹配的目的在于利用这些特征点的一致性,重构出三维空间中物体的几何结构。

3.1.2 匹配算法的基本框架

一个典型的特征匹配算法框架包括以下步骤: 1. 特征检测:在图像中识别出一系列的特征点。 2. 特征描述:为每个特征点生成一个描述符,用于表达特征点的局部信息。 3. 特征匹配:比较不同图像间的特征描述符,找出最佳匹配点对。 4. 匹配优化:通过一些几何约束和一致性检查来提高匹配的准确率。 5. 三维重建:使用匹配点对恢复物体的三维结构。

3.2 特征匹配方法的详细解读

3.2.1 基于描述符的匹配技术

基于描述符的匹配技术中最著名的是SIFT(尺度不变特征变换)算法。SIFT描述符具有良好的不变性和区分性,可以有效地在不同的图像之间进行匹配。以下是SIFT算法的关键步骤:

- 尺度空间的极值检测:通过高斯差分构建图像的尺度空间,并在各个尺度空间中寻找极值点,这些点即为潜在的特征点。

- 关键点定位:通过拟合三维二次函数去除边缘响应低的点,并确定特征点的精确位置。

- 方向分配:为特征点分配一个或多个方向参数,以实现旋转不变性。

- 特征描述符构造:使用特征点周围的图像梯度信息构造一个128维的描述符向量。

- import cv2

-

- # 读取图像

- image1 = cv2.imread('image1.jpg', 0)

- image2 = cv2.imread('image2.jpg', 0)

-

- # 初始化SIFT检测器

- sift = cv2.SIFT_create()

-

- # 检测并计算描述符

- keypoints1, descriptors1 = sift.detectAndCompute(image1, None)

- keypoints2, descriptors2 = sift.detectAndCompute(image2, None)

-

- # 匹配描述符

- matcher = cv2.BFMatcher(cv2.NORM_L2)

- matches = matcher.knnMatch(descriptors1, descriptors2, k=2)

-

- # 筛选出好的匹配点

- good_matches = []

- for m, n in matches:

- if m.distance < 0.75 * n.distance:

- good_matches.append(m)

-

- # 绘制匹配点

- result_image = cv2.drawMatches(image1, keypoints1, image2, keypoints2, good_matches, None, flags=2)

-

- cv2.imshow('SIFT Matches', result_image)

- cv2.waitKey(0)

3.2.2 利用机器学习的特征匹配

随着机器学习技术的发展,利用深度学习进行特征匹配逐渐成为研究热点。深度学习可以自动学习特征表示,且能够捕获图像中的语义信息。卷积神经网络(CNN)在特征提取方面表现尤为突出。

通过预训练网络提取的特征进行匹配,可以采用不同的度量方式,例如余弦相似度、欧氏距离等。深度学习的匹配方法通常包含以下步骤:

- 利用CNN提取图像特征。

- 对提取的特征进行降维处理。

- 利用分类器或度量学习方法识别匹配点。

- from keras.models import Model

- from keras.layers import Input, Conv2D, MaxPooling2D, Flatten, Dense

- from keras.datasets import mnist

-

- # 构建简单的CNN模型用于特征提取

- input_img = Input(shape=(28, 28, 1))

- x = Conv2D(32, (3, 3), activation='relu')(input_img)

- x = MaxPooling2D((2, 2))(x)

- x = Conv2D(32, (3, 3), activation='relu')(x)

- encoded = MaxPooling2D((2, 2))(x)

-

- # 编译模型

- encoder = Model(input_img, encoded)

- ***pile(optimizer='adam', loss='mse')

-

- # 加载数据并训练模型

- # ...(此处省略数据加载和模型训练过程)

-

- # 特征匹配示例代码

- # ...(此处省略特征提取和匹配过程)

-

- # 使用CNN模型的特征进行匹配

- # ...(此处省略匹配逻辑)

3.3 特征匹配的挑战与解决方案

3.3.1 匹配精度与鲁棒性分析

匹配精度与鲁棒性是衡量匹配算法性能的重要指标。精度指的是匹配点对中正确匹配的比例,鲁棒性指的是算法在面对光照变化、遮挡、噪声等环境因素时的性能表现。

提高匹配精度的策略包括: - 改进特征描述符以增强区分性。 - 采用先进的匹配算法,例如基于机器学习的方法。 - 设计有效的匹配后验证步骤,如RANSAC算法用于剔除错误匹配。

3.3.2 匹配算法的优化与应用实例

优化匹配算法通常需要考虑以下方面: - 采用高效的匹配算法以减少计算时间。 - 使用并行计算和优化过的数据结构以提升性能。 - 结合特定应用场景进行算法定制,例如在工业视觉检测中可以使用定制特征。

应用实例: 假设我们要对两个工业零件的图像进行匹配,使用SIFT算法提取特征并使用FLANN匹配器进行匹配优化,可以实现快速准确的零件定位。

- import cv2

-

- # 读取图像并转换为灰度

- image1 = cv2.imread('part1.jpg', 0)

- image2 = cv2.imread('part2.jpg', 0)

-

- # 初始化SIFT检测器和FLANN匹配器

- sift = cv2.SIFT_create()

- index_params = dict(algorithm=6, table_number=6, key_size=12, multi_probe_level=1)

- search_params = {}

- flann = cv2.FlannBasedMatcher(index_params, search_params)

-

- # 检测并计算描述符

- keypoints1, descriptors1 = sift.detectAndCompute(image1, None)

- keypoints2, descriptors2 = sift.detectAndCompute(image2, None)

-

- # 使用FLANN进行匹配

- matches = flann.knnMatch(descriptors1, descriptors2, k=2)

-

- # 筛选好的匹配点

- good_matches = []

- for m, n in matches:

- if m.distance < 0.75 * n.distance:

- good_matches.append(m)

-

- # 绘制匹配结果

- result_image = cv2.drawMatches(image1, keypoints1, image2, keypoints2, good_matches, None, flags=2)

-

- cv2.imshow('FLANN Matches', result_image)

- cv2.waitKey(0)

通过这种方式,我们可以看到特征匹配技术的原理和实现过程,并了解如何使用这些技术解决实际问题。特征匹配不仅为3D重建提供基础数据,还在机器视觉、图像识别和机器人导航等领域有着广泛的应用。

4. 几何恢复方法及其实现步骤

4.1 几何恢复的基本原理

4.1.1 几何恢复的概念和数学模型

几何恢复是3D重建中的核心步骤,它旨在从图像中提取出物体的三维几何信息。通过分析成像过程中几何特性的变化,可以利用几何模型来重建物体的三维形状。在计算机视觉中,几何恢复通常依赖于一系列的几何约束和数学模型,例如相机模型和透视投影。

几何恢复的核心是利用成像过程中的几何约束,来建立图像特征与三维空间点的对应关系。这个过程涉及到一系列数学运算,如矩阵变换和方程求解。核心任务之一是确定相机的姿态,即相机在三维空间中的位置和方向,以及成像平面上的内参矩阵,这个矩阵包含焦距、光心和镜头畸变参数。

具体来说,相机模型通常可以表示为:

[ X_c = K[R|t]X_w ]

其中,( X_c ) 表示相机坐标系下的三维点,( X_w ) 是世界坐标系下的三维点,( K ) 是相机内参矩阵,( R ) 和 ( t ) 分别是旋转和平移矩阵,它们共同定义了相机的姿态。

此外,为了从两幅图像中恢复出场景的三维结构,常使用单应性矩阵。单应性矩阵是一个描述两个平面间射影关系的 ( 3 \times 3 ) 矩阵,它表示了图像间点的对应关系。

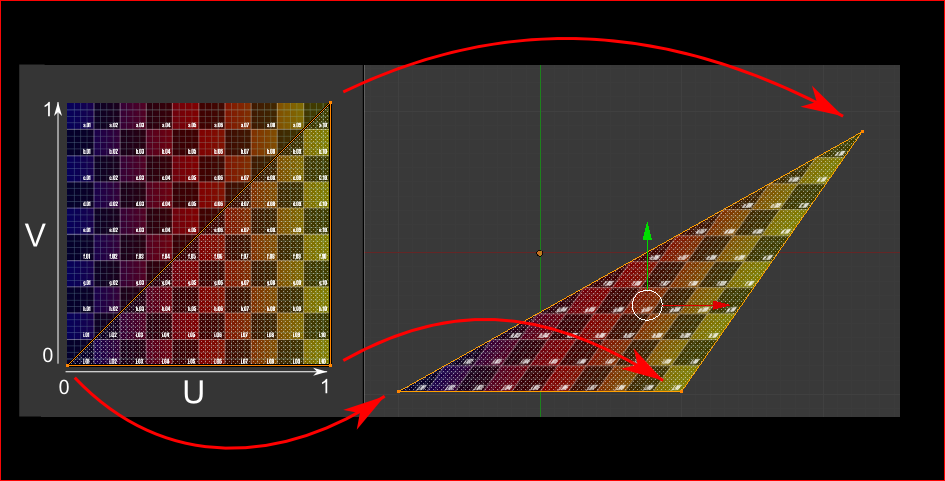

4.1.2 单应性矩阵的构建与应用

单应性矩阵 ( H ) 在几何恢复中扮演着重要角色。它连接了不同视角下同一物体的图像点,即使在物体形状或相机位置发生变化时,也能保持其不变性。通过分析这些不变的几何属性,单应性矩阵成为了解决3D重建中相机定位和场景重建问题的关键。

构建单应性矩阵通常涉及以下步骤:

- 特征检测与匹配:在两幅或多幅图像中提取关键点,并找到它们之间的对应关系。

- 单应性矩阵的求解:使用对应点集通过最小二乘法估计出单应性矩阵 ( H )。

- 单应性矩阵的验证和优化:通过计算重投影误差等方法,对矩阵进行验证和细化。

利用单应性矩阵,我们可以恢复出两幅图像中对应点的三维射影结构,进而为三维重建提供必要的几何约束。这在处理运动视频中的静态场景或静态相机下的动态物体时尤为有用。

4.2 几何恢复的关键技术

4.2.1 本质矩阵的提取与分析

本质矩阵是另一种描述两幅图像间几何关系的矩阵,它是归一化的单应性矩阵,在相机内参标准化的情况下,可以更简洁地表达两视图间的相对姿态。本质矩阵 ( E ) 通常通过以下方式获得:

[ E = K^T H K ]

其中,( E ) 是 ( 3 \times 3 ) 矩阵,( K ) 是相机内参矩阵。本质矩阵包含了相机运动的旋转信息,但由于它考虑了内参,因此可以用于更广泛的场景。

在单目和双目相机系统中,本质矩阵可以用来估计相机的运动,如平移和旋转。重要的是,它允许从图像到图像的几何约束,而不需要场景的精确三维模型。

4.2.2 法方程在几何恢复中的作用

法方程是解决最小二乘问题的数学方法之一,在几何恢复中它用来估计本质矩阵或单应性矩阵。法方程是通过最小化误差的平方和来得到最优解的,这种方法可以高效地处理线性化后的几何约束。

法方程的一般形式可以表示为:

[ A^T A x = A^T b ]

在这里,( A ) 是雅可比矩阵(Jacobian),( x ) 是我们要估计的参数向量(例如,旋转矩阵或平移向量),( b ) 是误差向量。法方程通过解这个方程组来求出使误差最小的参数向量 ( x )。

使用法方程求解几何恢复问题,可以得到一个数值稳定的解,尤其适用于处理大量的图像数据,如视频序列中的每一帧图像。

4.3 几何恢复的应用与实践

4.3.1 几何恢复技术的实际应用案例

几何恢复技术在多个领域都有实际应用。例如,在建筑行业,可以利用几何恢复技术从建筑物的多张照片中恢复出详细的三维模型。在自动驾驶领域,几何恢复技术被用来估计周围环境的结构,以提升车辆的定位精度。

另一个典型的应用是文化遗产保护。通过使用几何恢复技术,研究人员可以从历史照片或图像档案中重建出古代建筑的精确三维模型,有助于保护和传承人类的历史遗产。

4.3.2 应用中的问题诊断与处理

尽管几何恢复技术具有广泛的应用前景,但在实际应用中仍然面临着诸多挑战。例如,图像的噪声和光照变化会影响特征检测和匹配的准确性,进而影响到几何恢复的结果。

为了处理这些问题,通常需要采取多种策略。首先,可以采用鲁棒性强的特征检测算法来提高特征点的准确性和重复性。其次,对于图像噪声,可以应用滤波和去噪技术,以提升图像质量。另外,使用多种几何约束和后处理方法可以提高最终三维模型的准确度和鲁棒性。

在诊断和处理这些问题时,需要充分理解几何恢复的原理和限制,并结合具体的应用场景,灵活地选择和调整技术方案。

5. 3D重建的后处理与优化技术

3D重建技术的后处理和优化是将原始数据转换为高质量3D模型的关键步骤。本章将详细探讨三角化的基本概念与方法、点云转换与处理、以及平滑与噪声去除技术,为读者提供深入的了解和实际操作指南。

5.1 三角化的概念与方法

三角化是将特征匹配后的二维图像点转换为三维空间点的过程,是生成3D模型的重要步骤。它涉及到数学、几何学和计算机视觉的原理。

5.1.1 三角化的数学原理和实现步骤

三角化的数学基础在于通过多个图像中的对应点确定一个点在三维空间中的位置。假设我们有两个相机拍摄了同一场景,通过特征匹配我们获得了每对对应点的二维坐标,可以构建一个线性方程组,解得空间点的坐标。

实现三角化通常包含以下步骤:

- 特征匹配:在至少两个视角中找到对应的特征点。

- 相机标定:确定相机的内外参数,如焦距、主点和畸变系数。

- 构建方程组:利用匹配点和相机参数,根据三角测量原理构建方程组。

- 求解方程组:采用最小二乘法或其他数值方法求解空间点的坐标。

5.1.2 三角化在3D重建中的重要性

三角化对3D重建至关重要,因为它直接影响到模型的准确性和质量。准确的三角化可以有效地恢复场景的几何结构,而误差较大的三角化可能导致重建的3D模型出现变形或失真。

5.2 点云转换与处理

点云是3D重建过程中产生的海量数据点集合,它们是三维空间中的点,包含了场景的几何信息。

5.2.1 点云数据的特点与格式转换

点云数据具有以下特点:

- 离散性:点云数据由独立的点组成,不具有拓扑结构。

- 大量性:一个3D场景可能产生数百万到数十亿个点。

- 多样性:点云可以来源于不同的传感器,如激光雷达、结构光扫描仪、以及立体相机系统等。

点云格式转换是将原始点云数据转换为一种标准格式,以便于处理和分析的过程。常见的点云格式包括PLY、OBJ、STL等,这些格式定义了点云数据的存储结构,包括点的位置、颜色、法向量等信息。

5.2.2 点云处理的常用算法与技术

点云处理涉及多种技术,包括:

- 去噪:去除点云数据中的噪声和异常值,提高数据质量。

- 粗化:简化点云数据,减少计算量,同时保持主要结构。

- 拓扑关系分析:识别点云中的面、边界、角点等拓扑元素。

- 特征提取:从点云中提取用于分类、识别或重建的特征,如平面、圆柱等。

5.3 平滑与噪声去除技术

在3D模型构建后,模型表面往往存在不规则的尖锐突起和凹陷,这时平滑和噪声去除技术就显得尤为重要。

5.3.1 平滑算法的选择与应用

平滑算法用于减少3D模型表面的噪声,使模型看起来更加平滑、自然。常见的平滑算法包括:

- Laplacian平滑:通过优化顶点位置以最小化拉普拉斯能量来实现。

- Taubin平滑:改进的Laplacian平滑,通过在收缩和膨胀过程中平衡以消除平滑误差。

- 法向量平滑:基于顶点法向量的优化来平滑表面。

选择合适的平滑算法依赖于模型的特性以及所需的效果。

5.3.2 噪声去除的方法与效果评估

噪声去除的目的是去除由传感器误差或重建过程中的异常值造成的噪声。常用的方法有:

- 局部平滑:在局部区域使用低通滤波器来减少噪声。

- 基于优化的方法:如RANSAC算法,可以有效地从数据中剔除异常点。

- 自适应滤波:根据局部区域的特征动态调整滤波器参数。

对于噪声去除效果的评估,可以采用定量的指标,如均方根误差(RMSE)和峰值信噪比(PSNR),或者通过视觉对比的方式来评价。

以上就是对3D重建后处理与优化技术的探讨,通过本章内容的介绍,读者应能掌握三角化、点云处理和噪声去除等关键技术的操作方法,并理解它们在3D重建中发挥的重要作用。下一章将继续探讨单目相机3D重建的挑战与深度学习的应用。

简介:3D重建是IT领域关键技术,尤其在计算机视觉、机器人导航和虚拟现实中占有重要地位。本压缩包包含关于单目相机3D重建的研究论文,重点涉及特征检测、特征匹配、几何恢复和后处理等关键步骤。论文探讨了单目相机3D重建中的挑战和解决方案,如深度学习方法的应用,旨在为读者提供该领域的最新研究进展和理论支持。

评论记录:

回复评论: