目录

二、利用 ollama 和 docker 配置 deepseek-r1 的准备工作

(一)使用 ollama 获取 deepseek-r1 模型

(二)利用 docker 创建 deepseek-r1 容器

在人工智能技术日新月异的时代,大语言模型的应用越来越广泛,DeepSeek 作为其中的佼佼者,备受开发者和技术爱好者的关注。通过在本机部署 DeepSeek,能够更灵活地利用其强大功能。而借助 ollama 和 docker 进行 deepseek - r1 的配置,能为我们带来更高效、便捷的部署体验。

一、ollama 与 docker 简介

(一)ollama(Ollama)

ollama 是一个强大的工具,它为模型的管理和运行提供了便利。它可以简化模型的下载、配置和启动过程,让用户能够快速地将不同的模型集成到自己的工作流程中。例如,在处理多个不同类型的大语言模型时,ollama 可以轻松管理这些模型之间的切换和调用,提高开发效率。

(二)docker

docker 则是容器化技术的代表,它能够将应用程序及其依赖项打包成一个独立的容器。在 DeepSeek 部署中,使用 docker 可以确保 deepseek - r1 在不同环境中具有一致的运行状态。无论在开发环境、测试环境还是生产环境,只要安装了 docker,就可以运行相同的 deepseek - r1 容器,避免了因环境差异导致的兼容性问题。

二、利用 ollama 和 docker 配置 deepseek-r1 的准备工作

(一)硬件需求

同常规的 DeepSeek 部署类似,需要一台性能不错的计算机。内存建议 16GB 以上,这样在运行容器和模型时,能够保证系统的流畅性。同时,配备 NVIDIA GPU 会显著提升模型的推理速度,对于处理大规模文本任务非常关键。

(二)软件安装

- 安装 docker:可以从 docker 官方网站获取适合你操作系统的安装包,按照官方指引进行安装。在安装完成后,确保 docker 服务正常运行,可通过简单的命令行测试来验证(sheel中输入docker)。

- 安装 ollama:根据你使用的操作系统,选择合适的安装方式。例如,在 Linux 系统中,可以通过特定的脚本进行安装。安装完成后,配置好 ollama 的运行环境变量,确保其能够被系统正确识别。

三、配置 deepseek-r1 的详细步骤

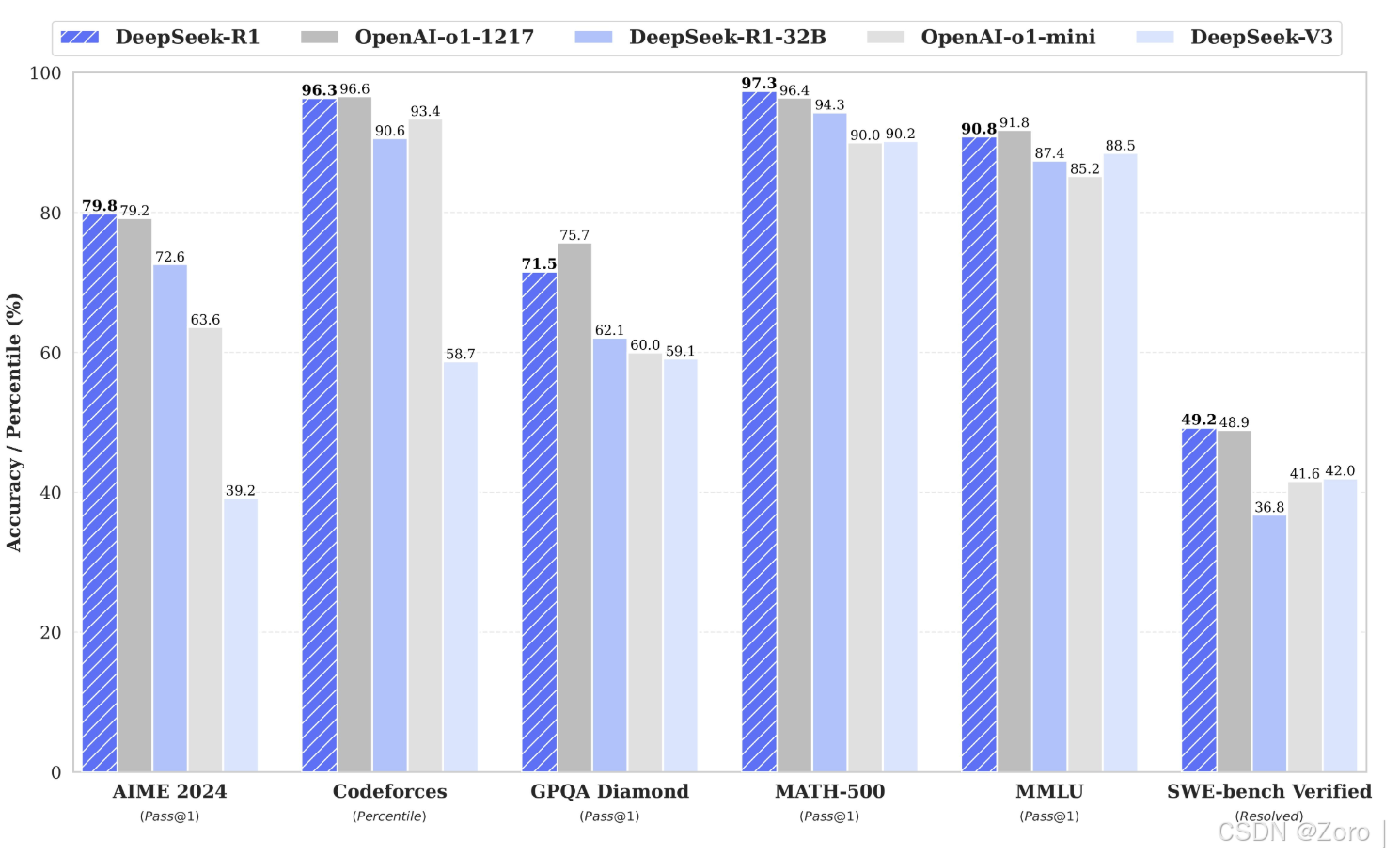

可以看出DeepSeek-r1完全模型在各方面优于OpenAI,在某些方面评估甚至强于OpenAI,参数量适合于本地部署办公使用。

(一)使用 ollama 获取 deepseek-r1 模型

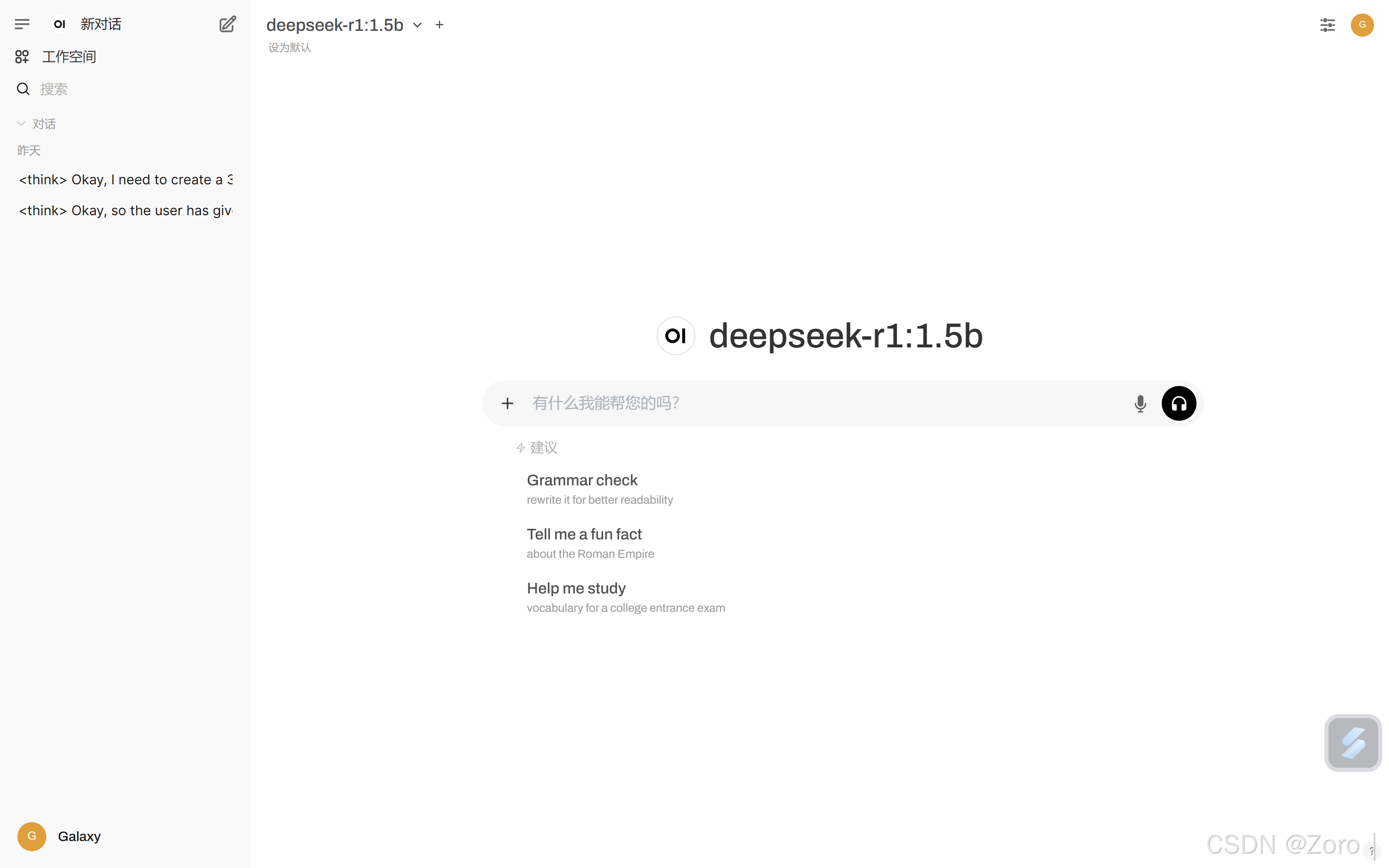

通过 ollama 的命令行工具,输入特定的命令来搜索和下载 deepseek - r1 模型。ollama 会自动从官方或指定的源获取模型文件,并将其存储在本地的模型库中。

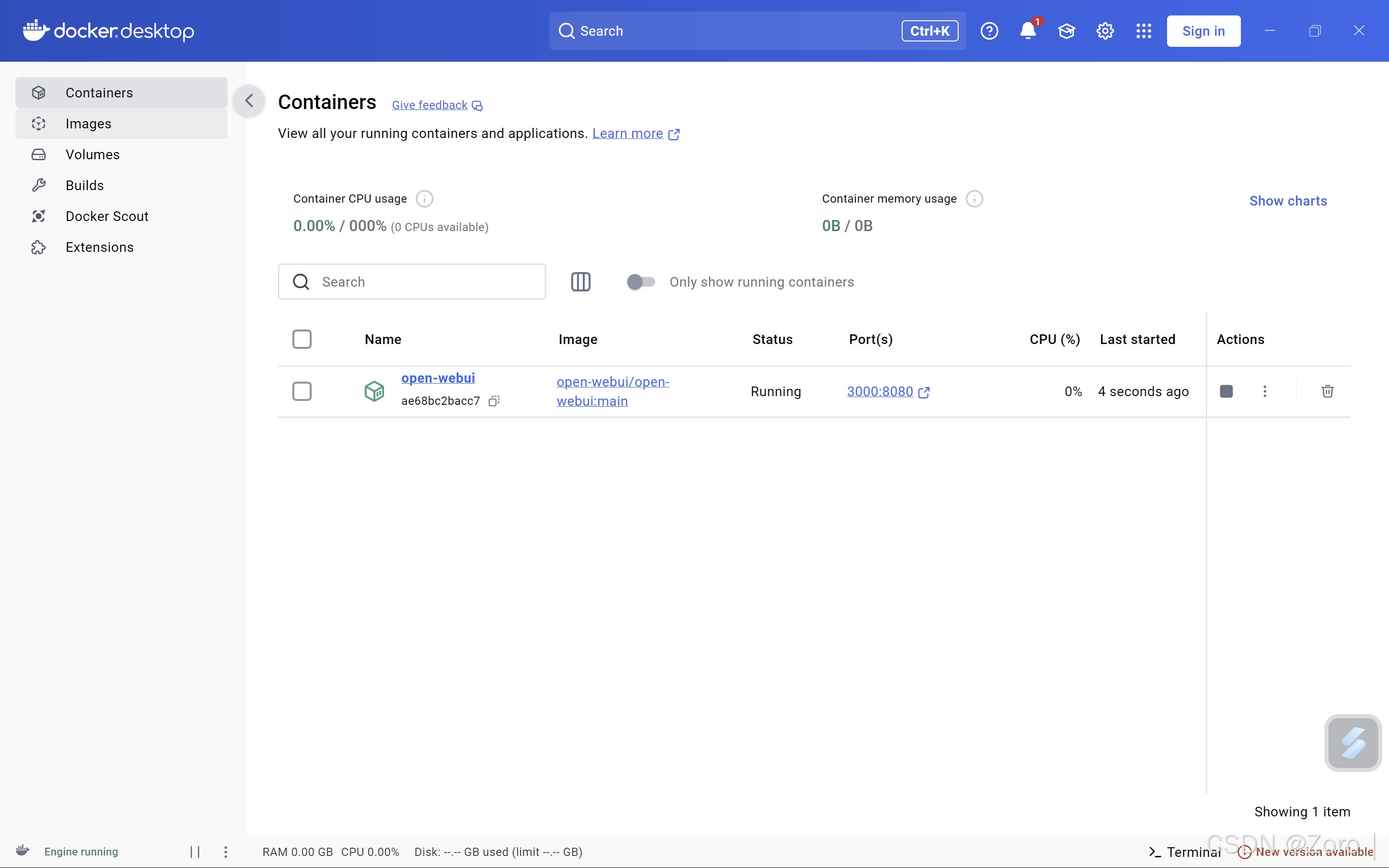

(二)利用 docker 创建 deepseek-r1 容器

- 基于下载好的 deepseek - r1 模型,使用 docker 命令创建一个新的容器。在创建容器时,需要指定容器的名称、挂载的目录(以便与本地文件系统进行交互)以及容器运行所需的环境变量。

查看模型列表

可以访问 ollama 官方的模型仓库library查看支持的模型列表,点击浏览某个模型,可看到详细说明,如模型参数、大小、运行命令等信息。

下载模型命令

使用ollama pull命令进行下载。例如,若要下载图片中的deepseek - r1 7b 模型,在命令行中输入

ollama pull deepseek-r1:7b class="hljs-button signin active" data-title="登录复制" data-report-click="{"spm":"1001.2101.3001.4334"}" onclick="hljs.signin(event)">

评论记录:

回复评论: