1.死锁介绍

死锁是并发计算中一个最隐秘的挑战,多个线程或进程因循环的资源依赖关系而永久停滞,无法继续前进。想象一下一个复杂的交通交叉口,其中四辆汽车同时到达,每个都在等待其他车移动,造成完美的停滞——这正是计算死锁的概念。

在并发系统的领域中,死锁是一种关键的模式,它会导致整个计算机系统完全停止。不同于可能导致暂时性能下降的其他同步挑战,死锁代表了系统完全瘫痪的状态,线程无限暂停,系统资源被消耗而没有任何进展。

死锁的复杂性源于其作为涌现现象的性质。它们不是由单一失效点造成的,而是由多个线程、资源分配策略和同步机制的复杂相互作用引起的。死锁需要对并行计算环境中的计算资源请求、分配和管理有一个整体认识。

2.死锁的基本特征

死锁的特征有四个基本条件,这些条件必须同时存在才能发生死锁。这些条件最初由计算机科学的先驱提出,为理解并预防这些复杂的同步失败情况提供了一个框架。

第一个条件涉及互斥,即多个线程不能同时共享资源。这意味着当资源分配给一个线程时,其他线程必须显式释放才能使其可用。虽然互斥对于数据完整性至关重要,但它也创造了资源竞争的潜在可能性。

第二个关键条件是持有和等待场景。在这种情况下,一个线程同时持有资源并请求额外的资源。如果这些额外的资源已被其他线程占用,请求线程将进入等待状态,同时保留其初始资源。这导致了一个潜在的循环依赖,可能会导致系统锁定。

第三个死锁条件是不可抢占。在不可抢占的系统环境中,资源不能被强制从当前持有资源的线程中释放。一旦分配到资源,资源将保留在持有该线程的线程中,直到该线程自愿释放。这种特征阻止了外部对资源分配的干预,可能会导致死锁情况无限期地持续。

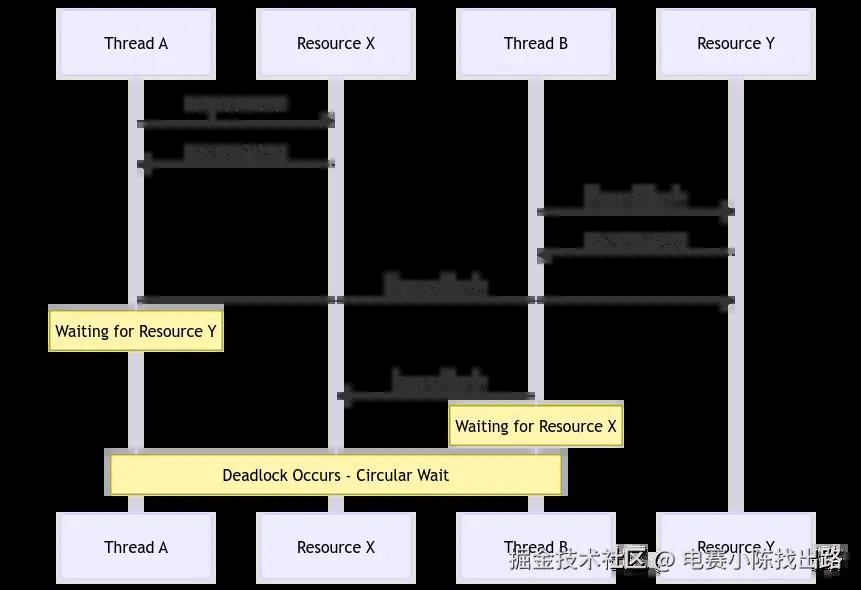

第四个条件涉及循环等待,即一组线程在环形链中的资源上等待对方持有的资源。例如,线程A持有资源X并希望资源Y,线程B持有资源Y并希望资源Z,线程C持有资源Z但希望资源X。这种循环依赖会创建一种完美的死锁场景,没有有任何解决方案。

3.导致死锁的条件

资源分配策略在创建易于死锁的系统过程中起着至关重要的作用。复杂的软件架构通常涉及多个共享资源,包括内存段、文件句柄、网络连接和同步原语。每一次资源分配决策都增加了潜在的死锁风险。

操作系统设计对死锁易发性有很大影响。内核级资源管理、线程调度算法和进程间通信机制都对死锁发生的可能性有贡献。现代操作系统实施越来越复杂的策略来检测、预防和缓解这些风险。

数据库系统代表了一个经典领域,其中死锁发生的可能性极高。多个事务同时访问共享数据可以很容易地创建每条事务持有其他事务所需资源的场景,导致复杂的循环依赖链。事务隔离级别和的谨慎锁定策略在管理这些风险时变得至关重要。

4.死锁的检测机制

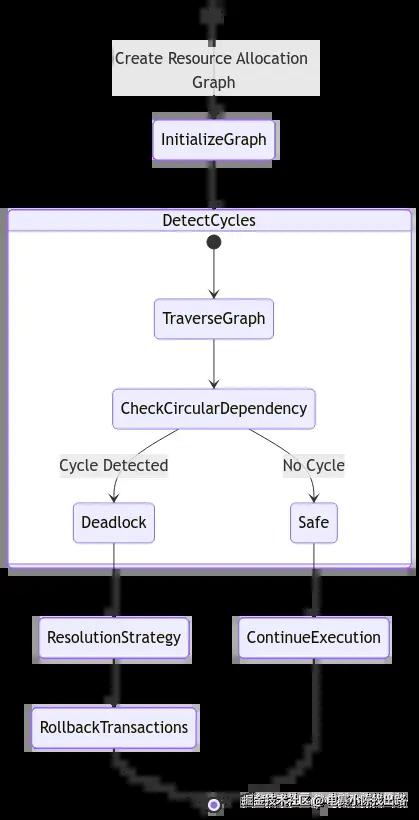

检测死锁需要复杂的算法,可以分析系统资源状况和线程交互的当前状态。资源分配图提供强大的可视化和分析工具,映射出线程和资源之间的连接方式。

在资源分配图中,线程被表示为进程,资源被表示为节点。向导边显示资源的分配和请求关系。当该图包含一个循环时表示潜在的死锁情况。高级检测算法可以实时遍历这些图,识别潜在的死锁情况,并在它们完全显现之前进行纠正。

基于超时的检测方法是一种实际的方法。通过实施具有预设时间限制的智能等待机制,系统可以自动检测和解决潜在的死锁。如果一个线程在指定的时间内未能获取所需的资源,系统就可以采取纠正,如回滚事务或释放已持有的资源。

5.预防措施

预防死锁需要一种多方面的策略,该策略应对是说发生的根本条件和因素。资源排序代表了最有效的预防技术之一。通过制定资源获取的全局一致顺序,系统可以数学上防止循环等待场景。

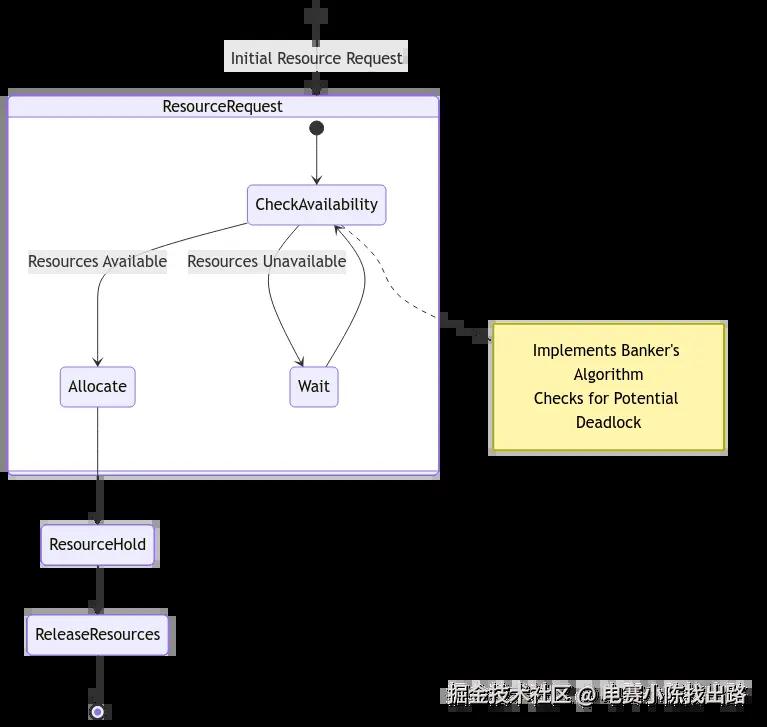

银行家算法作为一种复杂的死锁预防机制脱颖而出。其名称源自其与银行系统的某些类似性,该算法仔细分析了资源分配。在分配资源之前,银行家算法模拟了整个分配过程,以确保系统最终能够回到一个安全状态,所有线程都能完成执行。

资源预留和细致的资源分配规划提供了另一种预防策略。通过实施预测性资源管理技术,系统可以预见潜在的竞争并主动分配资源,以尽量减少死锁风险。这种方法需要对应用工作负载的特点和资源利用模式有深入的理解。

6.实用实现示例

c 代码解读复制代码#include

7.死锁管理的基础理论

关于死锁的理论探索可以追溯到并发系统设计的根本原则,借鉴了数学图论、资源分配模型以及高级计算思维。理解这些理论基础有助于深入理解复杂系统如何管理资源交互。

基于图的资源建模是理解死锁动态的关键理论方法。在这种模型中,计算资源被表示为节点,有向边代表分配和关系。通过将资源交互转化为数学图,计算机科学家可以应用复杂的图论算法来分析潜在的死锁情况。

形式化验证技术作为一种完善的理论方法,用于防止死锁。这些数学方法包括创建可以数学证明没有死锁条件的综合计算模型。研究人员使用先进的逻辑和模型检查算法来验证系统设计本身能固化防止循环资源依赖。

8.高级缓解技术

动态资源分配代表了解决死锁的最前沿方法。与静态资源分配策略不同,高级系统实现智能、实时资源管理机制,可根据当前系统条件动态调整资源分配。

预测性资源建模将缓解措施提升到复杂的水平。通过实施分析历史资源利用模式的人工智能算法,系统可以在潜在的死锁发生之前预测到这种情况。这些自适应系统可以积极重新分配资源、调整线程调度或实施预防性同步机制。

分层资源分配提供了一种先进的缓解策略。通过将资源组织成具有明确访问协议的分层结构,系统可以数学上防止循环依赖情况的发生。这种方法实施了严格的排序规则,消除了循环等待条件的可能性。

9.真实的死锁场景

操作系统文件系统管理演示了一个经典的死锁易发环境。想象一下,多个进程同时尝试访问和修改共享文件。一个进程可能会对一个文件持有读锁,同时请求对另一个文件持有写锁,而另一个进程则持有写锁并请求对第一个文件持有读锁。

数据库事务处理代表了另一个非常容易陷入死锁情况的领域。涉及多个并发数据库操作的复杂事务系统很容易创建复杂的资源依赖链。一个处理多账户间同时资金转账的银行系统提供了潜在死锁复杂性的完美例子。

分布式计算系统面临特别棘手的死锁情况。在跨越多个网络计算机的分布式环境中,资源分配变得指数级复杂。网络通信协议、分布式资源管理和节点间同步创造了众多潜在的死锁点。

10.新兴研究方向

量子计算同步出现在了死锁研究中的有趣前沿。传统的死锁预防策略依赖于经典计算模型,但量子计算引入了根本不同的资源交互范式。研究人员正在探索量子纠缠和叠加如何提供新的方法来解决同步挑战。

人工智能驱动的死锁预防代表另一个前沿研究领域。机器学习算法可以潜在地开发自适应的资源分配策略,这些策略动态学习和优化同步机制。这些智能系统能够以前所未有的精确度预测并防止死锁场景。

11.性能和优化策略

在防止死锁的机制中,性能优化需要在全面预防和计算效率之间取得平衡。每增加一次同步检查都会引入计算开销,因此需要智能且轻量级的预防策略。

自适应阈值机制提供了一种复杂的方式来平衡预防和性能。这些系统使用概率模型和动态阈值来选择性地应用更密集的死锁预防技术,而不是对每个资源请求实施全面的检查。

12.性能影响

死锁预防和检测机制引入了计算开销,必须仔细平衡与系统性能要求之间的关系。每一个额外的检查和验证步骤都会消耗处理资源,并有可能增加系统的延迟。

资源管理算法如银行家算法需要复杂的计算分析,在具有大量线程和资源的情况下可能会变得计算成本高。计算复杂度随着线程和资源类型的数量呈指数增长,这要求智能化的优化策略。

13.总结

死锁管理代表一种复杂的资源分配、线程同步和预测系统设计艺术。通过理解导致死锁的基本条件并实施智能预防策略,开发人员可以创建稳健、具有弹性的并发系统,这些系统优雅地处理复杂的计算场景。

评论记录:

回复评论: