大家好,我是蓝胖子的小叮当,今天分享的是如何搭建一个本地AI知识库,大家在阅读期间有任何的意见或建议都可以留言给我哈!

搭建一个本地知识库的意义在于可以利用大模型的能力加上自己的知识库,可以训练出一个符合自己业务和需求的大模型。

例如:我们在市面上的大模型AI中去提问JavaScript是什么,或者提问牛肉炒芹菜怎么做都可以获得很好的回答,但如果我们提问蓝胖子的小叮当是谁,得到的回答就不是我们想要的啦。同样的如果去提问一些关于自己积累的知识、公司的业务记录文档等,就很难帮助到我们啦。而本地部署大模型+知识库,就可以省去很多查找数据、资料的时间啦。

我采用的模型是deepseek,部署使用到的工具有ollama+docker+dify

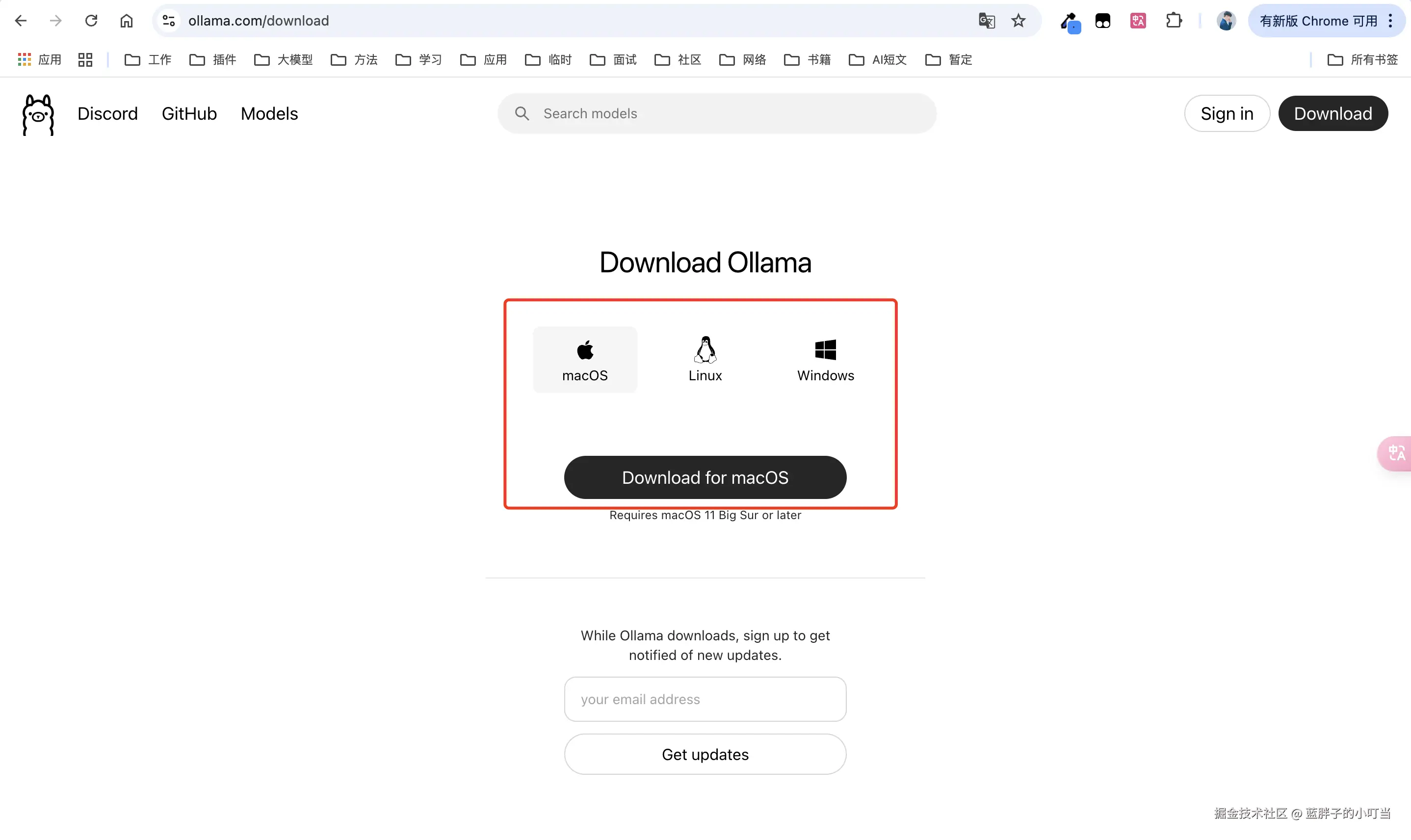

1.安装ollama

下载地址:ollama.com/ 根据自己的操作系统选择对应的版本下载并安装

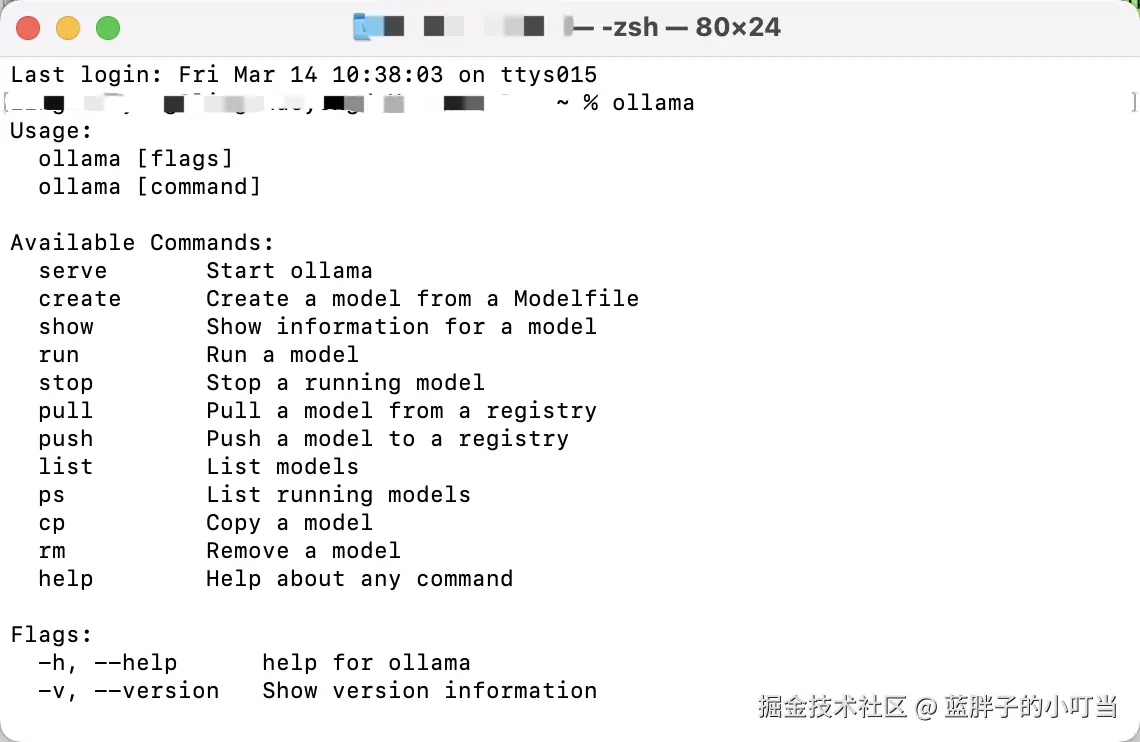

安装成功后打开命令终端输入ollama,出现下图则表示安装成功

安装成功后打开命令终端输入ollama,出现下图则表示安装成功

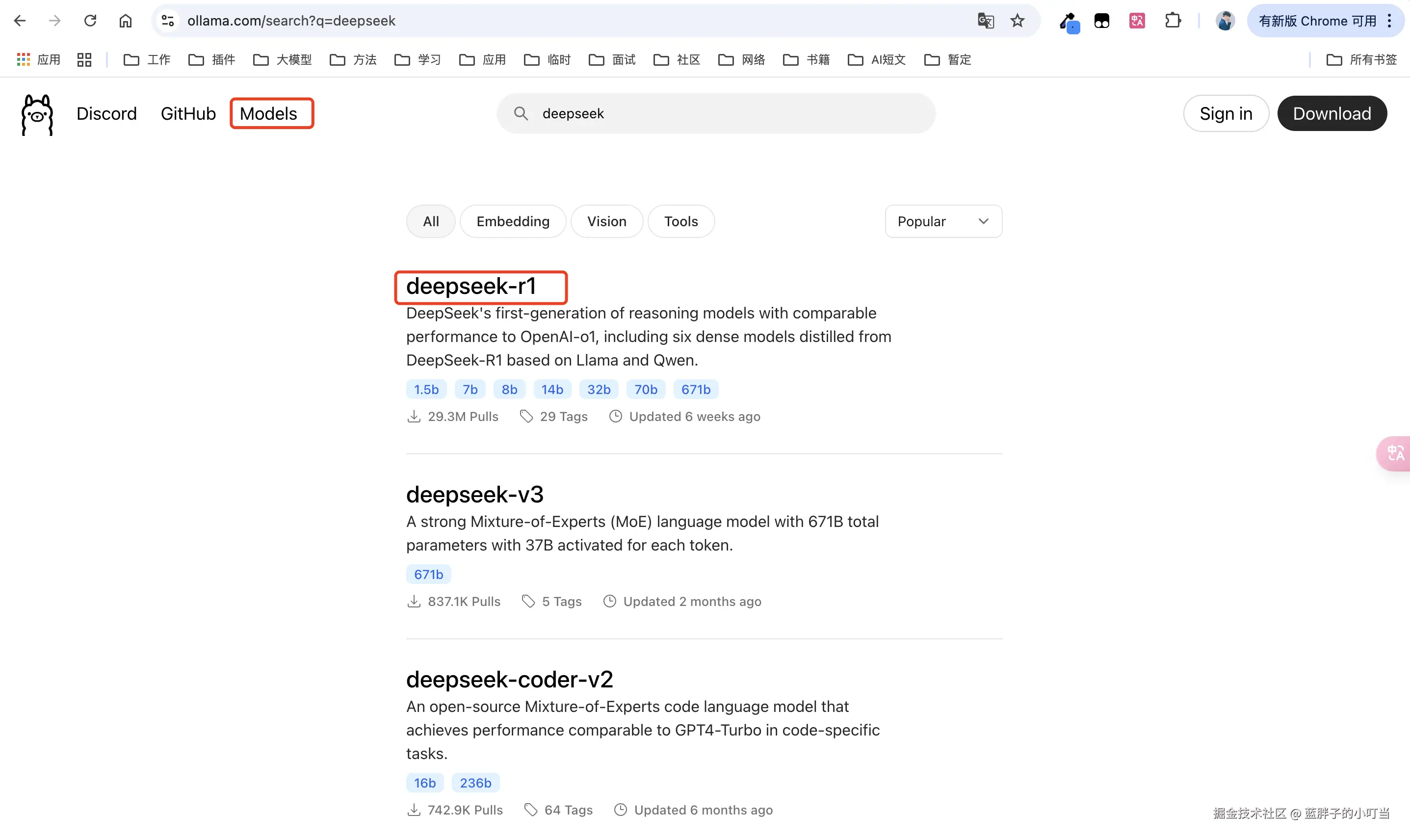

2.安装大模型

在ollama官网选择Models,搜索deepseek,我这里选择的是deepseek-r1

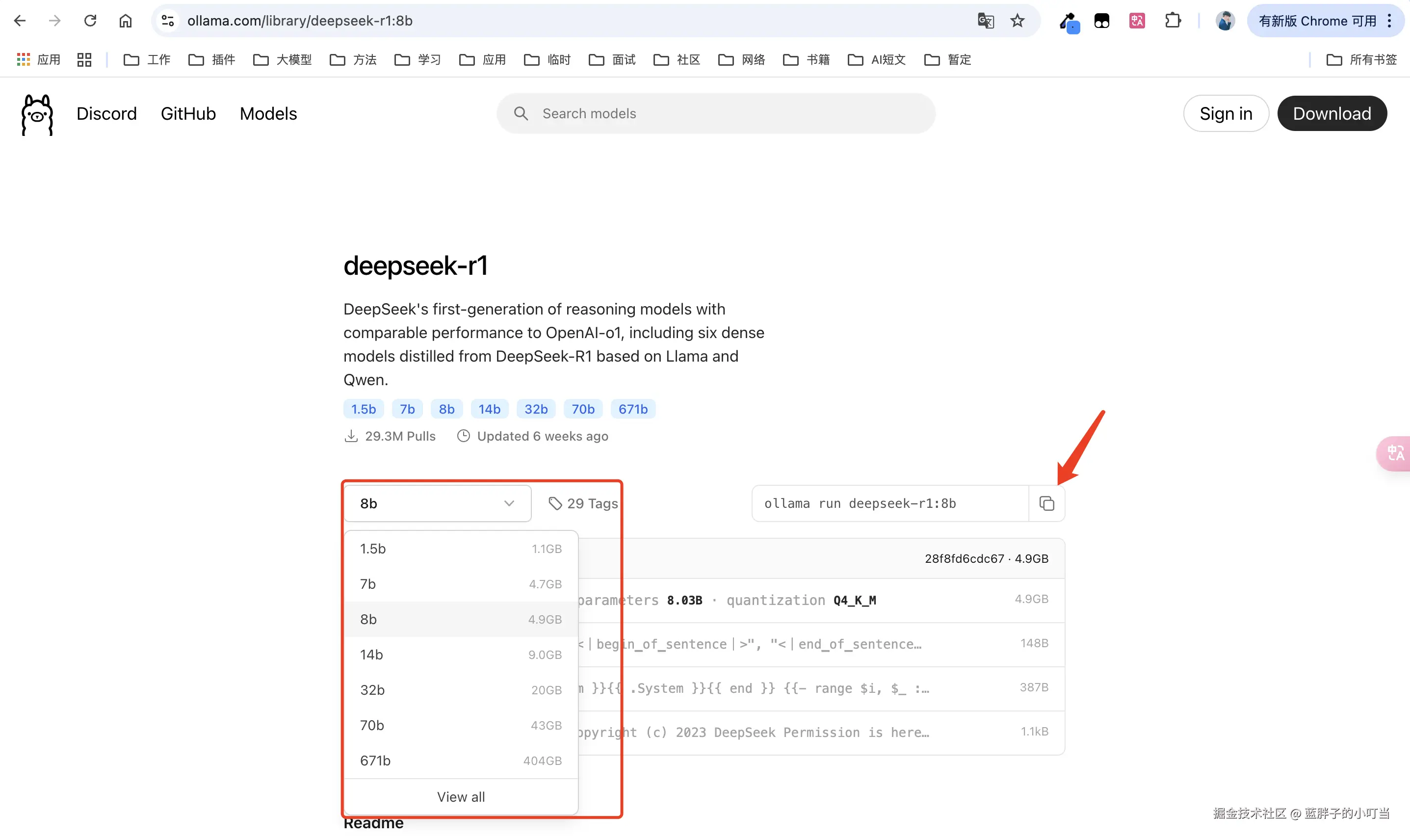

点进来后如下图选择对应模型,越大对应的智能程度越高,这里的大小对应的是显存的大小哦,根据自己安装的机子的显存大小来选择,这里我选择的是8b,并点击右侧复制按钮

点进来后如下图选择对应模型,越大对应的智能程度越高,这里的大小对应的是显存的大小哦,根据自己安装的机子的显存大小来选择,这里我选择的是8b,并点击右侧复制按钮

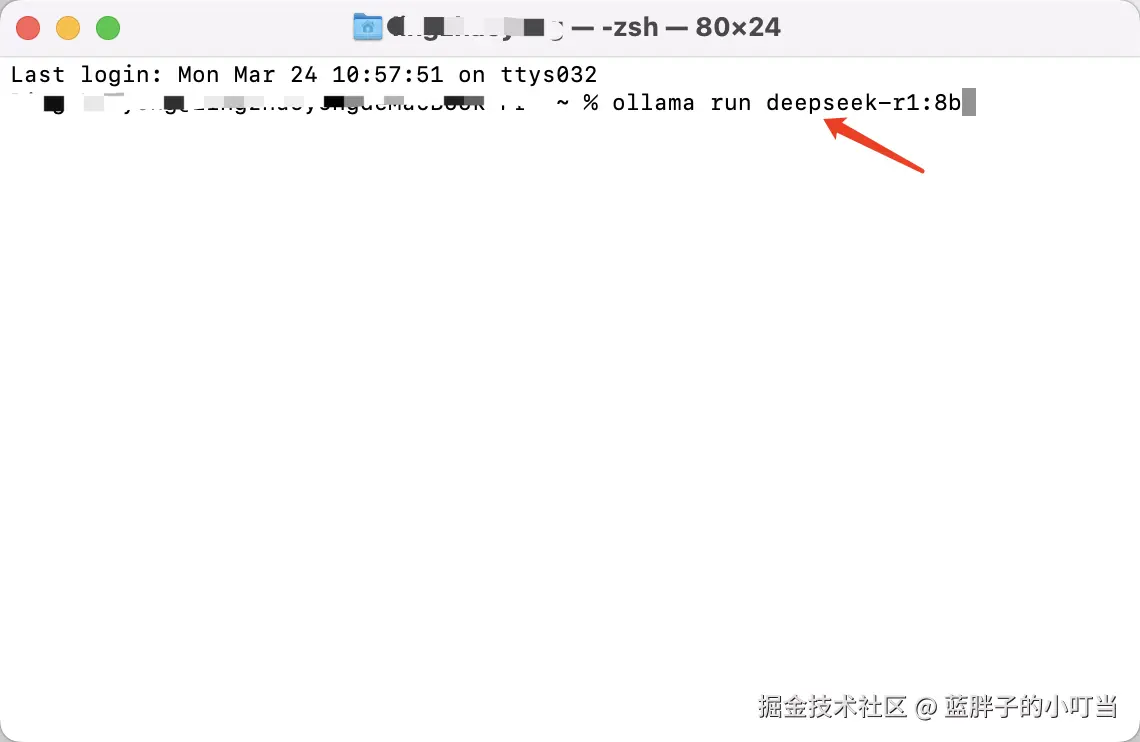

打开命令终端并运行复制下来的命令即可进行安装

打开命令终端并运行复制下来的命令即可进行安装

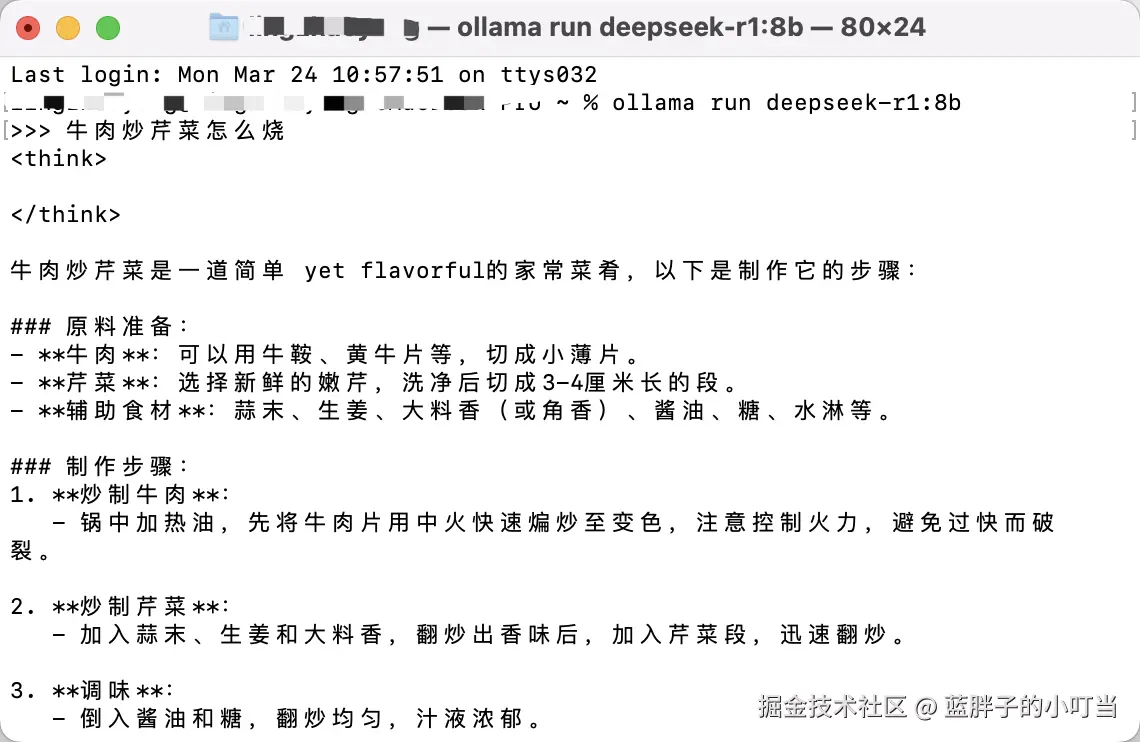

安装完成后即可开始提问啦,后续想要再次提问也是打开命令终端输入上述命令进入提问哦

安装完成后即可开始提问啦,后续想要再次提问也是打开命令终端输入上述命令进入提问哦

好啦 本地已经安装好大模型啦。

好啦 本地已经安装好大模型啦。

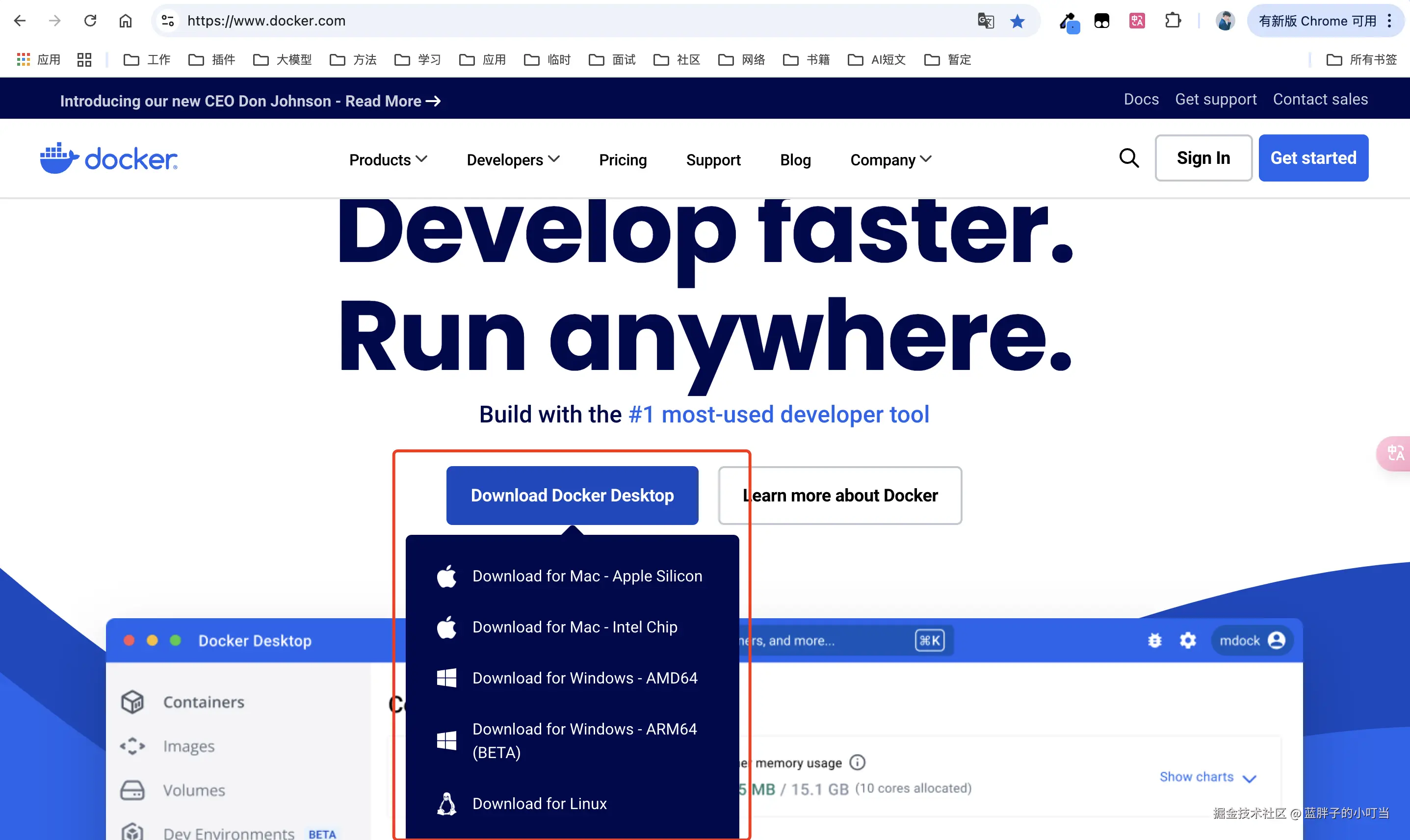

3.安装docker

下载地址:www.docker.com/ 根据自己的操作系统选择对应的版本下载并安装

4.安装dify

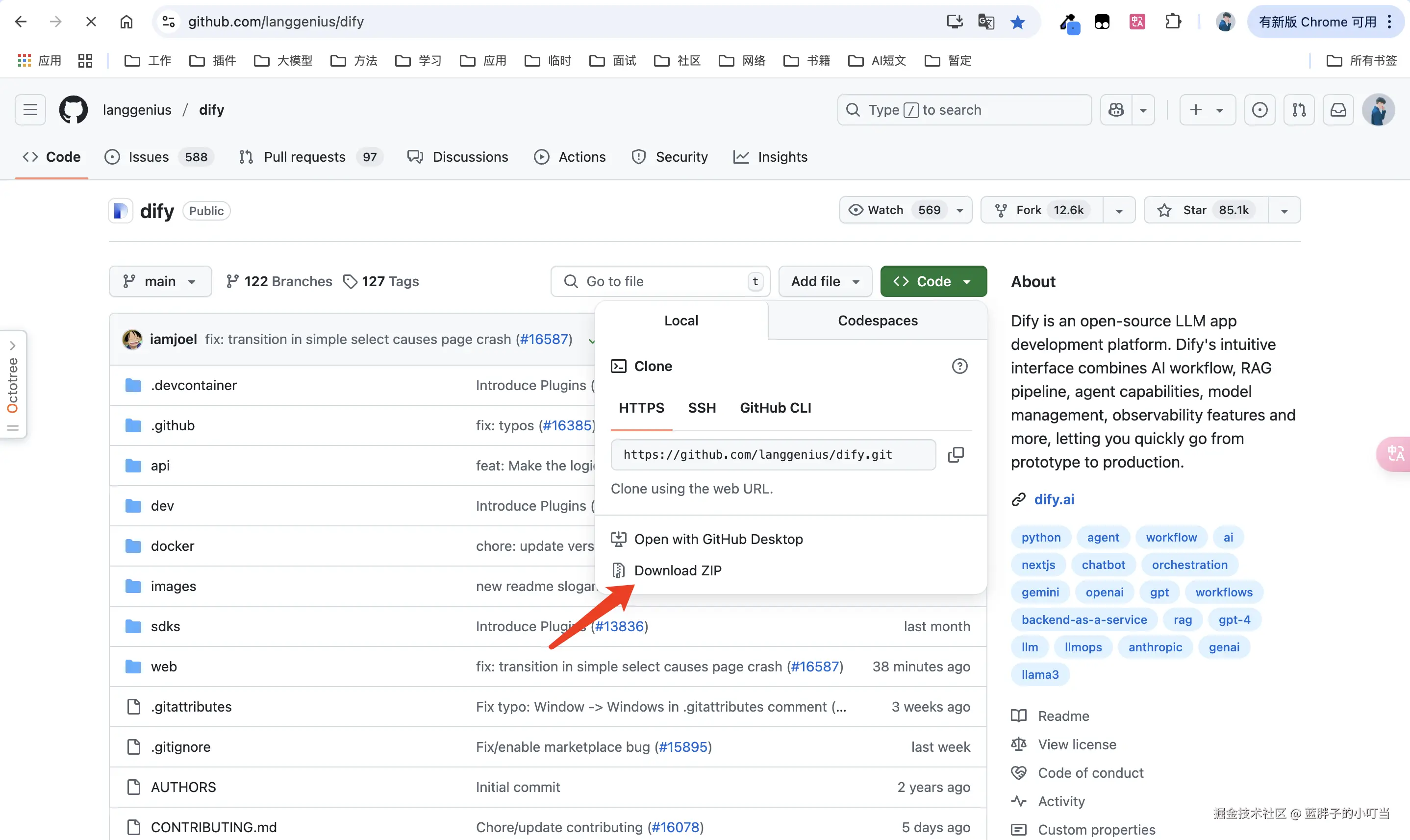

安装地址:github.com/langgenius/… 下载zip并解压,解压保存路径不要有中文

打开命令终端,执行下述命令

打开命令终端,执行下述命令

js 代码解读复制代码cd ./dify/dify-main/docker //进入解压包内的docker文件

cp .env.example .env //复制一份

docker compose up -d //执行docker命令

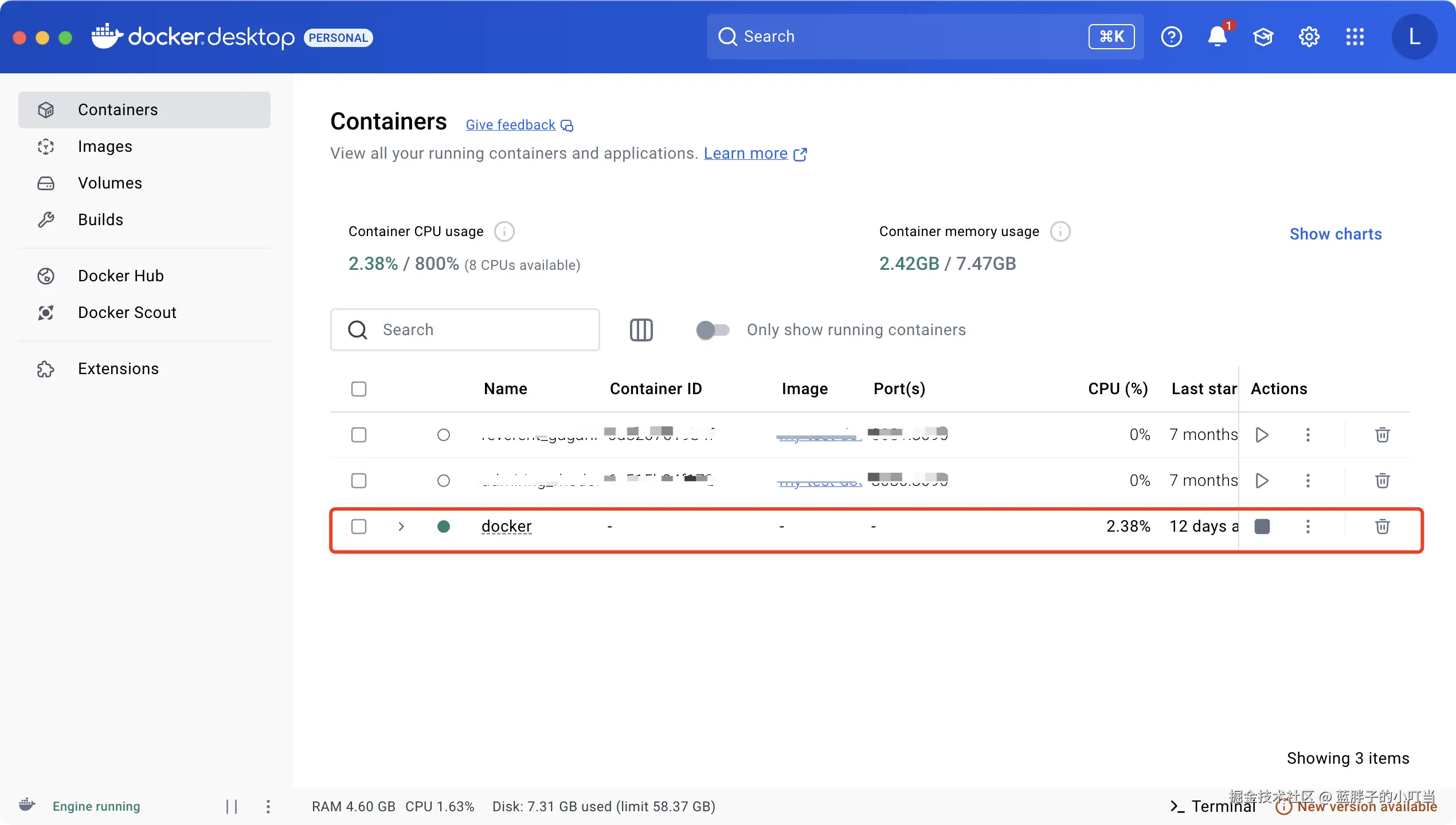

打开docker看到这一条,说明dify下载成功

5.安装bge-large

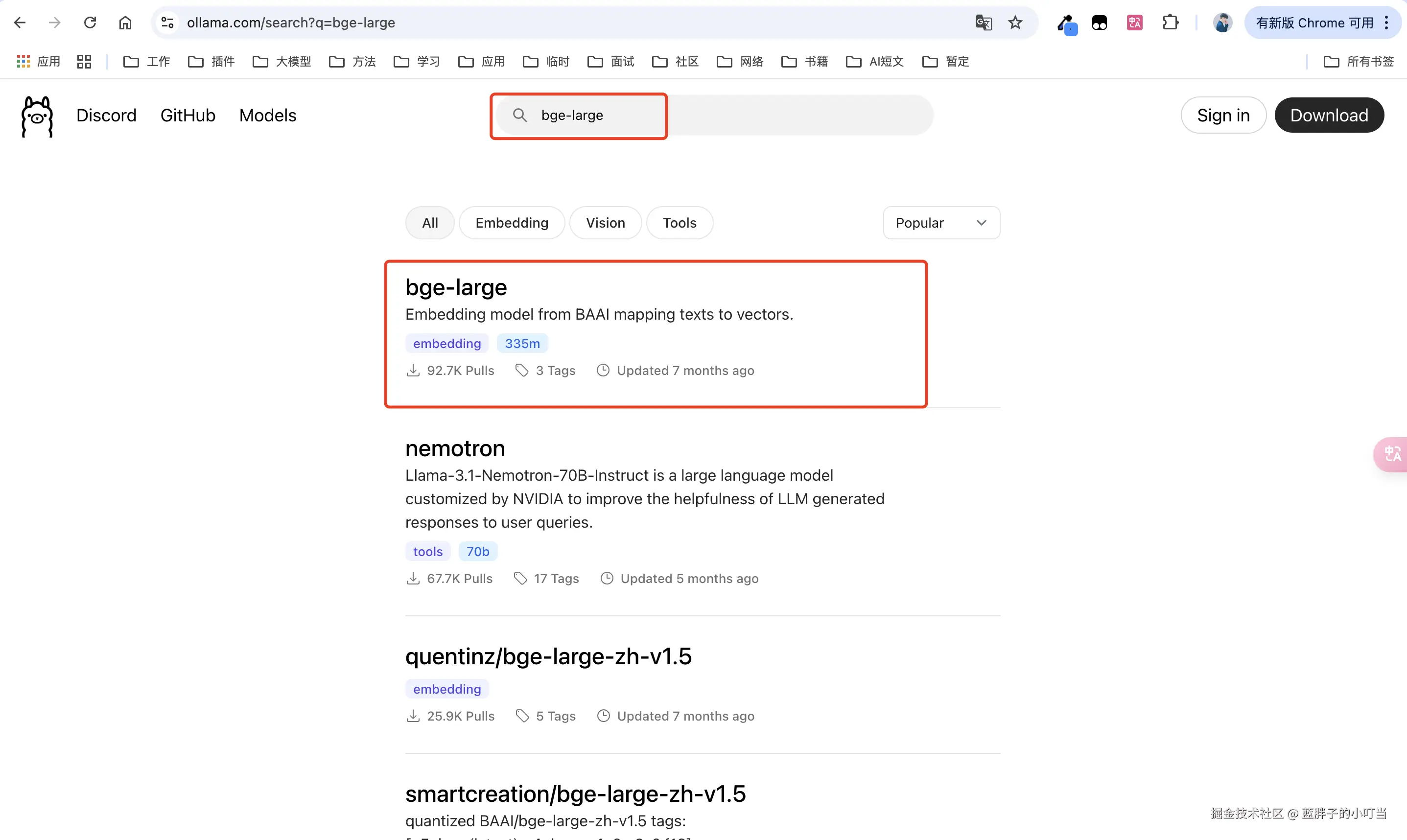

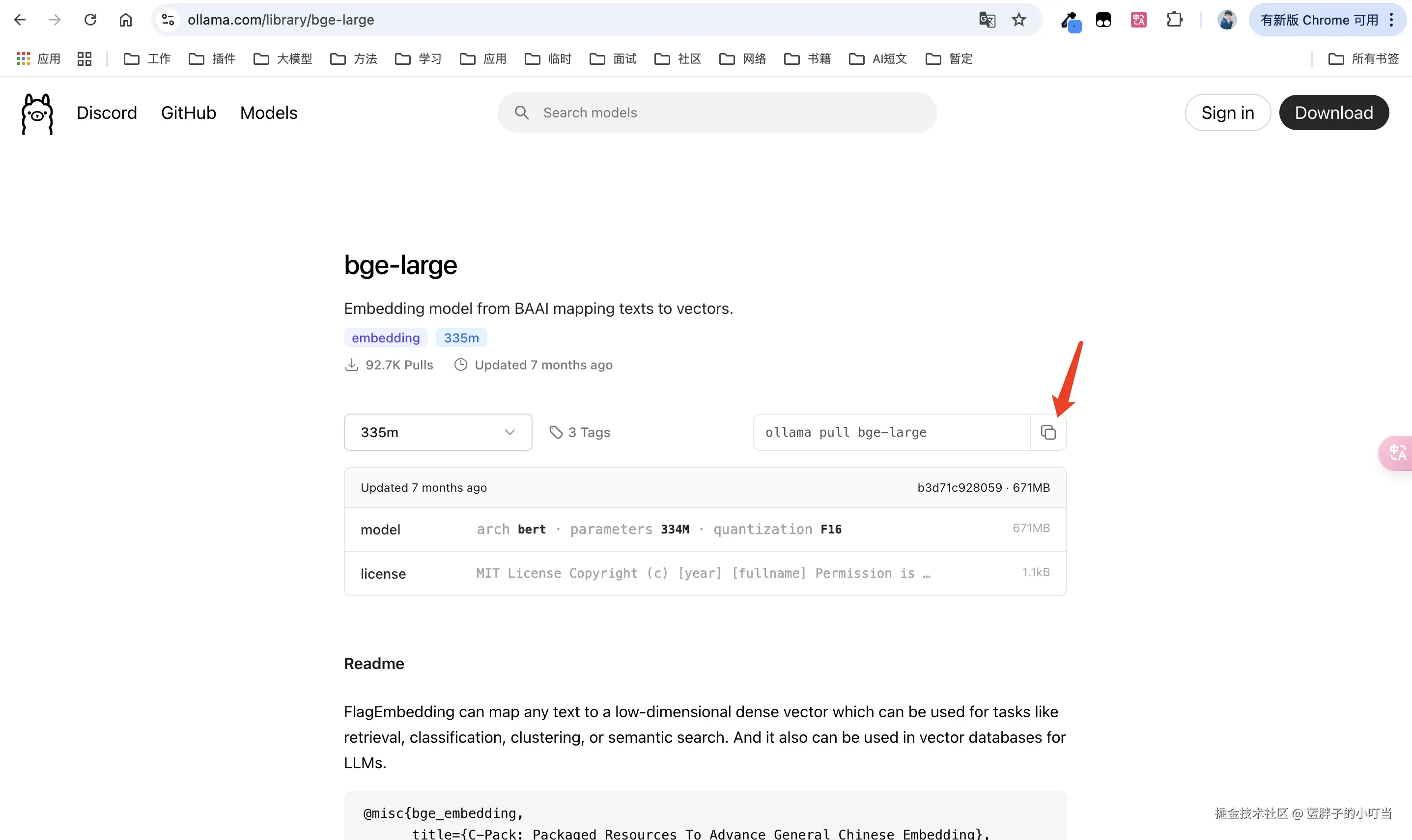

打开ollama官网选择Models搜索bge-large

进入后复制命令 并在命令终端执行下载

进入后复制命令 并在命令终端执行下载

6.安装dify配置大模型

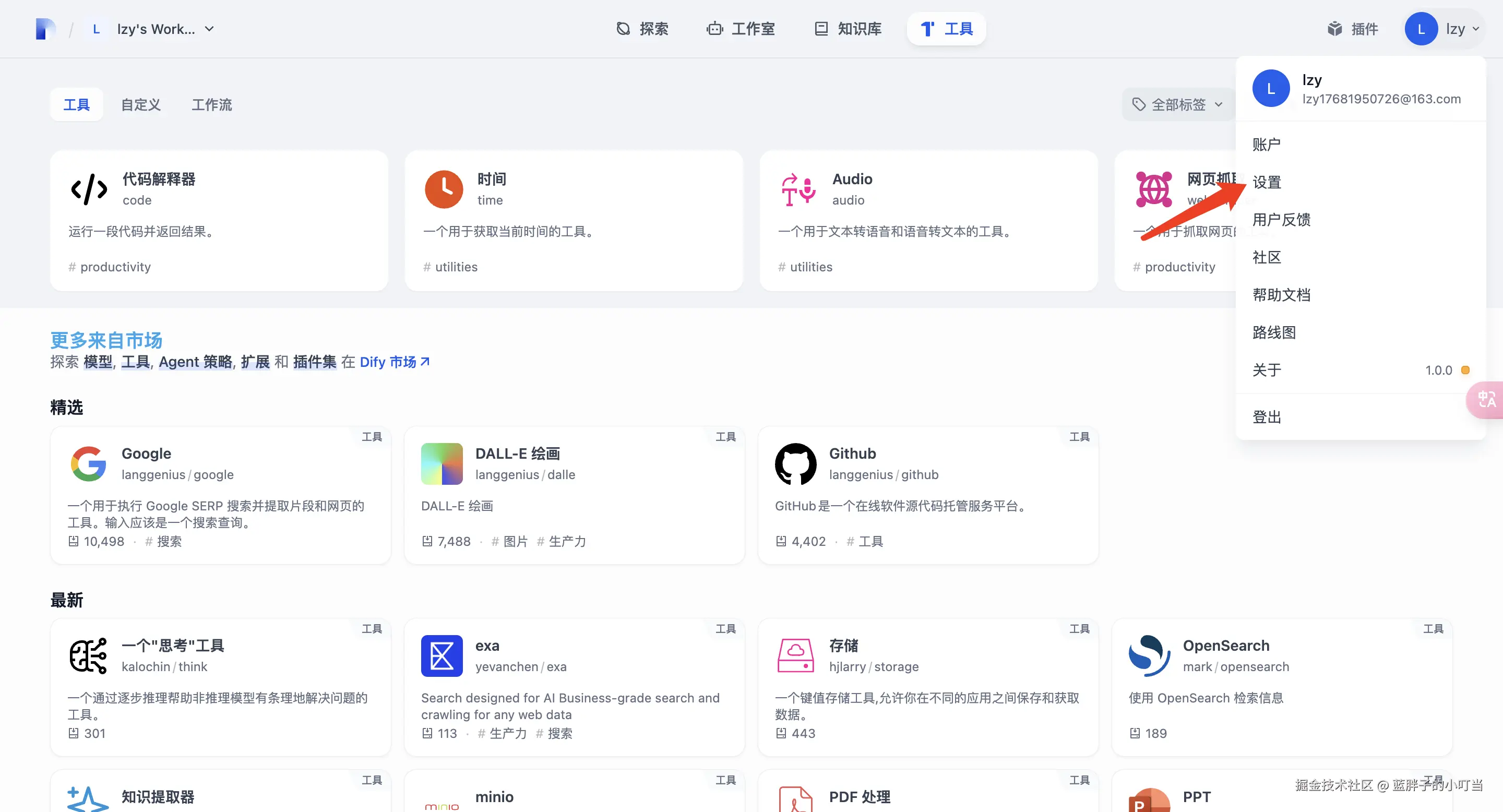

浏览器打开http://localhost/signin 进入登录界面注册账号登录,登录后点击右上角个人中心选择设置

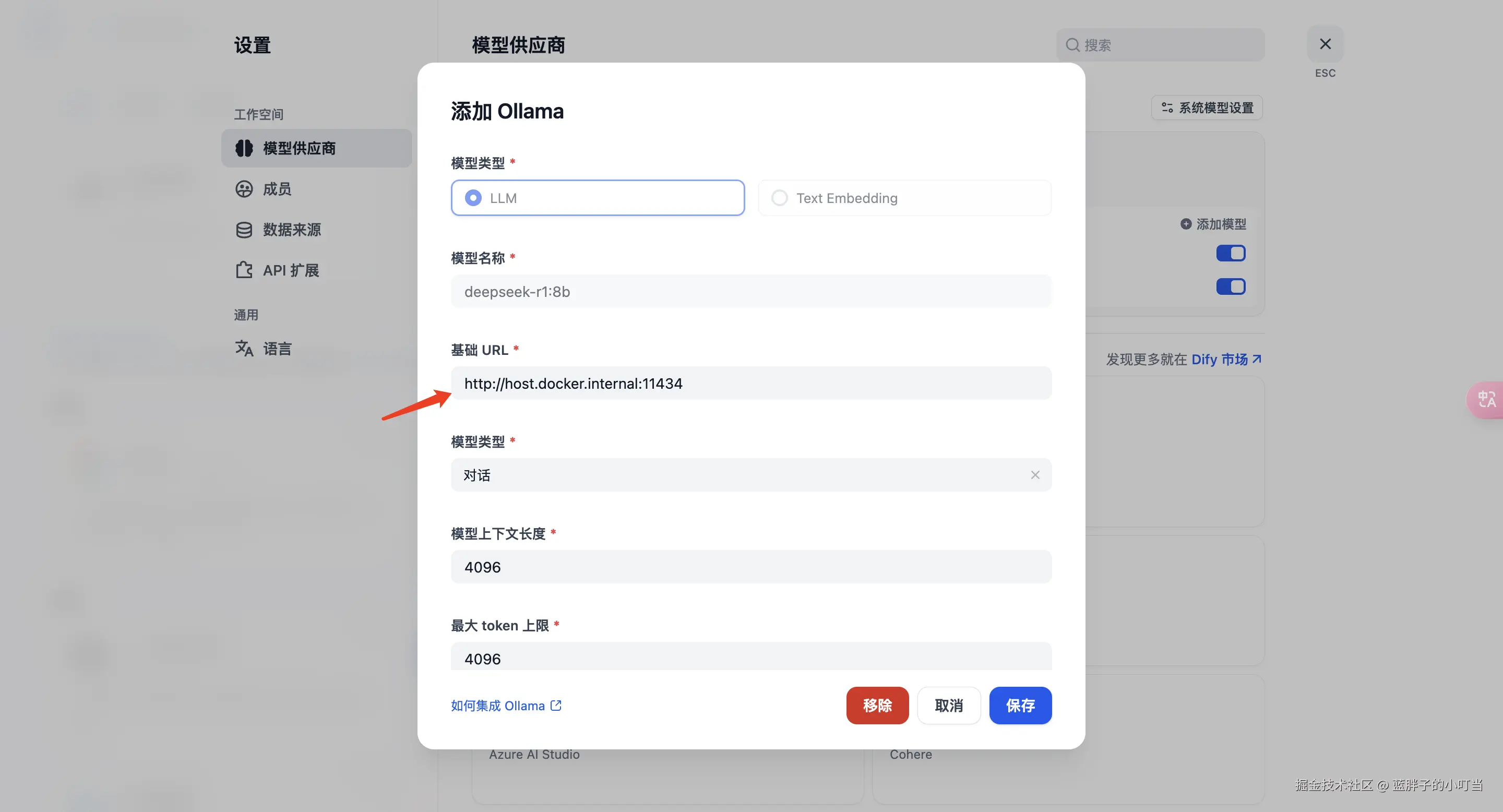

选择模型供应商找到ollama点击添加大模型,选择LLM,模型名称自定义,基础URL填写host.docker.internal:11434 其余不变,点击保存

选择模型供应商找到ollama点击添加大模型,选择LLM,模型名称自定义,基础URL填写host.docker.internal:11434 其余不变,点击保存

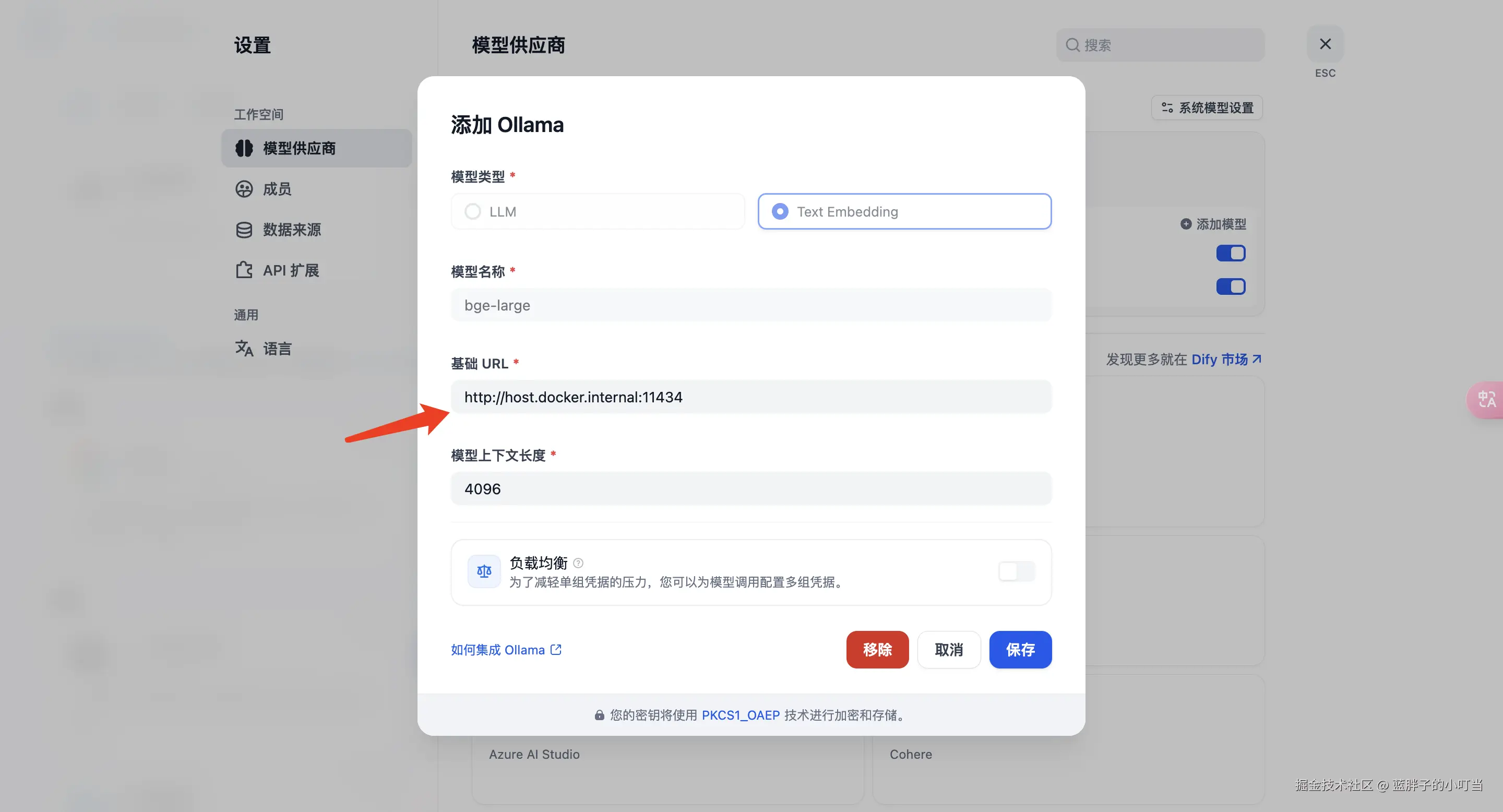

再点击ollama添加大模型,选择Text Embedding,模型名称自定义,基础URL填写host.docker.internal:11434 其余不变,点击保存

再点击ollama添加大模型,选择Text Embedding,模型名称自定义,基础URL填写host.docker.internal:11434 其余不变,点击保存

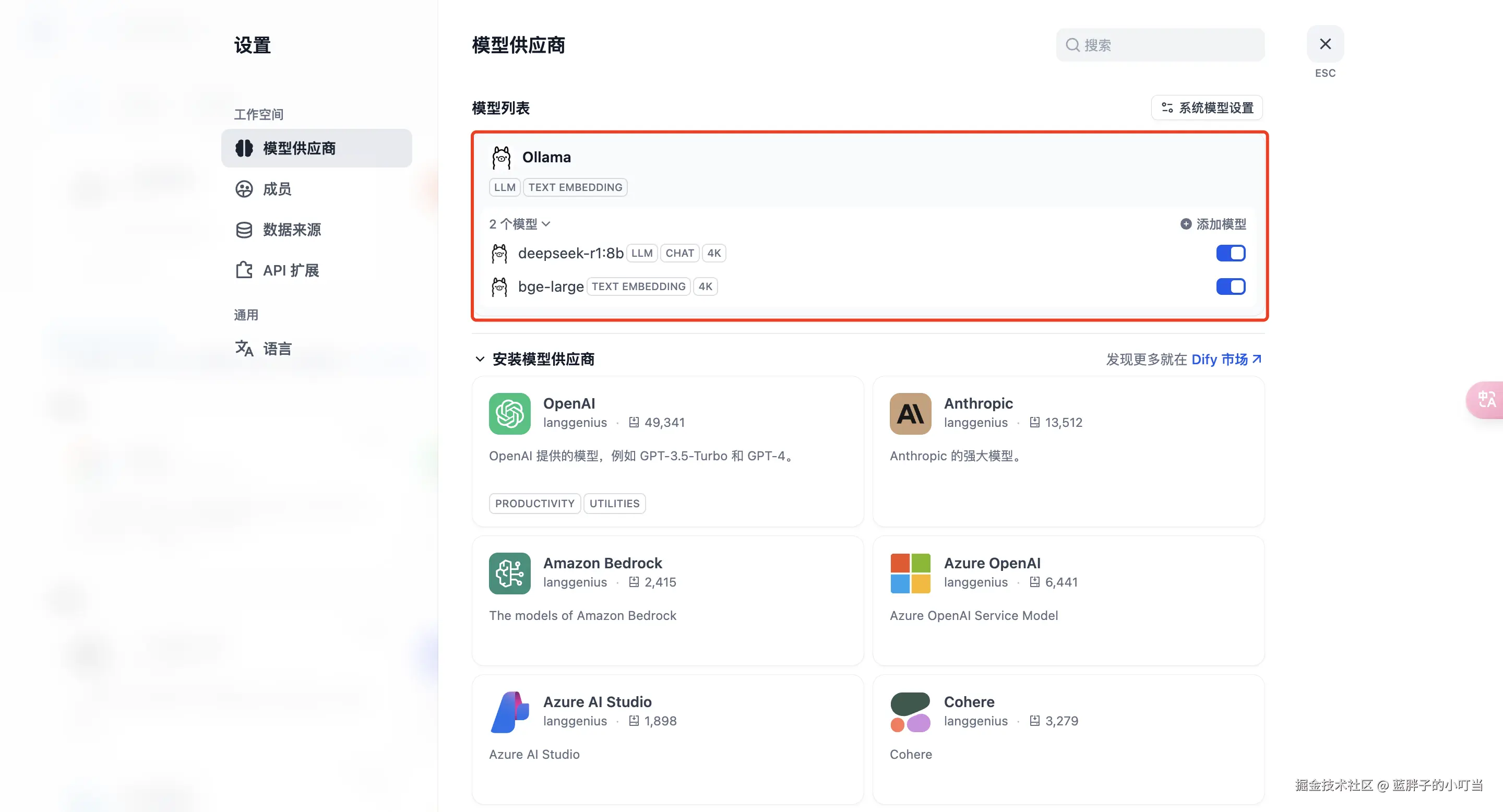

看到如下图就表示添加成功

看到如下图就表示添加成功

tip:在上述添加大模型时有可能会出现保存无响应或添加失败的情况,大概率是dify中配置的问题,可尝试根据./dify/dify-main/docker/.env该路径找到.env文件(找不到的话可能有文件隐藏,根据不同的操作系统将隐藏文件显示出来),编辑文件添加ollama服务ip地址

tip:在上述添加大模型时有可能会出现保存无响应或添加失败的情况,大概率是dify中配置的问题,可尝试根据./dify/dify-main/docker/.env该路径找到.env文件(找不到的话可能有文件隐藏,根据不同的操作系统将隐藏文件显示出来),编辑文件添加ollama服务ip地址

js 代码解读复制代码CUSTOM_MODEL_ENABLED=true

OLLAMA_API_BASE_URL=172.11.214.136:11434

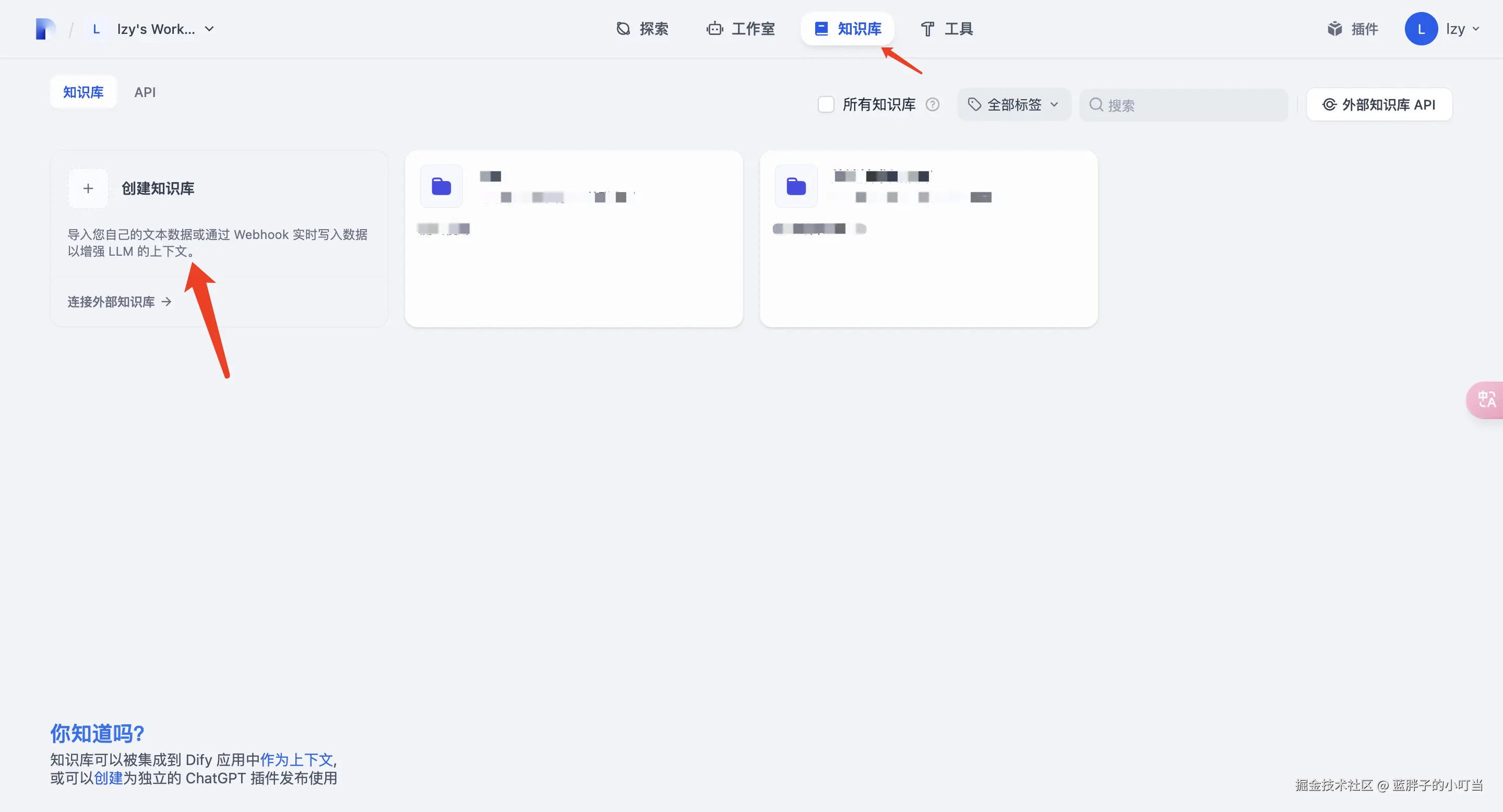

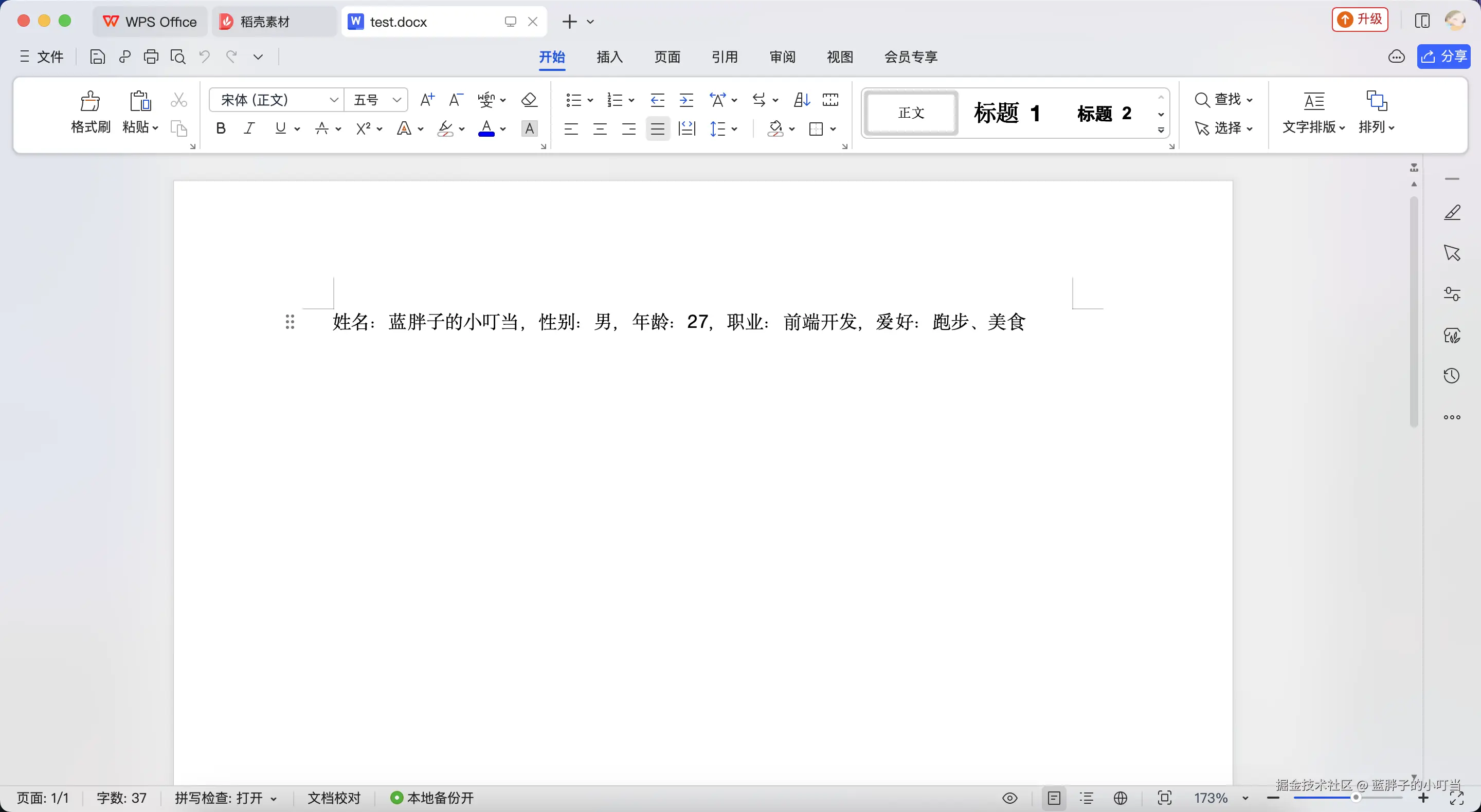

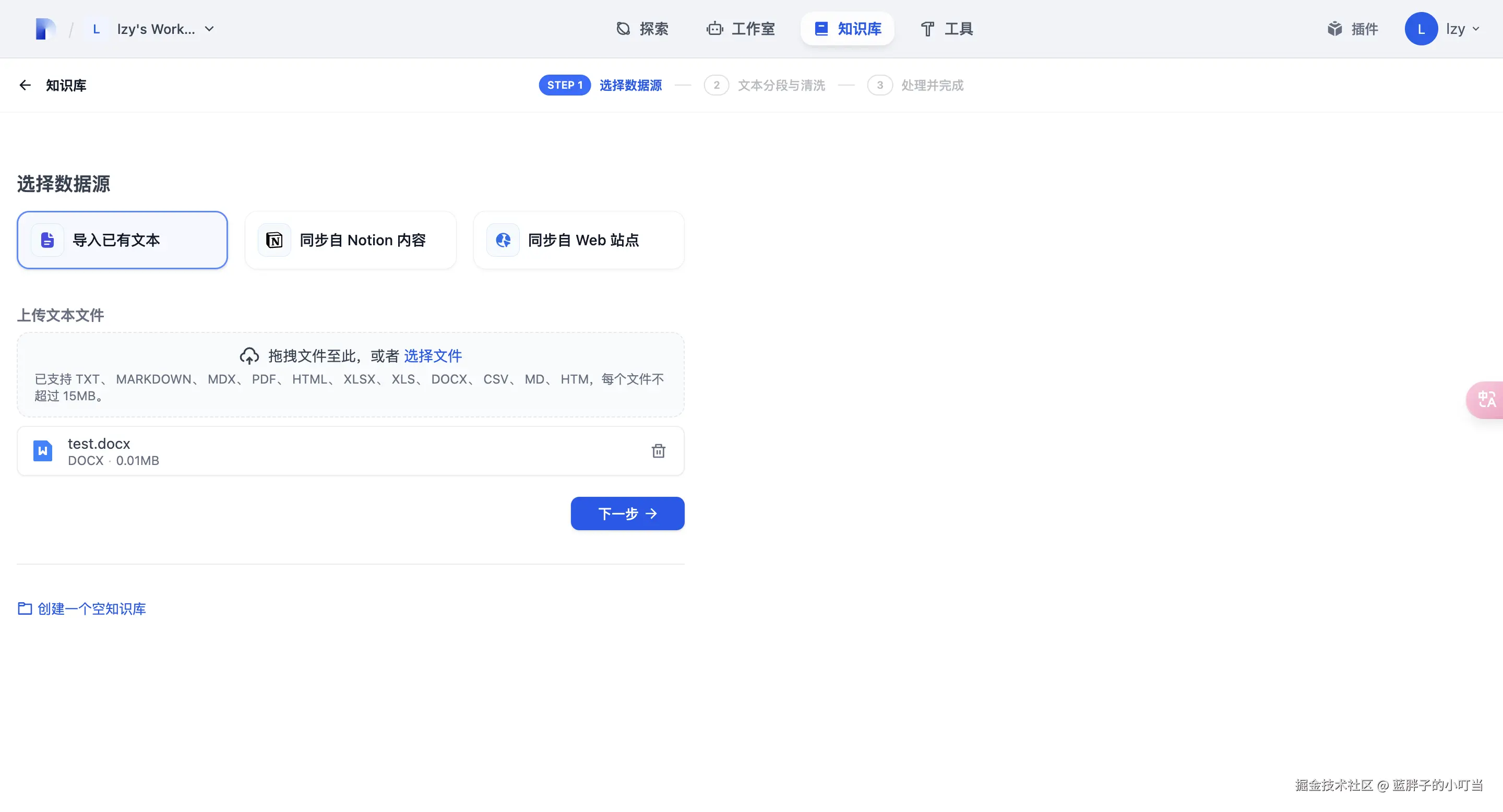

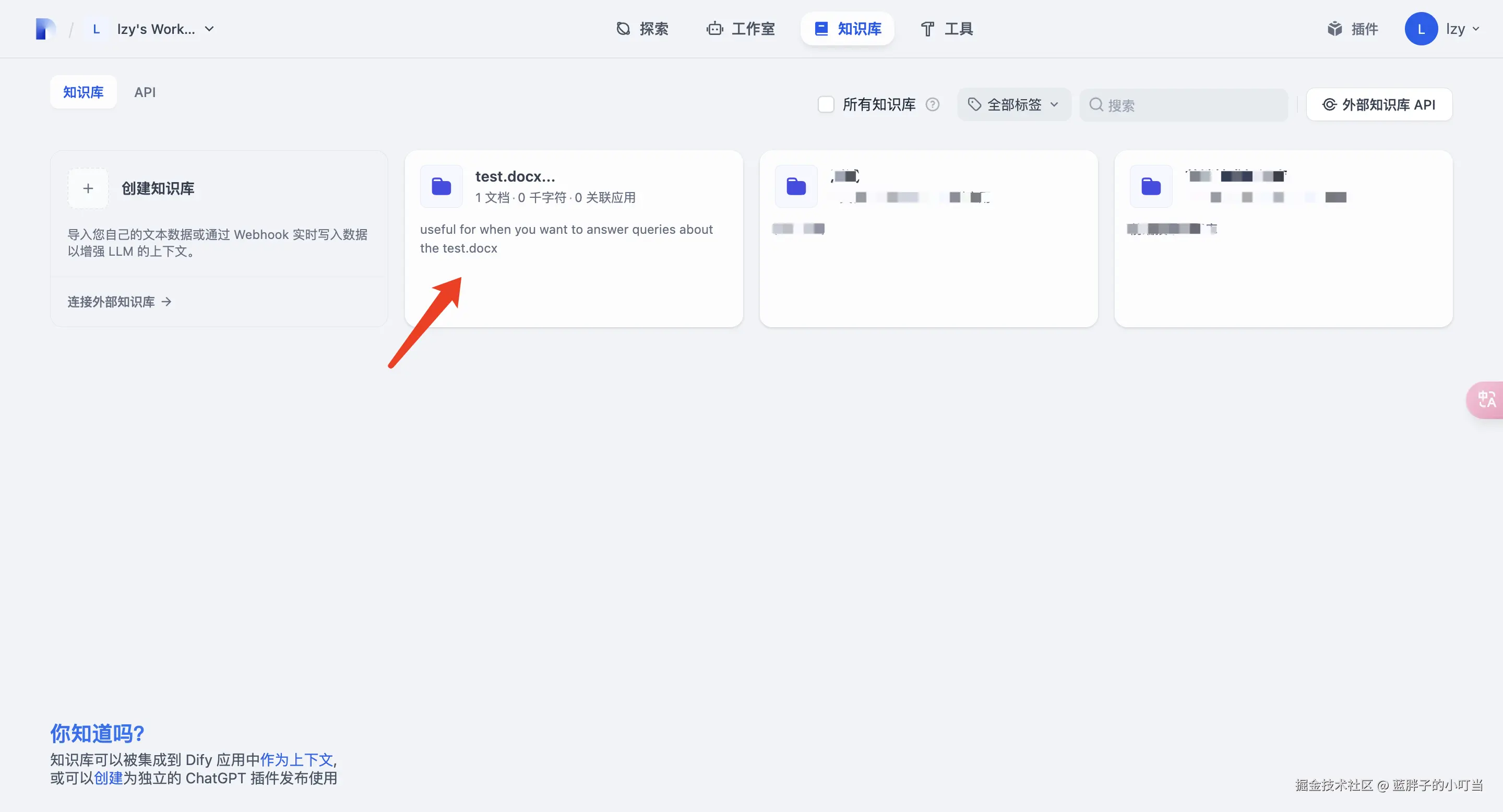

7.创建知识库

dify主界面点击知识库,创建知识库

上传知识文档(我这里测试用的,上传了一个蓝胖子的小叮当的简短介绍的word),点击下一步到文本分段与清洗(这里先全部默认,后续有一定认知后再调整),点击下一步就可以处理并完成,点击到知识库就可以看到我们创建的知识库啦

上传知识文档(我这里测试用的,上传了一个蓝胖子的小叮当的简短介绍的word),点击下一步到文本分段与清洗(这里先全部默认,后续有一定认知后再调整),点击下一步就可以处理并完成,点击到知识库就可以看到我们创建的知识库啦

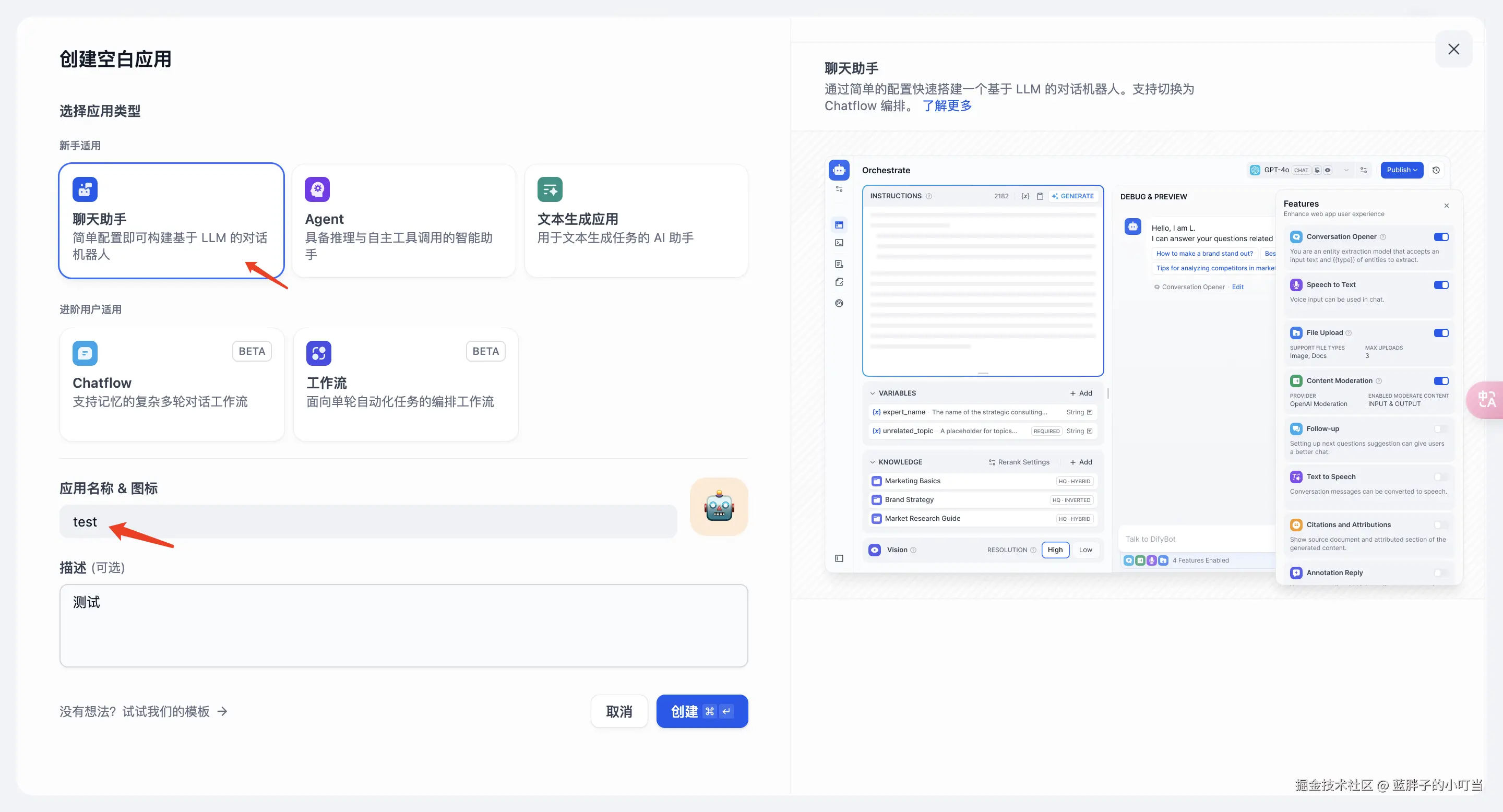

8.创建应用

dify主界面,点击工作室,点击创建空白应用

选择聊天助手,输入名称和描述,点击创建即可

选择聊天助手,输入名称和描述,点击创建即可

在对话界面,首先添加我们刚创建的知识,然后提问就可以看到输出的是我们刚才导入文档中的内容啦

在对话界面,首先添加我们刚创建的知识,然后提问就可以看到输出的是我们刚才导入文档中的内容啦

好啦,关于如何搭建一个属于自己的本地大模型AI知识库的流程就总结到这里,当然这里还有更多可供使用的知识点,大家可以慢慢探索哦,如果有什么疑问、意见或建议,都可畅所欲言,谢谢大家,我也将持续更新。

好啦,关于如何搭建一个属于自己的本地大模型AI知识库的流程就总结到这里,当然这里还有更多可供使用的知识点,大家可以慢慢探索哦,如果有什么疑问、意见或建议,都可畅所欲言,谢谢大家,我也将持续更新。

评论记录:

回复评论: