一、前言

在当前人工智能应用日益普及的背景下,各类大模型为我们的项目开发和技术交流提供了更多可能。今天,我们通过一个简单的 Python 示例,演示如何利用 OpenAI SDK 调用 deepseek-chat 模型,快速实现智能问答功能。需要注意的是,示例中提到的“什么是CNN神经网络?”仅作为测试问题,并非深入解析相关技术。

二、技术背景与原理简介

1. OpenAI SDK 与深度对话模型

OpenAI SDK 提供了一套易于使用的 API 接口,开发者可以通过该接口调用各种预训练大模型来完成自然语言处理任务。本文示例中,我们调用了 deepseek-chat 模型,该模型经过大量语料训练,能够生成流畅、自然的回答,适用于智能问答、对话系统等场景。

2. 模型调用的优势

2.1. 简单易用:只需几行代码即可完成 API 客户端的创建和模型调用。

2.2. 灵活高效:通过预训练大模型,能够快速生成符合上下文的回答。

2.3. 广泛适用:无论是开发智能客服、对话机器人,还是用于技术问答,均能轻松适应。

三、软件下载与环境配置

1. 安装 Python 与 pip

DeepSeek API 的调用依赖 Python 环境。请按以下步骤安装 Python:

1.1. 下载 Python:访问 Python 官方网站,选择适合你操作系统的版本进行下载安装。建议选择 Python 3.8 及以上版本。

1.2. 配置环境变量:安装过程中勾选“Add Python to PATH”,确保在命令行中可以直接使用 Python 和 pip 命令。

2. 安装 OpenAI SDK

DeepSeek API 调用依赖 OpenAI SDK。安装方法非常简单,只需使用 pip 命令即可:

pip install openai或者可以通过通过清华大学的 PyPI 镜像来加速安装 openai 库,可以显著提升在国内安装 Python 包时的下载速度。

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple pip install openai3. 配置 IDE 或开发环境

建议使用 Visual Studio Code、PyCharm 或其他你熟悉的代码编辑器进行开发。打开项目文件夹,创建 Python 脚本,并确保 IDE 已正确识别 Python 解释器。

4. 申请 API 密钥

4.1. 申请密钥:在控制台中找到“申请 API 密钥”或“创建新密钥”的选项。点击后系统会生成一个类似 sk-xxxxxxxxxxxxxxxxxxxx 的密钥。官网链接DeepSeek。

4.2. 复制保存:将生成的 API 密钥复制并妥善保存。切记不要泄露该密钥,因为它将用于你的所有 API 调用,保证账号安全至关重要。

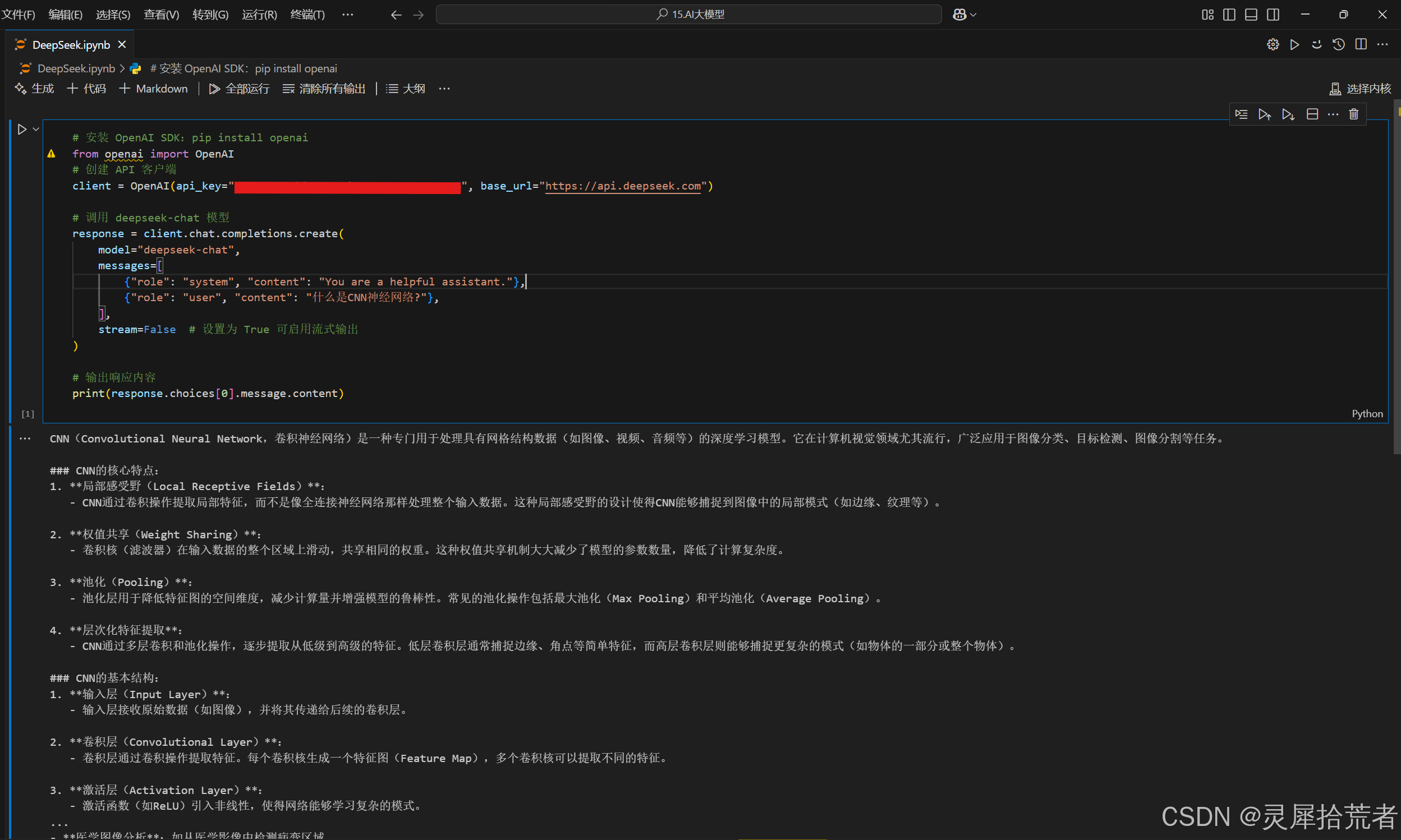

四、代码详解

- # 安装 OpenAI SDK:pip install openai

- from openai import OpenAI

解析:

首先,在代码中引入该库,为后续的 API 调用打下基础。

- # 创建 API 客户端

- client = OpenAI(api_key="sk-xxxxxxxxxxxxxxxxxxxx", base_url="https://api.deepseek.com")

解析:

这行代码创建了一个 API 客户端对象,传入了 API 密钥和基础 URL。这里的 base_url 指向 deepseek 平台的服务地址,确保后续请求能够正确路由到相应的模型。

- # 调用 deepseek-chat 模型

- response = client.chat.completions.create(

- model="deepseek-chat",

- messages=[

- {"role": "system", "content": "You are a helpful assistant."},

- {"role": "user", "content": "什么是CNN神经网络?"},

- ],

- stream=False # 设置为 True 可启用流式输出

- )

解析:

这部分代码调用了 deepseek-chat 模型:

- model 参数:指定使用的模型为 "deepseek-chat"。

- messages 参数:构造了一个对话列表,包括系统角色(设定 AI 为“有帮助的助手”)和用户角色(提出示例问题“什么是CNN神经网络?”)。

- stream 参数:控制返回结果的方式,此处设置为 False,表示一次性返回完整响应。如果需要实时获取模型回复,可设置为 True。

- # 输出响应内容

- print(response.choices[0].message.content)

解析:

最后,通过 print 函数输出模型返回的回答内容。response.choices[0].message.content 表示获取响应结果中的第一条消息内容,并展示给用户。

完整代码:

- # 安装 OpenAI SDK:pip install openai

- from openai import OpenAI

- # 创建 API 客户端

- client = OpenAI(api_key="sk-xxxxxxxxxxxxxxxxxxxx", base_url="https://api.deepseek.com")

-

- # 调用 deepseek-chat 模型

- response = client.chat.completions.create(

- model="deepseek-chat",

- messages=[

- {"role": "system", "content": "You are a helpful assistant."},

- {"role": "user", "content": "什么是CNN神经网络?"},

- ],

- stream=False # 设置为 True 可启用流式输出

- )

-

- # 输出响应内容

- print(response.choices[0].message.content)

五、总结与思考

本文通过简单的示例代码,展示了如何使用 OpenAI SDK 快速调用 deepseek-chat 模型实现智能问答。主要亮点包括:

- 接口简单:利用少量代码即可构建 API 客户端并调用模型,无需复杂配置。

- 应用广泛:示例中的问题仅作为测试,实际应用中可根据需求替换为各种业务场景的问题。

- 易于扩展:开发者可以根据业务需求修改对话内容、启用流式输出等,进一步提升系统交互体验。

这只是一个示例,帮助大家快速理解如何通过 OpenAI SDK 调用大模型进行问答。实际项目中,你可以根据具体场景调整模型参数、完善对话逻辑,打造更符合需求的智能系统。

【关注我们】

如果你对 AI 应用、智能问答等技术感兴趣,欢迎关注我们的公众号,点赞、评论并分享本期文章,获取更多前沿技术干货与实战经验!

评论记录:

回复评论: