基于Receiver的方式

这种方式使用Receiver来获取数据。Receiver是使用Kafka的高层次Consumer API来实现的。receiver从Kafka中获取的数据都是存储在Spark Executor的内存中的,然后Spark Streaming启动的job会去处理那些数据。

然而,在默认的配置下,这种方式可能会因为底层的失败而丢失数据。如果要启用高可靠机制,让数据零丢失,就必须启用Spark Streaming的预写日志机制(Write Ahead Log,WAL)。该机制会同步地将接收到的Kafka数据写入分布式文件系统(比如HDFS)上的预写日志中。所以,即使底层节点出现了失败,也可以使用预写日志中的数据进行恢复。

如何进行Kafka数据源连接

1、在maven添加依赖

groupId = org.apache.spark

artifactId = spark-streaming-kafka_2.10

version = 1.5.12、使用第三方工具类创建输入DStream

JavaPairReceiverInputDStream<String, String> kafkaStream =

KafkaUtils.createStream(streamingContext,

[ZK quorum], [consumer group id], [per-topic number of Kafka partitions to consume]);需要注意的要点

- Kafka中的topic的partition,与Spark中的RDD的partition是没有关系的。所以,在KafkaUtils.createStream()中,提高partition的数量,只会增加一个Receiver中,读取partition的线程的数量。不会增加Spark处理数据的并行度。

- 可以创建多个Kafka输入DStream,使用不同的consumer group和topic,来通过多个receiver并行接收数据。

- 如果基于容错的文件系统,比如HDFS,启用了预写日志机制,接收到的数据都会被复制一份到预写日志中。因此,在KafkaUtils.createStream()中,设置的持久化级别是StorageLevel.MEMORY_AND_DISK_SER。

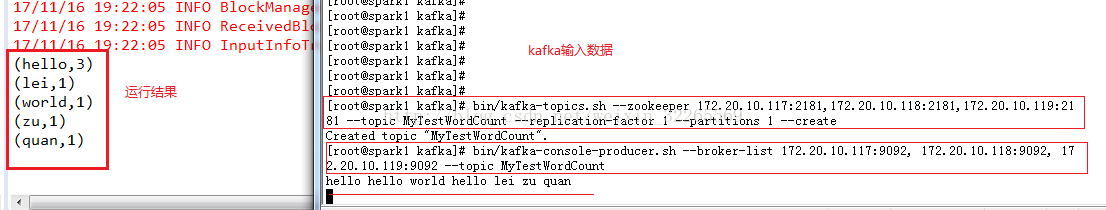

Kafka命令(进入到cd /usr/local/kafka)

// 创建topic

bin/kafka-topics.sh --zookeeper 172.20.10.117:2181,172.20.10.118:2181,172.20.10.119:2181 --topic MyTestWordCount --replication-factor 1 --partitions 1 --create// 创建consumer

bin/kafka-console-producer.sh --broker-list 172.20.10.117:9092, 172.20.10.118:9092, 172.20.10.119:9092 --topic MyTestWordCountjava版本代码:

- package cn.spark.study.streaming;

-

- import java.util.Arrays;

- import java.util.HashMap;

- import java.util.Map;

-

- import org.apache.spark.SparkConf;

- import org.apache.spark.api.java.function.FlatMapFunction;

- import org.apache.spark.api.java.function.Function2;

- import org.apache.spark.api.java.function.PairFunction;

- import org.apache.spark.streaming.Durations;

- import org.apache.spark.streaming.api.java.JavaDStream;

- import org.apache.spark.streaming.api.java.JavaPairDStream;

- import org.apache.spark.streaming.api.java.JavaPairReceiverInputDStream;

- import org.apache.spark.streaming.api.java.JavaStreamingContext;

- import org.apache.spark.streaming.kafka.KafkaUtils;

-

- import scala.Tuple2;

-

- /**

- * 基于Kafka receiver方式的实时wordcount程序

- * @author Administrator

- *

- */

- public class KafkaReceiverWordCount {

-

- public static void main(String[] args) {

- SparkConf conf = new SparkConf()

- .setMaster("local[2]")

- .setAppName("KafkaWordCount");

- JavaStreamingContext jssc = new JavaStreamingContext(conf, Durations.seconds(5));

-

- // 使用KafkaUtils.createStream()方法,创建针对Kafka的输入数据流

- Map

topicThreadMap = new HashMap(); - topicThreadMap.put("MyTestWordCount", 1);

-

- JavaPairReceiverInputDStream

lines = KafkaUtils.createStream( - jssc,

- "172.20.10.117:2181,172.20.10.118:2181,172.20.10.119:2181",

- "DefaultConsumerGroup",

- topicThreadMap);

-

- // 然后开发wordcount逻辑

- JavaDStream

words = lines.flatMap( -

- new FlatMapFunction

, String>() { -

- private static final long serialVersionUID = 1L;

-

- @Override

- public Iterable

call(Tuple2 tuple) - throws Exception {

- return Arrays.asList(tuple._2.split(" "));

- }

-

- });

-

- JavaPairDStream

pairs = words.mapToPair( -

- new PairFunction

() { -

- private static final long serialVersionUID = 1L;

-

- @Override

- public Tuple2

call(String word) - throws Exception {

- return new Tuple2

(word, 1); - }

-

- });

-

- JavaPairDStream

wordCounts = pairs.reduceByKey( -

- new Function2

() { -

- private static final long serialVersionUID = 1L;

-

- @Override

- public Integer call(Integer v1, Integer v2) throws Exception {

- return v1 + v2;

- }

-

- });

-

- wordCounts.print();

-

- jssc.start();

- jssc.awaitTermination();

- jssc.close();

- }

- }

运行步骤及运行结果(java本地运行):

文章最后,给大家推荐一些受欢迎的技术博客链接:

- Hadoop相关技术博客链接

- Spark 核心技术链接

- JAVA相关的深度技术博客链接

- 超全干货--Flink思维导图,花了3周左右编写、校对

- 深入JAVA 的JVM核心原理解决线上各种故障【附案例】

- 请谈谈你对volatile的理解?--最近小李子与面试官的一场“硬核较量”

- 聊聊RPC通信,经常被问到的一道面试题。源码+笔记,包懂

欢迎扫描下方的二维码或 搜索 公众号“10点进修”,我们会有更多、且及时的资料推送给您,欢迎多多交流!

![]()

评论记录:

回复评论: