引言

在当前的人工智能领域,模型的本地部署变得越来越重要,尤其是对于那些对数据隐私和安全有高要求的应用。Ollama平台作为一个强大的工具,支持多种深度学习框架和模型的快速部署。本文将详细介绍如何使用Ollama工具搭建DeepSeek模型,并将其应用于本地环境中(本文演示环境为MacOS Sequoia 15)。

一、为什么选择Ollama?

市面上常用的本地部署大模型工具有llama.cpp、Ollama、vLLM、LM Studio等等,当前主要对比一下流行的4个工具,各自的优缺点如下:

1. llama.cpp:轻量级、纯 CPU 也能运行的 LLM 推理引擎

-

特点

- 由 Georgi Gerganov 开发的一个用 C++ 实现的 LLaMA 模型推理引擎。

- 主要用于本地推理,可以在 CPU 或 GPU 上运行 LLaMA 及其变体以及其他开源大模型。

- 支持 多种硬件平台,包括 Windows、Linux、macOS、Android,甚至树莓派。

- 采用 4-bit、GGUF 量化,大幅减少显存占用,使得在消费级 GPU(如 8GB VRAM)上也能运行大型模型。

-

适用场景

- 适合开发者在本地 轻量级运行 LLM(如 LLaMA)。

- 适用于 边缘设备,如手机或嵌入式设备。

- 适合离线使用,不依赖云端。

-

缺点

- 仅支持 推理,不支持训练模型。

- 不如 vLLM 在 GPU 上的推理速度快(vLLM 使用 PagedAttention)。

- 接口较底层,对新手来说使用门槛较高。

2、Ollama:用户友好的 LLM 本地运行工具,基于 llama.cpp

-

特点

- 封装了 llama.cpp,提供更简洁的 CLI 和 API 接口,让用户更容易在本地运行 LLM。

- 支持模型管理:可以拉取、存储、运行各种 GGUF 格式模型(如 LLaMA 2、Mistral、Gemma)。

- 采用 容器化思路,类似于 Docker,可以使用 Modelfile 进行模型打包和分发。

- 支持 GPU 加速,如果设备支持,Ollama 会自动利用 GPU 运行。

-

适用场景

- 希望本地运行 AI,但不想手动编译 llama.cpp 的用户。

- 开发者和研究人员,用于快速测试和部署 LLM。

- CLI 和 API 友好,适合需要与其他应用集成的场景。

-

缺点

- 仍然依赖 llama.cpp,不如 vLLM 在高性能 GPU 上推理效率高。

- 只支持推理,不支持训练。

- 不支持 LoRA 微调(但可以加载量化后的 LoRA 适配器)。

3、vLLM:高性能 LLM 推理库,专为 GPU 设计

-

特点

- 由 UC Berkeley 研究团队 开发,专注于 超高效的 LLM 推理。

- 核心技术:PagedAttention,能更高效地利用 GPU 显存,支持多用户并发,适合部署大规模 LLM API。

- 兼容 Hugging Face Transformers,可以直接加载 PyTorch 格式的 LLM。

- 支持 分布式推理,可扩展到 多 GPU / 多节点集群。

-

适用场景

- 需要高吞吐量的 AI API 服务(如 Chatbot 或 AI 代理)。

- 云端部署 LLM,尤其是多 GPU 服务器环境。

- 需要 Hugging Face Transformers 兼容性 的场景。

-

缺点

- 不支持 CPU 运行,必须有 GPU。

- 对本地用户不友好,更适合 大规模云端部署。

- 依赖 PyTorch,环境配置可能比 llama.cpp 和 Ollama 更复杂。

4、LM Studio:本地 LLM GUI 应用,适合非技术用户

-

特点

- 基于 llama.cpp,但提供了图形界面(GUI),让用户可以在本地运行 LLM 而无需命令行操作。

- 类似 Ollama,但更偏向桌面端用户(Ollama 偏向 CLI 和 API)。

- 可以下载、管理和运行 GGUF 量化格式的 LLM(如 LLaMA 2、Mistral)。

- 适用于 Windows 和 macOS,并内置 GPU 加速支持。

-

适用场景

- 非技术用户,希望在本地使用 LLM(如写作、问答)。

- 希望使用 GUI 而不是 CLI 的用户。

- 轻量级离线 AI 助手(适合本地 AI 交互)。

-

缺点

- 不适合大规模部署,主要是桌面端应用。

- 相比 vLLM,推理性能较低(仍然基于 llama.cpp)。

- 自定义能力有限,不像 Ollama 那样可以通过 Modelfile 进行扩展。

对比:

| 工具 | 主要用途 | 是否支持 GPU | 主要技术 | 适用人群 | 主要优势 | 主要缺点 |

|---|---|---|---|---|---|---|

| llama.cpp | 轻量级本地推理 | 支持(但优化一般) | C++(GGUF 量化) | 开发者 | 可在 CPU 运行,轻量高效 | API 复杂,需手动编译 |

| Ollama | 方便的本地 LLM 运行工具 | 支持 | Go + llama.cpp | 开发者、普通用户 | 易用,CLI & API 友好,自动管理模型 | 不如 vLLM 快,仅支持 GGUF 格式 |

| vLLM | 高性能 LLM 推理 | 强制需要 GPU | PagedAttention + PyTorch | AI API 提供商 | 极快的 GPU 推理,适合大规模服务 | 不能在 CPU 运行,不支持 GGUF |

| LM Studio | 桌面端 LLM GUI | 支持 | llama.cpp | 普通用户 | GUI 友好,适合离线使用 | 不能大规模部署,性能一般 |

总结:

选择Ollama作为搭建DeepSeek本地模型的工具,主要是基于其用户友好性、易用性和灵活性。以下是选择Ollama的主要原因:

-

用户友好的接口:

Ollama封装了底层的llama.cpp,提供了更简洁的命令行界面(CLI)和应用程序接口(API),降低了使用门槛,使得开发者无需深入了解复杂的底层实现即可快速上手。 -

简化模型管理:

支持多种GGUF格式模型的拉取、存储和运行,包括LLaMA 2、Mistral、Gemma等。这种便捷的模型管理方式特别适合需要频繁切换或测试不同模型的研究人员和开发者。 -

容器化理念的应用:

类似于Docker的概念,Ollama采用Modelfile进行模型打包和分发,这为模型的部署和迁移提供了极大的便利,尤其是在团队协作或生产环境中。 -

自动硬件优化:

如果您的设备支持GPU加速,Ollama能够自动识别并利用GPU资源,提高模型推理速度。这对于希望在本地获得高性能但又不想手动配置硬件加速的用户来说非常实用。 -

适用于多样化的应用场景:

不论是想要快速验证模型效果的开发者,还是希望通过API与其他应用集成的专业人士,Ollama提供的CLI和API都非常适用。它不仅支持技术用户,也为那些寻求简单操作体验的普通用户提供了解决方案。

尽管Ollama依赖于llama.cpp,在某些高性能场景下可能不如vLLM那样高效,但对于大多数本地部署需求而言,尤其是对于那些寻找平衡性能与易用性的用户,Ollama提供了一个理想的解决方案。此外,考虑到它对GGUF格式的支持以及相对简单的环境配置要求,Ollama成为了在macOS环境下部署DeepSeek模型的一个优选工具。

二、下载安装Ollama

1、打开Ollama官网:Ollama

2、点击下载安装即可,安装完成后运行,系统状态栏出现小羊驼图标即运行成功:

三、下载运行DeepSeek大模型

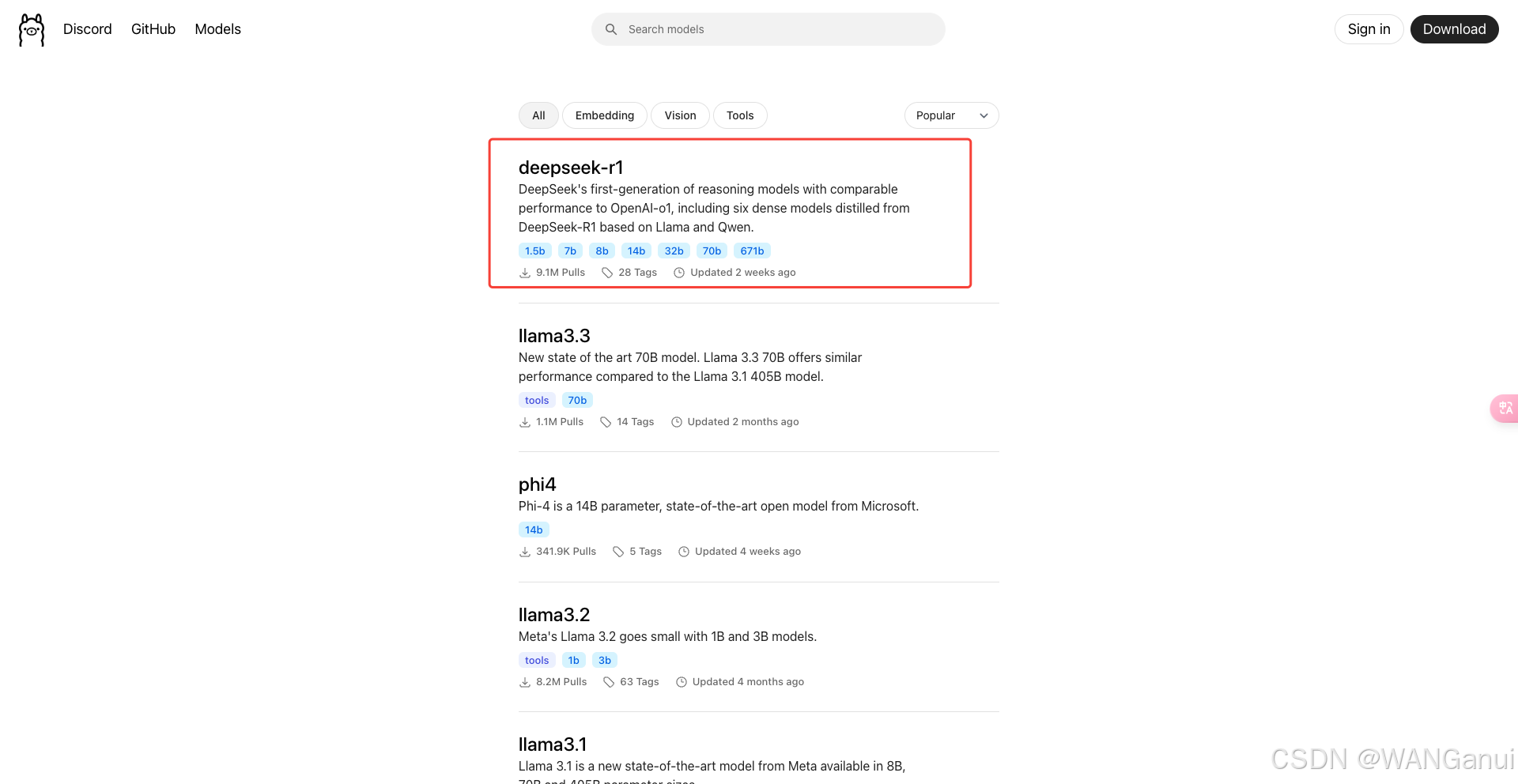

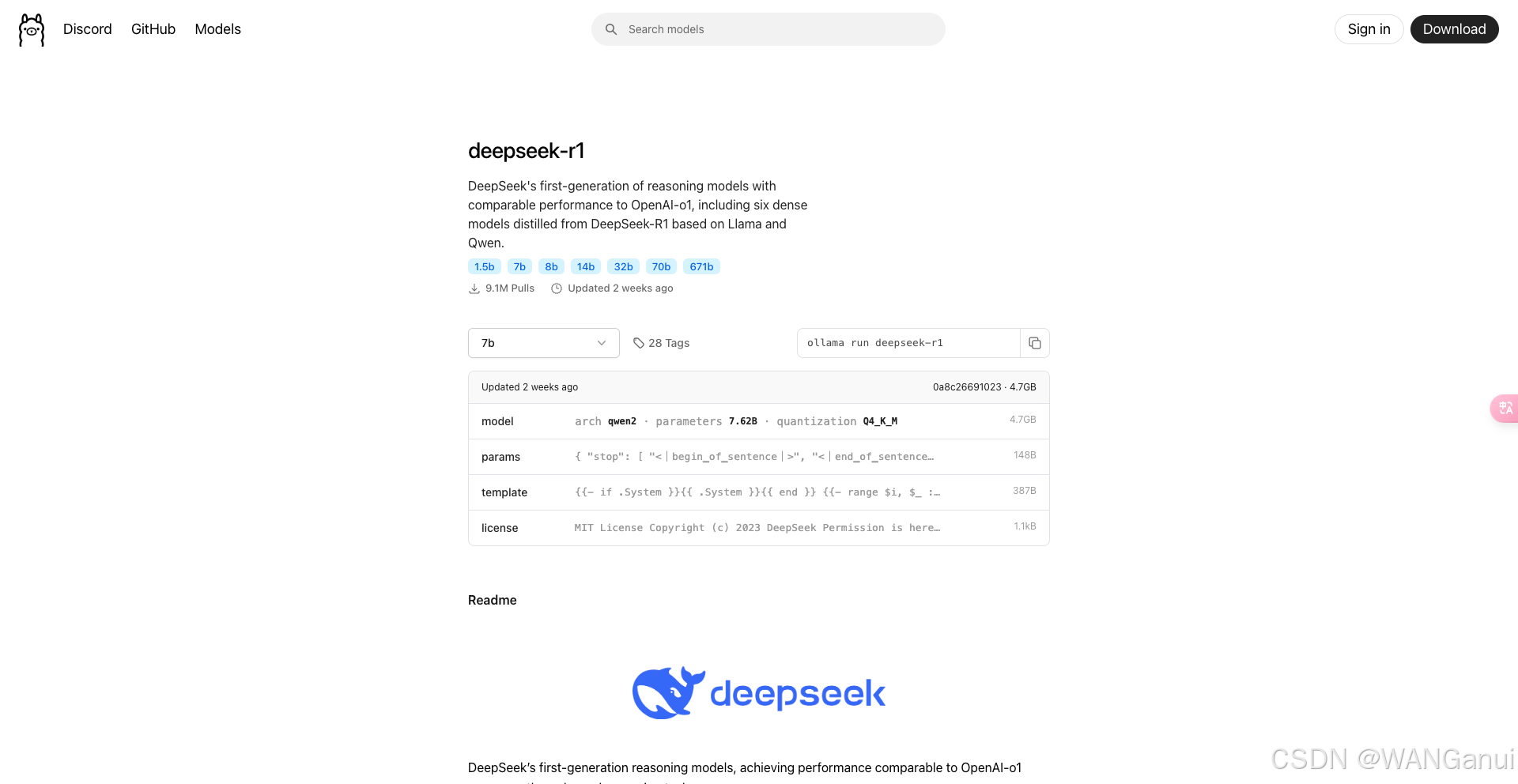

1、打开Ollama官网:Ollama,点击左上角Models,选择或搜索deepseek-r1:

2、这里我们发现了多个不同大小的模型,文件大小适配不同的设备,DeepSeek R1提供多个版本,参数量越大,模型通常越强大,但也需要更多的计算资源。比如1.5B代表有15亿个参数,我们这里根据网上整理的配置推荐选择7B即可。

| 模型大小 | 显卡显存需求 | 推荐显卡示例 | 内存需求 | 备注 |

|---|---|---|---|---|

| 1.5B | ≥4GB | NVIDIA GTX 1050 或集成显卡 | ≥8GB | 日常办公电脑也能轻松运行 |

| 7B | ≥6GB | GTX 1660, RTX 3050 | ≥16GB | GGML/GGUF格式需约4GB空闲内存 |

| 8B | 8-10GB | GTX 1660及以上 | ≥16GB | 运行流畅,体验感满分 |

| 14B | ≥12GB(推荐16GB) | RTX 3060及以上 | ≥32GB | 更流畅建议使用16GB显存 |

| 32B | ≥16GB | RTX 3060及以上 | 接近20GB,建议≥64GB | GGML格式需求大系统内存 |

| 70B | ≥40GB | RTX 3090, RTX 4090 | ≥64GB(推荐128GB) | 对于GGML等基于CPU推理的格式或GPU和CPU结合推理 |

| 671B | ≥1342GB | 需多GPU协作,如16张NVIDIA A100 80GB | ≥64GB至128GB更稳妥 | 适合专业科研机构或超级计算机 |

3、直接复制以下命令终端运行

⚠️ ollama的命令类似于docker,可输入ollama -h查看使用提示

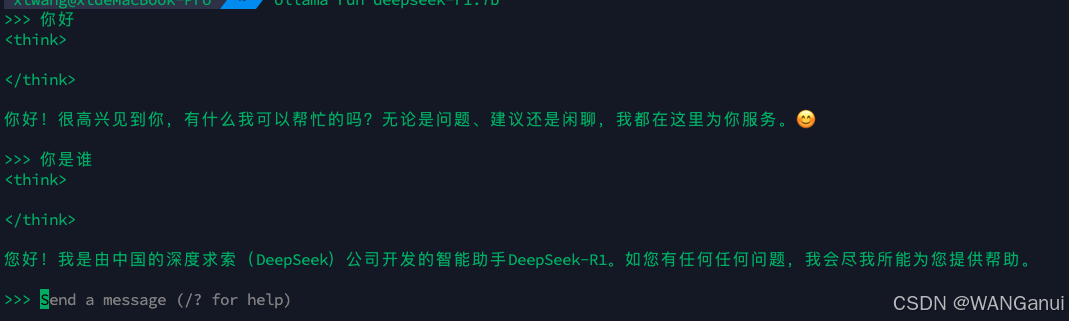

ollama run deepseek-r1:7b等待下载完成后如下所示即安装完成

输入任意问题测试是否正常运行:

当前在命令行中使用还是差强人意,下面给大家介绍两款更方便的使用工具。

四、Chatbox工具使用大模型

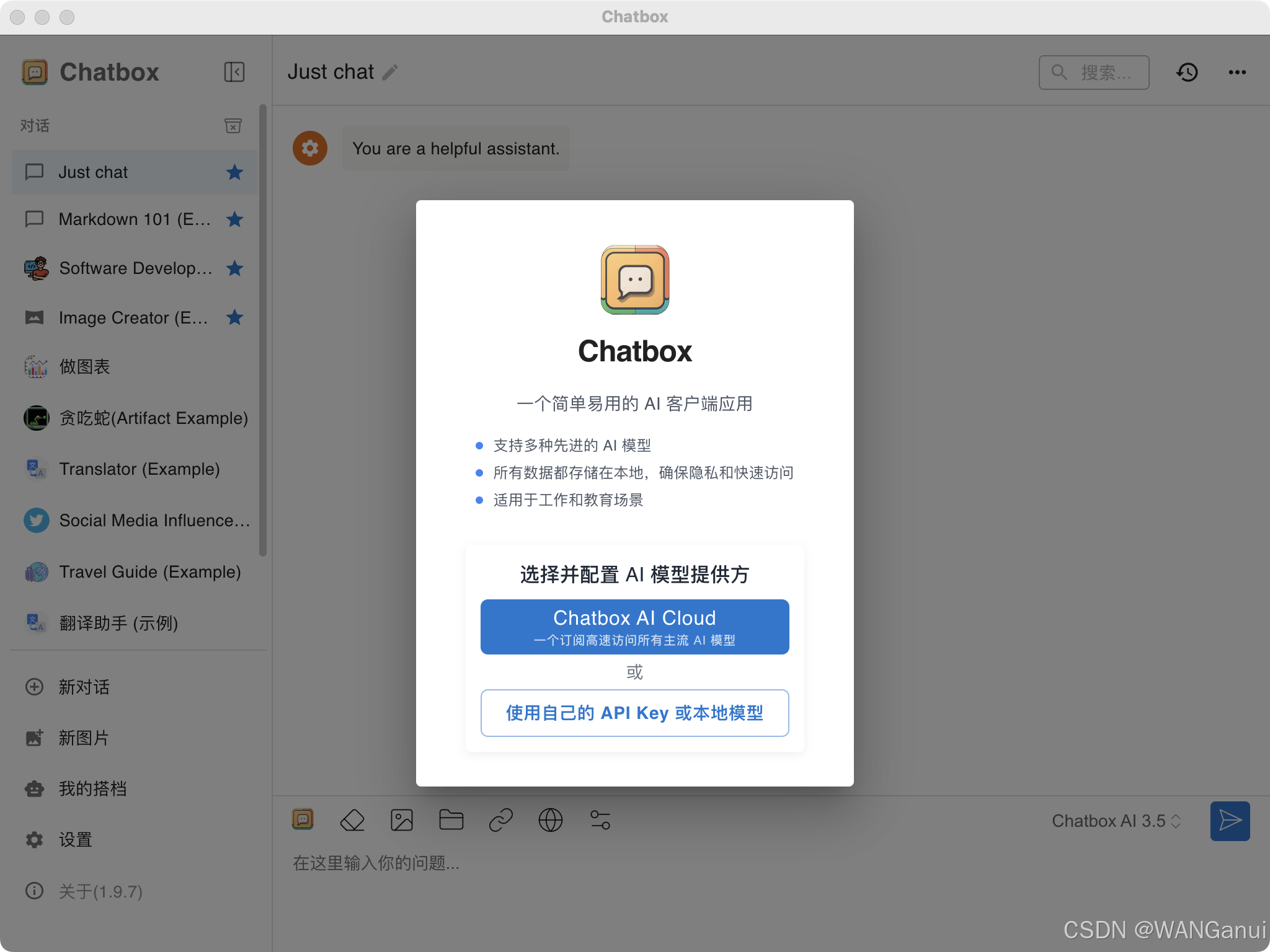

1、打开Chatbox官网:Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载,可以选择网页端或者客户端,这里我们使用客户端,点击下载安装并运行

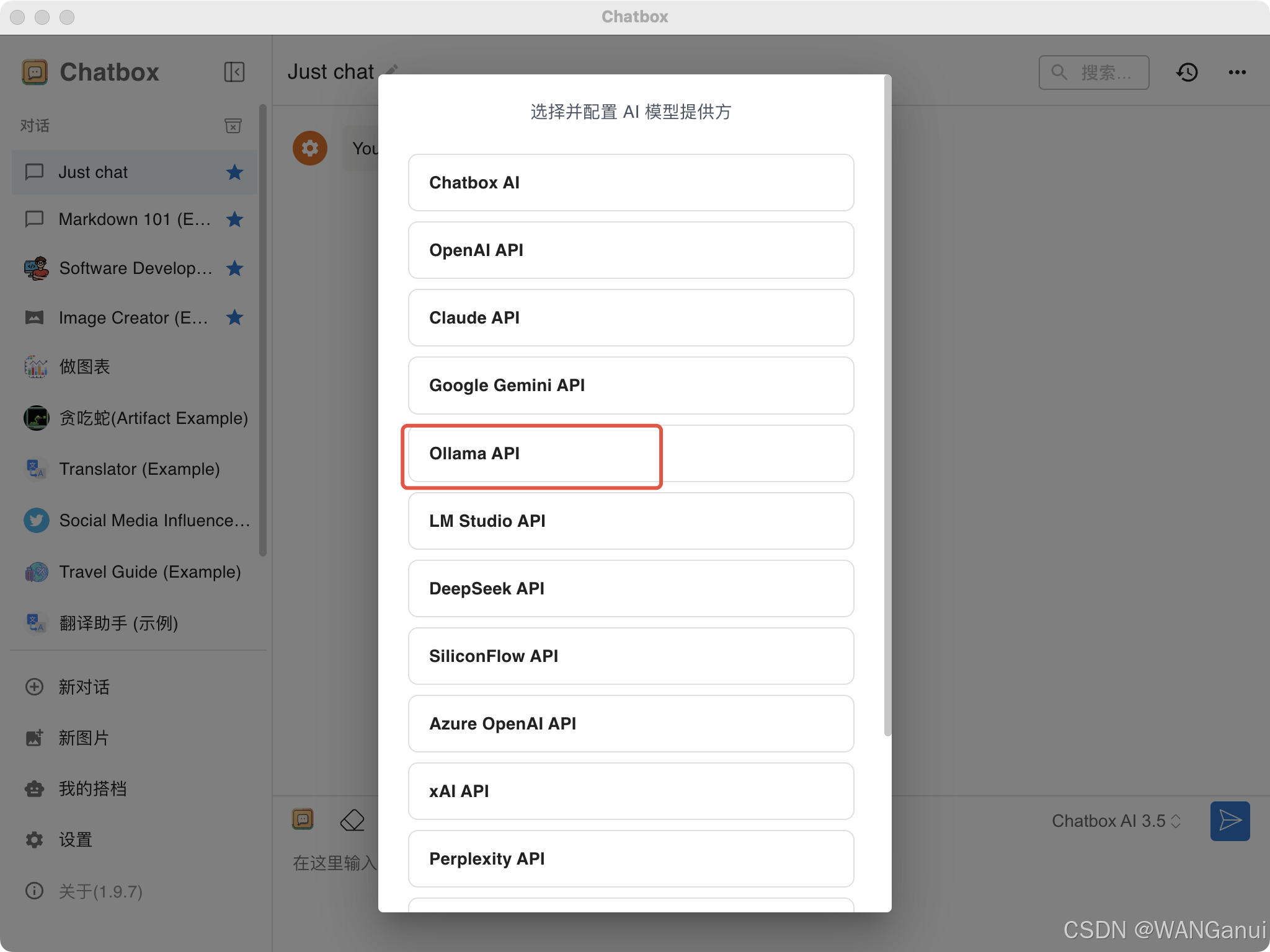

选择使用自己的API Key或本地模型,然后选择Ollama API

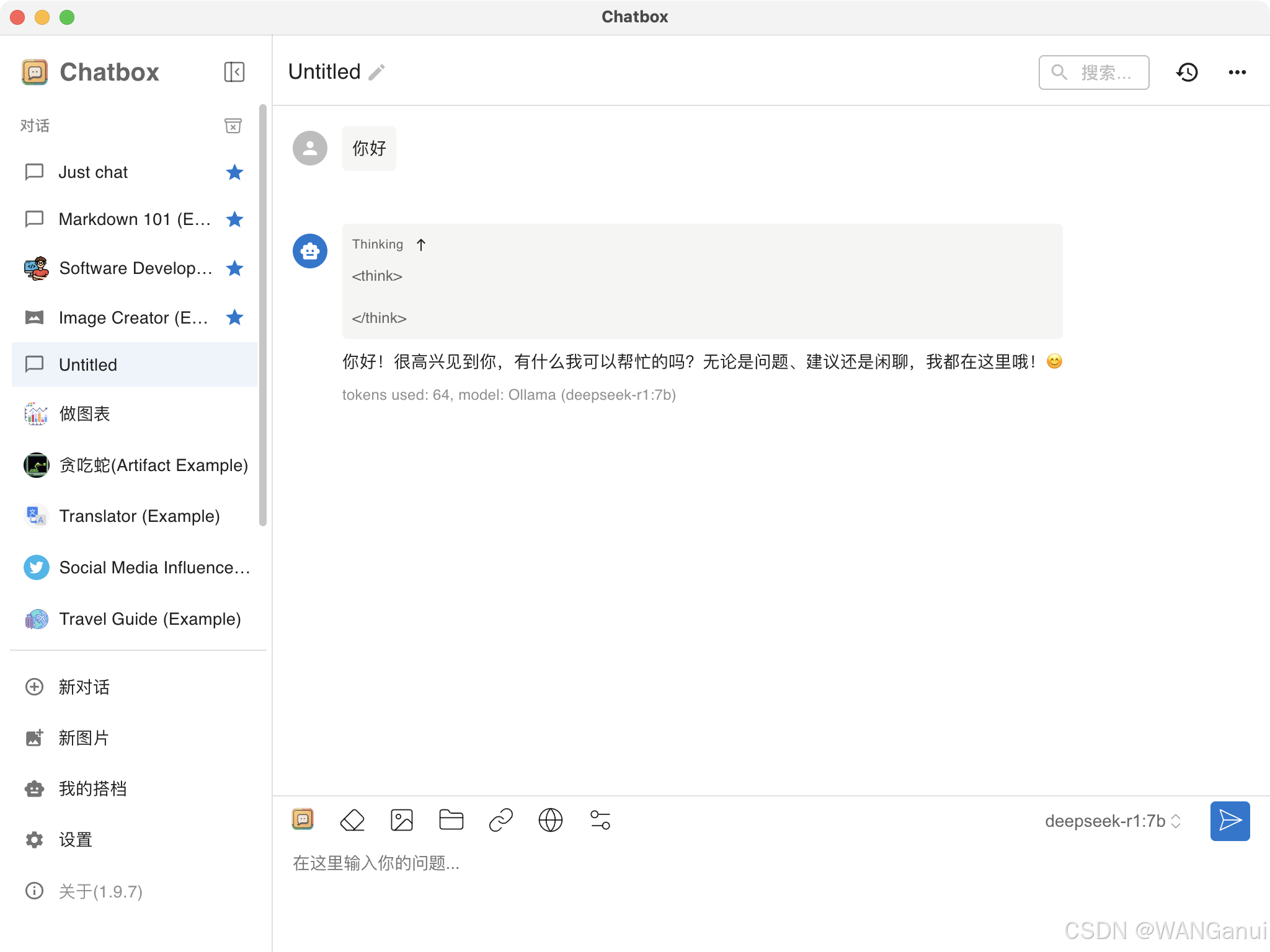

选择deepseek-r1模型,其他的按照推荐配置,点击保存后就可以使用了:

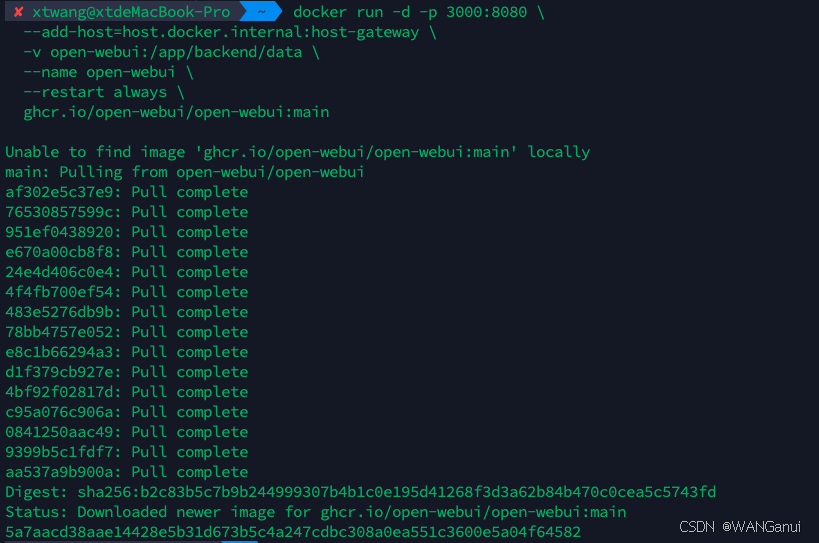

五、Open WebUI使用大模型

针对docker用户,使用Open WebUI会是一个不错的选择,首先前置条件必须已安装docker环境,运行以下命令拉取并运行Open WebUI

- docker run -d -p 3000:8080 \

- --add-host=host.docker.internal:host-gateway \

- -v open-webui:/app/backend/data \

- --name open-webui \

- --restart always \

- ghcr.io/open-webui/open-webui:main

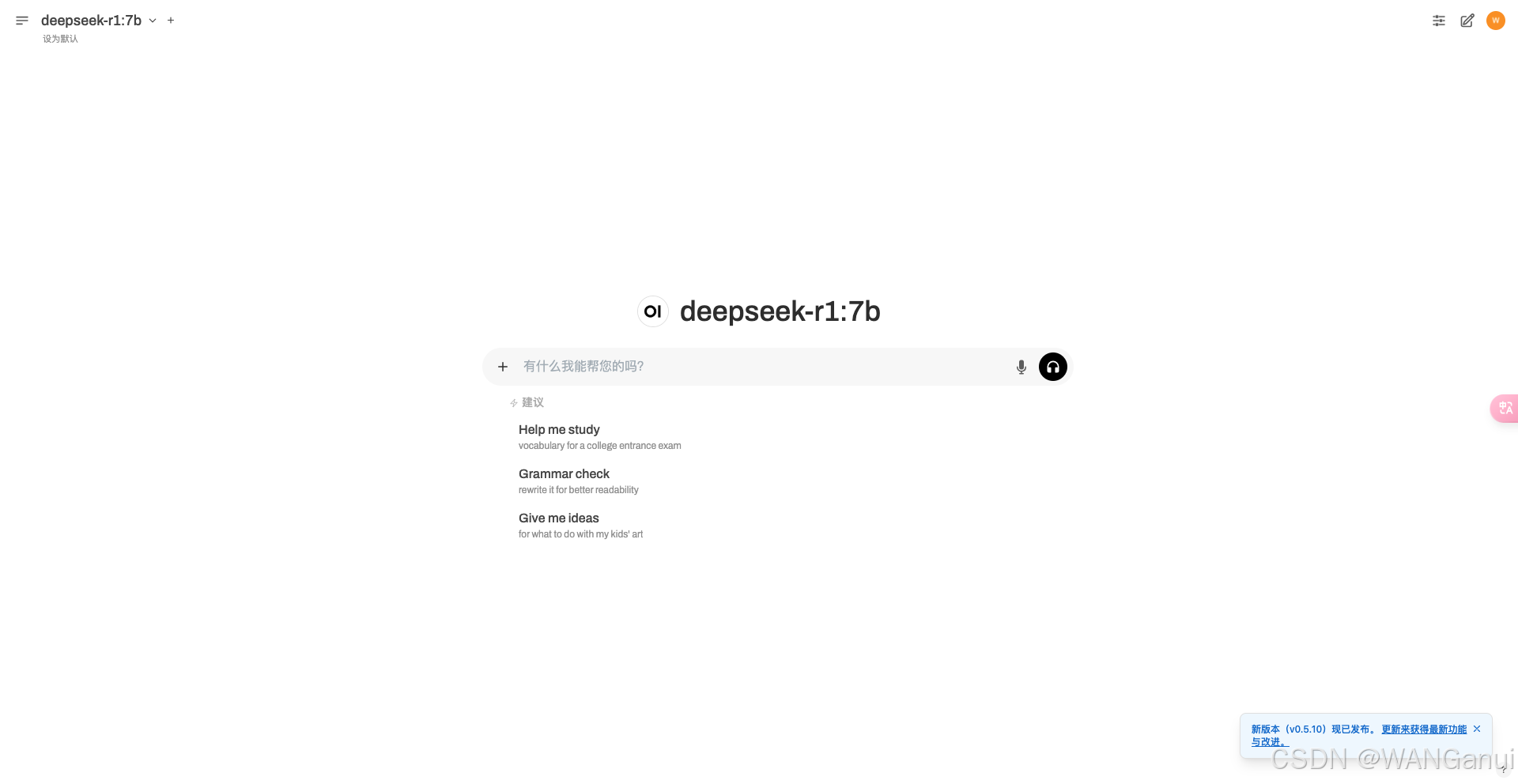

安装完成后docker ps 检查容器是否正常运行,然后访问本地 http://127.0.0.1:3000,出现下列画面即可使用

六、结论

通过上述步骤,您应该能够在macOS系统上成功部署DeepSeek模型,并利用其强大的功能满足特定业务需求。希望这篇指南能为您提供有价值的帮助,让您在探索人工智能技术的道路上更加顺利。

参考资料

- Ollama官方文档: https://www.ollama.com/docs

- DeepSeek官网:DeepSeek

- 工具介绍原文参考:Deepseek本地部署指南:五大工具详解与Ollama实践|AI模型本地运行最佳实践

请注意,文中提到的链接和命令行示例是基于当前上下文构造的。根据实际情况,可能需要访问最新的官方文档以获得准确的信息。

评论记录:

回复评论: