小编声明:文中描述内容,为小编自学的个人理解,仅供参考,希望大家学习时辅助权威资料。

-------------------------------------------------------------------

前言:了解操作目标

AI(人工智能Artificial Intelligence)作为人类的辅助大脑,可以帮我们做很多工作,而AI是怎么能替我们思考的呢,是因为通过分析大量的数据,总结了人类的思考思路,然后模拟人类思考模式,从而对人类的问题给出解决方案,而这个通过大量数据总结出来的结果,就可以理解为是所谓的“大语言模型”,不同的数据范围,不同的分析方法及技术,就有各种各样不同的“大语言模型”,ollama就是帮助我们管理和使用这些大语言模型的工具。网络的解释是这样:

Ollama是一个开源的大型语言模型服务工具,用于简化在本地运行大语言模型的过程,帮助用户快速在本地运行、管理和部署大型语言模型。

下面进入主题,如何部署ollama。

部署ollama。

下载软件

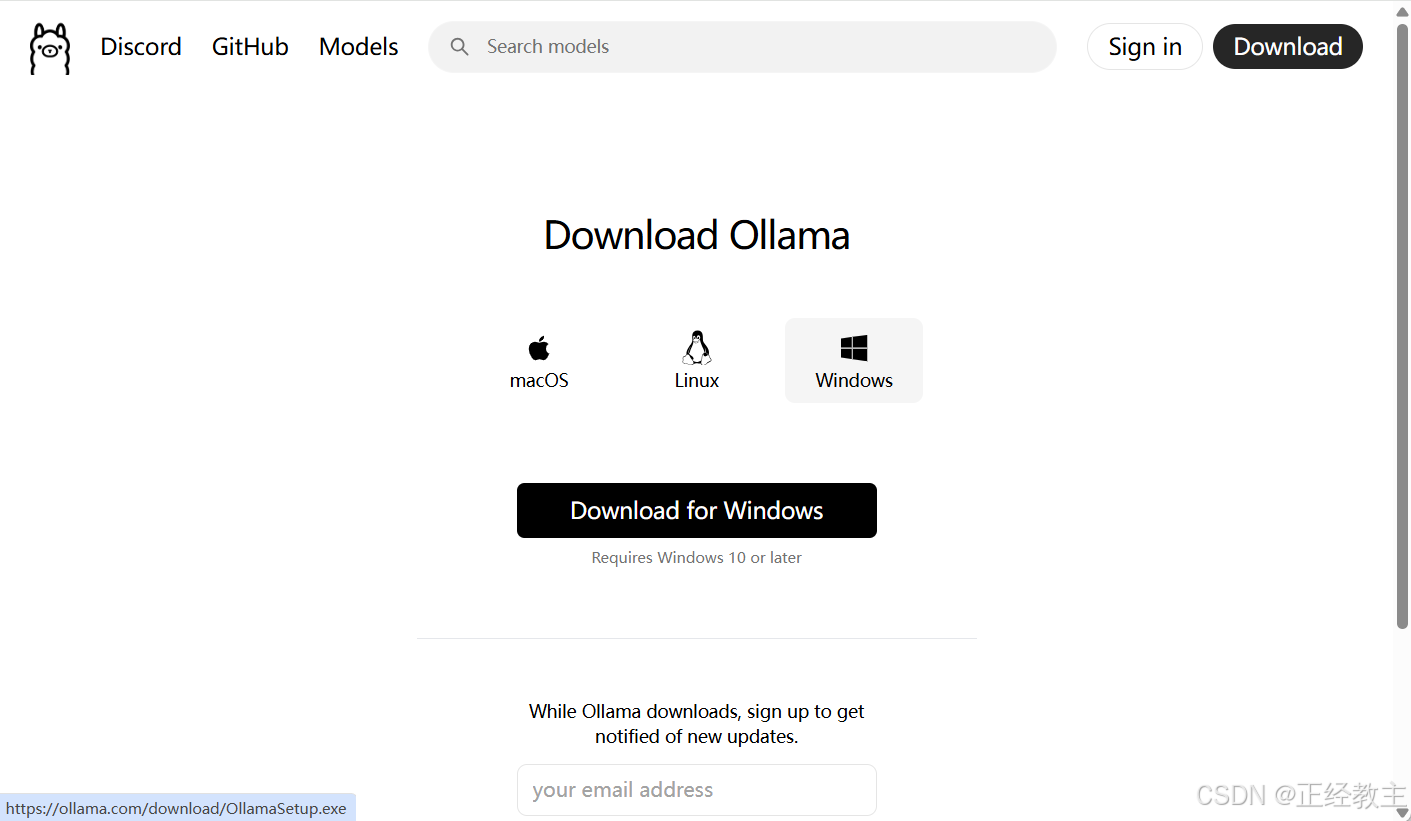

进入Ollama官网点击下载:Ollama

如果没有响应,可能是网络阻塞,会弹出一个空白的新页面,拷贝页面地址,是一个下载地址,用迅雷等下载即可:

https://github.com/ollama/ollama/releases/latest/download/OllamaSetup.exe

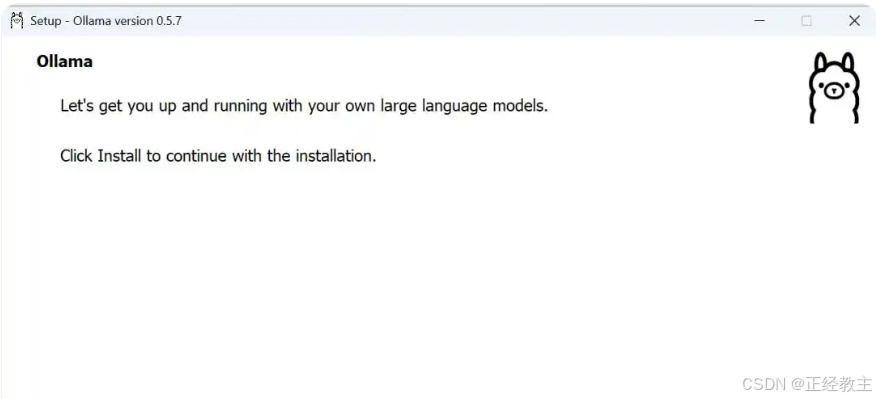

安装ollama

下载结束后,双击安装文件,点击「Install」开始安装。

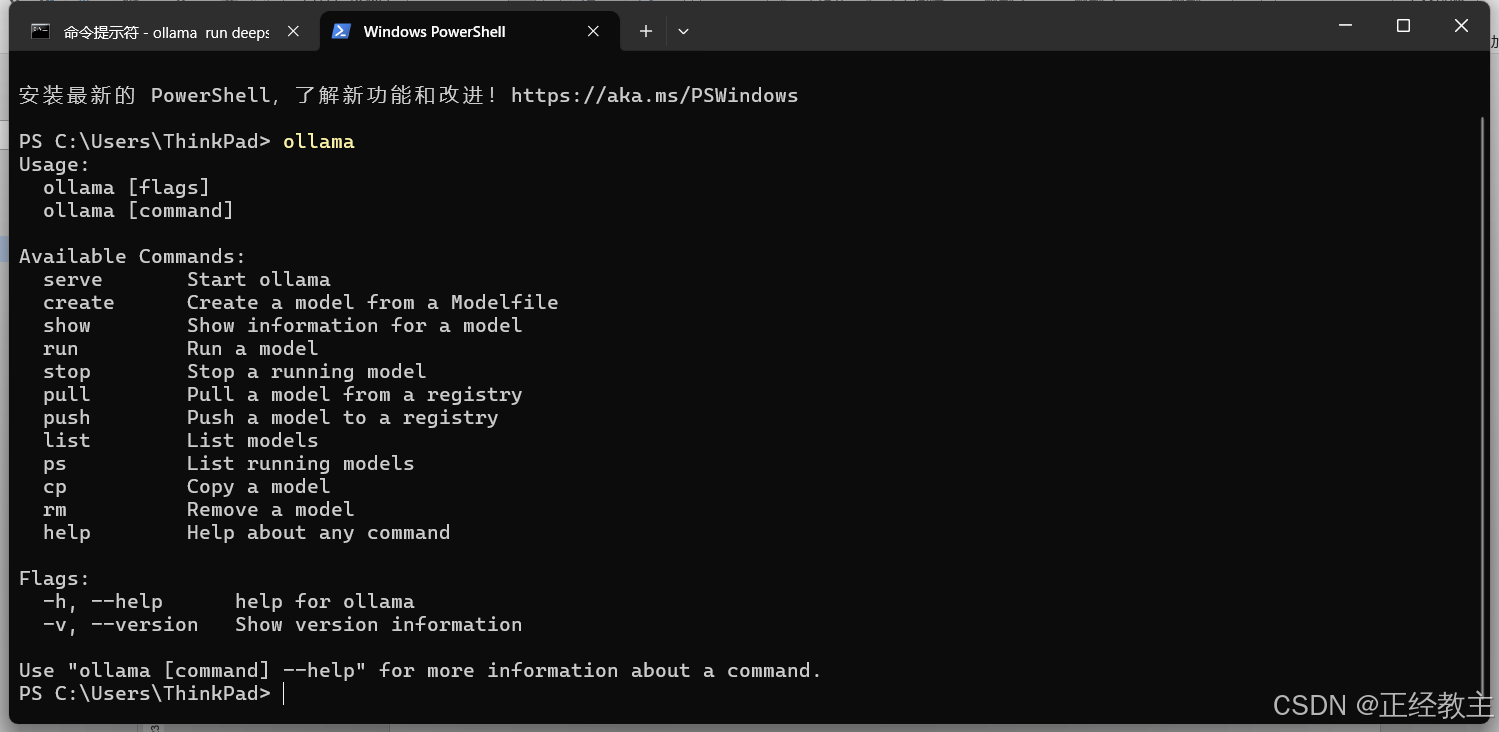

在cmd中,执行ollama,如果有如下反馈,表示安装成功

启动和关闭ollama

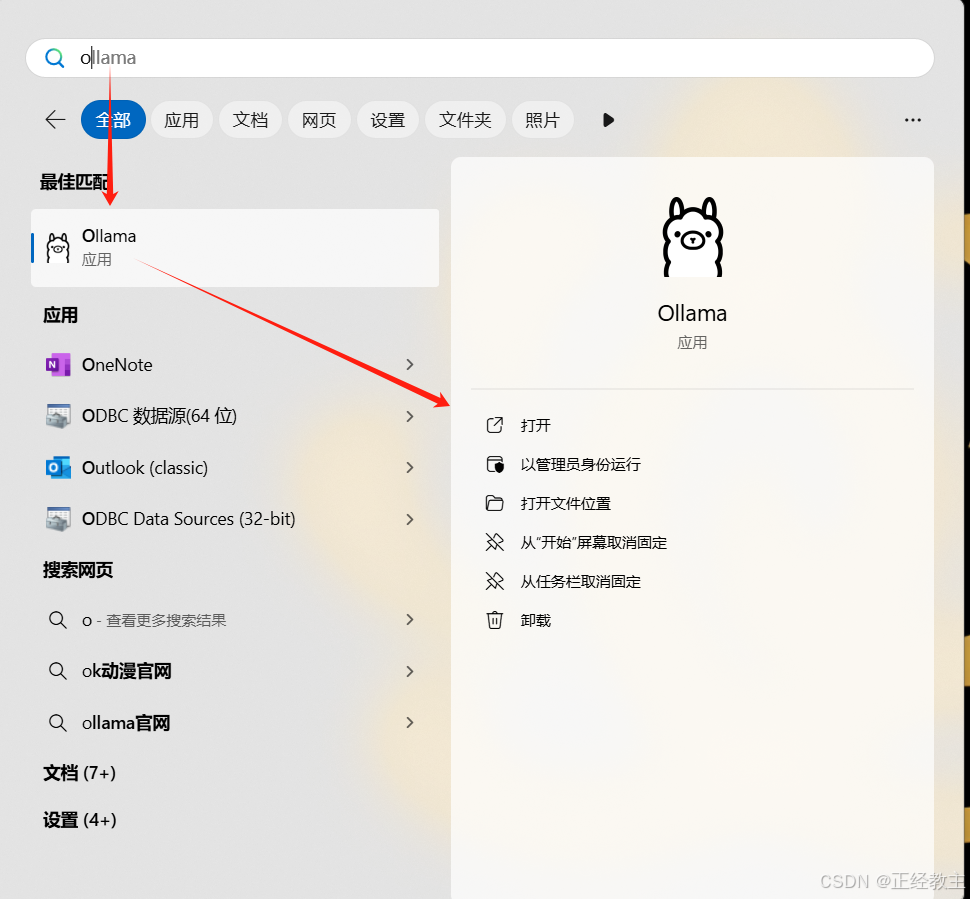

和其他软件启动一样,在开始菜单,找到ollama,打开即可:

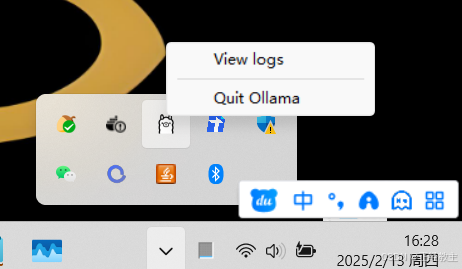

ollama运行后,在任务栏会有ollama图标,右键图标,会出现关闭的按钮「Quit Ollama」,点击即可关闭ollama。

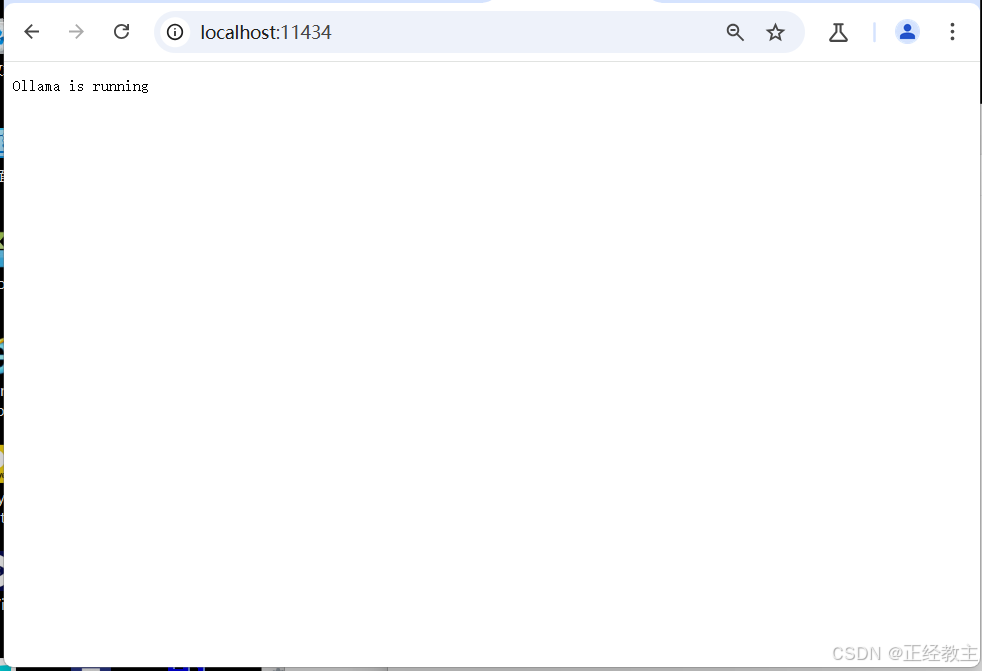

检测ollama运行的另一种方式

在浏览器中,访问本机及ollama端口,http://localhost:11434/,会显示ollama的运行状态:

其他

1、修改ollama的模型数据存在路径:

目前的Ollama会默认安装到C盘,路径如下:C:\Users%username%\AppData\Local\Programs\Ollama,并不会让用户自定义选择安装路径(安装后,可通过配置参数修改安装路径)。这样一来,ollama安装模型,如果很大,会占用C盘空间,影响系统运行速度,通过设置环境变量,来改变ollama放目录的地址。

ollama环境变量配置:修改ollama的数据路径(安装路径)-CSDN博客

2、取消ollama的自启动设置,减少不必要的资源占用:

解决ollama自动启动的问题_ollama自启动-CSDN博客

3、通过配置环境变量,解决ollama 只能本机访问,不能共享访问的问题:

解决Ollama只能本地访问的问题(windows系统)_ollama设置仅本地访问-CSDN博客

参考资料

Ollama常用命令(来自百度AI)

- 启动Ollama服务:使用命令

ollama serve,这将启动Ollama服务器,以便运行模型和处理请求。 - 创建模型:使用

ollama create [Modelfile路径],从模型文件创建新模型。 - 显示模型信息:使用

ollama show,查看特定模型的详细信息。 - 运行模型:使用

ollama run [模型名称],启动并运行所选模型。 - 从注册表拉取模型:使用

ollama pull [模型名称],从注册表中拉取模型到本地使用。 - 推送模型到注册表:使用

ollama push [模型名称],将本地模型推送到注册表中,以便他人或其他系统使用。 - 列出所有模型:使用

ollama list,列出本地所有可用的模型。 - 复制模型:使用

ollama cp [原模型名称] [新模型名称],复制一个模型到另一个位置或给定名称的地方。 - 删除模型:使用

ollama rm [模型名称],删除一个已安装的模型。 - 显示帮助信息:使用

ollama help或ollama --help,获取Ollama命令或具体命令的帮助信息。 - 查看版本信息:使用

ollama --version,显示当前Ollama工具的版本信息。

评论记录:

回复评论: