表情识别

面部情绪识别(FER)是指根据面部表情识别和分类人类情绪的过程。通过分析面部特征和模式,机器可以对一个人的情绪状态作出有根据的推断。这个面部识别的子领域高度跨学科,涉及计算机视觉、机器学习和心理学等领域的知识。

应用领域

以下是一些关键领域,其中这项技术可能有所帮助:

社交和内容创作平台:

根据情感反馈个性化用户体验。

自适应学习系统根据学习者的情绪状态调整内容,提供更具针对性的建议。

医疗研究:

监测患者是否存在抑郁、焦虑或其他情绪障碍的迹象。

协助治疗师在治疗过程中跟踪患者的进展或反应。

实时监测应激水平。

驾驶员安全机制:

监测驾驶员是否出现疲劳、注意力分散、压力或昏昏欲睡的迹象。

营销和市场研究:

实时分析观众对广告的反应。

根据观众的情绪状态定制广告内容。

产品测试和反馈。

安全和监控:

在拥挤区域检测可疑或异常行为。

分析公共事件中人群的反应,以确保安全。

构建面部情绪识别系统

本节深入探讨构建面部情绪识别系统的复杂性。我们首先探讨一个专门为面部情绪识别设计的数据集,确保我们的模型有稳健的基础。接下来,我们将介绍一种自定义的VGG13模型架构,该架构以其在分类任务中的效率和准确性而闻名,并阐明其与我们情绪识别目标的相关性。

最后,我们花费一些时间在实验结果部分,提供全面的评估,阐明系统的性能指标及其潜在应用。

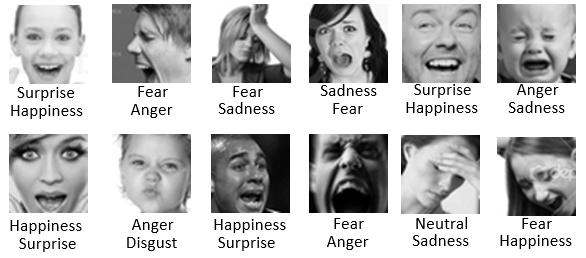

面部情绪识别数据集(FER +)

FER + 数据集是原始面部表情识别(FER)数据集的一个重要扩展。为了改进原始数据集的局限性,FER + 提供了更精细和细致的面部表情标签。虽然原始FER数据集将面部表情分类为六种基本情绪——快乐、悲伤、愤怒、惊讶、恐惧和厌恶——但FER + 根据这一基础更进一步引入了两个额外的类别:中性和蔑视。

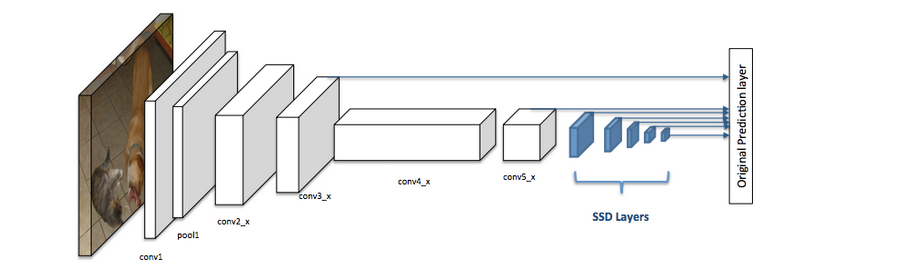

用于人脸检测的RFB-320

Single Shot Multibox Detector (SSD)模型 在识别情绪之前,需要在输入帧中检测人脸。为此,使用了超轻量级人脸检测模型RFB-320。它是一种针对边缘计算设备进行优化的创新人脸检测模型。该模型采用了改进的感受野块(RFB)模块,在不增加计算负担的情况下有效地捕捉多尺度的上下文信息。它在多样化的WIDER FACE数据集上进行训练,并针对320×240的输入分辨率进行优化,具有出色的效率平衡,计算速度为0.2106 GFLOPs,参数量仅为0.3004百万个。该模型基于PyTorch框架开发,取得了令人称赞的平均精度(mAP)为84.78%,在资源受限环境中成为高效人脸检测的强大解决方案。在此实现中,RFB-320 SSD模型以Caffe格式使用。

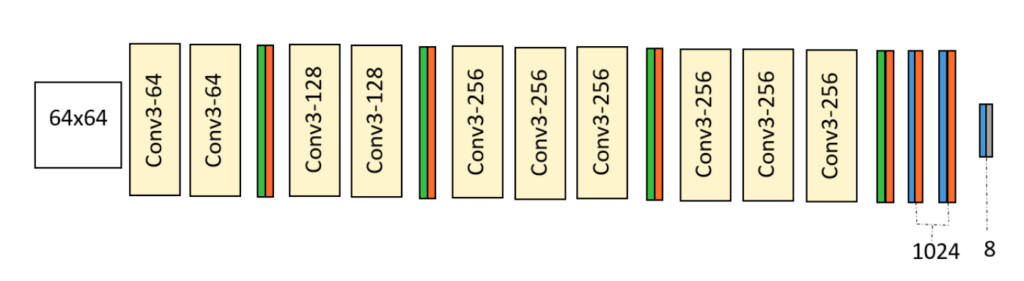

自定义的VGG13模型架构

情绪识别分类模型采用了定制的VGG13架构,专为64×64灰度图像设计。它使用具有最大池化和dropout的卷积层将图像分类为八个情绪类别,以防止过拟合。该架构开始于两个具有64个卷积核的卷积层,然后是最大池化和25%的dropout。额外的卷积层捕捉复杂的特征,两个具有1024个节点的密集层聚合信息,然后是50%的dropout。一个softmax输出层预测情绪类别。

让我们编写一些代码来实现这个系统。

首先,需要初始化一些重要的参数。

image_mean = np.array([127, 127, 127])

image_std = 128.0

iou_threshold = 0.3

center_variance = 0.1

size_variance = 0.2

min_boxes = [

[10.0, 16.0, 24.0],

[32.0, 48.0],

[64.0, 96.0],

[128.0, 192.0, 256.0]

]

strides = [8.0, 16.0, 32.0, 64.0]

threshold = 0.5

class="hljs-button signin" data-title="登录后复制" data-report-click="{"spm":"1001.2101.3001.4334"}">

class="blog_extension_card_cont">

class="blog_extension_card_cont">

评论记录:

回复评论: