前言

本文介绍使用雷达与多视角相机融合,实现3D目标检测、3D目标跟踪、道路环境BEV分割,它是来自ICCV2023的。

会讲解论文整体思路、输入数据分析、模型框架、设计理念、损失函数等。

论文地址:CRN: Camera Radar Net for Accurate, Robust, Efficient 3D Perception

代码地址:https://github.com/youngskkim/CRN

1、模型框架

CRN,全称是Camera Radar Net,是一个多视角相机-雷达融合框架。

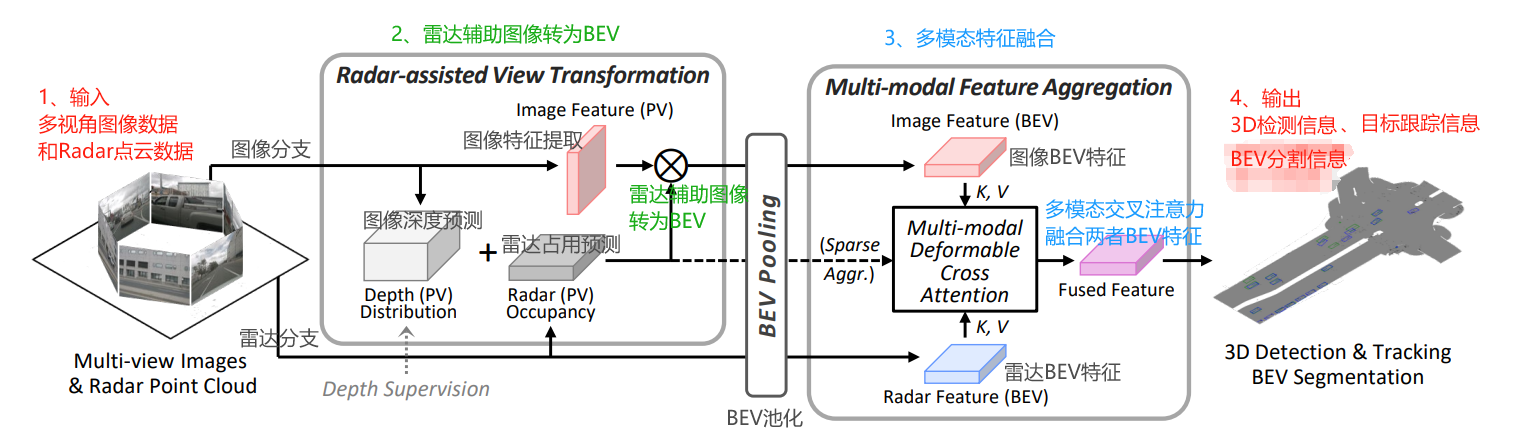

通过融合多视角相机和雷达的特性,生成语义丰富且空间精确的BEV特征图。实现3D物体检测、跟踪和BEV分割任务。CRN的框架图,如下图所示:

框架的思路流程:

- 输入数据:多视角图像数据、Radar雷达点云数据。

- 主要分为两个分支,图像分支、和雷达分支。

- 图像分支中,进行图像特征提取;同时需要深度预测,预测每个图像特征的深度距离。

- 雷达分支中,进行雷达点云特征提取;然后雷达占用预测,提供存在物体的距离信息。

- 结合图像特征和深度信息,以及雷达占用信息,将图像特征点由2D转为3D。雷达占用特征的距离信息,是很准确的,可以修正图像深度的误差。

- BEV池化,将3D图像特征转为“图像BEV特征”;将雷达特征转为“雷达BEV特征”。

- 通过多模态交叉注意力,融合图像BEV和雷达BEV特征,得到融合两个模态的BEV特征。融合后的BEV特征,后面接检测、跟踪和分割任务头。

- 输出信息:3D检测信息、目标跟踪信息、BEV分割信息。

2、关键贡献点

1)摄像头和雷达数据的融合

- CRN利用了摄像头和雷达传感器的互补优势。

- 摄像头提供高分辨率的丰富环境信息,但在恶劣天气条件和光照不足时表现不佳。

- 相比之下,雷达传感器提供精确的远程测量,且在所有环境条件下都能可靠工作,但缺乏摄像头提供的空间细节。

- 通过融合这两种模式,CRN旨在创建不同环境条件下都能有效操作的强大感知系统。

2)语义空间准确性

- 该框架生成了一个既包含丰富语义信息,又空间准确的鸟瞰图(BEV)特征图。

- 这是特别具有挑战性的,因为摄像头提供的图像是透视视图,缺乏直接的空间信息,这对于BEV表示是必需的。

- CRN通过使用雷达点提供精确的空间上下文,将透视图像特征转换为BEV来解决这个问题。

3)多模态可变形注意力

- 为了解决摄像头图像和雷达数据之间固有的空间错位,CRN采用多模态可变形注意力机制。

- 这允许系统动态地关注来自两种模式的相关特征,尽管它们的性质和表示方式不同,也能有效地整合它们。

4)性能和效率

- CRN通过实时处理(20 FPS)证明了其有效性,并在nuScenes数据集上达到了与基于LiDAR探测器相当的性能。

- 值得注意的是,它甚至在长距离(100m设置)检测对象方面超过了这些LiDAR方法。这一点非常重要,因为LiDAR虽然准确,但比摄像头和雷达系统要贵得多。

论文背景

- 在许多应用中,如自动驾驶和移动机器人,准确且稳健的3D感知系统至关重要。

- 为了实现高效的3D感知,可以从传感器输入获取可靠的BEV特征图,因为各种下游任务可以在BEV空间上实现。例如,物体检测和追踪、BEV分割、地图生成、轨迹预测和运动规划。

- BEV提供了一个从上而下的视角,对于执行如物体检测、轨迹预测和运动规划等任务至关重要,因为它简化了复杂的空间关系并使得物体的位置和运动更容易理解和预测。

- 3D感知系统需要识别道路上的语义信息,如交通灯、路标,这可以通过摄像头轻松利用。除了丰富的语义信息需求外,检测远距离物体也至关重要,雷达可以在这方面提供帮助。

- 最近,基于摄像头的BEV中的3D感知引起了较大关注。得益于密集图像像素中的丰富语义信息,摄像头方法可以即使在远距离也区分物体。

- 尽管摄像头具有优势,但从单目图像中定位物体的准确位置,自然是一个具有挑战性的不适定问题。此外,由于被动传感器的特性,摄像头可以受到照明条件的显著影响,如眩光、低对比度或低照明。

- 为了解决这个问题,使用多视角摄像头和雷达来生成BEV特征图。

3、核心内容——RVT雷达辅助视图转换

雷达辅助视图转换(Radar-assisted View Transformation, RVT),是CRN的一个核心组成部分,它利用雷达测量帮助将“透视视图”中的图像上下文特征转换为“BEV特征图”。

- 简介:图像特征转换到BEV中,通过RVT将这过程不完全依赖于图像估计的深度,同时借助雷达信息。RTV是一种创新的方法,它通过结合图像特征和深度分布,以及雷达特征和雷达占用信息来改善视图转换过程。

- 目的:从周围环境的图像中提取特征,并利用雷达测量来提高这些特征在空间上的准确性,即从透视图像特征转换到BEV特征时。

- 作用:这种转换可以从密集但不太准确的深度分布,和稀疏但准确的雷达占用中受益,以获得空间上准确的图像上下文特征。

- 优点:雷达辅助视图转换,它克服了仅依赖图像深度估计的限制。这种方法利用雷达数据的长距离感知能力和高精度,为图像特征提供了空间上的精确校正。

雷达辅助视图转换过程,主要分为两点:

1、图像特征编码和深度分布

- 图像特征编码:通过图像主干网络(如ResNet、ConvNeXt)配合特征金字塔网络FPN,获取每个图像视角的16倍下采样的特征图。

- 深度分布:随后,通过额外的卷积层进一步提取每个像素的图像上下文特征,和深度分布。

2、雷达特征编码和雷达占用预测。

-

投影雷达点:首先,将雷达点投影到相机的视角,找到雷达点在图像上对应的像素位置。这一步骤保留了雷达点的深度信息,即物体距离相机的距离。

-

体素化:然后,将这些带有深度信息的图像像素转换为体素(三维像素),这一过程在创建一个三维空间的表征中非常关键,尤其是转换到BEV表示时。

-

特征转换:通过上述步骤,可以利用雷达的深度信息来指导图像特征在三维空间中的正确位置,从而实现从透视视图到BEV的精确转换。

尽管雷达数据可能包含噪声,但RVT技术正是利用了雷达在测量距离方面的准确性,来改善和优化视图转换过程,使得最终生成的BEV特征更加精确和有用。

4、深入理解——视图转换和融合BEV

公式版理解——视锥体视图转换

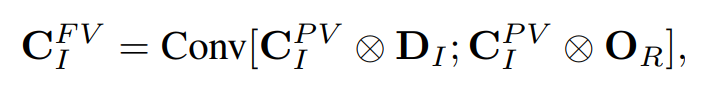

在视锥体视图转换中,考虑了图像的深度分布 和雷达的占用信息

和雷达的占用信息 。思路流程:

。思路流程:

- 首先每个像素的图像上下文特征

与其相应的深度分布

与其相应的深度分布 进行外积。该外积为每个像素的特征赋予了深度,从而将2D图像数据扩展到3D空间。

进行外积。该外积为每个像素的特征赋予了深度,从而将2D图像数据扩展到3D空间。 - 然后每个像素的图像上下文特征

与雷达占用

与雷达占用 进行外积。该外积使得雷达数据来验证或修正通过图像得到的深度估计。

进行外积。该外积使得雷达数据来验证或修正通过图像得到的深度估计。 - 最后将两者结果,在通道维度的拼接操作,形成视图特征

。

。

图像上下文特征图 通过以上操作,转换为相机视锥体视图特征

通过以上操作,转换为相机视锥体视图特征

其中,;表示沿着通道维度的拼接操作。⊗表示外积。

- 这个公式可以理解为:从相机视角看到的场景的深度,和物体是否存在的雷达检测信息。

- 由于雷达不提供高度信息,因此通过沿着高度轴进行求和来简化(或压缩)图像上下文特征,这样可以节省内存。

- 这个转换过程将2D特征映射到3D空间,但不是简单地将它们“拉升”,而是考虑了雷达的准确距离信息。

公式版理解——融合为BEV特征

在获得了多个相机视锥体视图的特征之后,包括 和

和 ,需要将它们合并到单一的BEV空间中。

,需要将它们合并到单一的BEV空间中。

为了实现这一转换,使用了支持CUDA的Voxel Pooling技术,并对其进行了修改,以便使用平均池化而不是求和来聚合每个BEV网格内的特征。

这样做有助于网络预测与自车距离无关的更一致的BEV特征图,因为近距离的BEV网格将关联更多的视锥体网格,这是由于透视投影的特性。

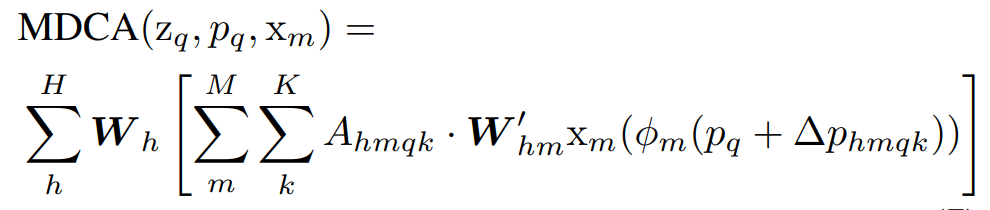

5、MFA 多模态特征聚合

MFA,全称是Multi-modal Feature Aggregation,表示多模态特征聚合。它是基于多模态可变形交叉注意力MDCA实现的,即Multi-modal Deformable Cross Attention。

- 在通过RVT转换特征之后,CRN使用MFA来适应性地聚合图像和雷达特征图,生成既丰富语义又空间精确的BEV表示。

- 这个步骤是为了解决在融合过程中可能出现的特征错位问题,并确保从两种不同模态中提取的信息能够有效地结合起来,增强系统对环境的理解能力。

- 由于转换到BEV中的图像特征不完全准确,接下来的多模态特征聚合MFA层,使用注意力机制将多模态特征图编码到统一的特征图中。

- 通过MFA层的引入,CRN能够有效地处理来自不同传感器的信息,解决了空间错位问题。注意力机制的使用进一步提高了特征融合的准确性,使得系统能够在处理复杂场景时更加灵活和动态。

作者设计的MDCA是一种特别适合于多模态融合的注意力机制。

- 它可以适应性地处理不同模态之间的特征,这样可以更好地结合它们的优势。

- 在MDCA中,首先将BEV上下文特征映射

,通过拼接后投射成查询特征

,通过拼接后投射成查询特征 ,其中

,其中 是一个线性投影,LN代表层归一化。

是一个线性投影,LN代表层归一化。 - 之后,使用MDCA聚合特征图,其具体公式如下:

其中,h表示注意力头、m表示模态、k表示采样点。

对多模态特征映射 ,应用注意力权重

,应用注意力权重 和采样偏移

和采样偏移 。

。

6、任务头

生成的BEV特征图可以用于多种下游任务,如3D物体检测、跟踪、BEV分割等。

这种统一和精确的BEV表示为自动驾驶系统提供了一个强大的基础,使其能够更好地理解和预测环境中的动态变化。

深度分布网络训练

- 深度映射训练:深度分布网络通过将LiDAR点投影到图像视图中获得的深度图进行训练,这种方法遵循了BEVDepth的策略。

3D检测和跟踪

- 3D物体检测:采用CenterPoint的方法来预测中心热图,这种方法是无锚点的,并且使用了多组头部网络来进行预测。

- 3D跟踪:通过基于速度的最近距离匹配来进行跟踪,这是一种跟踪检测的方法。

- 稀疏聚合训练:在训练稀疏聚合设置时,会过滤掉3D边界框外的LiDAR点以获得真实的深度图,并将等式3中的softmax激活函数替换为sigmoid函数,以便只有包含前景物体的特征网格才能获得高概率。

BEV分割

- BEV分割任务:附加一个卷积解码头部来获取预测图,这个过程遵循了CVT的方法。

- 分割头部:给定来自多模态特征聚合层的BEV特征图,分割头部将其编码为潜在表示,然后解码回最终输出的分割图,随后是一个sigmoid层。

- 网络预测:BEV分割网络预测一个包含车辆和可行驶区域的语义占用网格,采用焦点损失函数进行训练。

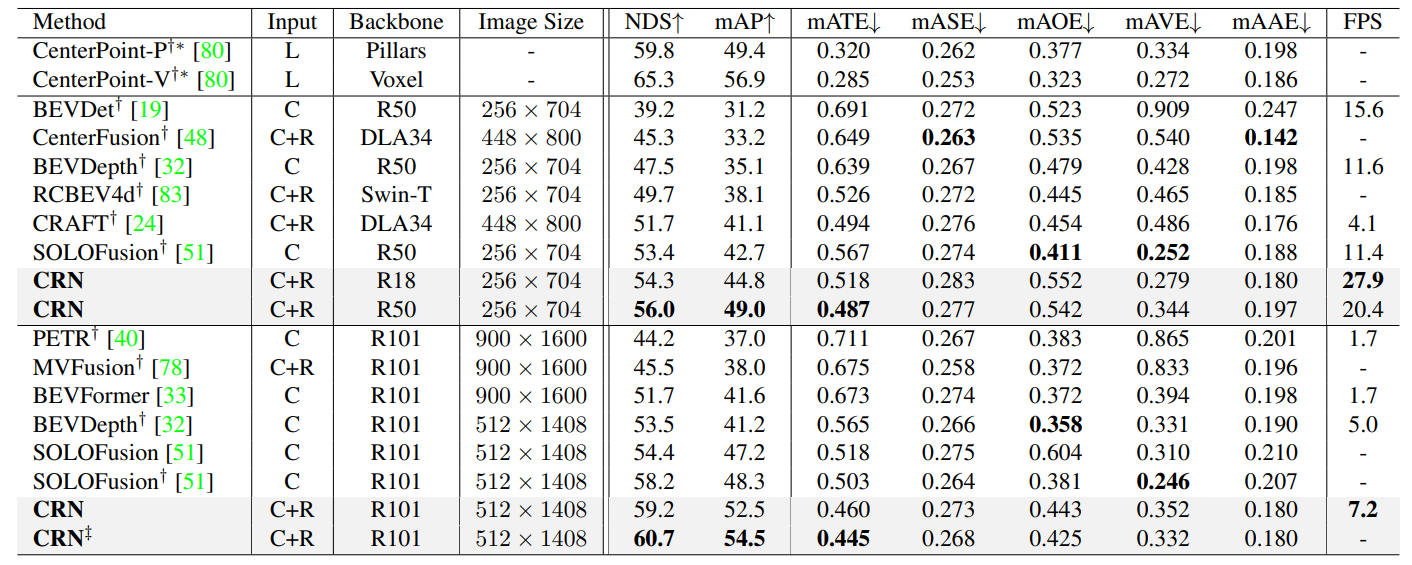

8、实验测试与模型效果

在nuScenes数据集上进行实验,该数据集提供大规模的Radar点云数据。

- 摄像头流:采用BEVDepth作为基线模型,并进行了一些修改,比如减少深度估计层的数量并移除深度细化模块,以提高推理速度且不会显著降低性能。

- 雷达处理:累积六次之前的雷达扫描,并使用规范化的雷达横截面(RCS)和多普勒速度作为特征,这遵循了GRIF Net的方法。

- 数据增强:除了图像和BEV数据增强,还随机丢弃雷达的扫描和点,这遵循了相关研究的方法。

- 训练细节:将之前三个BEV特征图以1秒间隔累积起来,类似于BEVFormer的做法。

- 训练周期:模型在24个周期内使用AdamW优化器以端到端的方式进行训练。

- 评价指标:对于3D物体检测和跟踪,使用官方指标,包括平均精度(mAP)、核心标准(NDS)和平均多目标跟踪精度(AMOTA)。对于BEV分割,遵循LSS提出的设置。

- 推理设备:在配备Intel Core i9 CPU和RTX 3090 GPU的系统上进行测量,使用单批次和FP16精度。

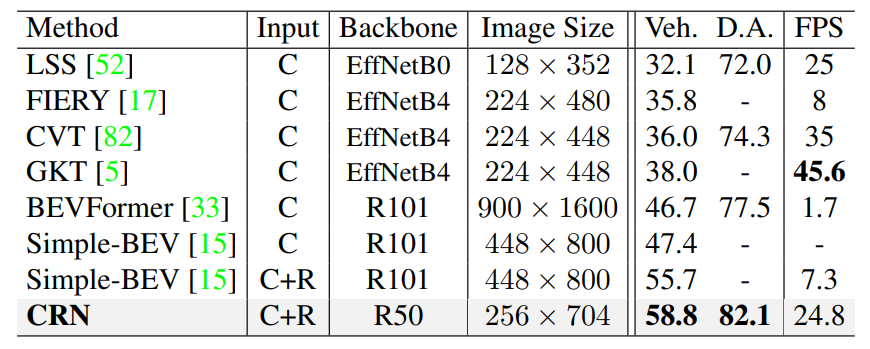

在nuScenes 测试集上的 3D 目标检测,测试结果如下图所示。

- “L”、“C”和“R”分别代表激光雷达、摄像头和雷达。

- * :来自 MMDetection3D的结果。

- † :使用CBGS 培训。

- ‡ :使用测试时间增加。

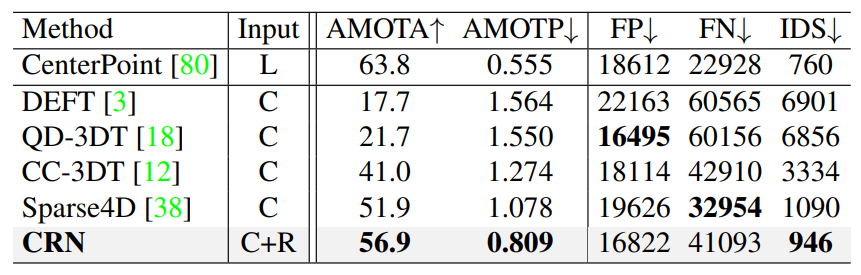

在nuScenes 测试集上的 3D 目标跟踪,测试结果如下图所示。

在nuScenes 测试集上的BEV分割,测试结果如下图所示。

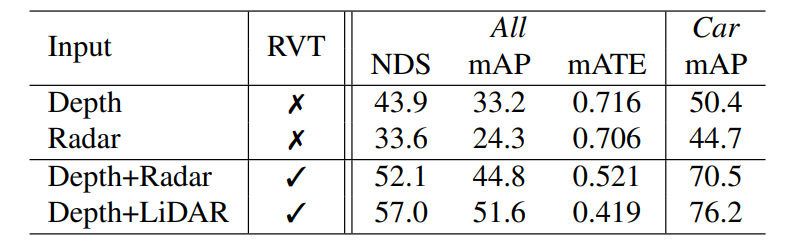

视图变换方法的消融实验 ,LiDAR和雷达仅用于变换,不用于特征聚合。

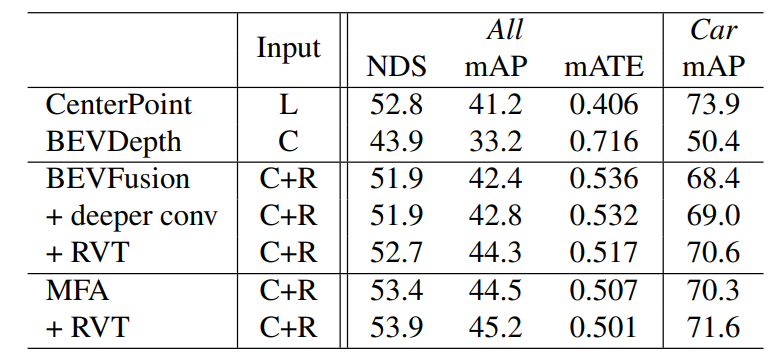

特征聚合方法的消融实验。

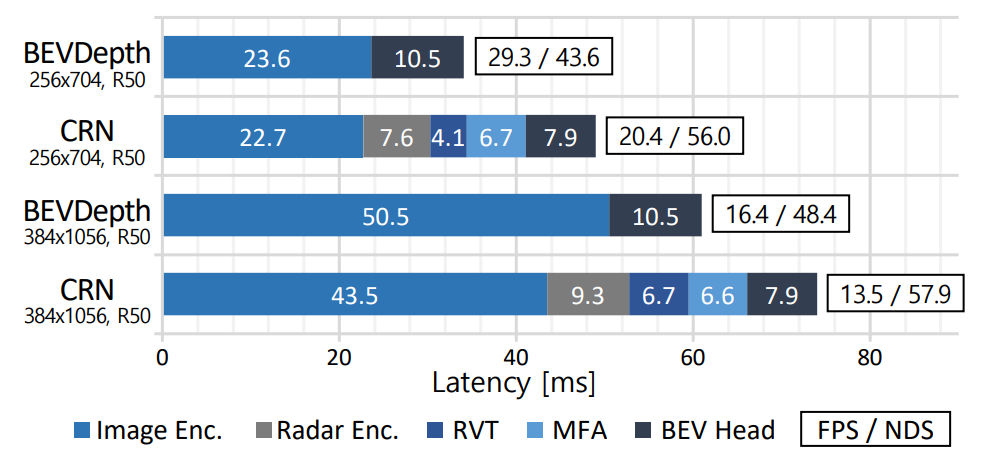

组件的推理时间分析。 所有延迟数字均使用批量大小 1、GPU 预热和 FP16 精度进行测量。

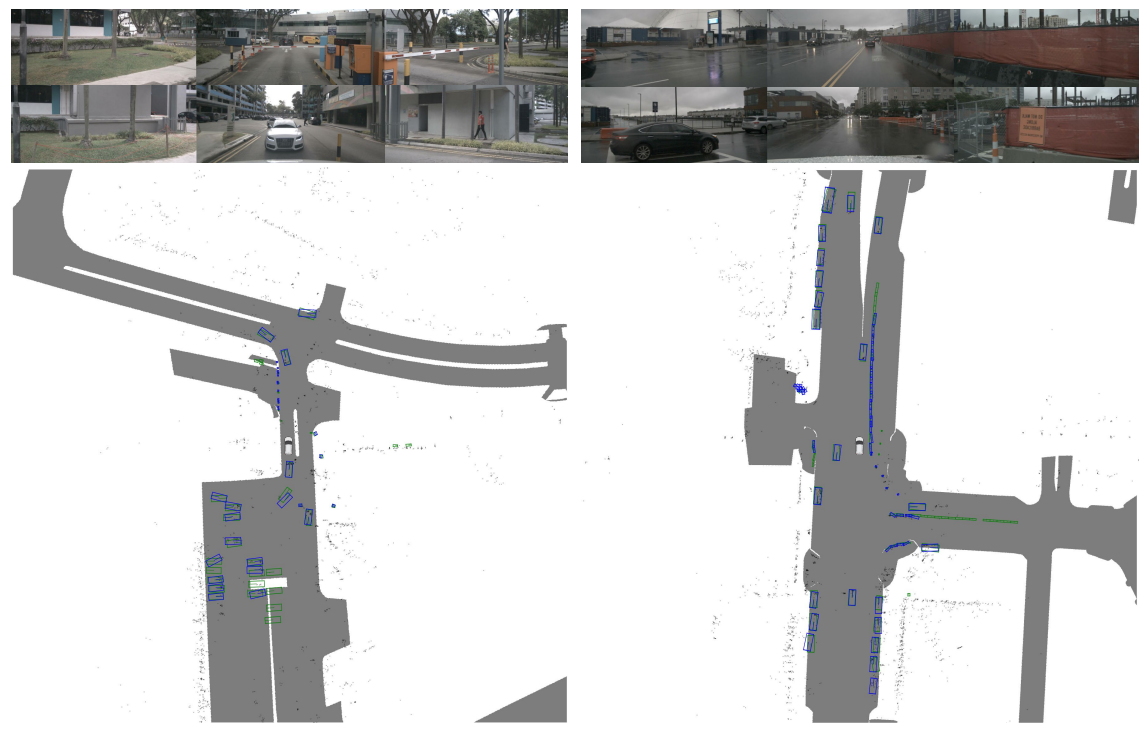

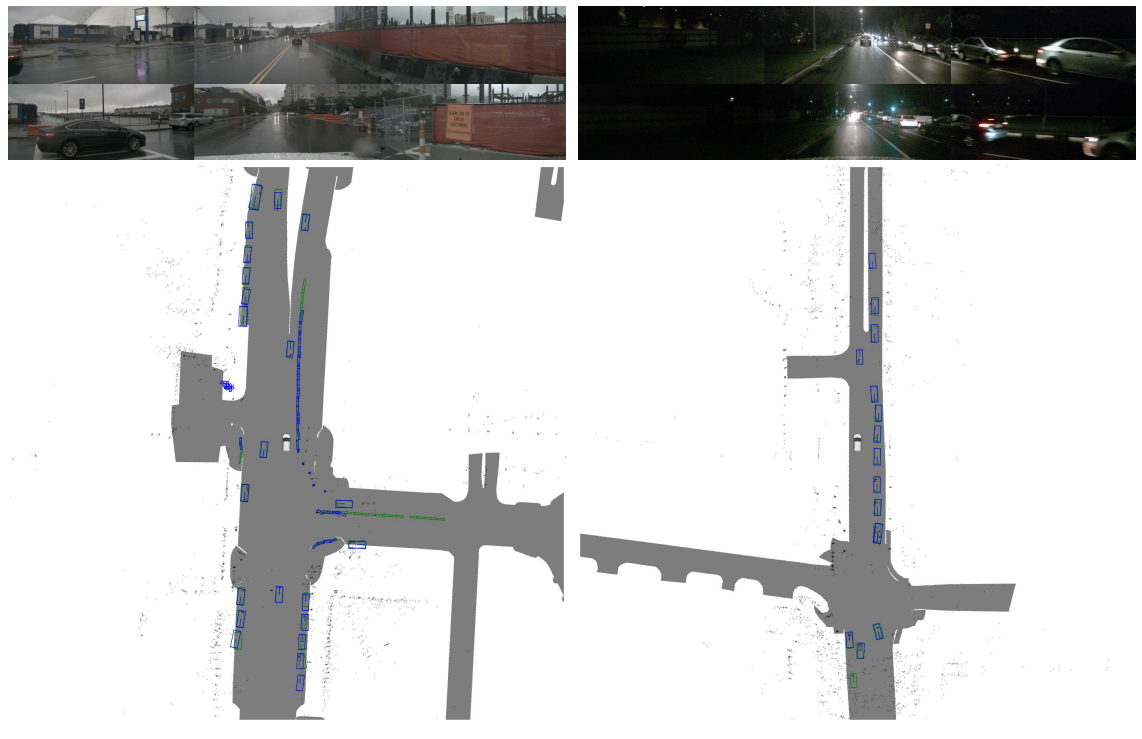

模型效果可视化:

本文先介绍到这里,后面会分享“多模态融合”的其它数据集、算法、代码、具体应用示例。

评论记录:

回复评论: