博客回顾

我的博客创作已经走过了两年的历程,总访问量突破 61 万,累计发布了 494 篇原创文章,目前在 CSDN 排名 2887。我已收获 4272 名粉丝。这些数据不仅是我的努力记录,也体现了读者对我内容的认可。在创作方面,我持续高产:2023 年发布了 166 篇文章,2024 年创作热情进一步提升,达到了 302 篇,而 2025 年至今已经完成了 26 篇内容。我在博客上累计获得 6414 次点赞、66 条评论、6245 次收藏,并且代码片段分享次数达到 5543 次,体现了内容在技术社区中的传播力。

我的博客主要围绕热门技术领域展开,重点包括 大模型开发(16 篇)、知识图谱技术(43 篇)、LLM 专栏(56 篇)和 机器学习专题(73 篇)。我特别关注人工智能、大模型和数据分析工具链等方向,为读者提供从基础到进阶的系统内容。此外,我积极参与社区活动,共获得 14 枚勋章,其中包括 勤写标兵 Lv10、创作能手 Lv4 和其他主题活动勋章。未来,我将继续专注于技术深耕和高质量内容创作,为技术社区贡献更多力量。

从光电到计算机,我的跨界拼搏与大模型的崛起

在过去的两年,我完成了一次人生的重要跨越——从光电信息科学与工程专业的工科生,转战计算机领域,并以初试374分的成绩顺利上岸。回想这段历程,不仅是一次学术领域的转变,更是一次自我突破的挑战。 我的本科就读于上海某高校的光电信息科学与工程专业。作为一个传统工科专业,课程内容相对严谨,但就业市场却不尽如人意。毕业后,我曾尝试进入对口行业,却发现机会稀少,职业发展的路径局限重重。面对这样的困境,我意识到,唯有主动出击、重新选择,才能走出这条窄路。于是,我决定破釜沉舟,跨考计算机。

这一决定背后,是一段异常艰辛的备考历程。作为非计算机专业的学生,我不仅要补上专业基础知识的空白,还要与一群从小接触编程、算法的“原住民”竞争。那些日子里,我将大部分时间投入到高数、数据结构、计算机网络等科目的学习中,熬夜刷题成为常态。一页页的书、一道道的题,支撑我的,是内心对未来的坚定信念。最终,努力没有白费,我以初试374分的成绩跨越了这座学科的“高山”。

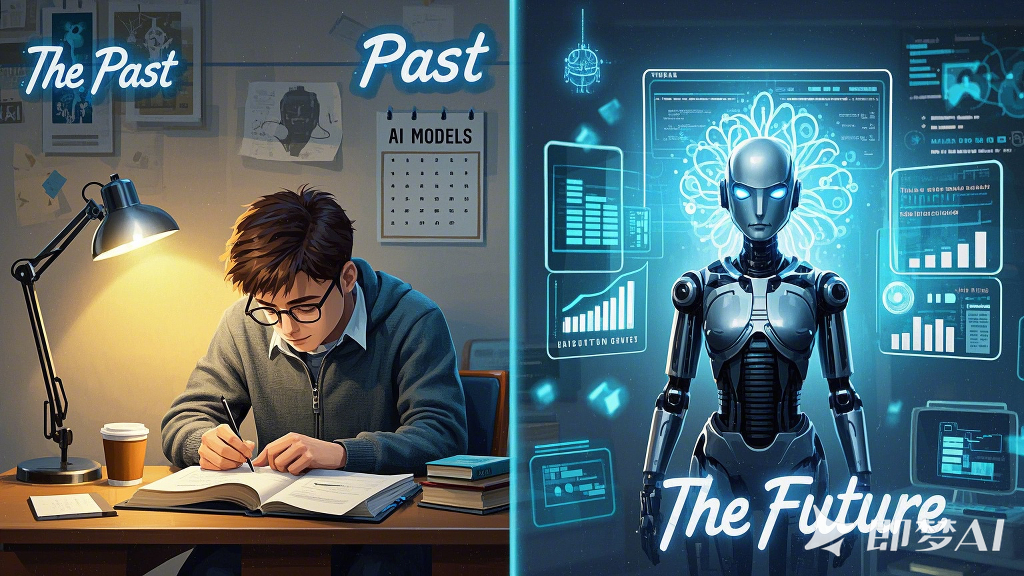

就在这一年,人工智能领域也迎来了划时代的技术浪潮——大模型的爆火。以ChatGPT为代表的大模型技术,以其强大的自然语言生成能力迅速走入大众视野,成为AI领域的焦点。2023年,不仅是我个人的转折之年,也是AI技术从专业圈走向大众的爆发之年。从OpenAI的GPT-4到国内外各类大模型竞相发布,大模型开始渗透到教育、医疗、编程等各个领域,展示出惊人的潜力。

而我的选择与这一技术浪潮不谋而合。在考研结束后,我迅速参与实验室关于大模型研究的课题。这让我有机会投身到最前沿的技术探索中。初识大模型时,我被其强大的语言理解和生成能力震撼,而随着研究的深入,我逐渐意识到,大模型背后的庞大参数和训练数据,也带来了诸多技术与伦理的挑战。 这份与大模型的初次邂逅,不仅让我坚定了自己的学术方向,也让我感受到,这次转变的意义远超个人层面。我不仅是技术浪潮的见证者,更希望成为这场浪潮的推动者。

从评估到实践:大模型的多领域探索与我的成长

大语言模型(LLM)的评估是确保其性能和可靠性的重要环节,也是推动其在不同领域广泛应用的关键手段。随着LLM被广泛应用于生成式任务、问答系统、代码生成、医疗咨询、法律辅助、教育教学等多个场景,对其能力进行科学、系统的评估显得尤为重要。LLM评估不仅帮助研究者深入了解模型的优势与局限,还为改进模型架构、优化应用效果提供了依据。

当前,大模型评估已覆盖多个关键领域,每个领域对评估方法的需求都各有侧重:

- 自然语言生成:使用BLEU、ROUGE等指标评估生成内容的流畅性和相关性,这在新闻生成和文学创作中尤为重要。

- 对话系统:重点评估用户满意度、对话连贯性及对话多样性,广泛用于客服机器人和智能助理领域。

- 代码生成:关注生成代码的语法正确性和功能实现能力,这对于开发辅助工具和代码补全工具尤为重要。

- 医疗咨询:评估生成的建议是否符合医学标准,是否能够准确捕捉患者问题,这需要强大的医学知识支持和推理能力。

- 法律辅助:法律场景中的评估重点在于生成的法律建议是否精准且符合本地法规,同时需考量模型的公平性和对偏见的规避。

- 教育场景:评估大模型是否能够充当教师角色或辅助学生学习,以及在不同学习阶段提供个性化的学习支持。

- 金融领域:在生成财务报告、预测市场趋势时,需关注语言的精确性、数据生成的合理性和预测的可信性。

- 跨模态生成:对于文本-图像生成模型,评估指标涉及文本与图像之间的语义一致性及生成内容的质量与多样性。

这些领域对LLM评估提出了多样化的需求,但也暴露出当前方法的不足,如难以全面捕捉复杂任务中的推理能力、对潜在偏见的识别能力不足等。因此,研究者们持续优化评估指标和方法,以适应不同场景的应用需求。

在我的研究中,我聚焦于LLM在教育领域的评估,尤其关注其在自动问题生成任务中的表现。借助经典的 Bloom分类学框架,我设计了一套针对教育场景的评估体系。Bloom分类学将学习目标分为六个层次:记忆、理解、应用、分析、评价和创造。我的研究从这些认知层次出发,逐层评估LLM生成的问题是否满足不同教学目标。例如:

- 记忆与理解层面:模型是否能生成涵盖基础知识点的问题,例如语法填空或单词拼写题。

- 应用与分析层面:生成的问题是否能够引导学生在特定语境中运用所学知识,例如阅读理解题。

- 评估与创造层面:模型是否能生成开放性、逻辑性强的问题,激发学生的批判性思维和创新能力。

我的研究成果还得到了实践应用。我与团队合作撰写了一篇关于大模型在教育评估中的论文,其中提出了一种全新的自动评估指标体系,涵盖了语义相关性、教育适用性、多样性等关键维度。此外,我们还与国内外多个高校和教育科技企业(如松鼠AI)展开了合作,共同探索如何将LLM应用于教育评估场景中。通过合作,我们开发了一系列针对中小学数学问答和问题生成的智能工具,验证了LLM在教育评估中的潜力,也积累了宝贵的实践经验。这些经历不仅让我对大模型技术有了更深的理解,也让我意识到其在教育领域的广阔前景。我希望未来能进一步优化评估框架,推动LLM更好地服务于教育实践。

从指令到演示:大模型提示学习的探索与我的创新

提示学习(Prompt Learning)是近年来大语言模型(LLM)研究的核心方向之一,通过设计有效的提示,可以激发LLM的潜力,实现高效的任务解决。提示学习的核心思想是利用模型在预训练阶段学习到的大量知识,通过简单的提示构造,让模型完成不同任务。与传统的微调方法相比,提示学习在思维链提示(Chain-of-thought Prompting)和少样本学习(Few-shot Learning)中表现出色,同时减少了对大量标注数据和计算资源的需求。

当前,提示学习已经在多个场景中得到了深入研究和广泛应用,涵盖以下几种主要方法和方向:

- 零样本学习(Zero-shot Learning):直接通过自然语言提示触发模型完成任务,无需任何示例,适用于任务未知或资源稀缺的场景。

- 少样本学习(Few-shot Learning):通过在提示中添加少量示例,提升模型对特定任务的适应能力,在低资源场景下尤为有效。

- 思维链提示(Chain-of-thought Prompting):通过设计逐步推理的提示,引导模型按照逻辑步骤完成复杂推理任务,广泛应用于数学计算、逻辑推理等场景。

- 自动提示工程(Automated Prompt Engineering):通过算法自动生成和优化提示,提升模型的输出质量和任务适配能力,这一方向在提示设计复杂或多任务场景中表现出显著优势。

- 上下文学习(In-context Learning):利用对话式或上下文提示,帮助模型理解任务背景,更好地生成与任务相关的输出。

- 多模态提示:将提示学习扩展到跨模态场景(如图像-文本结合),帮助模型在多模态任务中实现高效协作。

提示学习的核心挑战在于提示设计的多样性与有效性。在某些复杂任务中,手工设计提示往往耗时耗力,难以覆盖多样化需求,因此自动提示工程成为近年来的研究热点。方法包括基于进化算法、强化学习、蒙特卡罗搜索等技术的提示优化。此外,提示学习还面临跨语言适配、提示泛化能力、任务复杂性等问题的挑战。随着技术的进步,提示学习不仅大幅降低了模型使用门槛,还推动了LLM在教育、医疗、法律、金融等领域的广泛应用。

在我的研究中,我专注于教育方向的自动提示工程优化,将知识图谱与算法优化相结合,探索大模型在少样本学习中的潜力。具体而言,我设计了一套方法,将教育领域的知识数据集解析为类似知识树的结构形式。通过知识树,从根节点逐层向下检索,依据语义相似性选取一条与学习任务高度相关的学习路径,作为提示生成的核心样例。这种路径的选择既保证了学习任务的针对性,也提升了模型生成内容的语义相关性。

这一方法的创新之处在于结合了教育场景的知识层次结构和指令优化算法,为少样本学习提供了更高效的解决方案。在这一过程中,我还引入了强化学习的优化思想,动态评估提示的生成效果,进一步优化提示的适用性和生成质量。这项研究成果在第6届“华为杯人工智能研究生创新大赛”中荣获国家三等奖,同时,我也正在撰写相关论文,计划探索如何通过更多领域的优化算法(如动态规划、蒙特卡罗搜索)进一步提升提示的生成效率与精确度。通过这项研究,我不仅验证了自动提示工程在教育领域的可行性,还为大模型在少样本学习中的应用提供了创新思路。这些成果为未来构建更智能、更高效的教育辅助系统奠定了基础。

从优化到融合:大模型和知识图谱的协同进化与我的研究

大语言模型(LLM)与知识图谱(Knowledge Graph,KG)的深度融合代表了人工智能领域的重要方向。知识图谱以显式结构化的方式存储实体及其关系,为模型提供高精度的知识支撑;LLM则通过其强大的语义理解与生成能力,为知识图谱的构建、补全及应用提供了新的可能性。这种融合推动了人工智能的知识表达与推理能力的发展,并在多个领域中展现了巨大潜力。

-

LLM增强知识图谱的构建与补全

知识图谱构建传统上依赖于规则抽取和人工标注,这种方式效率低且难以扩展到海量语料。LLM通过强大的语言理解与生成能力,可从非结构化文本中自动提取实体、关系及其属性,显著提升知识图谱的覆盖度与构建效率。同时,LLM还能通过语言生成技术,补全知识图谱中缺失的关系和属性。 -

知识图谱增强LLM的推理与生成

尽管LLM在生成任务中表现出色,但其推理能力在复杂任务中仍有不足。知识图谱通过提供显式的实体和关系,为大模型生成提供了强有力的逻辑支撑。例如,在开放问答任务中,知识图谱可以通过检索高相关性的知识路径,为LLM生成答案提供语义精准的上下文支持;在多跳推理中,知识图谱可以帮助LLM构建清晰的推理链条,提升模型对复杂问题的解答能力。 -

LLM与知识图谱的融合应用

LLM与知识图谱的结合已在医疗、教育、金融等领域产生了显著影响。例如,在医疗领域,知识图谱帮助模型生成精准的诊断建议;在教育场景中,知识图谱辅助构建个性化学习路径;在金融场景中,知识图谱与LLM的结合为市场趋势分析和投资决策提供了数据支持。然而,这种融合也面临诸多挑战,例如知识图谱动态更新的难度、LLM生成内容的可信性以及两者结合的计算复杂度等。

在我的研究中,我致力于通过重写技术改进RAG(Retrieval-Augmented Generation)框架,探索知识图谱在生成任务中的深度应用。我的方法以SFT(Supervised Fine-Tuning)为核心,通过知识图谱提供高相关性上下文支持,将重写技术与LLM的生成能力相结合,显著提升了查询效率和生成质量。具体而言,我设计了一套基于大语言模型的语义重写策略,通过微调模型优化生成质量,使模型能够从检索的结构化数据中提取最相关的知识并重新组织生成内容,从而提升生成结果的准确性与可读性。

目前,我的研究成果已经在知识问答和推理任务中进行了初步验证,并取得了良好的效果。此外,我准备撰写相关论文,探讨如何通过知识图谱增强RAG框架的上下文检索能力,并计划在未来引入强化学习技术以进一步优化生成策略。这一研究为大模型与知识图谱的深度融合提供了新的解决思路,同时也为复杂任务中的生成任务优化奠定了坚实基础。

从微调到应用:大模型的定制化探索与我的实践

微调(Fine-tuning)技术是大语言模型(LLM)实现定制化和任务优化的核心手段,通过在预训练模型基础上调整部分或全部参数,使模型能够更精准地适应特定任务需求。近年来,微调技术在轻量化、高效性和任务适配性方面取得了显著进展,成为大模型落地的关键技术路径。

-

指令微调(Instruction Tuning)

指令微调是近年来微调技术的核心进展之一。通过在多任务数据集上引入指令示例,模型能够学会理解人类意图并完成多种任务。例如,InstructGPT 使用包含用户反馈的多样化指令数据对模型进行微调,使其在对话生成和问题回答任务中展现了更强的适应性和响应性。 -

LoRA(Low-Rank Adaptation)

LoRA 技术通过低秩分解的方式,仅更新模型的一部分参数,大幅降低了微调成本,同时保持较高的性能。例如,在图像描述生成任务中,LoRA 被用于高效调整视觉-语言模型的文本生成模块,显著降低了训练资源需求。 -

PEFT(Parameter-Efficient Fine-Tuning)

PEFT 是一类高效的参数微调方法,通过冻结主模型参数,仅对少量新参数(如 Adapter 或前缀)进行优化。研究表明,PEFT 技术在跨任务迁移中具有显著优势。例如,在法律判例分类中,PEFT 方法通过小规模训练数据实现了与全参数微调相当的效果。

微调技术的灵活性和适应性使其在多个领域的实际应用中展现了强大的潜力:

-

医疗领域

微调技术已广泛应用于医学文本分析和个性化诊断任务。例如,微调后的 MedAlpaca 模型结合医学问答任务,能够生成精准的诊断建议和治疗方案。此外,在基因序列分析中,微调技术被用于快速解析基因变异,支持精准医疗的研究。 -

法律领域

在法律文本处理和判例预测任务中,微调技术表现出显著优势。例如,LegalBench 使用指令微调技术优化了模型对法律条款和案例的理解能力,使其能够为法律顾问提供更加精准的支持。 -

科学文献分析

微调技术在科学研究领域的文献分类和信息抽取任务中得到了应用。例如,Galactica 模型通过指令微调,在文献摘要生成和科学实体识别方面表现出色,显著提升了科学数据处理的效率。

在参与拓尔思人工智能学院的“智研惠师”智能体设计项目时,我结合指令微调与 LoRA 技术,为系统设计了精准的试题分类与知识提取模块。在项目中,我通过微调模型实现了对复杂教育任务的高度适配,例如根据不同课程内容生成个性化试题集以及对海量教学资源进行语义分类与提取。此外,通过优化微调方法,我提升了系统对多任务的处理效率,为实际教育场景中的智能化解决方案提供了新的思路。这一研究让我深刻体会到微调技术的灵活性和广泛性,也让我更加意识到未来探索轻量化微调技术的重要性。下一步,我计划进一步优化模型性能,并尝试结合强化学习技术,为更复杂的应用场景提供高效的解决方案。

从智能到赋能:大模型多智能体系统的跨领域应用与我的探索

大语言模型(LLM)与多智能体系统(MAS)的结合,正在重塑多个领域的人工智能应用。MAS通过协作机制完成复杂任务,而LLM为其提供了强大的自然语言理解与生成能力,使智能体能够在动态环境中高效感知、决策与执行。以下是几个典型领域的应用案例:

-

工业制造与能源调度

在分布式制造与能源调度场景中,多智能体结合LLM构建了智能能效管理系统。通过引入区块链技术,这些系统能够优化新能源车辆的生产排程,并在多智能体的协作下实现高效调度。 -

医疗与心理健康

在医疗与心理健康领域,LLM赋能的多智能体系统(如AutoCBT框架)被用于支持认知行为治疗,通过语言生成技术与患者进行互动,提供定制化的心理支持方案。此外,多智能体技术还被用于诊断偏见的缓解与医学数据分析,为患者提供更加公平与可靠的医疗服务。 -

交通与城市规划

智能交通系统通过结合多智能体技术与边缘计算,实现了对6G智能运输系统的动态优化。例如,在城市规划中,多智能体协同完成了绿色治理策略的建模与优化,推动了可持续发展的城市交通体系。 -

法律文本处理与翻译

LLM支持的多智能体系统被广泛用于法律领域的文本翻译与分析。例如,在香港法律案例中,多智能体系统利用LLM增强了法律文档的翻译精确性,同时支持复杂的判例推理任务。 -

环境与资源管理

在环境保护中,多智能体结合博弈模型被用于船舶自主避碰决策和矿井气体状态监测,显著提升了环境治理的自动化与智能化水平。 -

游戏开发与仿真

LLM支持的多智能体在游戏开发中展现了强大的动态交互能力。例如,Whodunitbench框架通过多模态智能体的推理和任务协调能力,优化了推理型游戏中的复杂情节生成。这种智能交互技术提升了游戏的可玩性和沉浸感。

我专注于基于大模型的游戏多智能体系统设计,探索其在开放世界游戏中的应用。我设计了一种结合语义生成与行为优化的智能体框架,能够根据玩家的实时行为动态生成任务与对话,同时结合强化学习技术改进角色的互动行为。实验结果表明,该框架显著提高了游戏的沉浸感与任务完成率。目前,我的研究成果已整理为一篇中文期刊论文,并投稿至国内三大学报。论文系统分析了智能体在开放世界游戏中的表现,特别是在多任务协作和对话生成的灵活性方面。未来,我计划引入多模态交互技术,进一步提升智能体在语音、图像与文本交互中的综合表现,为复杂场景的智能体开发提供新的解决方案。

从问答到推理:大语言模型在复杂推理任务中的探索与我的应用

大语言模型(LLM)在复杂推理任务中的潜力得到了广泛认可。通过整合检索增强生成(RAG)、链式思维(Chain of Thought, CoT)等技术,LLM 可以高效处理多步推理、跨领域知识整合和动态决策问题。以下是 LLM 在多个领域复杂推理中的典型应用方向:

-

教育与知识问答

LLM 在教育领域中的应用主要体现在复杂问题的逐步解答和知识传播中。例如,结合 RAG 技术,LLM 能够从外部知识库检索相关信息,并通过生成模块提供准确的答案解析。这种能力显著提升了模型在处理长上下文和开放性问题时的表现。 -

医疗推理

LLM 在医疗领域可处理复杂的诊断任务。例如,FineMedLM-o1 模型通过子问题分解和监督微调,帮助医生从患者描述中提取重要信息并生成可靠的诊断报告。这种分解式推理方法显著提升了模型的稳健性和诊断准确性。 -

化学与科学推理

在化学推理领域,ChemAgent 模型通过引入自更新知识库,增强了大语言模型的领域知识。结合子问题分解,该模型能够逐步推理复杂化学反应路径,为科学研究提供了智能化支持。 -

多模态推理

LLM 在音频推理任务中的应用通过整合链式思维(CoT)进一步得到强化。例如,Audio-CoT 模型能够在多模态数据下解析语音情境,推导出准确的语义解释,为音乐分析与语音交互提供技术支持。 -

机器人与物联网

结合子问题分解与任务规划的多智能体系统,通过 LLM 实现了低空自主飞行和任务协调能力。例如,UAVs Meet LLMs 框架在灾害应急和物流运输中表现出色。 -

通用人工智能(AGI)

LLM 被认为是通用人工智能发展的关键。通过 RAG 技术与逻辑推理相结合,LLM 展现了在开放领域任务中处理复杂问题的能力,为未来通用人工智能的实现提供了基础。

我聚焦于基于子问题分解与 RAG 重写的复杂推理框架,探索其在开放域问答中的应用。我设计了一种结合链式思维与知识检索的推理方法,将复杂问题拆解为多个子问题,并利用 RAG 技术从外部知识库中获取相关信息。通过对检索结果的动态重写,模型能够生成更准确、更符合语义逻辑的答案。当前,我的研究仍在实验阶段,主要测试不同子问题分解策略与 RAG 模块的结合效果。初步实验结果表明,该框架在复杂问题处理中的准确率和推理连贯性均有显著提升。此外,我计划优化动态重写模块,以提高答案的生成效率与上下文一致性。这项研究为 LLM 在复杂推理任务中的应用提供了新的技术路径,也为教育领域智能问答系统的开发奠定了理论基础。

我和大模型:并肩前行的逐梦旅程

大模型的崛起不仅是人工智能发展的里程碑,也深刻影响了我的学习与研究之路。从跨考计算机到融入研究生课题组,我与大模型的接触逐渐深入,从最初的敬畏与好奇,到如今的实践与探索,我深刻体会到了技术创新带来的震撼与机遇。

在学习和研究的过程中,我不断挑战自我。从基础理论的学习到复杂推理任务的研究,我见证了自己的成长。在参与教育知识问答、RAG框架优化和子问题分解实验的过程中,我逐渐掌握了将理论转化为实际应用的能力,也对技术细节和方法论的严谨性有了更深的理解。与此同时,我的论文研究也见证了努力的价值,通过多次优化和实验,我逐渐摸索出将大模型应用于特定领域的最佳实践。

这种与大模型的共成长不仅是我个人发展的体现,也是技术快速进步的缩影。从模型的能力扩展到场景的落地应用,大模型在软件开发、游戏设计、教育问答等多个领域取得了令人瞩目的成绩。而我,也从一个刚刚接触人工智能的门外汉,逐步成长为能够独立设计和实现技术方案的研究者。

成长与进步的背后,离不开不断的尝试与坚持。 无论是模型微调的优化实验,还是智能体行为规划的细节设计,我深知,技术的进步不仅需要理论的积累,更需要实践中的思考和打磨。每一次实验数据的改进,每一段代码逻辑的优化,都让我距离自己的目标更近一步。

大模型的飞速发展提醒着我:未来仍有无限可能。从教育到医疗,从游戏到科学研究,我希望能够继续探索大模型的边界,推动技术在更多领域的创新应用。与此同时,我也希望通过自身的努力,为大模型的应用与发展贡献一份力量。

我与大模型的故事仍在继续,未来,我期待着与它并肩,走向更广阔的技术前沿,书写属于我们的精彩篇章。

评论记录:

回复评论: