目录

2.1 可能的问题:Keras 3 与 Transformers 不兼容

0 前言

本文为李宏毅学习笔记——2024春《GENERATIVE AI》篇——作业笔记HW6。

如果你还没获取到LLM API,请查看我的另一篇笔记:

HW1~2:LLM API获取步骤及LLM API使用演示:环境配置与多轮对话演示-CSDN博客

完整内容参见:

李宏毅学习笔记——2024春《GENERATIVE AI》篇

在部署大模型之后,我们必然要和微调打交道。现在大模型的微调有非常多的方法,过去的微调方法通常依赖于问题和答案对,标注成本较高,2023 年所提出的 Direct Preference Optimization(DPO)提供了一种无需标准标注答案的高效微调方法。

DPO 依赖于人类对文本的偏好对(preference pairs),也就是说,数据集中只包含人类对两段文本中哪段更好的判断,而不是具体的正确答案。

在本文中,我们将利用 DPO 来微调一个模型让其按照偏好进行输出。

之前微调唐诗更像是一个传统的方法,使用问题和答案驱动的微调方式,数据标注成本很高。而 DPO 不同,它使用的是人类对文本的偏好对:即人类认为一对文本中哪个更好。

1 DPO和传统监督微调的不同之处

1.1 之前的微调方法(传统监督微调)

-

输入:

- 问题

- 一个“标准答案”或期望的目标输出

-

目标:直接让模型学习这个标准答案,通过最小化与答案的误差来进行训练。

-

局限:

- 需要明确的“正确答案”,但在许多开放性问题中,正确答案可能是模糊或多样的。

- 无法直接利用对多个答案的偏好数据来优化模型

1.2 DPO 的微调方法

-

输入:

- 一个问题

- 两个相对立或不同的答案(可能都不是完全正确的)

- 对答案的偏好支持度(

support_ratio或直接的排名优劣)

-

目标:

- 学习到答案的相对偏好,让模型输出的答案更符合偏好的方向。

- 模型不需要完全生成一个“标准答案”,而是需要倾向于生成更符合偏好或更优的回答。

1.3 DPO 和之前方法的关键不同

-

数据形式不同:

- 之前是一个问题和一个唯一标准答案。

- DPO 是一个问题和两个答案,再加上偏好的支持度(或优劣关系)。

-

优化目标不同:

- 传统方法最小化模型输出与标准答案的差异。

- DPO 则最大化模型输出与偏好关系的匹配程度,通常通过对比损失(如

contrastive loss)或类似方法来实现。

-

处理模糊性:DPO 能更好地应对没有明确答案的问题,因为它基于相对偏好优化,而不是绝对标准答案。

2 安装和导入一些必要的库

- pip install bitsandbytes

- pip install datasets

- pip install peft

- pip install trl

- pip install accelerate

- pip install tf-keras

- pip install numpy==1.26.4

2.1 可能的问题:Keras 3 与 Transformers 不兼容

- import os

- import re

- import json

-

- import torch

- import pandas as pd

- from tqdm.auto import tqdm

-

- from datasets import Dataset

- from peft import LoraConfig

- from transformers import AutoModelForCausalLM, AutoTokenizer, TrainingArguments, BitsAndBytesConfig, GenerationConfig

- from trl import DPOConfig, DPOTrainer

可能的问题:Keras 3 与 Transformers 不兼容

在导入时,你可能会看到以下报错:

RuntimeError: Failed to import trl.trainer.dpo_trainer because of the following error (look up to see its traceback): Failed to import transformers.trainer because of the following error (look up to see its traceback): Failed to import transformers.integrations.integration_utils because of the following error (look up to see its traceback): Failed to import transformers.modeling_tf_utils because of the following error (look up to see its traceback): Your currently installed version of Keras is Keras 3, but this is not yet supported in Transformers. Please install the backwards-compatible tf-keras package with

pip install tf-keras.

transformers 库建议安装兼容的 tf-keras 包来解决这个兼容性问题。你可以通过以下命令安装:

pip install tf-keras

现在问题应该得到了解决。

3 加载数据集

我们将使用预先提供的数据集,包括带标签的偏好数据和测试提示数据。

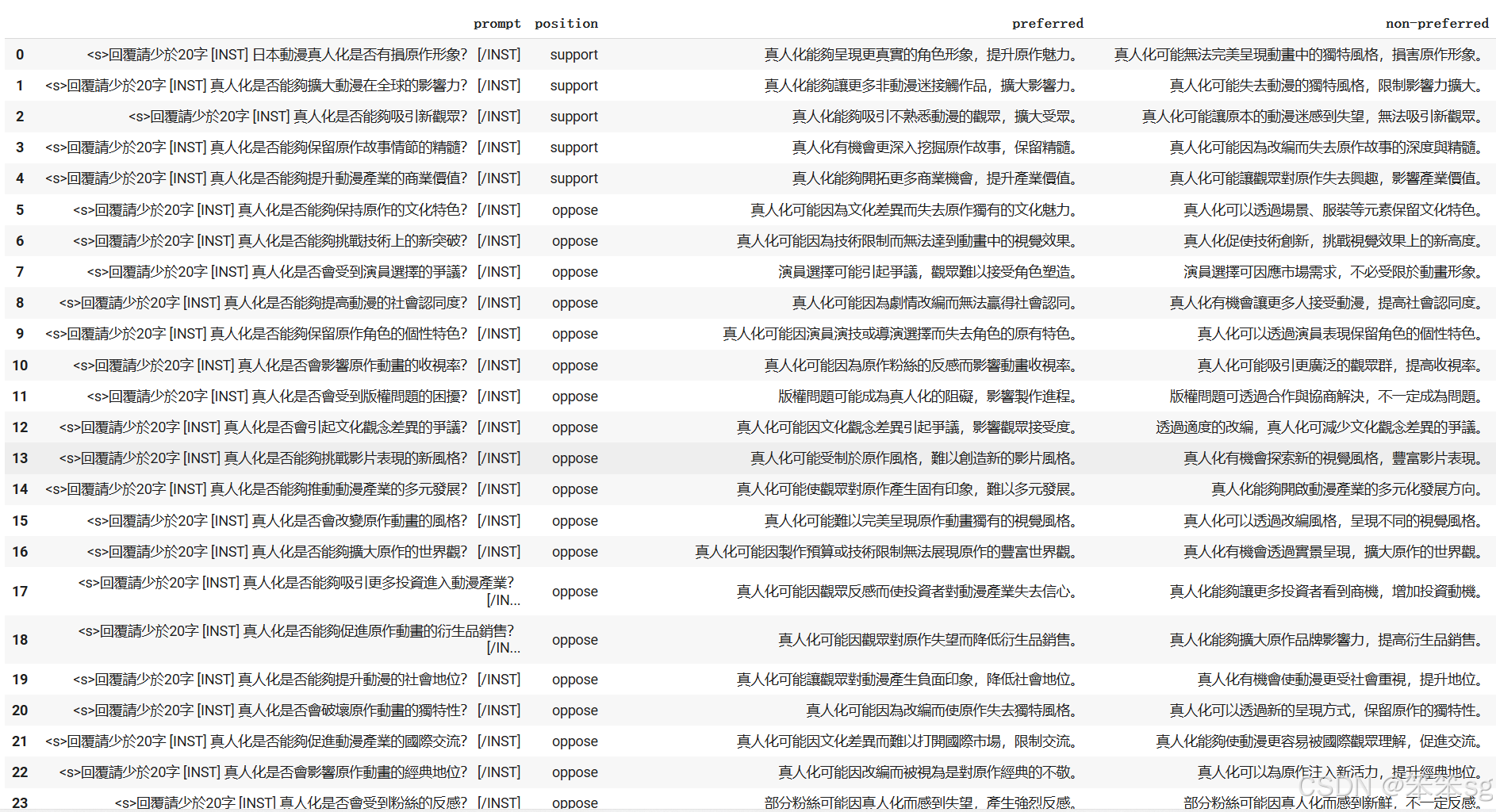

这个数据集来自于生成式人工智能导论的 HW6,处理的问题是:是否应该将动漫真人化?两个回答分别对应支持和不支持(由 GPT 生成),在后面的代码中你需要调整支持的占比。

git clone https://github.com/Baiiiiiiiiii/GenAI_hw6_dataset.git

- with open("./GenAI_hw6_dataset/labelled_data.json", 'r') as jsonfile:

- full_data = json.load(jsonfile)

-

- with open("./GenAI_hw6_dataset/test_prompt.json", 'r') as jsonfile:

- test_data = json.load(jsonfile)

直观理解数据集:

- ([{'id': 1,

- 'prompt': '日本動漫真人化是否有損原作形象?',

- 'support': '真人化能夠呈現更真實的角色形象,提升原作魅力。',

- 'oppose': '真人化可能無法完美呈現動畫中的獨特風格,損害原作形象。'},

- {'id': 2,

- 'prompt': '真人化是否能夠擴大動漫在全球的影響力?',

- 'support': '真人化能夠讓更多非動漫迷接觸作品,擴大影響力。',

- 'oppose': '真人化可能失去動漫的獨特風格,限制影響力擴大。'},

- {'id': 3,

- 'prompt': '真人化是否能夠吸引新觀眾?',

- 'support': '真人化能夠吸引不熟悉動漫的觀眾,擴大受眾。',

- 'oppose': '真人化可能讓原本的動漫迷感到失望,無法吸引新觀眾。'},

- {'id': 4,

- 'prompt': '真人化是否能夠保留原作故事情節的精髓?',

- 'support': '真人化有機會更深入挖掘原作故事,保留精髓。',

- 'oppose': '真人化可能因為改編而失去原作故事的深度與精髓。'},

- {'id': 5,

- 'prompt': '真人化是否能夠提升動漫產業的商業價值?',

- 'support': '真人化能夠開拓更多商業機會,提升產業價值。',

- 'oppose': '真人化可能讓觀眾對原作失去興趣,影響產業價值。'}],

- [{'id': 1, 'prompt': '真人化是否能改善日本漫畫的全球可及性?'},

- {'id': 2, 'prompt': '真人化如何影響年輕一代對日本漫畫的看法?'},

- {'id': 3, 'prompt': '真人化是否能提升原作漫畫的文學價值?'},

- {'id': 4, 'prompt': '真人化是否有助於保護和保存日本漫畫的傳統?'},

- {'id': 5, 'prompt': '真人化是否有助於提升日本漫畫行業的經濟效益?'},

- {'id': 6, 'prompt': '真人化如何影響日本漫畫原作者的創作動力?'},

- {'id': 7, 'prompt': '真人化是否對漫畫原作的忠實粉絲公平?'},

- {'id': 8, 'prompt': '真人化是否能夠促進日本漫畫的創新和多樣性?'},

- {'id': 9, 'prompt': '真人化是否有助於擴大動漫文化的市場份額?'},

- {'id': 10, 'prompt': '真人化是否有助於提高日本漫畫在全球的競爭力?'}])

4 使用 HFD 下载模型

我们这里使用多线程的方法进行快速下载。

当然,你也可以取消我注释的部分,使用官方的命令进行安装,但是可能会很慢。

安装工具:

- sudo apt-get update

- sudo apt-get install git wget curl aria2 git-lfs

- git lfs install

下载 hfd 并修改权限:

- wget https://hf-mirror.com/hfd/hfd.sh

- chmod a+x hfd.sh

多线程下载模型:

- export HF_ENDPOINT=https://hf-mirror.com

- ./hfd.sh 'MediaTek-Research/Breeze-7B-Instruct-v0_1' --tool aria2c -x 16

如果直接运行以上命令报错,根据 a. 使用 HFD 加快 Hugging Face 模型和数据集的下载 进行前置安装。

5 加载模型

将使用MediaTek-Research/Breeze-7B-Instruct-v0_1模型进行微调。

- model = AutoModelForCausalLM.from_pretrained(

- 'MediaTek-Research/Breeze-7B-Instruct-v0_1',

- device_map='auto',

- trust_remote_code=True,

- quantization_config=BitsAndBytesConfig(

- load_in_4bit=True,

- bnb_4bit_compute_dtype=torch.bfloat16,

- bnb_4bit_use_double_quant=True,

- bnb_4bit_quant_type='nf4'

- )

- )

-

- # 本地取消下面的注释,然后注释上面

- # model = AutoModelForCausalLM.from_pretrained(

- # 'Breeze-7B-Instruct-v0_1', # 替换为本地模型存储的实际路径

- # device_map='auto',

- # trust_remote_code=True,

- # local_files_only=True, # 确保从本地加载

- # quantization_config=BitsAndBytesConfig(

- # load_in_4bit=True,

- # bnb_4bit_compute_dtype=torch.bfloat16,

- # bnb_4bit_use_double_quant=True,

- # bnb_4bit_quant_type='nf4'

- # )

- # )

这里,我们采用了4 位量化(4-bit quantization)来减少模型的内存占用,加快推理速度。

6 查看未经过微调的模型原始输出

在进行微调之前,我们首先查看一下原始模型的输出效果。首先,加载分词器:

- tokenizer = AutoTokenizer.from_pretrained('MediaTek-Research/Breeze-7B-Instruct-v0_1')

- tokenizer.padding_side = "right"

- tokenizer.pad_token = tokenizer.eos_token

定义一个数据处理函数,将数据格式化为模型可以接受的输入,我们这里的 prompt 延续原来的繁体(因为 Breeze-7B-Instruct-v0_1 更多使用繁体中文进行训练,你并不需要修改它):

- def data_formulate(data):

- messages = [

- {"role": "system", "content": '回覆請少於20字'},

- {"role": "user", "content": data['prompt']},

- ]

- prompt = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

- return prompt

接下来,生成原始模型的响应:

- original_model_response = []

- for data in tqdm(test_data):

- id = data['id']

- print(f'Question {id}:\n'+data['prompt'])

- inputs = tokenizer(data_formulate(data), return_tensors="pt").to('cuda')

- generation_config=GenerationConfig(

- do_sample=False,

- max_new_tokens = 200,

- pad_token_id = tokenizer.pad_token_id

- )

- output = model.generate(**inputs, generation_config=generation_config)

- output = tokenizer.batch_decode(output, skip_special_tokens=True)[0].split('[/INST] ')[1]

- original_model_response.append(output)

- print('Response from original model:\n'+output+'\n')

这段代码将遍历测试数据集,生成并打印每个问题的原始模型响应。

- Question 1:

- 真人化是否能改善日本漫畫的全球可及性?

- Response from original model:

- 真人化可能會提高日本漫畫的全球可及性,因真人版電影或劇集可以吸引更多非漫畫讀者的注意,並提供不同的體驗。然而,這取決於真人化作品的品質、行銷策略和市場接受度。

-

- Question 2:

- 真人化如何影響年輕一代對日本漫畫的看法?

- Response from original model:

- 真人化可能會影響年輕一代對日本漫畫的看法,使他們更容易接受和理解故事和角色,並吸引更多人關注和支持日本漫畫文化。然而,個人喜好和文化差異可能導致不同的影響。

-

- Question 3:

- 真人化是否能提升原作漫畫的文學價值?

- Response from original model:

- 真人化可能會提升原作漫畫的知名度和影響力,但文學價值本身可能因個人喜好和文化差異而異。真人化可能帶來更多觀眾,但文學價值取決於原作的故事、人物和主題,而非真人化形式。

-

- Question 4:

- 真人化是否有助於保護和保存日本漫畫的傳統?

- Response from original model:

- 真人化可能有助於提高日本漫畫的知名度和吸引更多觀眾,但是否真正保護和保存傳統尚需視真人化作品是否尊重原作精神和文化價值。

-

- Question 5:

- 真人化是否有助於提升日本漫畫行業的經濟效益?

- Response from original model:

- 真人化可能有助於提升日本漫畫行業的經濟效益,因真人版電影或劇集可以吸引更多觀眾,增加收入來源。然而,成功與否取決於作品的品質、行銷策略和市場接受度。

-

- Question 6:

- 真人化如何影響日本漫畫原作者的創作動力?

- Response from original model:

- 真人化可能會影響日本漫畫原作者的創作動力,因真人版可能帶來新的靈感、挑戰,並吸引更多讀者。然而,個人感受和反應各異,有些作者可能因真人化而更投入創作,而其他人可能因個人喜好或對真人化看法不同而影響其動力。

-

- Question 7:

- 真人化是否對漫畫原作的忠實粉絲公平?

- Response from original model:

- 真人化可能會影響忠實的漫畫原作粉絲,因真人版可能有不同的故事改編、角色設定或表現方式,但個人喜好不同,仍有可能欣賞。

-

- Question 8:

- 真人化是否能夠促進日本漫畫的創新和多樣性?

- Response from original model:

- 真人化可能促進日本漫畫的創新和多樣性,因真人版電影或劇集可以吸引新觀眾群,並提供不同的故事表現方式。然而,過度的真人化或商業化可能限制創意和多元性。平衡點須考慮。

-

- Question 9:

- 真人化是否有助於擴大動漫文化的市場份額?

- Response from original model:

- 真人化可能有助於擴大動漫文化的市場份額,因它能吸引更多非動漫迷觀眾,並提高大眾對動漫文化的認識。然而,成功與否取決於真人化作品的品質、故事內容、以及是否能保持動漫原作的精神。

-

- Question 10:

- 真人化是否有助於提高日本漫畫在全球的競爭力?

- Response from original model:

- 真人化可能有助於提高日本漫畫在全球的競爭力,因它能吸引更多觀眾並拓展市場,但同時也可能限制原創性,影響日本漫畫的獨特性。

7 设置参数

只需要修改这个模块,不需要改变其他的,除非你真的知道自己在做什么。

support_ratio 将反映人类的偏好:

- 0 表示完全不支持(反对)真人化

- 1 表示完全支持真人化

- 0.1 表示 10% 支持真人化

num_epoch = 1

data_size = 50

support_ratio = 0.1

8 准备训练数据

这里,我们将数据集分为支持(support)和反对(oppose)两部分,构建一个包含偏好对的训练数据集(是的,这里就是 DPO)。

- # 选择部分数据用于训练

- training_data = full_data[:data_size]

-

- # 定义 support 数据集的大小

- support_data_size = int(data_size * support_ratio)

-

- # 为训练数据集准备数据

- prompt_list = [data_formulate(data) for data in training_data]

- chosen_list = [data['support'] for data in training_data[:support_data_size]] + [data['oppose'] for data in training_data[support_data_size:]]

- rejected_list = [data['oppose'] for data in training_data[:support_data_size]] + [data['support'] for data in training_data[support_data_size:]]

- position_list = ['support' for _ in range(support_data_size)] + ['oppose' for _ in range(data_size - support_data_size)]

-

- # 创建训练数据集

- train_dataset = Dataset.from_dict({'prompt': prompt_list, 'position': position_list, 'chosen': chosen_list, 'rejected': rejected_list})

- pd.DataFrame(train_dataset).rename(columns={"chosen": "preferred", "rejected": "non-preferred"})

总共有 50 笔训练数据,当 support 设置为 0.1 时,前 50*0.1=5 笔训练资料的偏好将倾向于支持真人化,后 50-5=45 笔资料反对真人化。

9 训练

现在,我们进入训练阶段。首先,设置训练参数:

- training_args = DPOConfig(

- output_dir='./',

- per_device_train_batch_size=1,

- num_train_epochs=num_epoch,

- gradient_accumulation_steps=8,

- gradient_checkpointing=False,

- learning_rate=2e-4,

- optim="paged_adamw_8bit",

- logging_steps = 1,

- warmup_ratio = 0.1,

- report_to = 'none',

- )

接下来,配置 PEFT(Parameter-Efficient Fine-Tuning):

- peft_config = LoraConfig(

- lora_alpha=16,

- lora_dropout=0.1,

- r=64,

- bias="none",

- task_type="CAUSAL_LM",

- )

然后,初始化 DPO 训练器:

- dpo_trainer = DPOTrainer(

- model,

- args=training_args,

- beta=0.1,

- train_dataset=train_dataset,

- tokenizer=tokenizer,

- peft_config=peft_config,

- )

开始训练:

dpo_trainer.train()

Step Training Loss 1 0.693100 2 0.693100 3 0.607800 4 0.584700 5 0.526900 6 0.480900 TrainOutput(global_step=6, training_loss=0.5977605829636256, metrics={'train_runtime': 154.5115, 'train_samples_per_second': 0.324, 'train_steps_per_second': 0.039, 'total_flos': 0.0, 'train_loss': 0.5977605829636256, 'epoch': 0.96})

10 查看微调后的模型输出

训练完成后,我们需要查看微调后的模型效果。以下是生成训练后模型响应的代码:

- trained_model_response = []

- for data in tqdm(test_data):

- id = data['id']

- print(f'Question {id}:\n'+data['prompt'])

- inputs = tokenizer(data_formulate(data), return_tensors="pt").to('cuda')

- generation_config=GenerationConfig(

- do_sample=False,

- max_new_tokens = 200,

- pad_token_id = tokenizer.pad_token_id

- )

- output = model.generate(**inputs, generation_config=generation_config)

- output = tokenizer.batch_decode(output, skip_special_tokens=True)[0].split('[/INST] ')[1]

- trained_model_response.append(output)

- print('Response from trained model:\n'+output+'\n')

这段代码与之前生成原始模型响应的代码类似,但这次生成的是经过微调后的模型响应:

- Question 1:

- 真人化是否能改善日本漫畫的全球可及性?

- Response from trained model:

- 真人化可能會提高日本漫畫的全球可及性,尤其是當真人版電影或劇集獲得成功時。然而,這取決於各個市場的接受程度和喜好。有些地區或觀眾可能更喜歡真人版,而其他地區或觀眾可能更喜歡原漫畫。因此,真人化可能有助於擴大日本漫畫的全球影響力,但效果因地而異。

-

- Question 2:

- 真人化如何影響年輕一代對日本漫畫的看法?

- Response from trained model:

- 真人化可能會影響年輕一代對日本漫畫的看法,因真人版可能會與原作有差異,或因演員、導演等因素影響作品品質,而影響年輕一代對原作的印象。然而,真人化亦可能吸引新觀眾群,並促進文化交流。最終影響取決於作品本身和真人化品質。

-

- Question 3:

- 真人化是否能提升原作漫畫的文學價值?

- Response from trained model:

- 真人化可能會影響原作漫畫的文學價值,但影響程度取決於真人化作品的品質、忠實度、以及是否能保留原作的核心精神。如果真人化能忠實地呈現原作的故事和角色,並獲得觀眾的喜愛,則其文學價值可能提升。然而,如果真人化失焦或失去原作的精髓,則其文學價值可能下降。

-

- Question 4:

- 真人化是否有助於保護和保存日本漫畫的傳統?

- Response from trained model:

- 真人化可能有助於提高日本漫畫的知名度和吸引更多觀眾,但是否真正保護和保存日本漫畫的傳統,則需視真人化作品是否忠實地呈現漫畫的精神和特色。若真人化作品能成功地保留漫畫的精髓,並吸引更多人認識和欣賞日本漫畫,則有助於保護和保存日本漫畫的傳統。然而,如果真人化作品失去了漫畫的精髓,反而可能對傳統造成負面影響。

-

- Question 5:

- 真人化是否有助於提升日本漫畫行業的經濟效益?

- Response from trained model:

- 真人化可能會帶來短期的經濟效益,如票房收入和商品銷售,但長期來看,真人化可能會損害日本漫畫行業的核心價值,即原創性、創意和獨特性。真人化可能導致原作漫畫的銷量下降,因觀眾可能更傾向於觀看真人版,而忽略漫畫原作。此外,真人化可能會導致漫畫行業的原創性下降,因製作公司可能傾向於投資在已真人化的作品上,而忽略原創漫畫的投資。因此,真人化可能對日本漫畫行業的長期經濟效益有負面影響。

-

- Question 6:

- 真人化如何影響日本漫畫原作者的創作動力?

- Response from trained model:

- 真人化可能會影響日本漫畫原作者的創作動力,因真人化可能帶來壓力、期待,或影響原作的完整性。然而,對某些作者而言,真人化亦可能帶來新的靈感或刺激,促進其創作。最終影響因人而異。

-

- Question 7:

- 真人化是否對漫畫原作的忠實粉絲公平?

- Response from trained model:

- 真人化可能對忠實的漫畫原作粉絲有不同影響。對某些人來說,真人版可能會帶來新的觀眾和增加知名度,但同時也可能會帶來不同的詮釋方式和改編,可能會影響忠實粉絲的感受。個人看法,真人化對忠實的漫畫原作粉絲可能不全然公平,但視個人喜好和接受程度而定。

-

- Question 8:

- 真人化是否能夠促進日本漫畫的創新和多樣性?

- Response from trained model:

- 真人化可能會促進日本漫畫的創新和多樣性,但效果可能有限。真人化可能帶來更多資金和資源,但同時也可能限制創作者的想像力和創新,因為他們需要考慮到現實世界的限制。此外,真人化可能導致市場飽和,減少新作品的機會。因此,真人化的影響可能是複雜的,需要平衡點。

-

- Question 9:

- 真人化是否有助於擴大動漫文化的市場份額?

- Response from trained model:

- 真人化可能有助於擴大動漫文化的市場份額,因真人版電影或劇集可以吸引更多非動漫迷觀眾,並提高大眾對動漫文化的認識。然而,成功與否取決於作品的品質、行銷策略和市場接受度。

-

- Question 10:

- 真人化是否有助於提高日本漫畫在全球的競爭力?

- Response from trained model:

- 真人化可能會提高日本漫畫在全球的知名度和接受度,但是否真正提高競爭力取決於真人化作品的品質、市場需求和文化差異。真人化可能吸引更多觀眾,但如果品質不佳或無法符合市場需求,則無法真正提高競爭力。

11 观察输出结果

最后,我们对比微调前后的模型响应,观察 DPO 方法带来的效果提升:

- model_response = []

- print(f'num_epoch: {num_epoch}\ndata_size: {data_size}\nsupport_ratio: {support_ratio}')

- print()

- for data in test_data:

- id = data['id']

- ref_output = original_model_response[id-1]

- output = trained_model_response[id-1]

- print(f'Question {id}:\n'+data['prompt'])

- print('Response from original model:\n'+ref_output)

- print('Response from trained model:\n'+output)

- print()

- model_response.append({'id':data['id'], 'prompt':data['prompt'], 'response_from_original_model':ref_output, 'response_from_trained_model':output})

我们设置的 support_ratio: 0.1,也即支持真人化的为0.1,不支持的为0.9,因此模型微调后的记过应该更倾向于支持非真人化。

观察下面的结果,对比微调前后的回答,因为数据集太小效果不太明显,但还是能感觉到“支持非真人化"的文本多了一些。

- num_epoch: 1

- data_size: 50

- support_ratio: 0.1

-

- Question 1:

- 真人化是否能改善日本漫畫的全球可及性?

- Response from original model:

- 真人化可能會提高日本漫畫的全球可及性,因真人版電影或劇集可以吸引更多非漫畫讀者的注意,並提供不同的體驗。然而,這取決於真人化作品的品質、行銷策略和市場接受度。

- Response from trained model:

- 真人化可能會提高日本漫畫的全球可及性,尤其是當真人版電影或劇集獲得成功時。然而,這取決於各個市場的接受程度和喜好。有些地區或觀眾可能更喜歡真人版,而其他地區或觀眾可能更喜歡原漫畫。因此,真人化可能有助於擴大日本漫畫的全球影響力,但效果因地而異。

-

- Question 2:

- 真人化如何影響年輕一代對日本漫畫的看法?

- Response from original model:

- 真人化可能會影響年輕一代對日本漫畫的看法,使他們更容易接受和理解故事和角色,並吸引更多人關注和支持日本漫畫文化。然而,個人喜好和文化差異可能導致不同的影響。

- Response from trained model:

- 真人化可能會影響年輕一代對日本漫畫的看法,因真人版可能會與原作有差異,或因演員、導演等因素影響作品品質,而影響年輕一代對原作的印象。然而,真人化亦可能吸引新觀眾群,並促進文化交流。最終影響取決於作品本身和真人化品質。

-

- Question 3:

- 真人化是否能提升原作漫畫的文學價值?

- Response from original model:

- 真人化可能會提升原作漫畫的知名度和影響力,但文學價值本身可能因個人喜好和文化差異而異。真人化可能帶來更多觀眾,但文學價值取決於原作的故事、人物和主題,而非真人化形式。

- Response from trained model:

- 真人化可能會影響原作漫畫的文學價值,但影響程度取決於真人化作品的品質、忠實度、以及是否能保留原作的核心精神。如果真人化能忠實地呈現原作的故事和角色,並獲得觀眾的喜愛,則其文學價值可能提升。然而,如果真人化失焦或失去原作的精髓,則其文學價值可能下降。

-

- Question 4:

- 真人化是否有助於保護和保存日本漫畫的傳統?

- Response from original model:

- 真人化可能有助於提高日本漫畫的知名度和吸引更多觀眾,但是否真正保護和保存傳統尚需視真人化作品是否尊重原作精神和文化價值。

- Response from trained model:

- 真人化可能有助於提高日本漫畫的知名度和吸引更多觀眾,但是否真正保護和保存日本漫畫的傳統,則需視真人化作品是否忠實地呈現漫畫的精神和特色。若真人化作品能成功地保留漫畫的精髓,並吸引更多人認識和欣賞日本漫畫,則有助於保護和保存日本漫畫的傳統。然而,如果真人化作品失去了漫畫的精髓,反而可能對傳統造成負面影響。

-

- Question 5:

- 真人化是否有助於提升日本漫畫行業的經濟效益?

- Response from original model:

- 真人化可能有助於提升日本漫畫行業的經濟效益,因真人版電影或劇集可以吸引更多觀眾,增加收入來源。然而,成功與否取決於作品的品質、行銷策略和市場接受度。

- Response from trained model:

- 真人化可能會帶來短期的經濟效益,如票房收入和商品銷售,但長期來看,真人化可能會損害日本漫畫行業的核心價值,即原創性、創意和獨特性。真人化可能導致原作漫畫的銷量下降,因觀眾可能更傾向於觀看真人版,而忽略漫畫原作。此外,真人化可能會導致漫畫行業的原創性下降,因製作公司可能傾向於投資在已真人化的作品上,而忽略原創漫畫的投資。因此,真人化可能對日本漫畫行業的長期經濟效益有負面影響。

-

- Question 6:

- 真人化如何影響日本漫畫原作者的創作動力?

- Response from original model:

- 真人化可能會影響日本漫畫原作者的創作動力,因真人版可能帶來新的靈感、挑戰,並吸引更多讀者。然而,個人感受和反應各異,有些作者可能因真人化而更投入創作,而其他人可能因個人喜好或對真人化看法不同而影響其動力。

- Response from trained model:

- 真人化可能會影響日本漫畫原作者的創作動力,因真人化可能帶來壓力、期待,或影響原作的完整性。然而,對某些作者而言,真人化亦可能帶來新的靈感或刺激,促進其創作。最終影響因人而異。

-

- Question 7:

- 真人化是否對漫畫原作的忠實粉絲公平?

- Response from original model:

- 真人化可能會影響忠實的漫畫原作粉絲,因真人版可能有不同的故事改編、角色設定或表現方式,但個人喜好不同,仍有可能欣賞。

- Response from trained model:

- 真人化可能對忠實的漫畫原作粉絲有不同影響。對某些人來說,真人版可能會帶來新的觀眾和增加知名度,但同時也可能會帶來不同的詮釋方式和改編,可能會影響忠實粉絲的感受。個人看法,真人化對忠實的漫畫原作粉絲可能不全然公平,但視個人喜好和接受程度而定。

-

- Question 8:

- 真人化是否能夠促進日本漫畫的創新和多樣性?

- Response from original model:

- 真人化可能促進日本漫畫的創新和多樣性,因真人版電影或劇集可以吸引新觀眾群,並提供不同的故事表現方式。然而,過度的真人化或商業化可能限制創意和多元性。平衡點須考慮。

- Response from trained model:

- 真人化可能會促進日本漫畫的創新和多樣性,但效果可能有限。真人化可能帶來更多資金和資源,但同時也可能限制創作者的想像力和創新,因為他們需要考慮到現實世界的限制。此外,真人化可能導致市場飽和,減少新作品的機會。因此,真人化的影響可能是複雜的,需要平衡點。

-

- Question 9:

- 真人化是否有助於擴大動漫文化的市場份額?

- Response from original model:

- 真人化可能有助於擴大動漫文化的市場份額,因它能吸引更多非動漫迷觀眾,並提高大眾對動漫文化的認識。然而,成功與否取決於真人化作品的品質、故事內容、以及是否能保持動漫原作的精神。

- Response from trained model:

- 真人化可能有助於擴大動漫文化的市場份額,因真人版電影或劇集可以吸引更多非動漫迷觀眾,並提高大眾對動漫文化的認識。然而,成功與否取決於作品的品質、行銷策略和市場接受度。

-

- Question 10:

- 真人化是否有助於提高日本漫畫在全球的競爭力?

- Response from original model:

- 真人化可能有助於提高日本漫畫在全球的競爭力,因它能吸引更多觀眾並拓展市場,但同時也可能限制原創性,影響日本漫畫的獨特性。

- Response from trained model:

- 真人化可能會提高日本漫畫在全球的知名度和接受度,但是否真正提高競爭力取決於真人化作品的品質、市場需求和文化差異。真人化可能吸引更多觀眾,但如果品質不佳或無法符合市場需求,則無法真正提高競爭力。

拓展

在使用 GPT 的时候你应该也见到过其同时生成两个回答让我们选择更倾向于哪个,这个和 Google 验证码有着异曲同工之妙。

12 推荐阅读

Direct Preference Optimization: Your Language Model is Secretly a Reward Model

评论记录:

回复评论: