class="hljs-ln-code"> class="hljs-ln-line">git clone https://github.com/infiniflow/ragflow.git class="hljs-ln-numbers"> class="hljs-ln-line hljs-ln-n" data-line-number="2"> class="hljs-ln-code"> class="hljs-ln-line">cd ragflow/docker class="hljs-ln-numbers"> class="hljs-ln-line hljs-ln-n" data-line-number="3"> class="hljs-ln-code"> class="hljs-ln-line">docker compose -f docker-compose-CN.yml up -d class="hljs-button signin active" data-title="登录复制" data-report-click="{"spm":"1001.2101.3001.4334"}" onclick="hljs.signin(event)">

核心文件大小约为9GB,需要一段时间才能完成加载,完成后可执行以下命令检测服务器状态:

docker logs -f ragflow-server class="hljs-button signin active" data-title="登录复制" data-report-click="{"spm":"1001.2101.3001.4334"}" onclick="hljs.signin(event)">

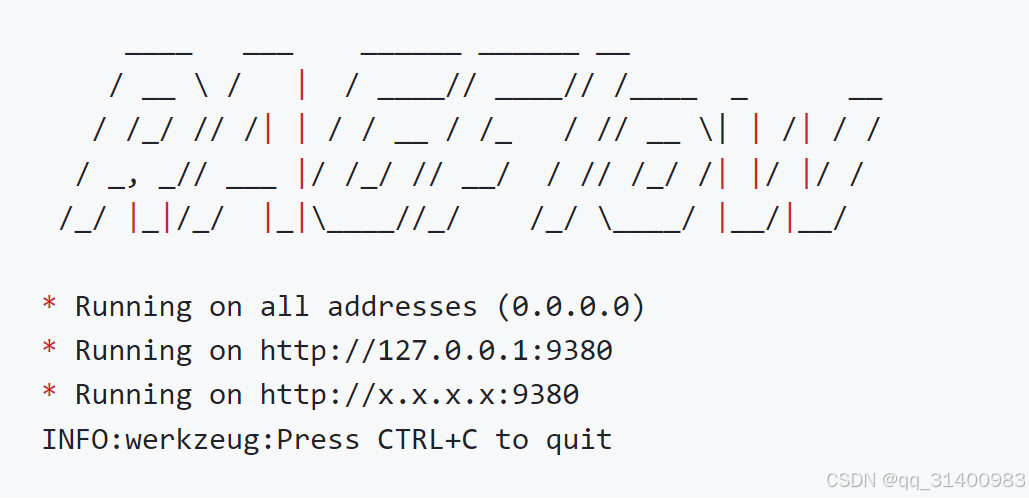

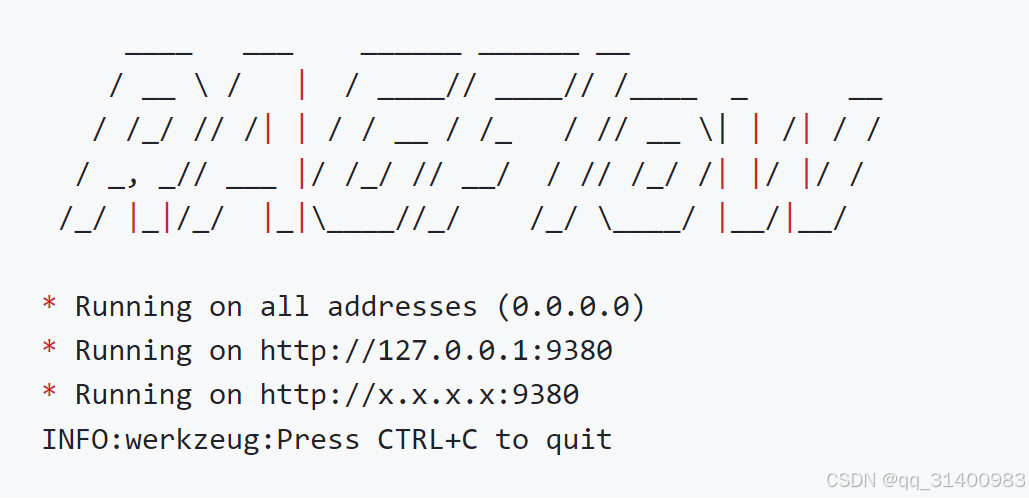

执行命令后如显示以下图形,表示安装成功。

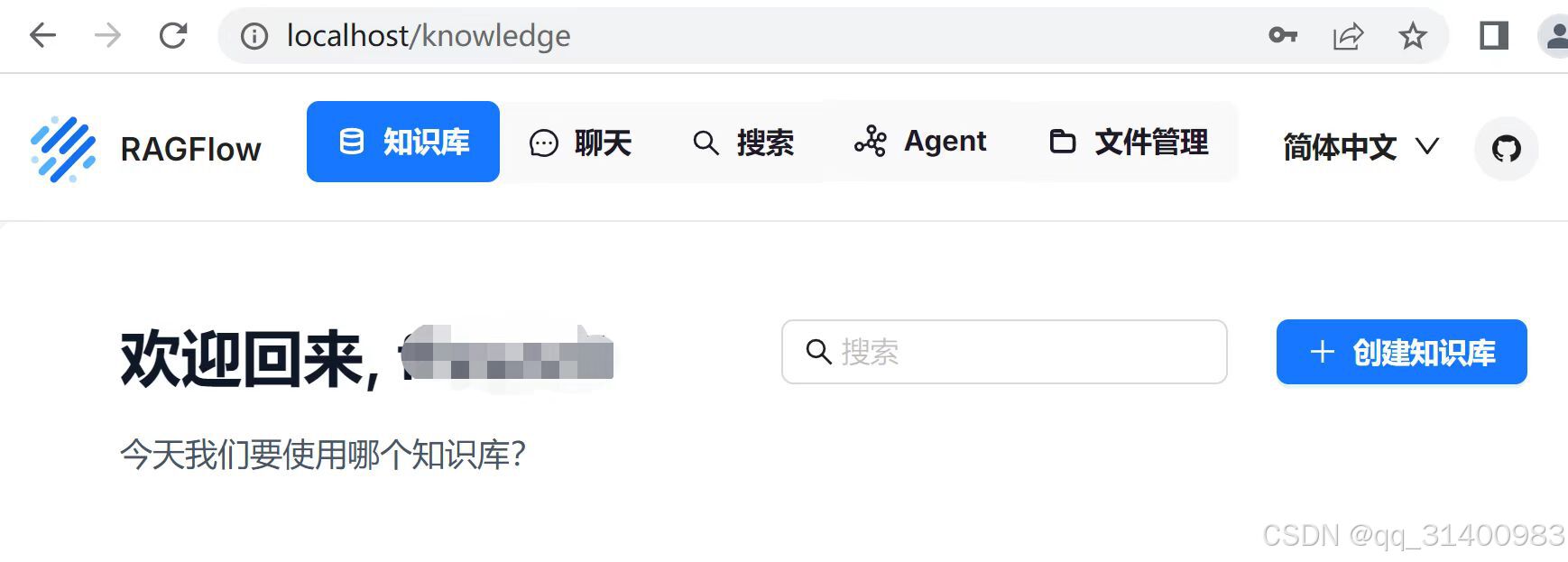

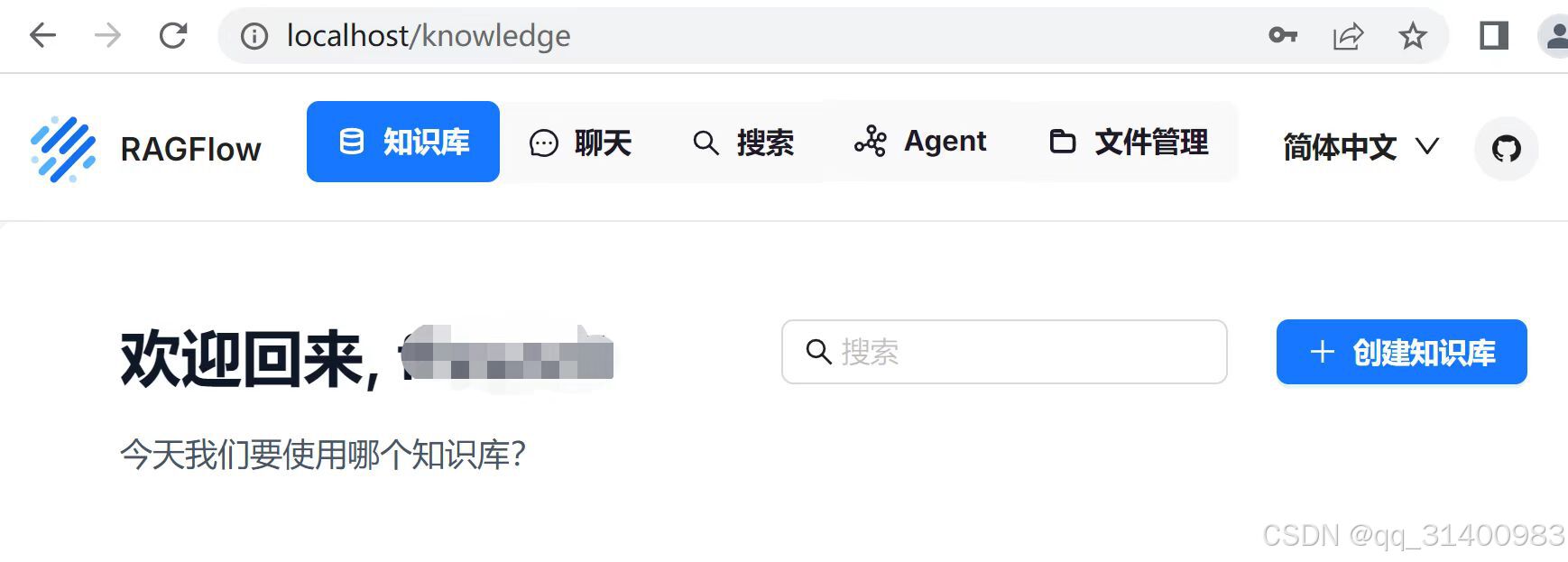

然后网络浏览器中,输入服务器的IP地址(http://localhost/)即可登录RAGFlow(首次登录需进行注册)登录后设置为简体中文。

6、在RAGFlow中配置模型

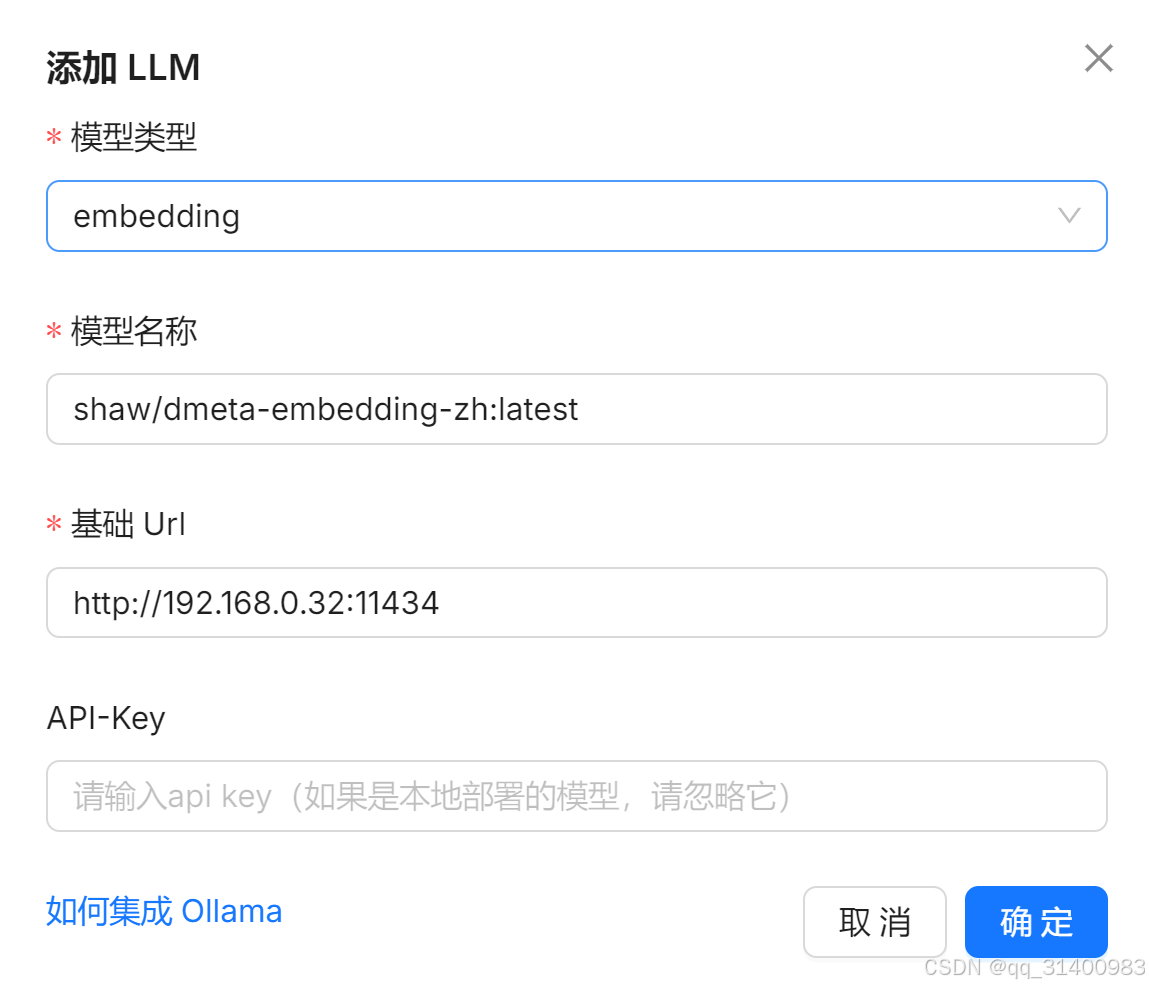

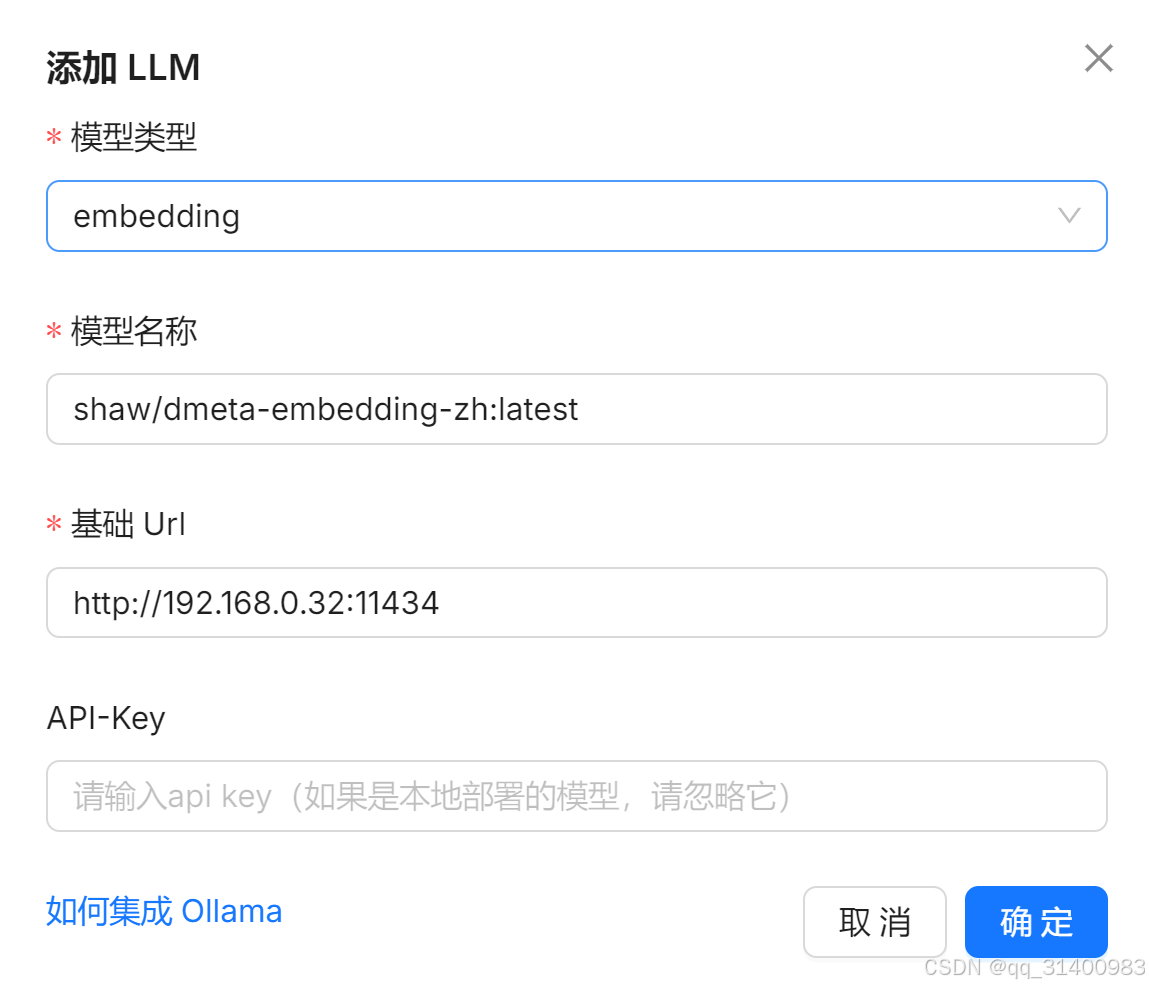

(1)配置embedding模型

点击右上角“设置”,选择“模型提供商”,选择Ollama并添加模型。

设置模型类型为“embedding”,输入模型名称和模型Url后“确定”即可(IP地址就是本机IP,默认端口为11434)。

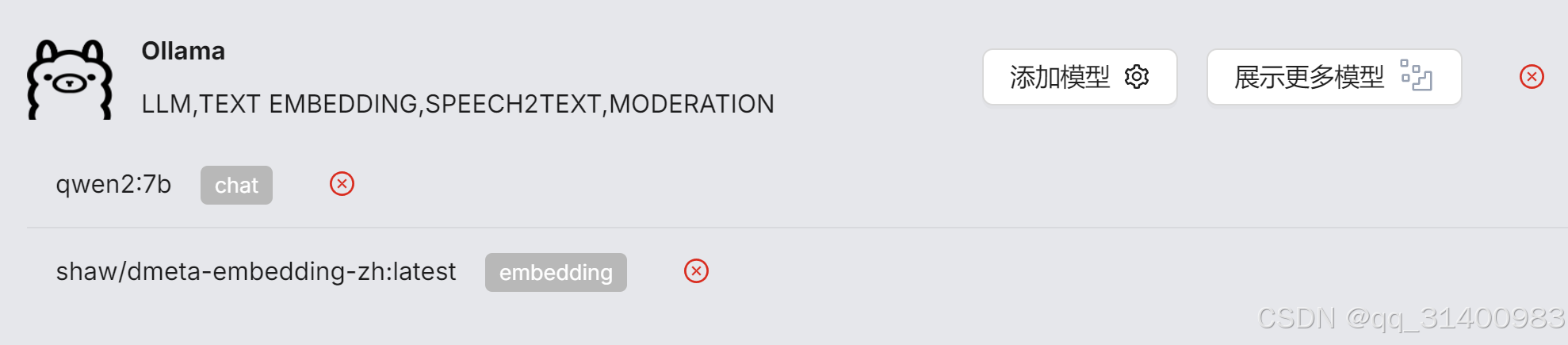

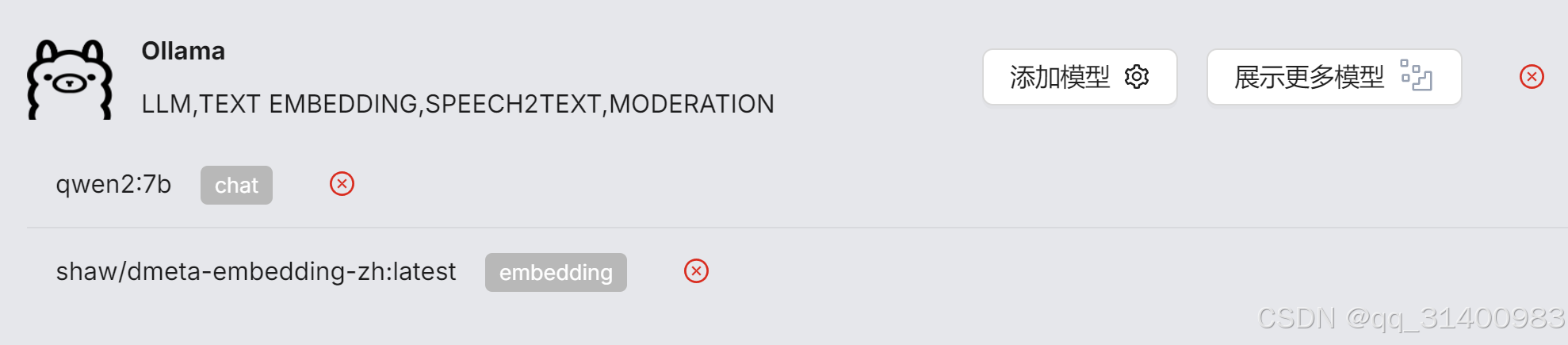

(2)配置chat模型

配置方法同上。

配置好模型后,可选择Ollama“展示更多模型”查看。

7、在RAGFlow中配置知识库

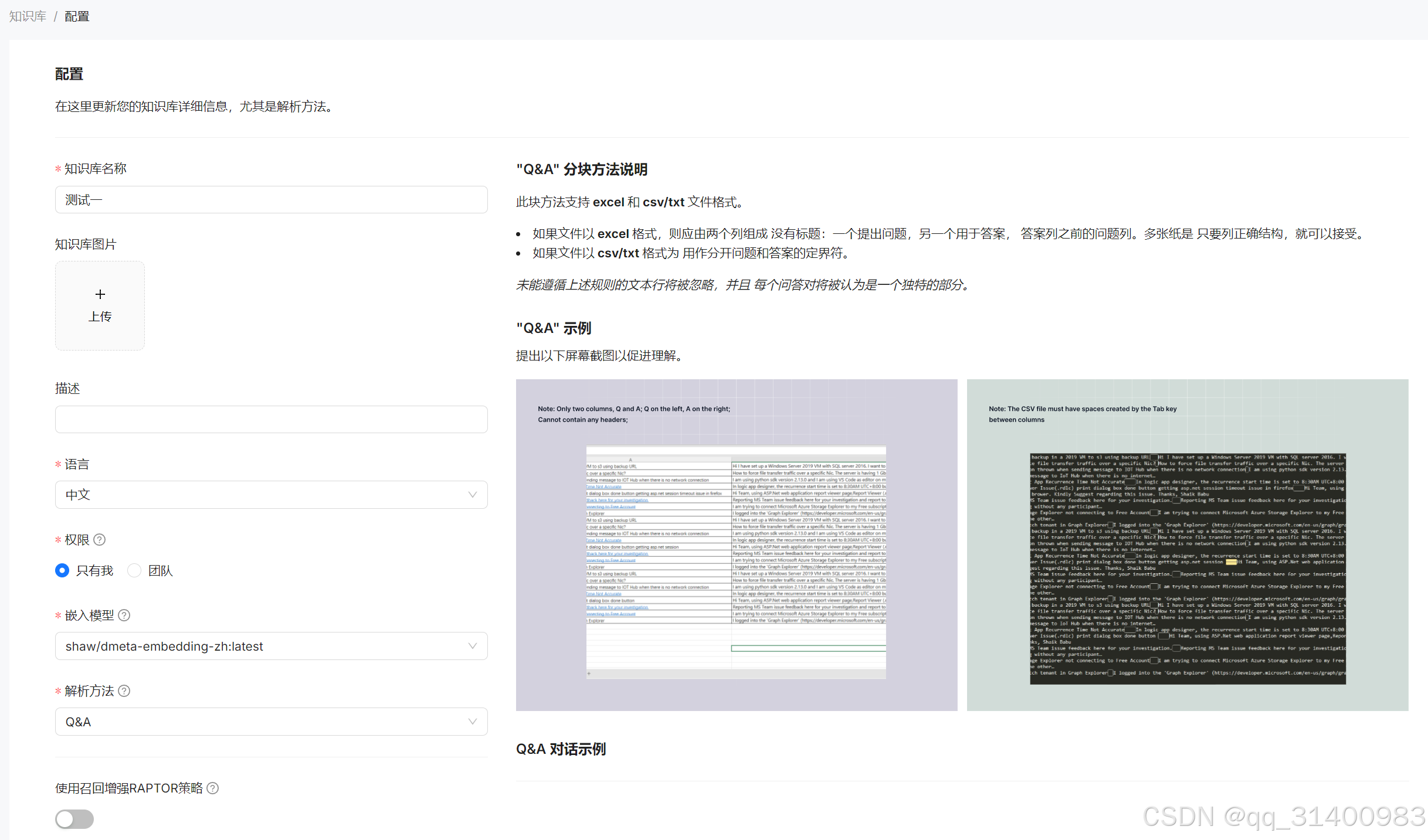

(1)创建知识库,选择模型

回到RAGFlow首页,进入“知识库”,选择“创建知识库”。

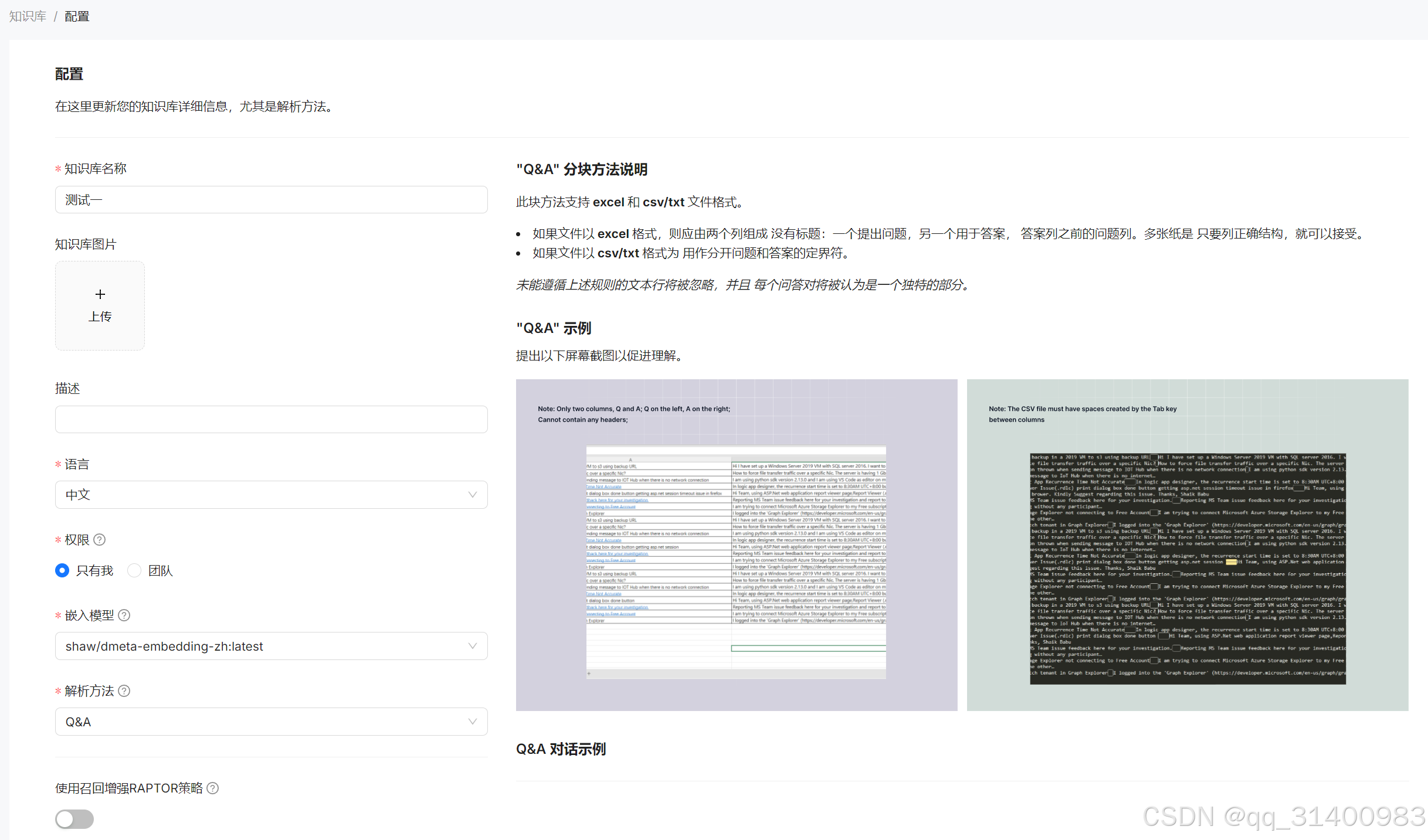

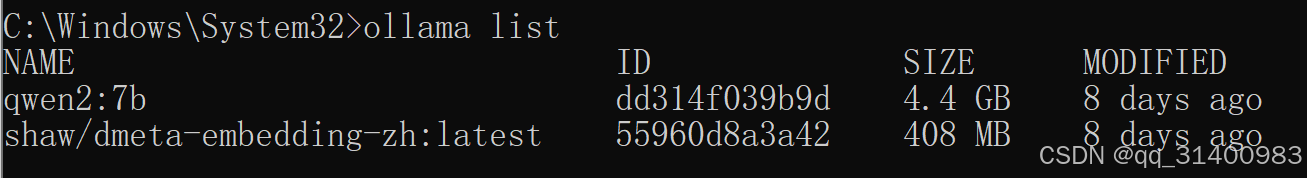

输入知识库名称,分别设置“语言”为“中文”、“嵌入模型”为“shaw/dmeta-embedding-zh:latest”。“解析方法”需根据自己创建的知识库类型进行选择,系统给出了每种方法的分块方法说明,以及支持的文件类型。

设置完成后“保存”。

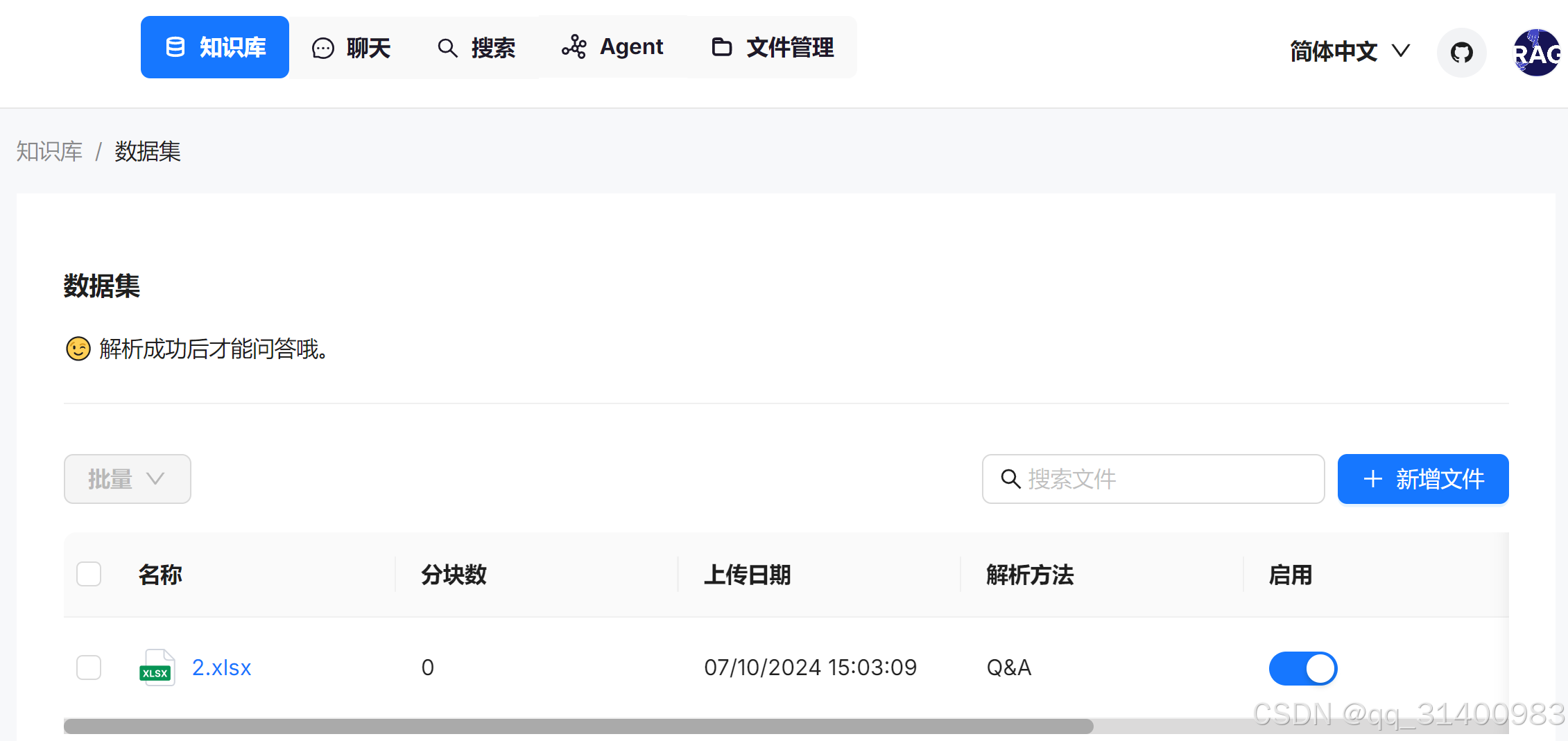

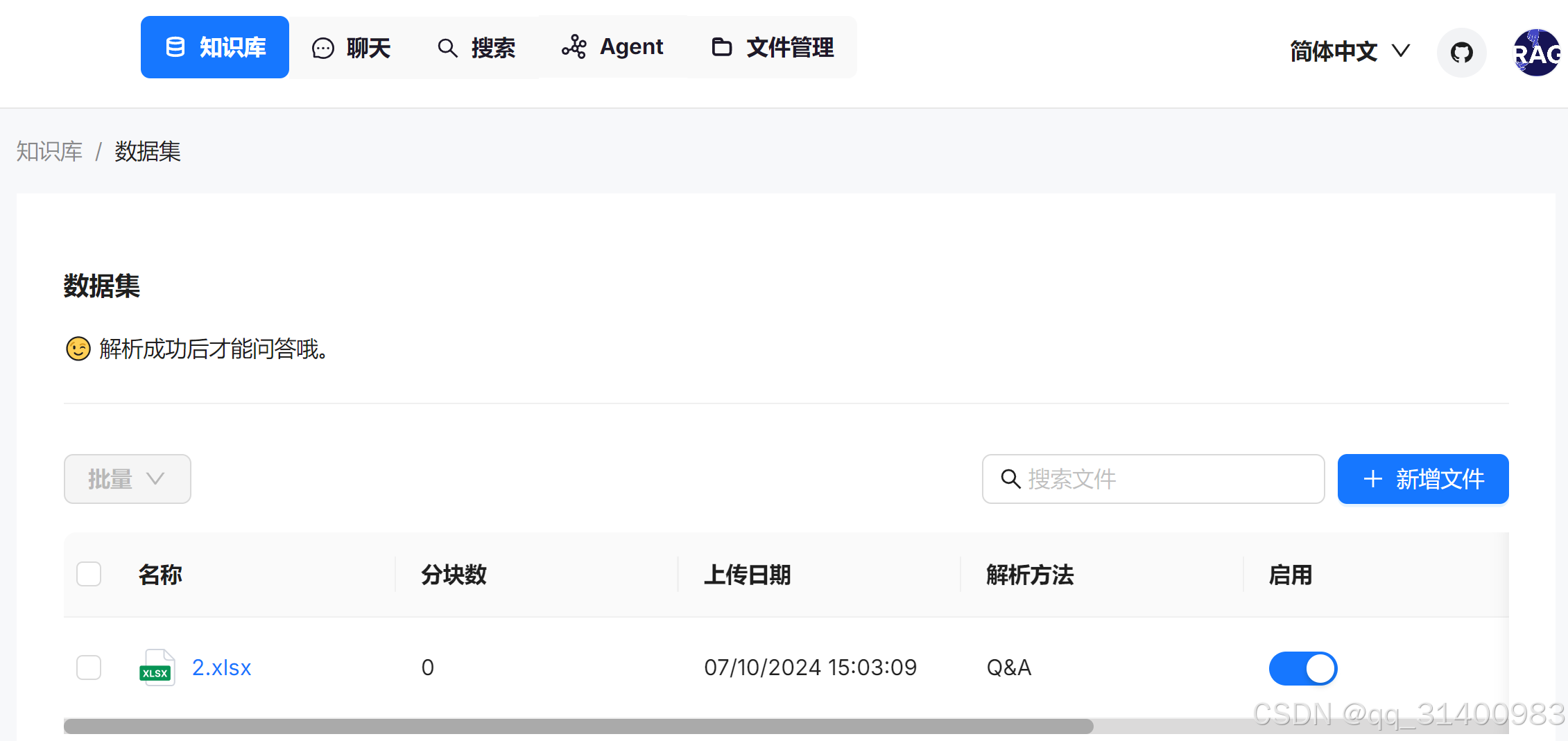

(2)上传知识库文件

保存知识库设置后,系统自动进入数据集设置,选择“新增文件”,加载本地需上传的知识库文件(文件格式要符合知识库设置时限定的文件格式)。

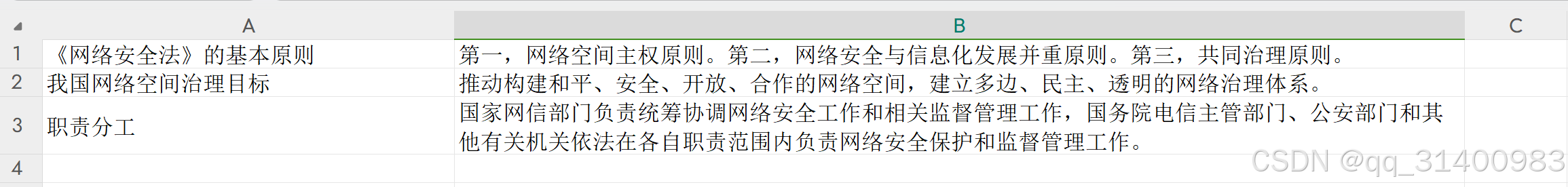

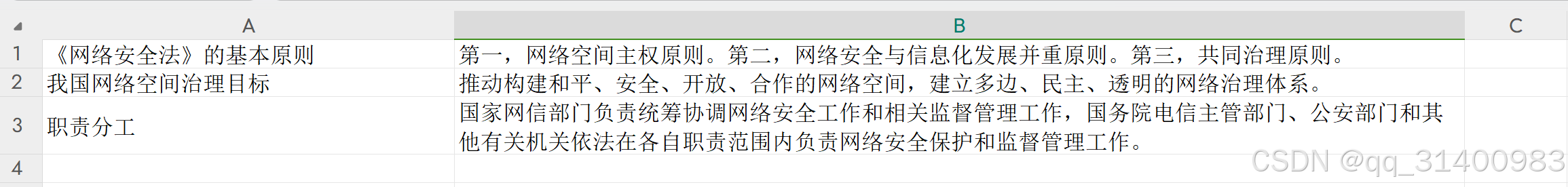

我这里是简单构建了一个关于网络安全法的问答数据集。

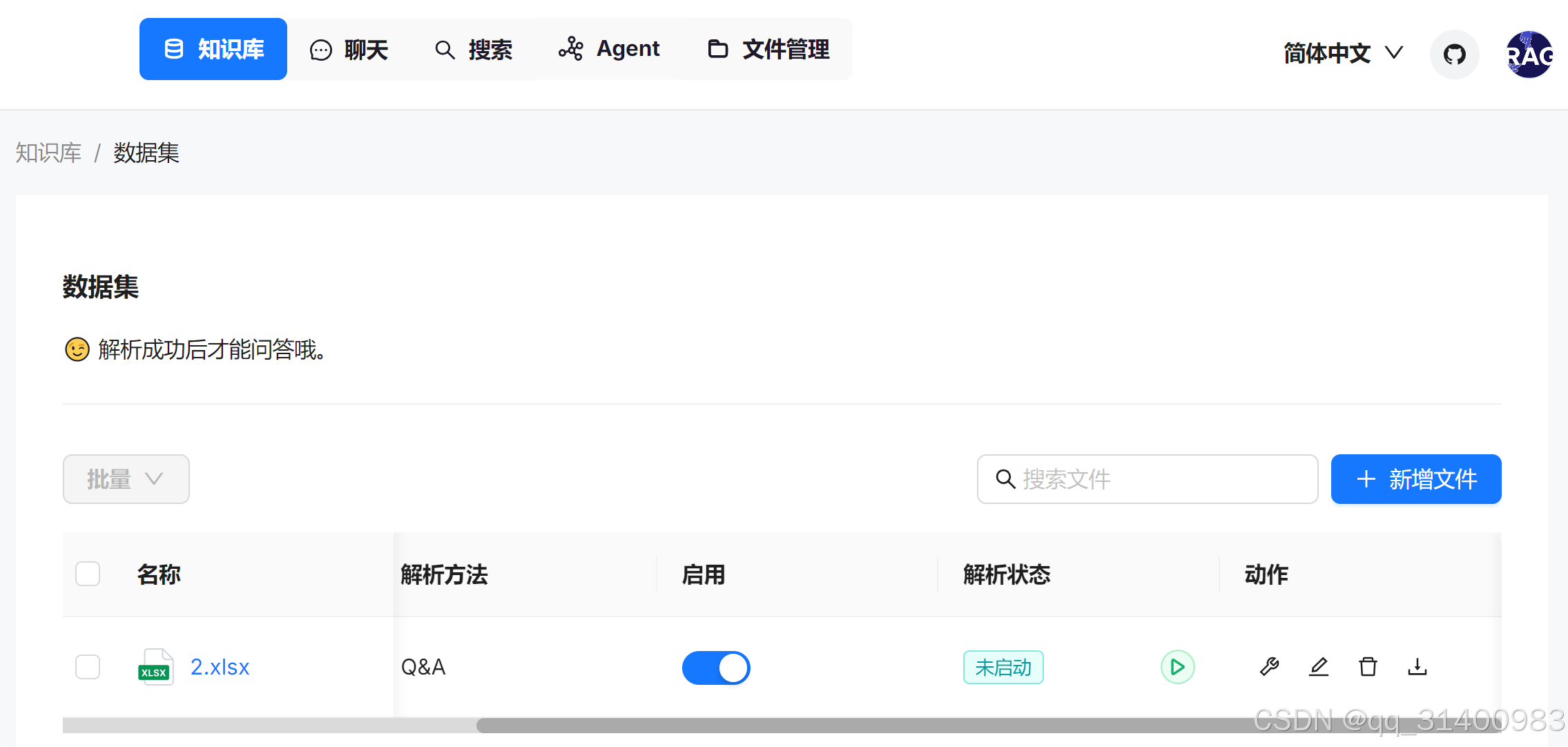

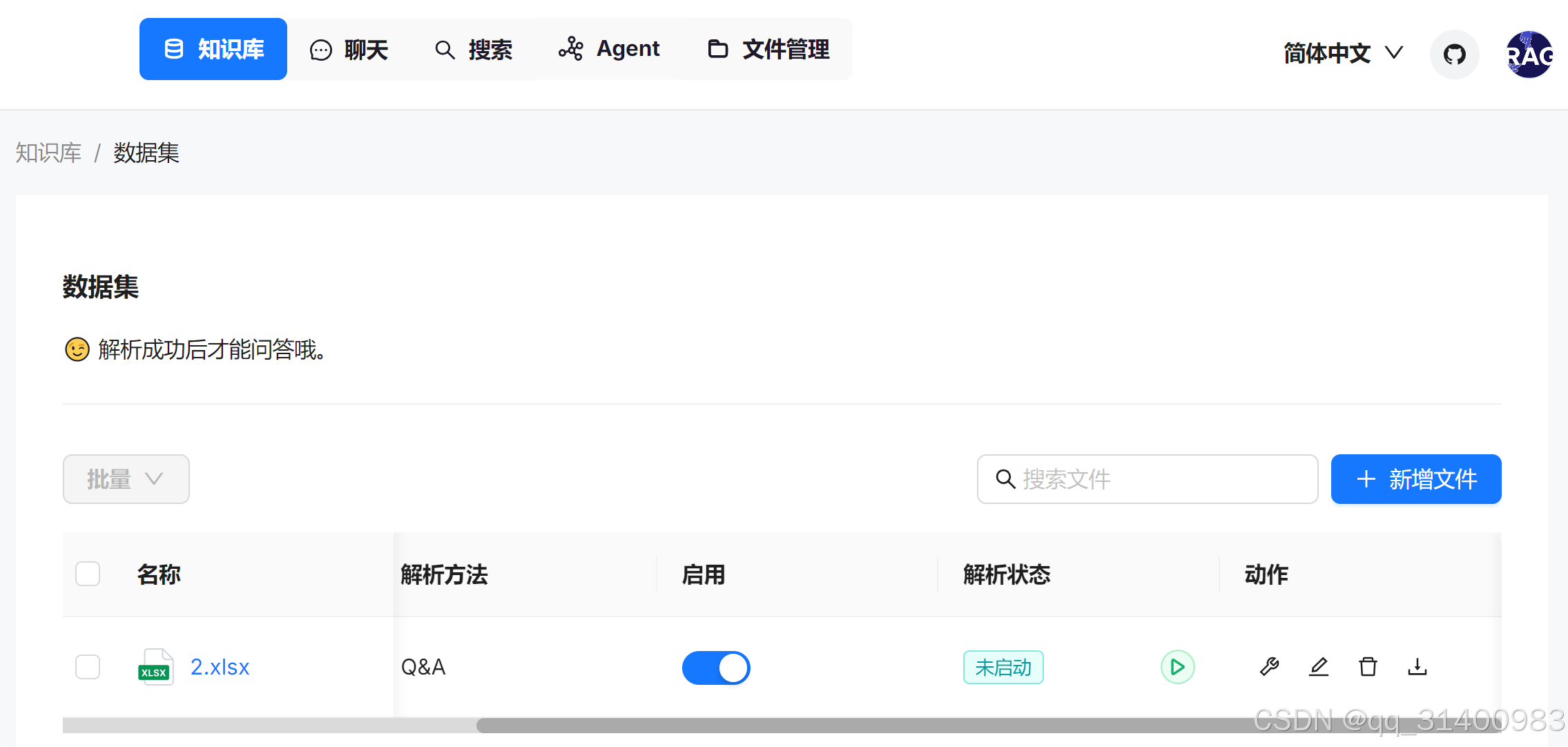

(3)解析文件

点击解析状态下的 开始解析文件,解析成功后就可以使用了。

开始解析文件,解析成功后就可以使用了。

8、知识库应用

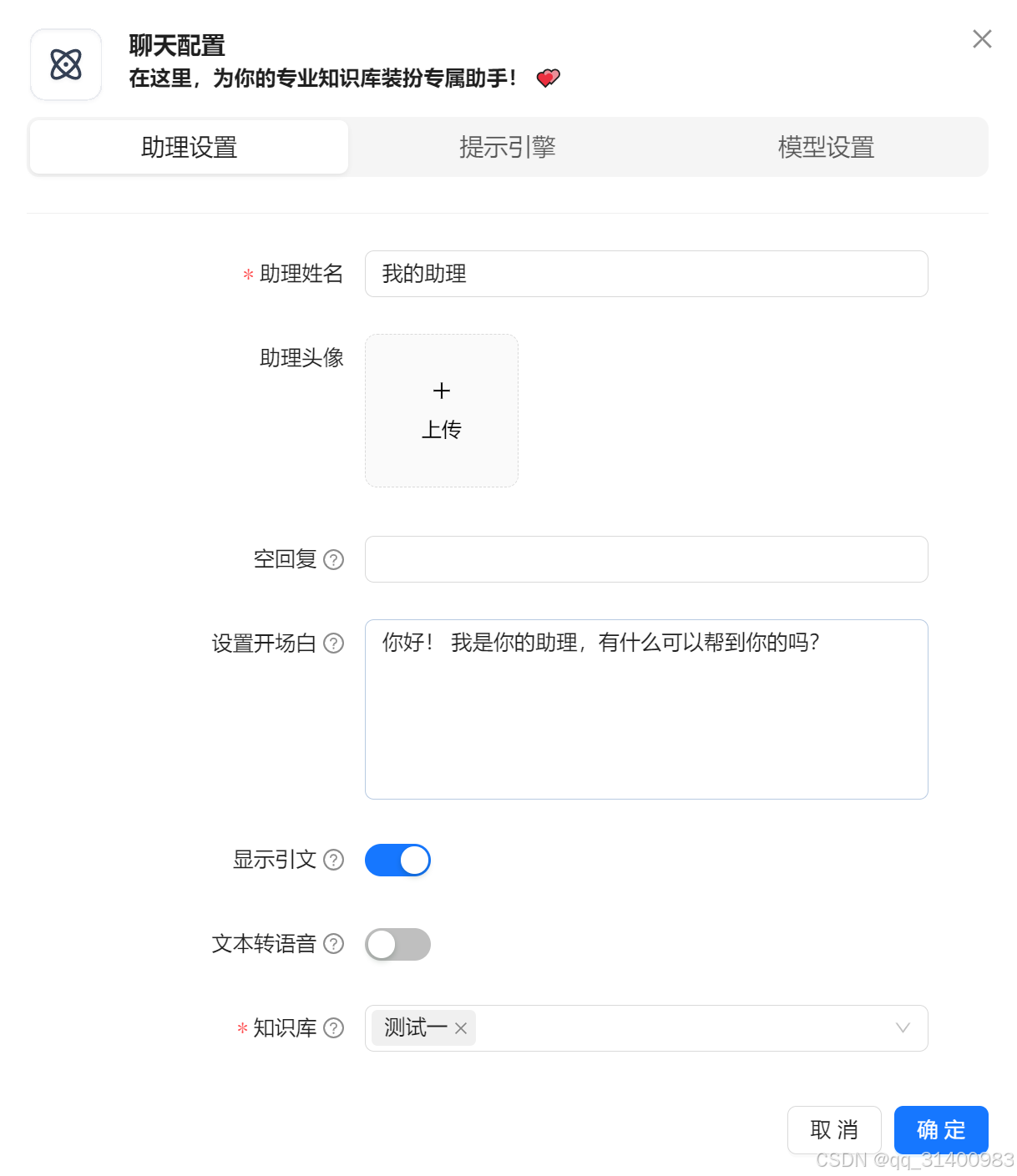

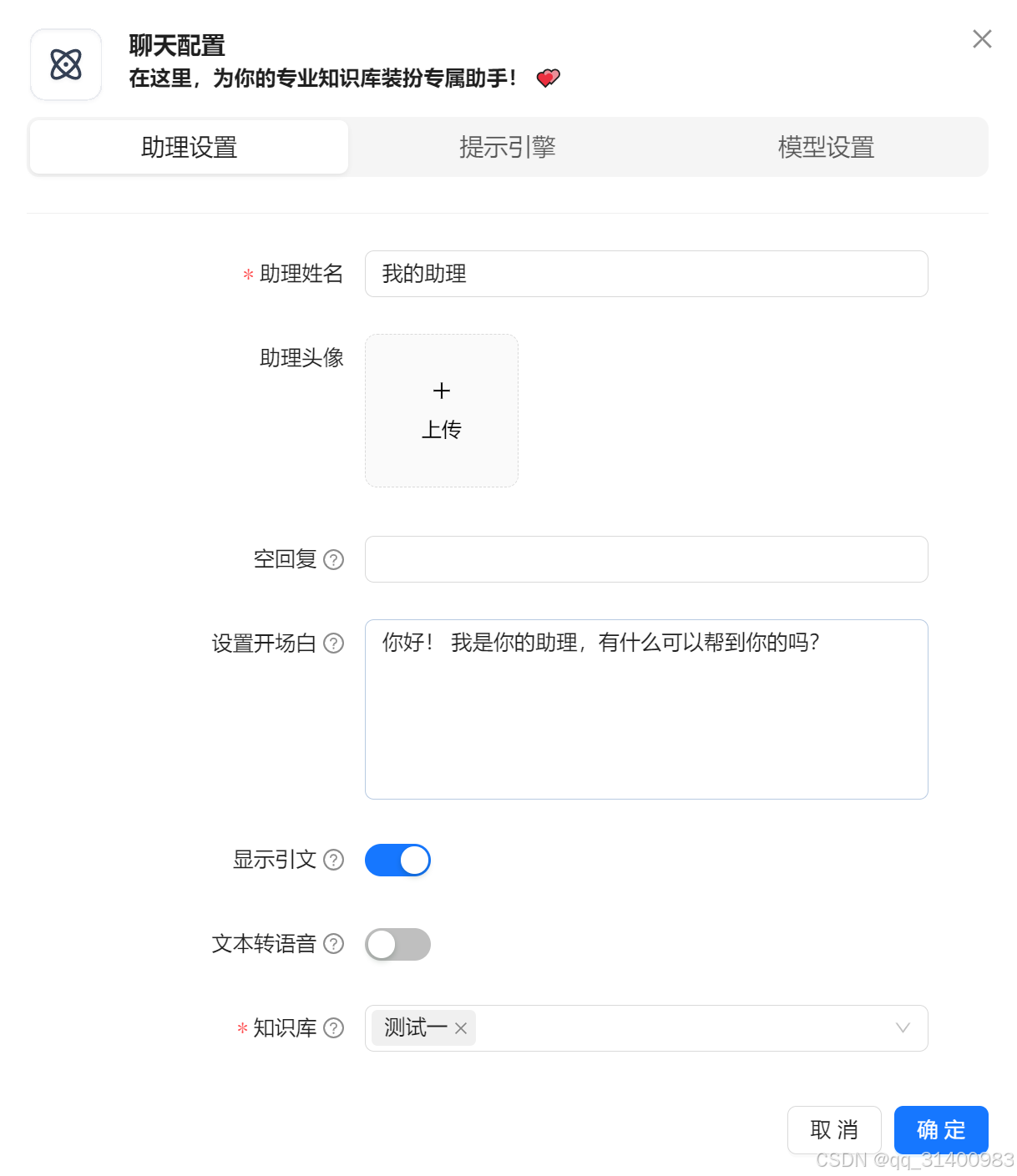

进入“聊天”,选择“新建助理”,在助理设置页面设置“助理姓名”,选择该助理要使用的知识库。

在模型设置页面选择要使用的模型,并选择“确定”。

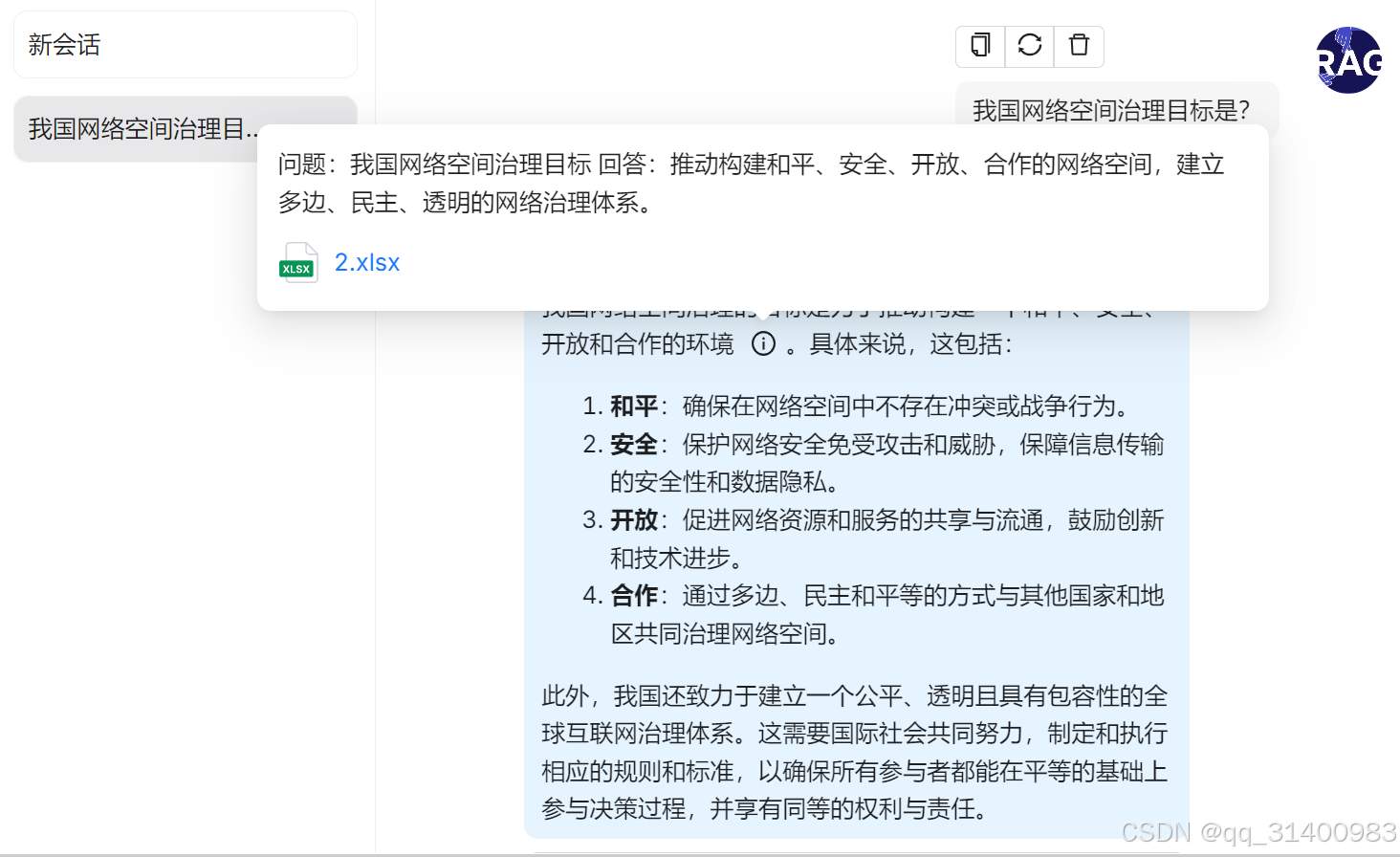

接下来就可以在聊天窗口开始使用集成了本地知识库的大模型了。

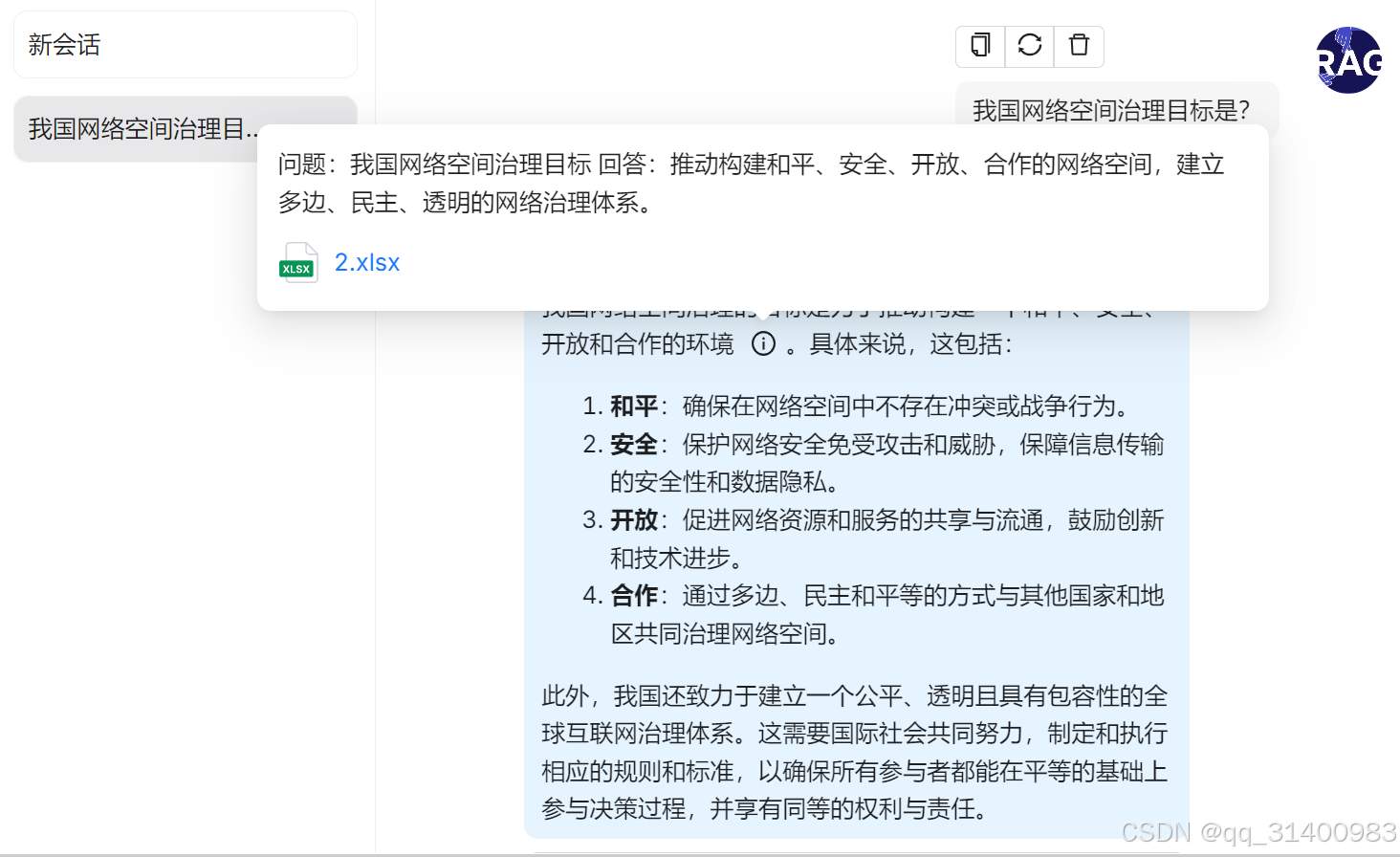

选择设置好的助理,提出问题。

系统回答问题时会注明使用到的知识库文件,鼠标移动到回答内容的 处,还会提示使用了知识库文件的哪些内容。

处,还会提示使用了知识库文件的哪些内容。

data-report-view="{"mod":"1585297308_001","spm":"1001.2101.3001.6548","dest":"https://blog.csdn.net/qq_31400983/article/details/142736594","extend1":"pc","ab":"new"}">>

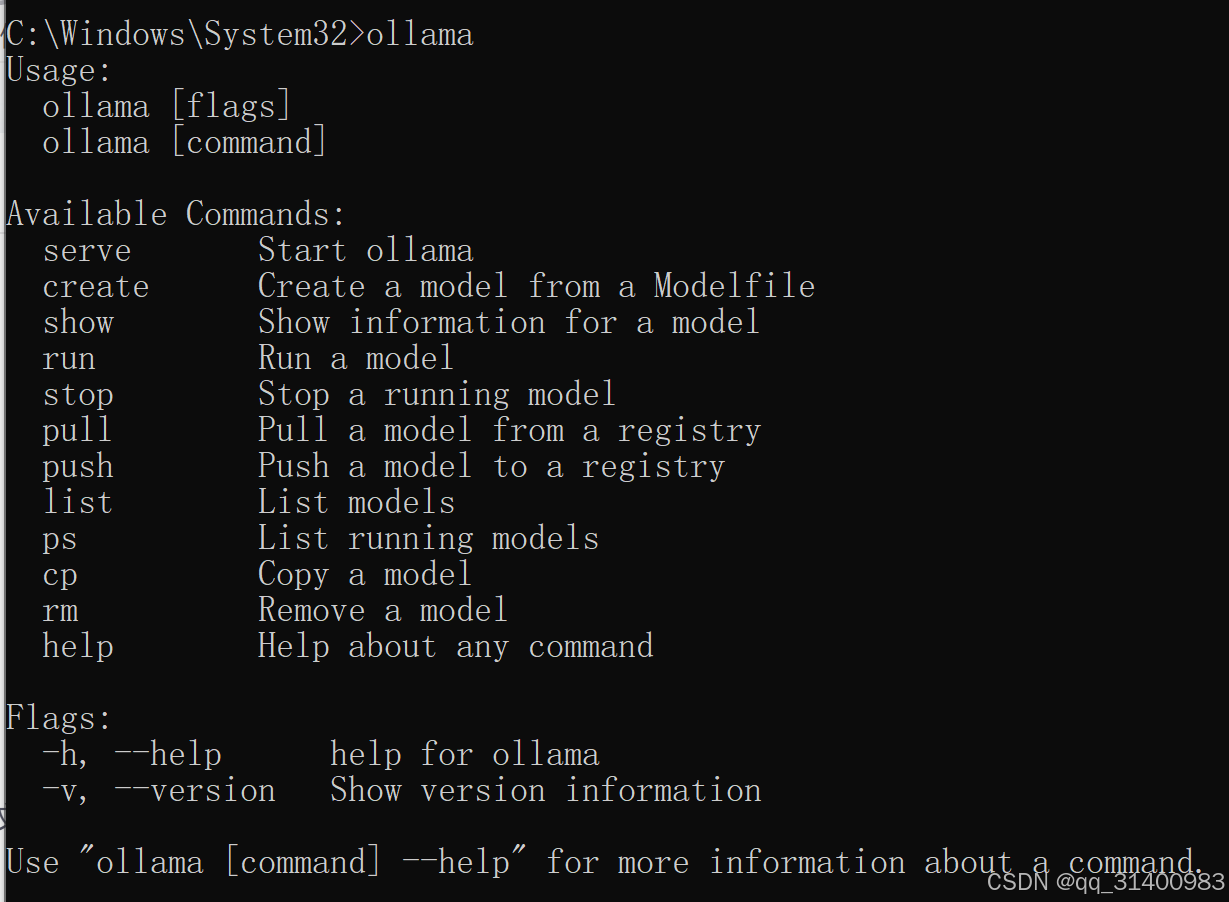

![]() 图标,启动cmd窗口直接输入Ollama,可以看到Ollama的主要命令及使用方法。

图标,启动cmd窗口直接输入Ollama,可以看到Ollama的主要命令及使用方法。

评论记录:

回复评论: