一、基本工具安装

二、VScode插件Debugger安装

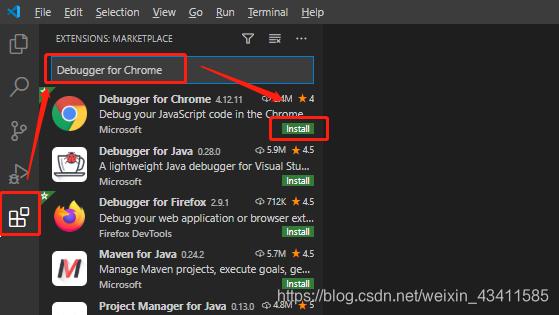

- 安装插件:

Debugger for Chrome

- PS:

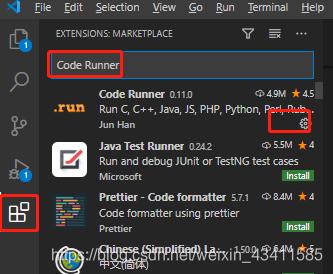

Code Runner插件可以运行各种文件;

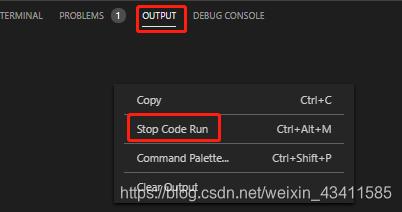

- PS:js文件运行卡死,要停止运行可右击Stop Code Run

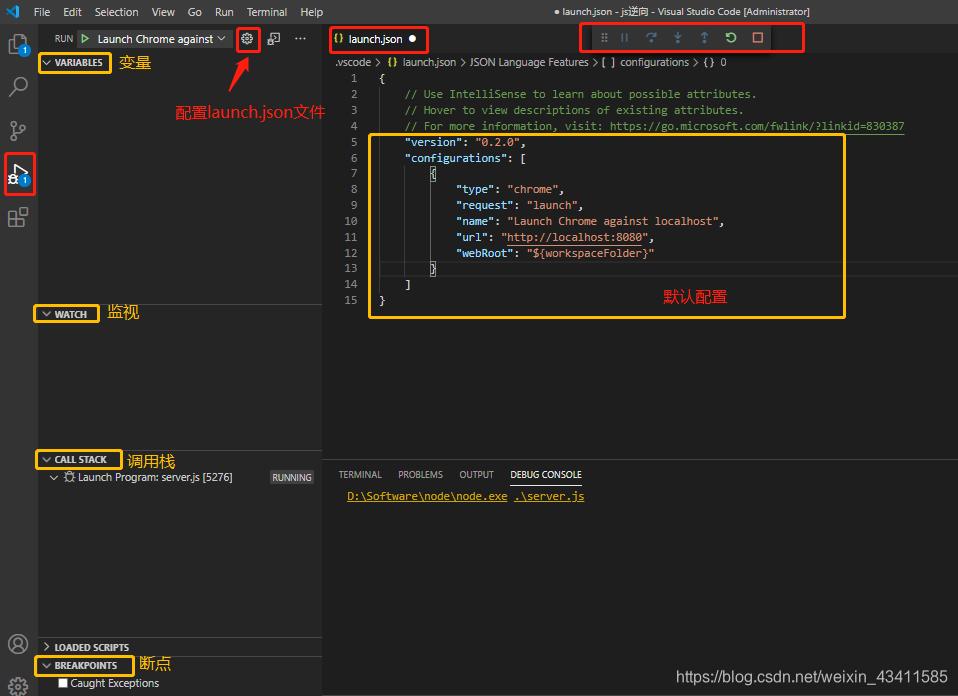

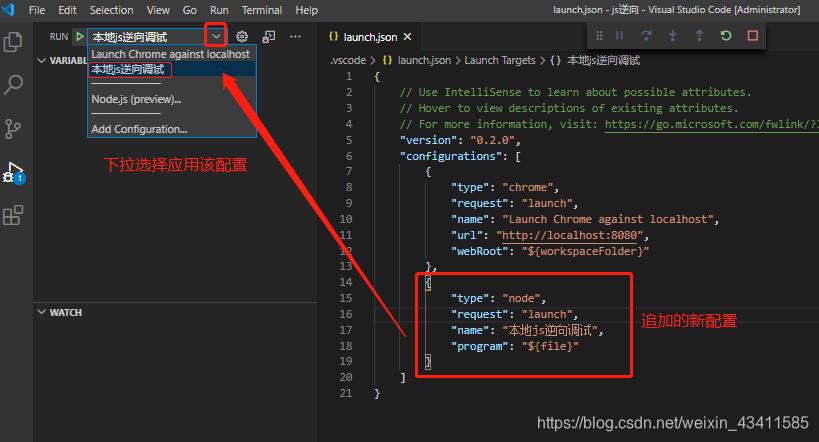

三、插件Debugger之launch.json文件配置

- 安装完成后,按F5键会跳出如下界,该界面与chrome开发者工具一致(原因:该插件会打开chrome浏览器,然后挂载到chrome进程,由浏览器处理这条语句并输出结果,然后再显示给vscode的调试器)

- 点击红色的齿轮设置配置修改launch.json文件,默认配置如下;

version:配置文件的版本,默认是0.2.0;configurations:配置域,所有配置都放在这个花括号里面type:调试工具的类型,vscode默认调试工具类型node,你也可以修改为其他name:每个调试配置的名称,可随意起名request:调试工具的启动方式,有launch和attach两种,直接启动本地服务或者挂载远程服务url:指定访问的链接webRoot:指定根目录或者执行文件

- 修改launch.json文件,追加一个配置如下即可直接调试当前打开的js文件

{

"type": "node",

"request": "launch",

"name": "本地js逆向调试",

"program": "${file}"

}

- 1

- 2

- 3

- 4

- 5

- 6

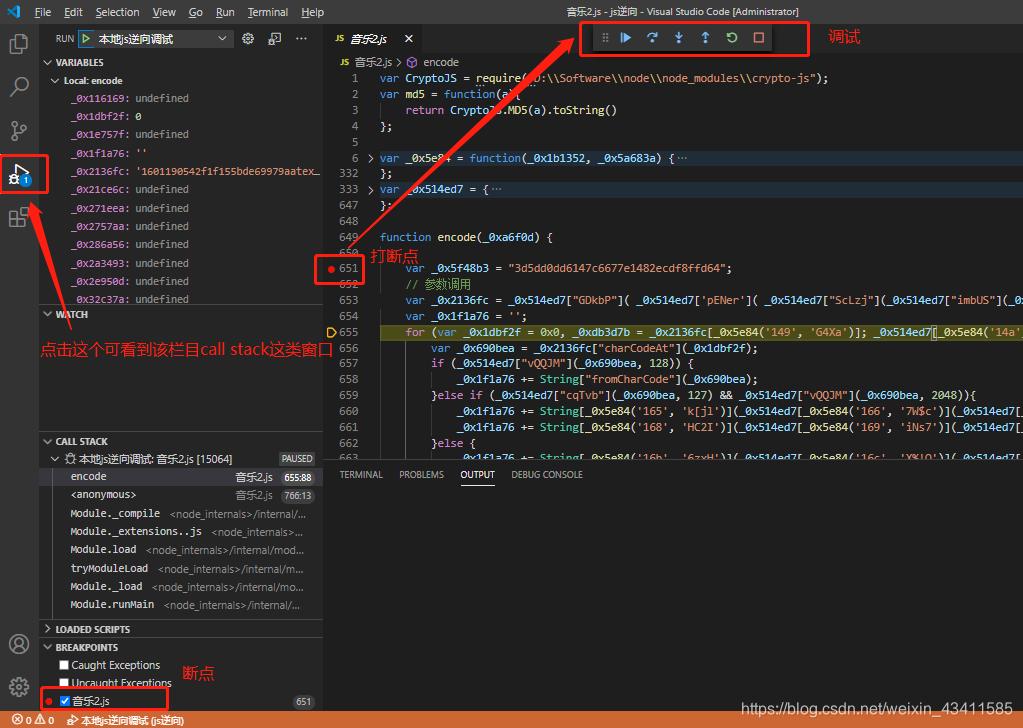

四、js调试应用

- 首先打开一个js文件》在序号左侧点击打断点》按F5即可调出调试界面》点击左侧三角形标识即可和chrome开发者工具一样调试js文件了

微信公众号

微信公众号

目录

一、探索“可解释人工智能”:AI如何从“黑箱”走向“透明大师”

2024年,人工智能(AI)与神经科学的碰撞引发了一个引人入胜的变革——可解释人工智能(XAI)成为提升决策透明度和理解复杂算法的“钥匙”。本篇文章将带你走进XAI的世界,探索从“特征”到“人性化”的方法演变,并通过一系列精彩的案例分析它在医疗、金融等领域的实际应用。我们还将揭开生成模型可解释性难题的面纱,讨论为什么负责任的AI是未来的必修课,同时聊聊如何在科技的浪潮中保持伦理的底线。

随着AI渐渐朝着通用人工智能(AGI)迈进,意识、伦理与社会影响这三个“炸药桶”也开始引发热议。但别担心,解码大脑的奥秘和追寻类人智能的道路,虽然挑战重重,但也正是我们站在科技与人文交汇的前沿,指引着未来认知的无限可能。让我们一起,带着好奇心和一点幽默,踏上这段探索之旅,总结下这一年度看过的优秀论文吧!

一、探索“可解释人工智能”:AI如何从“黑箱”走向“透明大师”

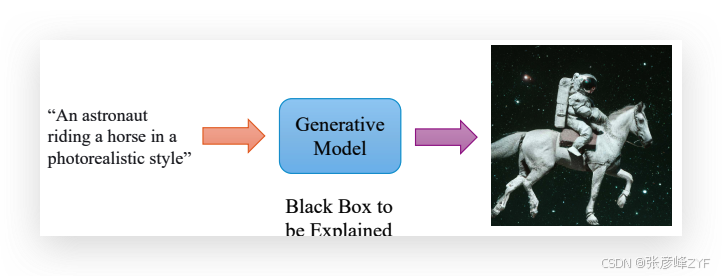

人工智能(AI)正以前所未有的速度发展,但随着它的普及,一个问题也越来越引起大家的关注:AI到底是怎么做决定的?在许多关键领域,比如医疗、金融,AI的决策可能关乎生命和财富,所以,理解它的决策过程变得至关重要。可解释人工智能(XAI)正是为了解决这个问题而诞生的,它试图让AI的决策变得更加透明、可追溯。

但是,理解AI可不是一件简单的事。你可能听过AI是一个“黑箱”,什么意思呢?简单来说,就是AI做出的决策和我们通常理解的思维过程相差甚远,看似不透明,甚至有点神秘。所以,我们需要一种“解密”的方法,让AI的“黑箱”变得不再那么难懂。

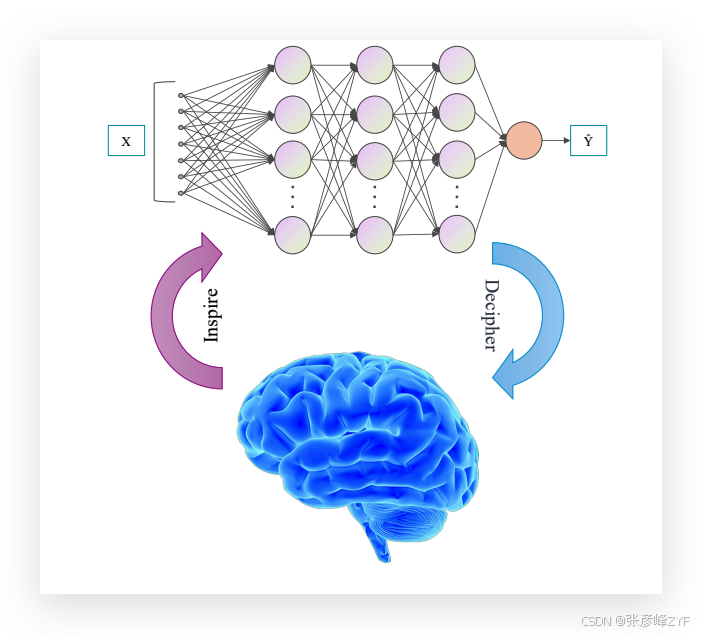

有趣的是,AI的学习过程竟然与我们人类大脑的运作有些相似。就像我们大脑通过不断的反复学习来改进思维方式,AI的神经网络也是通过类似的方式逐步“进化”,在不断“模仿”人脑的过程中,AI和神经科学的研究竟然开始互相启发。通过理解AI的运行机制,我们或许能更深入地了解人类的大脑。是不是很有意思?

不过,解开AI的谜团可不仅仅是技术上的挑战,它还涉及伦理、责任和社会影响。比如,当AI的决策越来越复杂时,假如它做出了错误的决定,应该由谁来负责?我们是不是该将责任从AI的创造者转移到AI本身?这些问题需要我们在AI发展的同时,也关注其可能带来的社会伦理问题。

让我们把目光投向未来,XAI不仅仅是为了让AI更“聪明”,它还在试图将人类的推理能力融入到AI系统中。这样一来,AI不仅仅是一个“决策机器”,它甚至能够像我们一样进行理性思考!这对于教育、医疗甚至法律系统的变革都有巨大的潜力。

总的来说,XAI正通过技术和认知科学的跨界合作,为AI走向“类人智能”(Human-Like Intelligence)铺路。我们不仅是在解锁AI的神秘面纱,也在探索人类认知的奥秘。未来的AI将不再只是一个程序,它可能会成为拥有自我意识、能与我们“心有灵犀”的智能伙伴。这条道路虽然充满挑战,但也无疑充满了激动人心的可能性。

二、走进可解释人工智能:让AI的决策变得透明

在AI的世界里,我们常常听到“黑箱”的概念——就是那些做出决策却无法理解其原因的神秘系统。而可解释人工智能(XAI)的目标正是让AI不再像个“谜一样的黑箱”,而是能像朋友一样告诉我们,它是如何做出决定的。为了实现这一点,XAI有很多方法,每种方法都有自己的特色和优缺点。

(一)几种常见的特征导向方法

在当前的XAI研究中,特征导向的可解释方法备受关注,它们通过从不同角度展示AI决策过程中的重要特征,帮助我们理解AI的“思维方式”。

-

SHAP(Shapley Additive Explanation):这是一种基于博弈论的技术,能同时保持局部和全局一致性,帮助我们分析每个特征对决策的贡献。简单来说,SHAP像是AI在做决策时,告诉我们每个“角色”的贡献,确保每个特征都能公平地“发言”。

-

类激活图(CAM)和渐变类激活图(Grad-CAM):这些方法主要应用于卷积神经网络(CNN),通过热图的形式高亮出对图像分类影响最大的区域。它们让我们能够“看到”AI关注的焦点区域,像是通过显微镜观察AI在做判断时看的重点。

-

Grad-CAM++:是Grad-CAM的“升级版”,它提供了更高的灵活性和更细致的细节,像是AI给我们提供了更清晰、更丰富的“思维过程图”。

-

全局归因映射(GAM):这种方法与众不同,它通过对不同群体进行聚类,揭示了AI在做决策时的全局模式。它可以让我们看到AI在大范围内如何考虑各种特征,而不仅仅是某个具体实例。

-

基于梯度的显著性图(Gradient-based Saliency Maps):这是一种通过计算梯度的绝对值来可视化图像分类中特征影响力的方法,就像给每个特征打分,突出显示它在分类中的重要性。

虽然这些方法都能帮助我们理解AI的决策,但它们依然面临着一些挑战。例如,它们通常能够指出决策影响的位置,但很难解答“为什么”和“如何”做出这样的决定,尤其是在一些复杂的非加性模型中,或者当输入中有相似对象时,AI可能会做出相同的判断。

这些方法各有千秋,虽然它们还没有完全解决AI决策的“透明”问题,但它们为我们提供了宝贵的工具,帮助我们一步步揭开AI决策的面纱。随着研究的不断深入,我们有理由相信,AI会越来越能清晰地告诉我们它的“心路历程”。

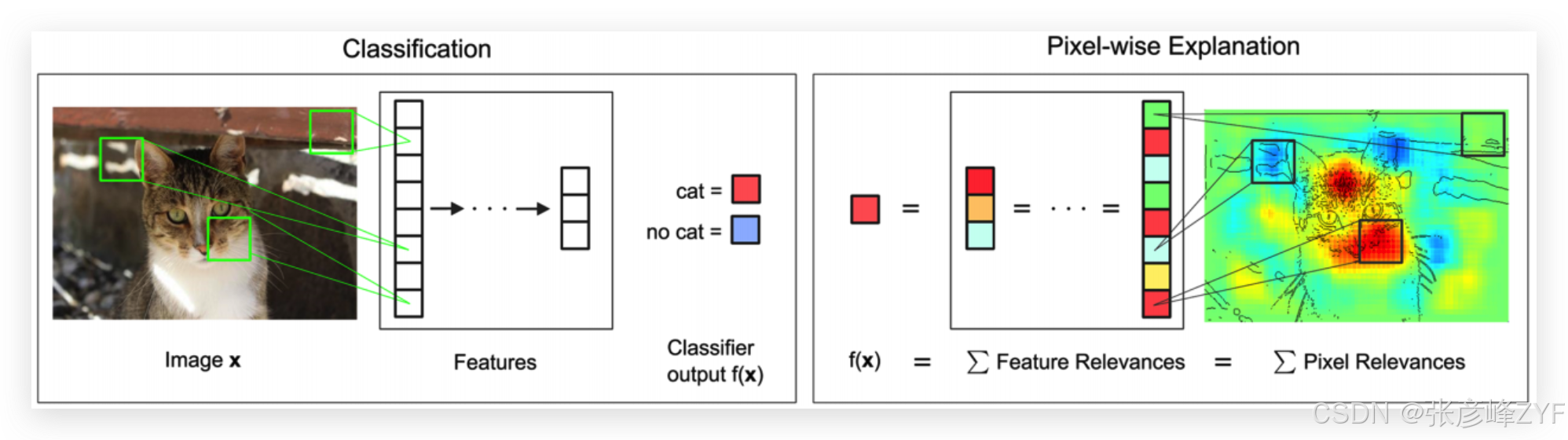

(二)像素级方法

在理解深度学习模型的决策过程中,像素级的解释方法提供了非常直观的视角,其中最具代表性的是层次相关传播(LRP)和DeconvNet。这些方法通过图像的每一个像素来揭示模型的决策依据,让我们不仅能看到模型的最终输出,还能理解哪些具体的图像区域或像素在模型的决策中起到了关键作用。

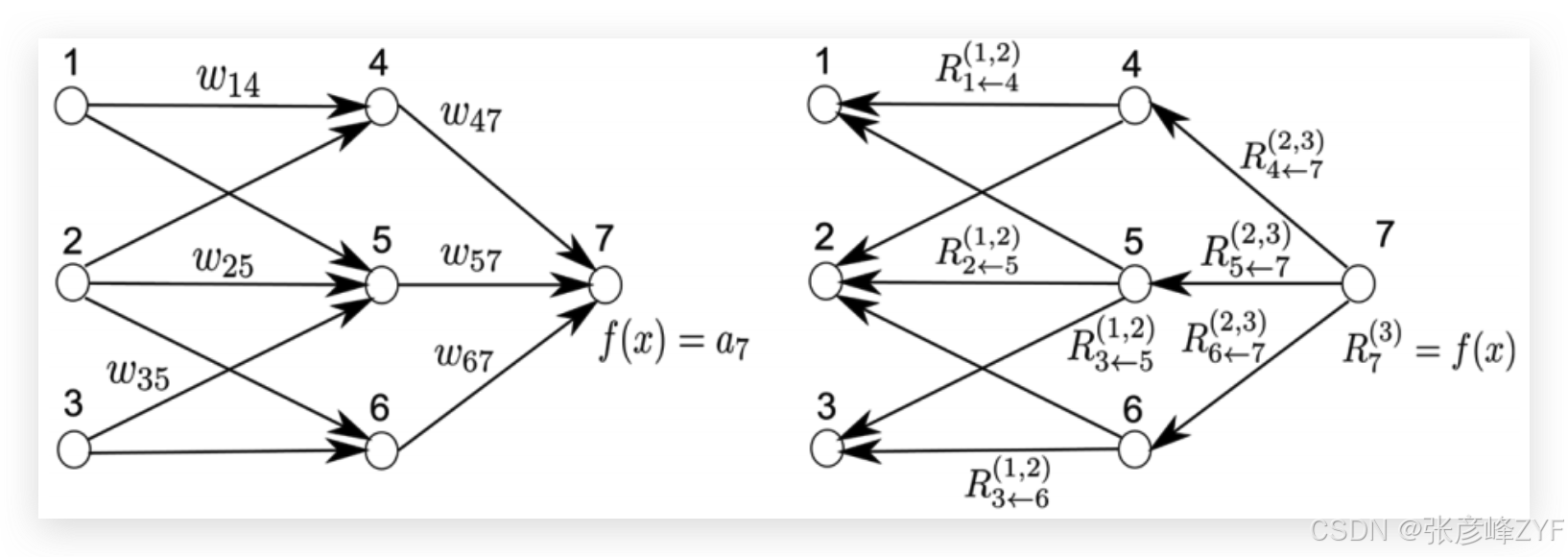

1. 层次相关传播(LRP)

层次相关传播(LRP)通过特定的传播规则,帮助我们理解多层神经网络如何从输入的每个像素到最终的决策输出逐步传递信息。它生成一张热图,直观地显示每个像素对网络输出的贡献程度。通过这种方式,我们可以看到哪些图像元素对模型决策有正面影响,这对于我们追踪模型的决策过程非常有帮助。

举个例子,假设一个图像分类模型需要识别一只猫,LRP会帮助我们找到图像中对“猫”这一类预测贡献最大的区域,如猫的耳朵或眼睛区域。这种方法尤其适用于预训练模型,帮助我们回顾模型是如何根据过去的学习经验进行决策的。不过,需要注意的是,LRP方法主要适用于能够进行反向传播的模型,这限制了它的应用范围。

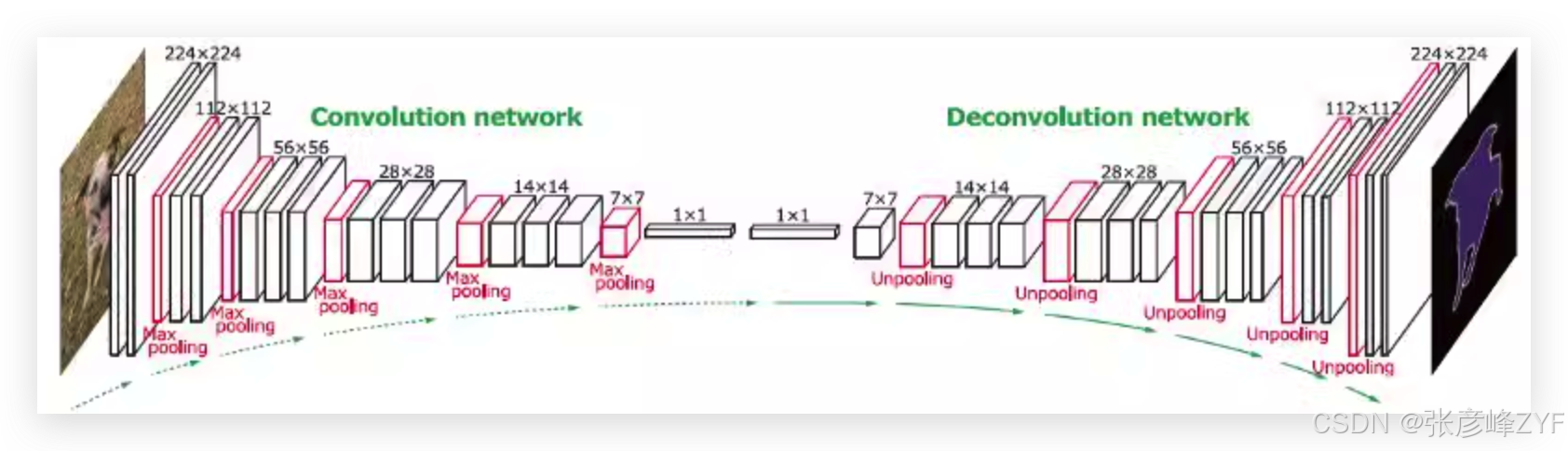

2. DeconvNet

与LRP不同,DeconvNet通过一种语义分割的方式来解释图像分类过程。它利用学习到的反卷积网络来揭示每个像素在分类时的贡献。反卷积的过程可以帮助我们理解图像中哪些区域最能影响分类结果,从而提供模型决策的透明度。它的应用,特别是在语义分割任务中,显著提高了模型的可解释性,使得我们能够看到每个像素在整个图像的语义层面上的作用。

DeconvNet和LRP的区别在于,DeconvNet更加注重图像的像素级别解释,尤其是在处理复杂的图像内容时,它能够细化到每个像素对决策的具体影响。尽管如此,这两种方法在应用时仍面临挑战,例如它们的效果依赖于网络的结构以及所选择的可解释框架。

3. 思考总结分析

从整体上来看,像素级解释方法,如LRP和DeconvNet,提供了非常直观的图像级别可解释性。这对于理解深度学习模型的“黑箱”行为至关重要。特别是对于需要对模型决策进行透明化的领域,如医疗影像诊断或自动驾驶,像素级的解释可以帮助专家更好地理解模型为何做出某个预测,进而提升对模型结果的信任度。

然而,像素级方法也并非万能。它们的效果在很大程度上依赖于模型的架构以及所采用的可解释性框架。例如,对于某些复杂的非卷积神经网络(CNN)模型,这些方法的解释可能不够充分或者不够准确。此外,像素级方法在面对图像内容非常相似的情况下(如多个对象的重叠区域或模糊图像)可能会遇到困难,导致其解释的准确性下降。

因此,尽管像素级方法为我们提供了强有力的可解释性工具,但在实际应用中,如何结合不同的可解释方法以提高模型透明度,仍然是一个值得深思的问题。未来,随着可解释AI技术的发展,我们或许能看到更为智能的集成方法,这些方法能够融合不同层次的解释信息,从而更全面地揭示深度学习模型的决策过程。

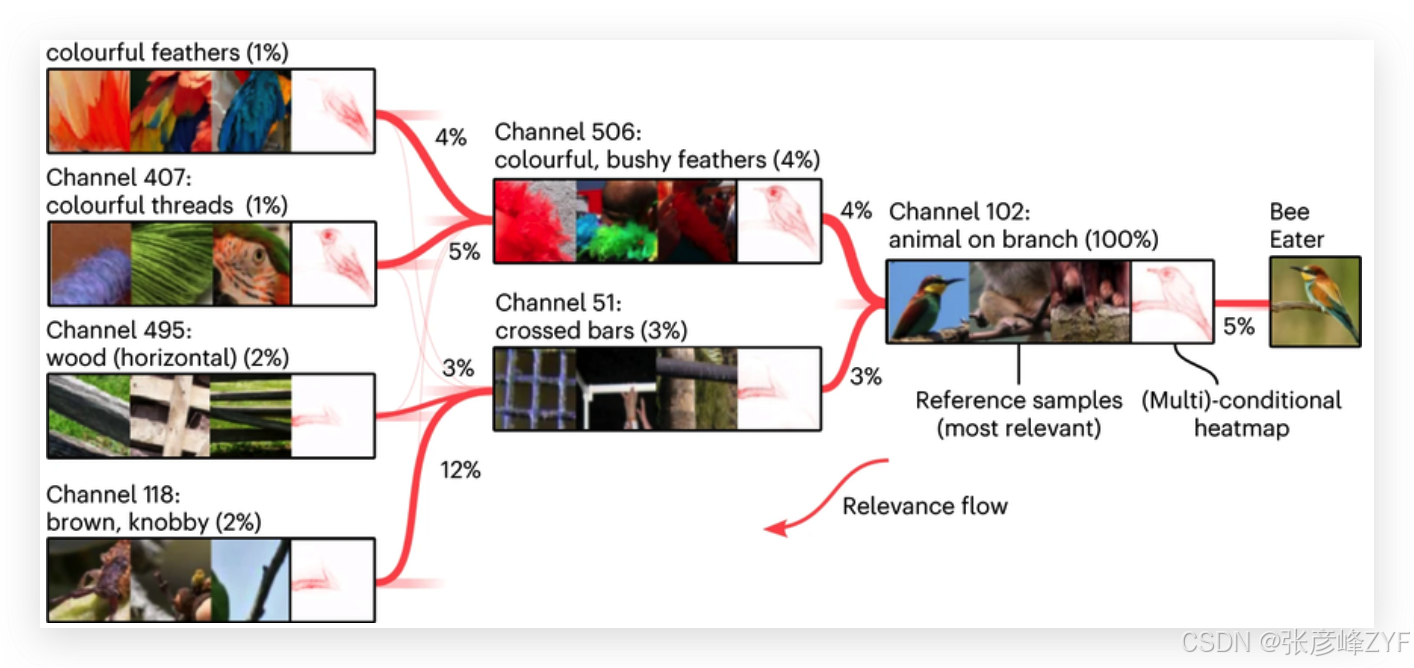

(三) 概念模型

在人工智能的可解释性领域,概念相关传播(CRP)和概念激活向量(CAV)等技术为我们提供了更深入的理解。这些方法不仅仅停留在局部特征的解释上,它们突破了传统的像素级分析,旨在揭示模型判断背后的“为何”——即AI如何基于复杂的、抽象的概念来做出决策。

1. 概念相关传播(CRP)

概念相关传播(CRP)是从层次相关传播(LRP)技术发展而来(Bach et al., 2015),它的目标不仅仅是识别图像中的重要部分,更进一步揭示影响AI决策的根本概念。

例如,在图像识别中,CRP能够指出模型是如何将图像中的某些特征与特定的高层次概念(如“猫”、“车”)进行关联的。与传统的像素级方法不同,CRP更注重对这些核心概念的分析,使得我们能够理解AI做出判断的逻辑。

这对于复杂语言模型(如ChatGPT)尤为重要,因为这些模型的决策不仅基于具体的输入,还涉及到潜在的、抽象的语言概念。通过CRP,我们可以更清楚地看到模型如何处理和关联这些概念,从而揭示模型做出判断的核心原因。

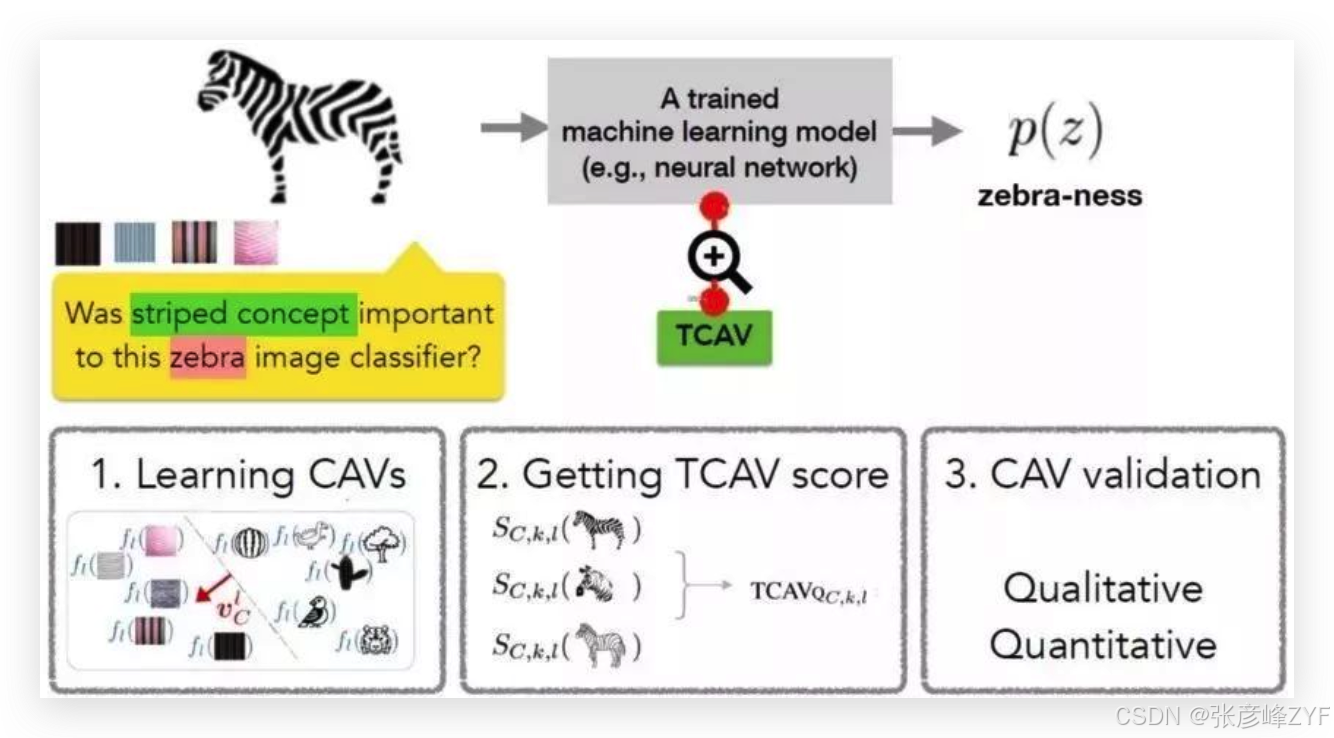

2. 概念激活向量(CAV)

概念激活向量(CAV)为神经网络提供了一个全局视角。它通过将高级潜在特征与人类可理解的概念相联系,量化了这些特征与用户定义概念之间的对齐程度。CAV帮助我们理解网络中隐藏层的特征是如何与高层次的语义概念对接的,进而揭示可能存在的学习偏差或模型的缺陷。

例如,在图像分类任务中,CAV可以帮助我们发现模型是否对某些特定概念(如“宠物”或“自然风景”)有过多或过少的依赖,从而识别模型可能的偏误。这种方法比起传统的特征导向方法,能够提供更为深层次的理解,尤其是在复杂的多类别分类任务中。

3. 思考与分析

概念模型的引入为AI可解释性带来了显著的提升。通过将低级特征映射到高级的、人类可理解的概念上,我们不仅能够解读模型的决策过程,还能识别模型学习中可能的偏差。这对于提升AI系统的透明度、增强用户信任度具有重要意义。

然而,概念模型的有效性也面临一些挑战。首先,概念的选择和定义仍然是一个关键问题。如果我们定义的概念过于模糊或不够具体,可能会影响模型的解释效果。其次,这些技术仍依赖于人工定义的概念,这意味着在某些应用中,可能会受到人为偏差的影响,限制了其普遍适用性。

但总体来看,概念模型为AI的可解释性提供了更高层次的视角,它不再仅仅满足于解释某个具体的决策,而是帮助我们理解AI是如何构建起自己对世界的认知模型的。这对于开发更智能、更人性化的AI系统至关重要,尤其是在需要与人类专家进行协作的领域(如医疗、法律等)。未来,随着自动化概念生成技术的发展,我们或许能够减少人为偏差,更好地帮助AI与人类之间建立深度的信任与合作。

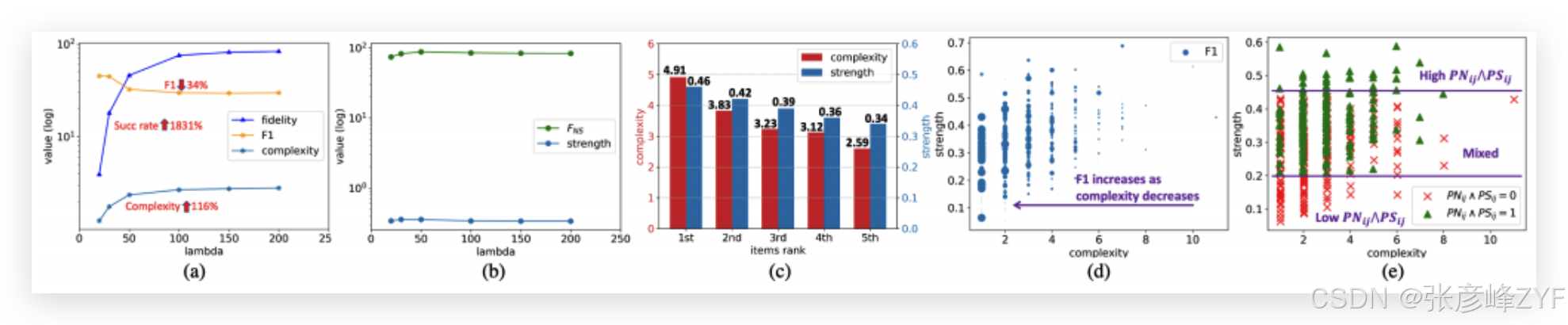

(四)替代模型

在可解释人工智能(XAI)领域,模型无关的解释技术的出现,标志着一个重要的里程碑。这些技术为我们提供了一个通用的框架,帮助我们揭开复杂黑盒模型的神秘面纱。特别是稀疏线性子集解释(SLISE)和局部可解释模型无关解释(LIME),它们通过独特的方式,帮助我们理解和解码机器学习模型的预测过程。

1. 稀疏线性子集解释(SLISE)

SLISE技术特别适用于那些需要高透明度的领域,因为它能够为个体预测提供直观的解释,而无需使用任何合成样本。这种方法通过识别最具影响力的特征,并使用简洁的线性模型来近似预测结果,从而为用户提供清晰且容易理解的解释。与传统的黑盒模型不同,SLISE让我们能够“看到”每个预测是如何得出的,这使其在金融、医疗等需要精准和透明决策的领域,显得尤为重要。

SLISE的优势在于它的普适性,不仅适用于各种机器学习模型,也能在不同的数据集和应用场景中展现出强大的解释能力。其不依赖复杂的合成样本,直接通过原始数据提供解释,使其在实际应用中显得更加灵活。

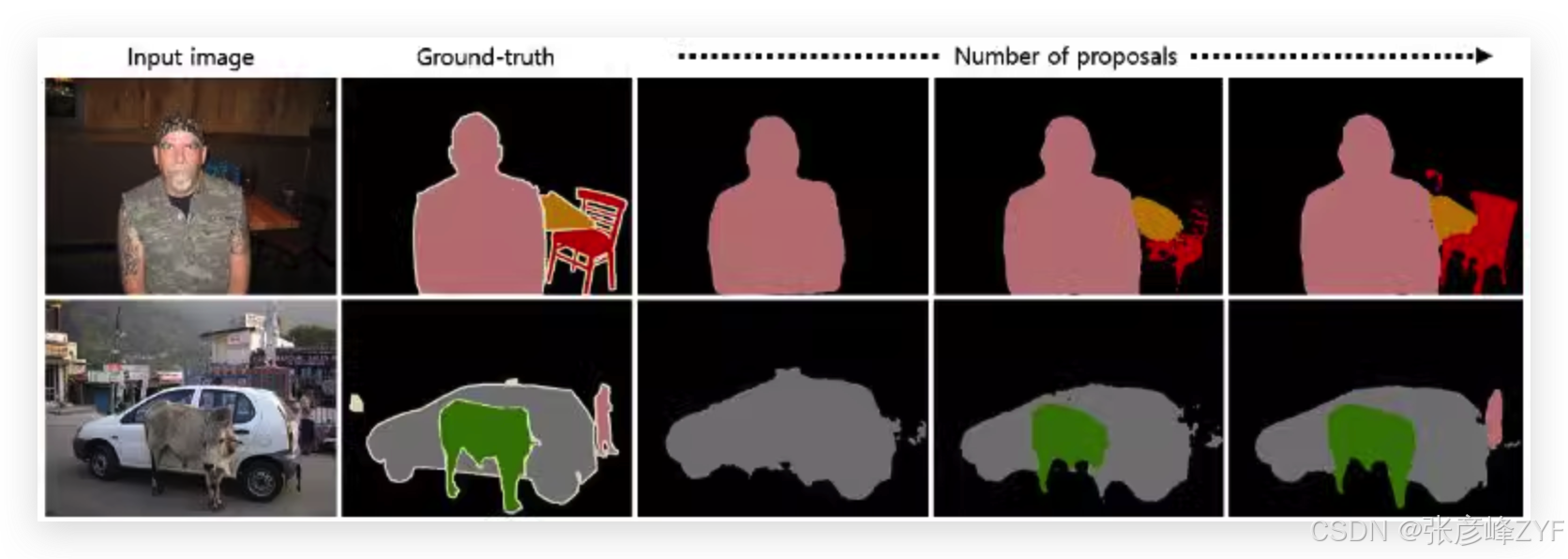

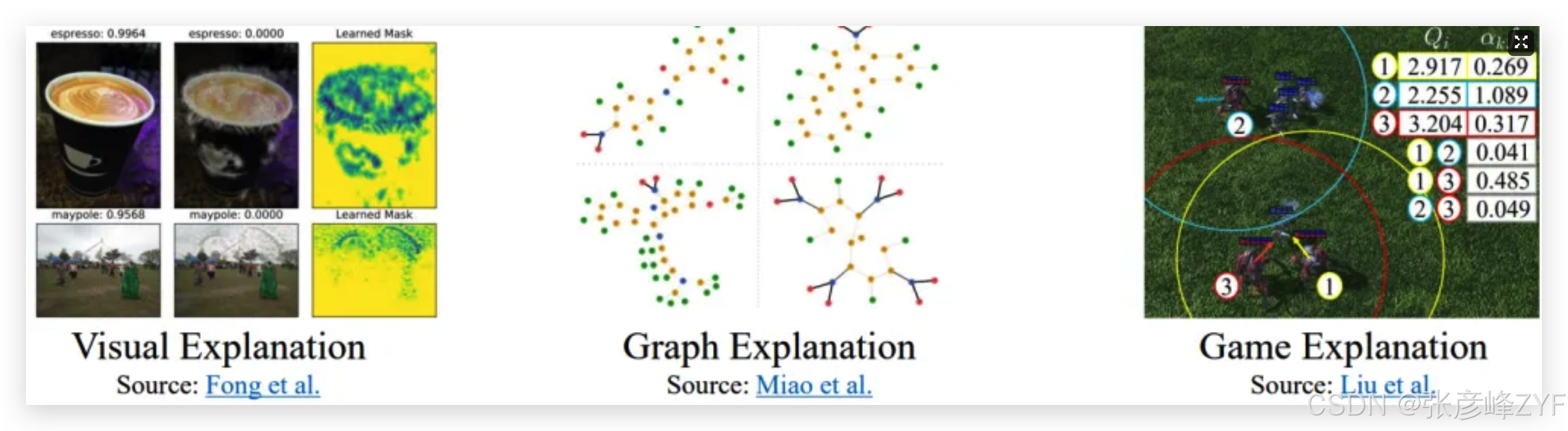

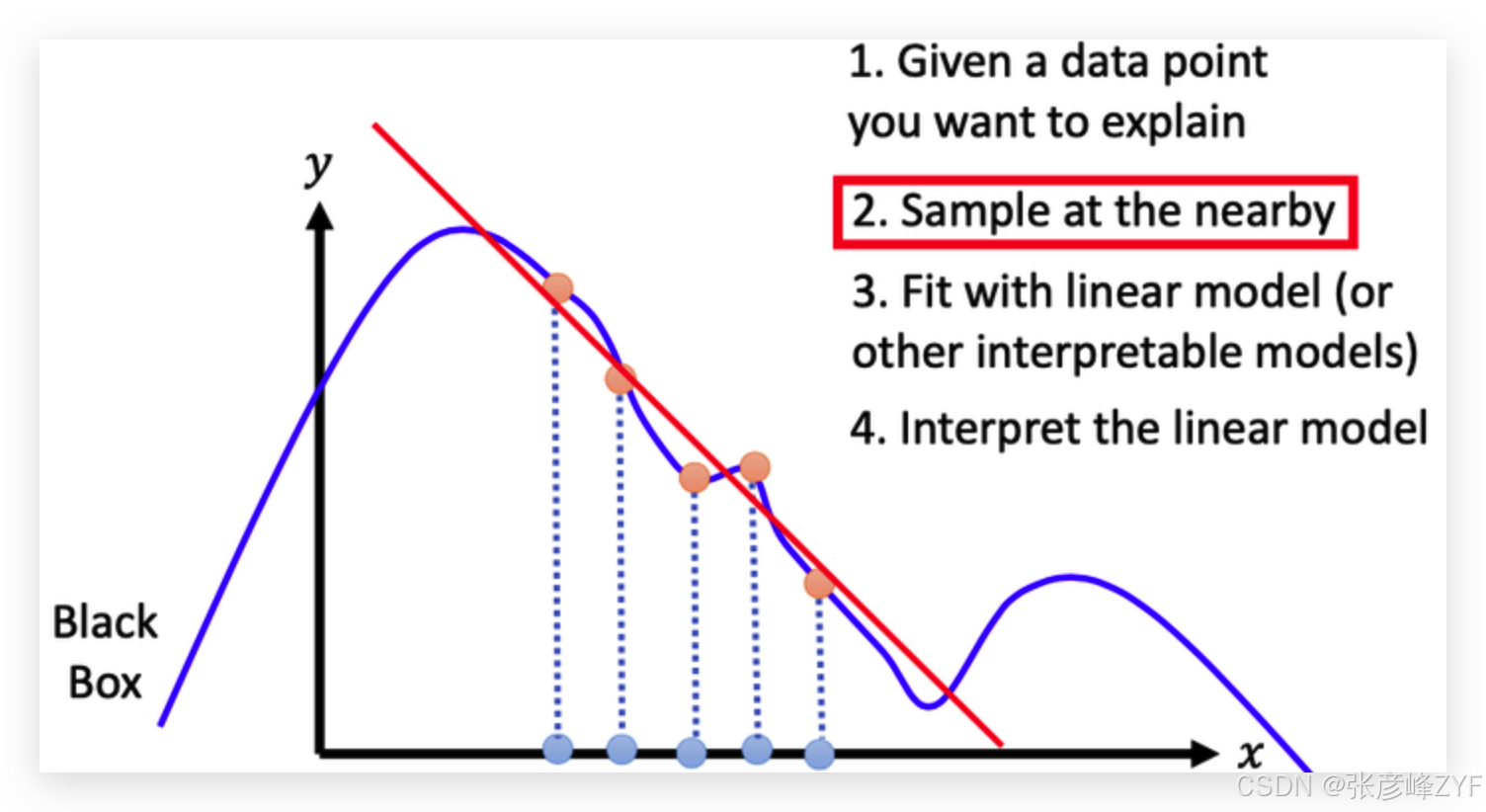

2. 局部可解释模型无关解释(LIME)

LIME则提供了另一种解释方式,它通过训练一个局部的、可解释的替代模型来模拟黑盒模型在特定数据点附近的决策过程。具体而言,LIME将输入图像分解为超像素(superpixels),通过分析这些小区域的影响,来解释图像分类中的关键特征。其核心思想是通过对局部区域的扰动,来探索模型对于不同输入特征的敏感度,从而构建更易理解的解释。

然而,LIME的有效性也依赖于扰动参数的选择。如何在不同的应用场景中,平衡启发式定制和易理解的解释之间的关系,是LIME方法的一大挑战。尽管如此,LIME已经在多个实际应用中展现了它的优势,特别是在需要高灵活性和解释性的任务中。

3. 个人思考与分析

SLISE和LIME这两种替代模型方法,都推动了AI可解释性的进步,但它们的工作原理和适用场景各有不同。SLISE更加注重全局的简洁性,它通过简化复杂的预测过程,帮助我们更清楚地理解模型的决策路径。而LIME则侧重于局部优化,它通过对模型的局部区域进行扰动分析,使得我们能够更加细致地探索模型在某一特定输入下的行为。

我个人认为,这两种方法的结合,将是未来可解释AI发展的一个重要方向。例如,在医疗影像分析中,SLISE可以提供全局的透明度,帮助医生理解模型的预测依据;而LIME则可以在具体病理图像上,揭示哪些局部特征对于诊断最为关键,从而为医生提供更加细致、可操作的建议。

然而,尽管这两种方法都具有各自的优点,它们依然面临一些挑战,比如扰动参数选择的难度、模型本身的复杂性等问题。因此,未来在模型解释性方面,我们需要更多创新的技术,尤其是那些能够在全局性和局部性之间找到更好平衡的方法,以便让AI的决策过程更加透明、可信。

(五)以人为中心的方法

当前的可解释人工智能(XAI)方法,虽然为我们提供了有关机器学习模型的宝贵见解,但它们常常未能提供真正符合人类认知需求的解释。大多数现有方法关注于通过特征重要性或图像局部性等后期解释,呈现给我们一个模糊的“黑箱”视图(Saeed & Omlin, 2023)。然而,这种方法与人类的认知过程有很大的不同——人类的思考方式包括推理、类比、评估相似性以及建立联系,这些在医学、金融和法律等专业领域至关重要。因此,传统的XAI方法并没有很好地解决模型的结构和参数复杂性与问题解决之间的关系,它们忽略了人类思维中至关重要的推理能力(Hassabis et al., 2017)。

1. 传统XAI方法的局限性

传统的可解释性方法大多从模型的“表面”进行解读,尝试通过特征重要性或者图像区域的分析来解释决策过程。这种方式往往聚焦于特定的输入特征或者模型的局部区域,而忽略了人类理解事物的全局视角。比如在医疗领域,当医生试图理解一个AI模型的诊断建议时,他们不仅仅关心单一的特征或图像区域,而是希望理解整个病人的状况、症状以及这些因素如何共同作用于决策。因此,传统的XAI方法在与人类的直觉和认知习惯对接时,往往显得力不从心。

2. 以人为中心的解释方法

与传统方法相比,近年来出现了一种根本不同的解释思路——以人为中心的可解释性。这种方法强调从整体上理解和比较复杂的实体(如图像、音乐、电影等),而非将它们拆解为孤立的特征或像素点。这种方法与人类的认知方式高度契合,强调通过与已知的认知原型建立联系来理解新信息,这一理念得到了理论和实证研究的支持(Angelov & Soares, 2020;Bien & Tibshirani, 2011)。这种思维方式不仅与我们如何理解世界相一致,而且比传统的统计方法更加灵活。统计方法通常依赖于平均值或总体趋势,而人类的思维方式更倾向于通过分类和相似性来理解事物,从而使我们能够高效地处理复杂信息。

3. 以人为中心的XAI应用

随着XAI技术的不断发展,越来越多的研究开始关注如何优化AI与人类的交互,特别是在决策支持场景中的应用。例如,在医疗决策中,医生不仅需要知道AI模型的诊断依据,还希望理解其决策的整个过程和逻辑,甚至包括AI如何综合患者的多种特征进行判断。这里的关键是,AI不仅要给出正确的结论,更要能够清晰、透明地与人类的思维方式相连接。

因此,现代XAI方法开始转向以人为中心的评估策略,重点评估AI如何在实际应用中增强人类决策过程的有效性。这不仅仅是技术层面的考量,更涉及到XAI在非专业人员中的可访问性和可用性(Doshi-Velez & Kim, 2017)。这也意味着,我们不应仅仅关注AI模型本身的精度,还需要评估它在帮助人类做出决策时的易用性和透明度。

4. 思考与分析

我认为,以人为中心的XAI方法代表了人工智能领域的一个重要转变。它不仅仅追求技术上的突破,更着眼于AI如何更好地融入人类的生活和工作中。正如我们在医疗、金融、法律等领域看到的那样,AI不仅需要回答“是什么”的问题,还需要能够解释“为什么”以及“怎么做”。在这方面,传统的XAI方法往往无法提供深入的推理过程,而以人为中心的方法则通过模拟人类认知的方式,能够帮助我们更全面地理解AI的决策机制。

与此同时,我也认为,尽管这种方法具有很大的潜力,但它的实施仍然面临一些挑战。例如,如何设计出能够与人类认知深度对接的模型?如何避免由于过于简化的模型导致误导性的解释?这些问题都需要进一步的探索。

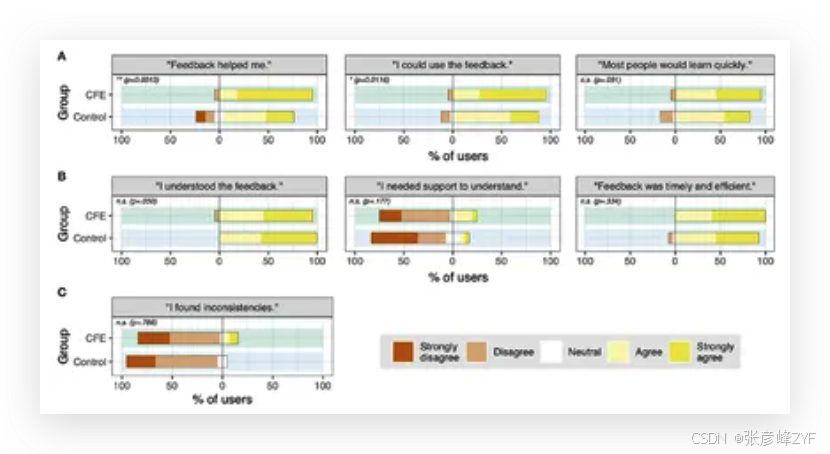

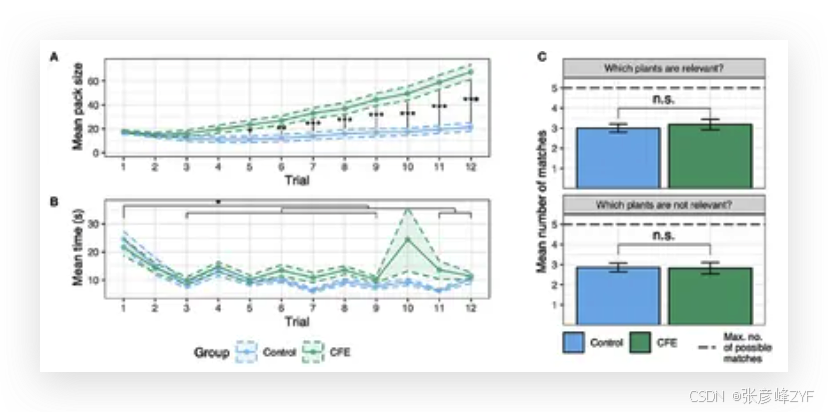

(六) 反事实解释的可用性

近年来,反事实解释(Counterfactual Explanations)在人工智能(AI)决策透明化方面越来越受到关注,因为它们能够通过展示输入变化如何影响结果,从而帮助我们更好地理解AI的决策过程。与传统的特征重要性分析不同,反事实解释通过提供“如果…会怎样”的情境,展示了不同决策路径的可能性。这种方法不仅能增强用户对AI决策过程的理解,还能使AI系统变得更具可接近性和可解释性。

1. 反事实解释的原理与优势

反事实解释的核心思想是通过描述一个与实际情况非常相似但有些许不同的假设情境,来帮助用户理解AI模型如何做出决策。比如,当AI系统拒绝贷款申请时,反事实解释可以告诉用户:“如果您的信用评分提高10分,您的申请可能会被接受。”这种“假如发生了什么”的方式,使用户能够更加直观地理解哪些因素会影响最终的决策。

与传统的解释方法相比,反事实解释的优势在于它不仅仅提供了决策背后的原因,还呈现了如何改变输入条件才能实现不同的结果。这种方式贴近人类思维习惯,因为我们通常通过对比和假设来理解世界。而AI系统的决策过程,往往对用户来说是难以捉摸的“黑箱”,反事实解释则为这种不透明性提供了有效的破解方式。

2. Alien Zoo框架:评估反事实解释的可用性

为了更好地评估反事实解释的效果和用户友好性,像Alien Zoo(Kuhl et al., 2023)这样的框架应运而生。Alien Zoo框架提供了一种方法,帮助研究人员和开发者了解用户如何接收和理解反事实解释。它从用户的角度出发,衡量不同反事实解释的清晰度、可操作性和对决策的影响,指导我们优化AI系统中的解释机制。

Alien Zoo不仅关注解释的准确性,还强调用户的参与感和可操作性。它的目标是让用户不仅仅是理解“为什么”,而且能够理解“如何改变”以便获得不同的结果。通过这种方式,AI决策不再是一个静态的“黑箱”,而是一个动态的过程,用户可以主动影响和调整。这种反馈机制与传统的解释方式相比,更加符合人类的认知模式。

3. 反事实解释的实际应用与挑战

反事实解释在多个领域的应用已经取得了显著成果,尤其是在金融、医疗和法律等领域。例如,银行可以通过反事实解释帮助贷款申请者理解自己未能获得批准的具体原因,并为他们提供改进信用评分的具体建议;医疗领域的AI系统可以向患者解释为何某种治疗方案更适合他们,甚至提供调整治疗计划的可行选项。

然而,反事实解释虽然具有明显优势,但在实际应用中仍面临一些挑战。首先,如何确保反事实情境的合理性和可操作性是一个重要问题。如果给出的反事实情境过于理想化或不切实际,用户可能会对解释产生怀疑。其次,反事实解释在复杂的AI模型中可能变得非常困难,特别是在模型的决策机制过于复杂或输入变量过多时,生成合理且有意义的反事实情境可能变得不现实。

4. 思考与分析

反事实解释为AI的可解释性带来了巨大的突破,它不仅帮助我们理解模型是如何做出决策的,还让我们看到调整输入后可能得到的不同结果。这种方法对提升AI系统透明度和用户信任至关重要。然而,我认为,在进一步推广反事实解释时,我们需要更多地关注如何生成高质量的反事实情境,确保它们不仅具备可操作性,而且符合用户的实际需求。

在应用层面,反事实解释为各行各业的AI系统增加了人性化的维度,尤其是在需要高度信任和透明度的领域。然而,我们也应该警惕反事实解释可能带来的过度简化问题。有时候,AI模型的决策过程过于复杂,反事实解释可能会过度简化,忽略掉一些关键的细节。因此,如何平衡解释的简洁性与准确性,将是未来研究的一个重要方向。总结来说,反事实解释是一个强大的工具,能够让AI决策过程更加透明,帮助用户理解并互动。随着技术的进步和框架的完善,反事实解释将在AI的可解释性领域发挥更大的作用,帮助我们更好地理解和使用这些复杂的技术。

三、当前XAI面临的挑战

随着机器学习模型在各行各业中的广泛应用,可解释人工智能(XAI)的需求愈加迫切。XAI的目标是让这些复杂的模型变得透明、负责任,并且能被广泛的受众理解,而不仅仅是技术专家。随着AI逐渐走进我们的日常生活,它的“黑箱”特性使得非专业人士很难理解和信任AI系统的决策过程。因此,推行XAI不仅是为了提升模型性能和可接入性,更是为了推动AI技术更公平、更民主的应用。

然而,要实现这一目标,XAI还面临着一系列挑战。这些挑战既有技术上的困难,也涉及到伦理层面的考量:

class="table-box">| 挑战类型 | 描述 | 关键问题 |

|---|---|---|

| 技术难题 | 模型复杂性与透明度的平衡 | 深度学习模型和生成式模型具有复杂的参数和非线性关系,难以提供清晰的解释,尤其是在生成图像或创意时。 |

| 尽管已有如LIME和SHAP等局部解释方法,但全局透明度仍是一个难题。 | 如何在确保高性能的同时提供模型的透明度,仍然是技术难题。 | |

| 伦理挑战 | 可解释性与隐私之间的冲突 | 过度透明的解释可能暴露敏感数据,尤其是在医疗、金融等领域。 |

| 需要平衡为用户提供足够的解释与保护个人隐私和数据安全之间的关系。 | 如何确保数据隐私安全,同时不影响模型的可解释性。 | |

| 理解障碍 | 非专业用户的理解问题 | 目前的XAI技术主要面向机器学习专家,普通用户可能难以理解复杂的决策过程。 |

| 需要将技术性强的解释转化为普通用户可以理解的语言和形式。 | 如何让普通用户能够容易理解和接受AI的决策解释。 | |

| 信任问题 | 模型解释的信任度问题 | 简化的解释可能导致对模型决策过程的误解,从而影响对模型的信任。 |

| 过度简化的解释虽然容易理解,但可能忽略了决策过程中的复杂因素,失去准确性。 | 如何在保持简化和准确性之间找到合适的平衡点,提升信任度。 |

评论记录:

回复评论: